- 1CSDN博客——“我的2014”年度征文活动火爆开启_配置管理学习的感悟和展望总结

- 2AndroidStudio期末大作业校园快递领取系统(Android课设,新手小白必看)_android studio大作业物流源代码

- 3【Python入门系列】第六篇:Python常用内置库总结_python内置库

- 4git clone error: RPC failed; HTTP 504 curl 22 The requested URL returned error: 504 Gateway Time-out

- 5键盘盲打练习打字软件 v6.30绿色版_键盘盲打练习入门程序

- 6Python之socket-UDP协议通信_sendaddr

- 7华为OD机试C++ - 悄悄话_华为od 悄悄话

- 8SQL SERVER之数据查询_sql server 无结算记录查询

- 9SSM+微信小程序网易云音乐设计与实现 毕业设计-附源码261620_音乐小程序论文

- 10go interface

【机器学习】——神经网络与深度学习_深度学习与神经网络

赞

踩

目录

引入

人工神经网络ANN是由大量处理单位(人工神经元)经广泛互连而组成的人工网络,以模拟脑神经系统的结构与功能。ANN可看作以人工神经元为节点,用有向加权弧连接起来的有向图,有向弧的权重表示相互连接的两个神经元间相互作用的强弱。深度学习算法是人工神经网络算法的改进,提高了神经网络算法的性能和应用。

一、神经网络及其主要算法

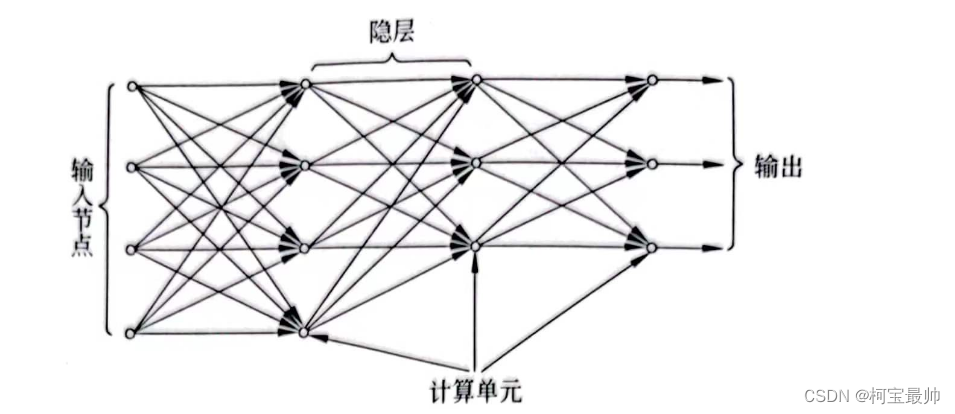

1、前馈神经网络

构成前馈神经网络的各神经元接收前一级输入,并输入到下一级,无反馈,可用一有向无环图表示。图的节点分为两类——输入节点和计算单元。每个计算单元可有任意个输入但只有一个输出,而输出可耦合到任意多个其他节点输入(输出的是同一个值给很多人)。前馈网络通常分为不同层,通常认为输入为第一层,所以单层计算单元的网络实际上是一个两层网络,输入和输出节点可与外界相连,直接受环境影响,称为可见层,其他中间层称为隐层。

2、感知器

感知器模型是为研究大脑的存储、学习和认知过程而提出的一类具有自学习能力的神经网络模型,把神经网络的研究从纯理论探讨引向了工程实现。它是一种双层神经网络模型,一层为输入层,另一层具有计算单元,可以通过监督学习建立模式判别的能力。

学习的目标是通过改变权值使神经网络由给定的输入得到给定的输出。作为分类器,可以用已知类别的模式向量或特征向量作为训练集,当输入为属于第j类的特征向量X时,应使对应于该类输出y1=1,而其他神经元的输出则为0(或-1)。

设理想的输出为:

实际输出为:

为了使输出逼近理想输出,可以反复依次输入训练集中的向量X,并计算出实际的输出Y^,对权值w做出如下修改:

其中:

感知器的学习过程与求取线性判别函数的过程是等价的,此处只指出感知器的一些特性:①两层感知器只能用于解决线性可分问题;②学习过程收敛很快,且与初始值无关。

单层感知器不能表达的问题称为线性不可分问题,如“异或”问题(XOR)。线性不可分函数的数量随着输入变量个数的增加而快速增加,甚至远远超过线性可分函数得个数。

3、三层前馈网络(多层感知器MLP)

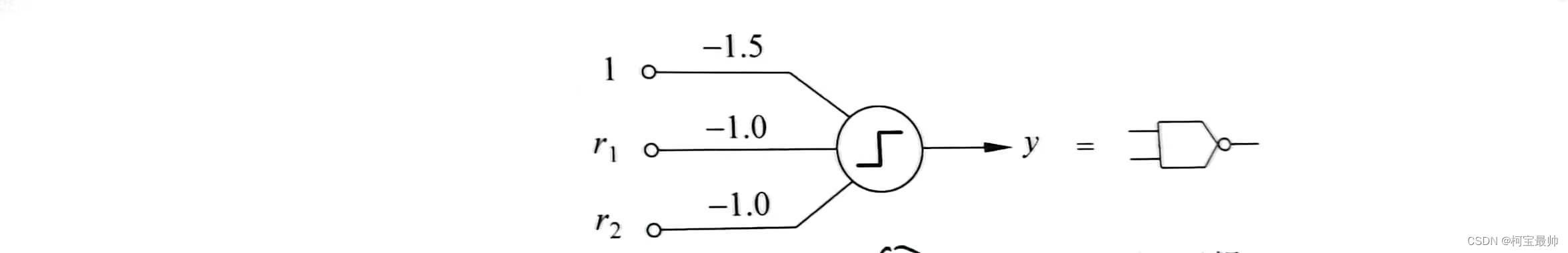

神经元的非线性特性可实现各种逻辑门,如NAND(与非门)可用如下的阈值神经元实现:

任何逻辑函数都可以由与非门组成,所以:①任何逻辑函数都可以用前馈网络实现;②单个阈值神经元可以实现任意多输入的与门、或门、与非门、或非门;由于任何逻辑函数都可以化为析取(或合取)形式,所以任何逻辑函数都可用一个三层(只用两层计算单元)的前馈网路实现。

当神经元的输出函数为Sigmoid函数时,上述结论可推广到连续的非线性函数,在很宽松的条件下,三层前馈网络可以逼近任意的多元非线性函数,突破了两层前馈网络线性可分的限制。这种三层或三层以上的前馈网络叫作多层感知器。

4、反向传播算法

三层前馈网络的适用范围大大超过二层前馈网络,但学习算法较为复杂——主要困难是中间隐层不直接与外界连接,无法直接计算其误差。为此提出了反向传播算法(BP)——主要思想从后向前(反向)逐层传播输出层的误差,以间接算出隐层的误差。

BP算法两个阶段: