- 1云电脑是什么_什么是云电脑?云又是如何工作的?

- 2报错BrokenPipeError: [Errno 32] Broken pipe_brokenpipeerror: [errno 32] broken pipe 在向管道中写入参数的

- 3Could not find ‘cudart64_100.dll‘

- 4ioDraw在线图表工具 - 轻松制作专业图表,只需3步!_自动生成柱状图的ai

- 5数据结构与算法之计数排序_数据结构 计数排序

- 6微信支付-Native支付(网页二维码扫码微信支付)简单示例_网页扫码支付功能

- 7初次使用github

- 8旋转位置编码原理及代码_旋转位置代码

- 9关于AI记忆系统的研究_在ai智能如何实现记忆功能的方法

- 102024最新版JavaScript逆向爬虫教程-------基础篇之无限debugger的原理与绕过

AI跟踪报道第46期-新加坡内哥谈技术-本周AI新闻:Google 推出gemma 2, Kyutai 开源 Moshi 和 Runway Gen-3挑战 Sora_gemma-2 26bv

赞

踩

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅:https://rengongzhineng.io/

点击下面视频观看在B站本周AI更新:

B 站 链接 观看:

https://www.bilibili.com/video/BV1eDaMeXEum![]() https://www.bilibili.com/video/BV1eDaMeXEum

https://www.bilibili.com/video/BV1eDaMeXEum

想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行! 订阅: https://rengongzhineng.io/

1) Gemma 2现已在Google AI Studio(https://aistudio.google.com/app/prompts/new_chat?model=gemma-2-27b-it)Hugging Face Models(https://huggingface.co/google/gemma-2-9b

2) Meta: https://arxiv.org/abs/2404.19737

3) https://moshi.chat/

4) https://runwayml.com/ai-tools/gen-3-alpha/

5) https://robot-tv.github.io/

人工智能有潜力解决一些最紧迫的人类问题,但前提是每个人都能使用这些工具。因此,今年早些时候,Google推出了Gemma,这是一个轻量级、最先进的开源模型家族,基于与Gemini模型相同的研究和技术开发。Google还扩展了Gemma家族,推出了CodeGemma、RecurrentGemma和PaliGemma,每个模型都针对不同的AI任务提供独特功能,并通过与Hugging Face、NVIDIA和Ollama等合作伙伴的集成,便于用户访问。

现在,Google正式向全球的研究人员和开发者发布了Gemma 2。Gemma 2有9亿(9B)和27亿(27B)参数两种型号,性能更高,推理效率更优,并且在安全性方面有显著提升。事实上,27B型号在性能上可以与体积是其两倍以上的模型竞争,达到了仅在去年12月专有模型才可能实现的性能。而且,这些性能现在只需一台NVIDIA H100 Tensor Core GPU或TPU主机即可实现,显著降低了部署成本。

高效性能开源模型新标准

Gemma 2基于重新设计的架构,专为卓越的性能和推理效率而设计。其特点包括:

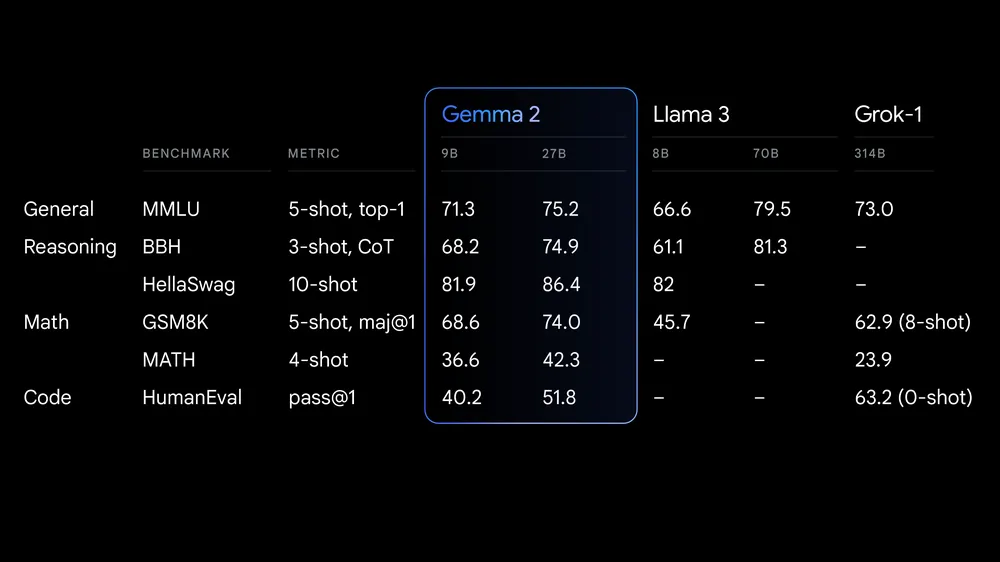

- 超强性能:27B的Gemma 2在其体积类别中提供了最佳性能,甚至可以与体积是其两倍以上的模型竞争。9B的Gemma 2模型也在其体积类别中表现领先,超越了Llama 3 8B和其他同类开源模型。详细的性能分析可参见技术报告。

- 无与伦比的效率和成本节约:27B的Gemma 2模型设计为在单个Google Cloud TPU主机、NVIDIA A100 80GB Tensor Core GPU或NVIDIA H100 Tensor Core GPU上全精度高效运行,在保持高性能的同时显著降低成本,使AI部署更加经济实惠。

- 跨硬件的极速推理:Gemma 2优化为在从强大的游戏笔记本电脑和高端台式机到云端设置的各种硬件上以惊人的速度运行。可以在Google AI Studio中全精度体验Gemma 2,通过Gemma.cpp在CPU上解锁本地性能,或在家用电脑上通过Hugging Face Transformers使用NVIDIA RTX或GeForce RTX体验。

专为开发者和研究人员设计

Gemma 2不仅更强大,还更容易集成到工作流程中:

- 开源且可访问:与原始的Gemma模型一样,Gemma 2在商业友好的Gemma许可证下提供,允许开发者和研究人员分享和商业化他们的创新。

- 广泛的框架兼容性:Gemma 2与主要AI框架兼容,如Hugging Face Transformers、JAX、PyTorch和TensorFlow,通过原生Keras 3.0、vLLM、Gemma.cpp、Llama.cpp和Ollama使用。此外,Gemma还优化了NVIDIA TensorRT-LLM,以在NVIDIA加速基础设施上运行或作为NVIDIA NIM推理微服务,未来还将针对NVIDIA的NeMo进行优化。开发者可以使用Keras和Hugging Face进行微调,未来还会支持更多参数高效微调选项。

- 轻松部署:从下个月开始,Google Cloud客户可以在Vertex AI上轻松部署和管理Gemma 2。

探索新的Gemma Cookbook,这是一系列实用示例和指南,帮助用户构建自己的应用程序并针对特定任务微调Gemma 2模型。了解如何轻松使用Gemma完成常见任务,如检索增强生成。

负责任的AI开发

Google致力于为开发者和研究人员提供负责任地构建和部署AI所需的资源,包括通过其负责任生成AI工具包。最近开源的LLM Comparator帮助开发者和研究人员深入评估语言模型。从今天起,用户可以使用配套的Python库运行模型和数据的对比评估,并在应用中可视化结果。此外,Google正在积极开源其文本水印技术SynthID,以供Gemma模型使用。

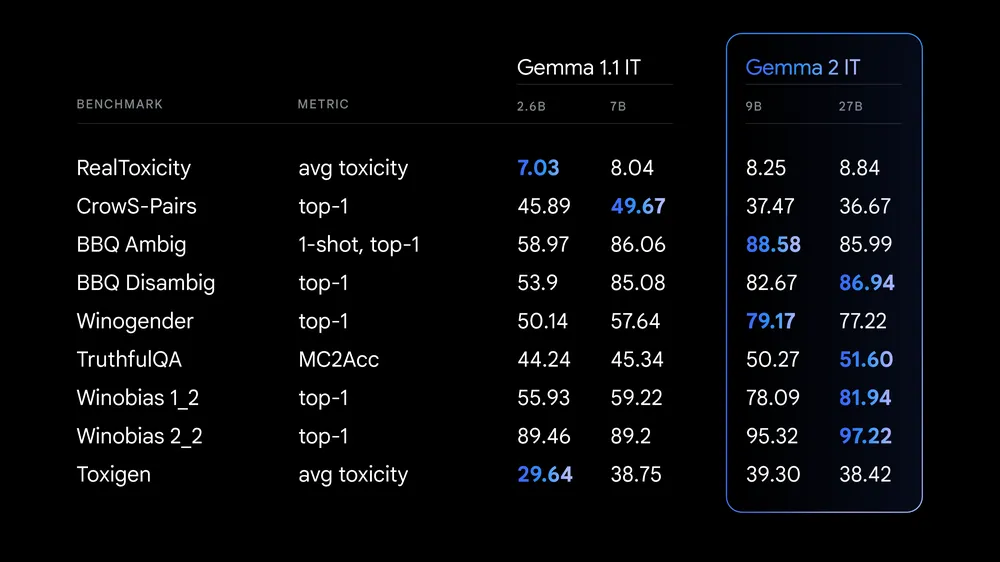

在训练Gemma 2时,Google遵循了严格的内部安全流程,筛选预训练数据并对其进行严格测试和评估,以识别和减轻潜在的偏见和风险。Google还在一系列公共基准测试上公布了结果,涉及安全性和表示性危害的相关问题。

使用Gemma构建的项目

首次推出Gemma时,下载量超过了1000万,并催生了无数令人鼓舞的项目。例如,Navarasa利用Gemma创建了一个根植于印度语言多样性的模型。

现在,Gemma 2将帮助开发者启动更具雄心的项目,在AI创作中解锁新的性能和潜力。Google将继续探索新的架构,并开发专门的Gemma变体,以应对更多AI任务和挑战。这包括即将推出的2.6B参数Gemma 2模型,旨在进一步缩小轻量级可访问性和强大性能之间的差距。关于即将发布的更多信息,请参见技术报告。

入门指南

Gemma 2现已在Google AI Studio(https://aistudio.google.com/app/prompts/new_chat?model=gemma-2-27b-it)中提供,用户可以在没有硬件要求的情况下测试其27B的全部性能。用户还可以从Kaggle和Hugging Face Models(https://huggingface.co/google/gemma-2-9b)下载Gemma 2的模型权重,Vertex AI Model Garden也将很快上线。

为支持研究和开发,Gemma 2也可通过Kaggle免费获得,或通过Colab笔记本的免费层使用。首次使用Google Cloud的客户可能有资格获得300美元的积分。学术研究人员可以申请Gemma 2学术研究计划,以获得Google Cloud积分,加速他们使用Gemma 2的研究。申请现已开放,截止日期为8月9日。