热门标签

热门文章

- 1算法基础学习笔记----数据结构---KMP算法_董晓算法

- 2七道Android面试题,先来简单热个身_android开发面试题

- 3docker 本地部署大模型(ollama)_ollama 国内镜像

- 4企业国产操作系统选型适配实施方案_kylin-server-10-sp1-release-build10-2500-20201202-

- 5解决:PyCharm中找不到python打包工具_pycharm找不到python打包工具

- 6从码农到上岸公务员,到底是什么体验?工作感受真实分享!_程序员上岸事业编体验

- 7Python NumPy库详解:高效处理数组的利器

- 8内网渗透-内网穿透工具_python 自制内网穿透

- 9嵌入式学习笔记——STM32的时钟树_stm32时钟树

- 1080MHz~100MHz 频谱分析仪(E 题 本科组)-- 2015 年全国大学生电子设计竞赛试题_2015电子设计大赛e题

当前位置: article > 正文

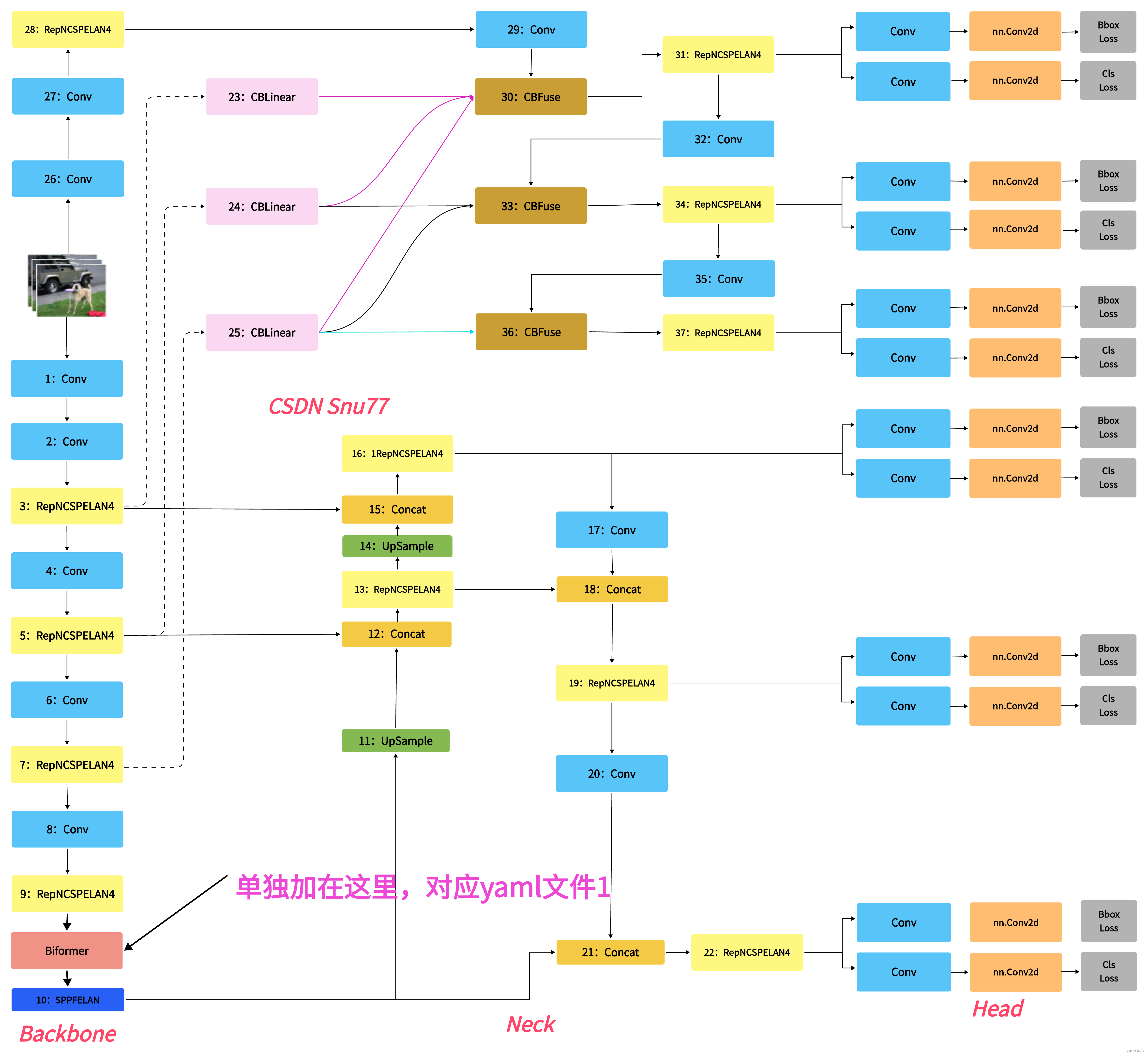

YOLOv9改进策略 | 添加注意力篇 | BiFormer双层路由注意力机制(Bi-level Routing Attention)_bilevei routing attention

作者:知新_RL | 2024-08-17 06:24:02

赞

踩

bilevei routing attention

一、本文介绍

BiFormer是一种结合了Bi-level Routing Attention的视觉Transformer模型,BiFormer模型的核心思想是引入了双层路由注意力机制。在BiFormer中,每个图像块都与一个位置路由器相关联。这些位置路由器根据特定的规则将图像块分配给上层和下层路由器。上层路由器负责捕捉全局上下文信息,而下层路由器则负责捕捉局部区域的细节。

具体来说,上层路由器通过全局自注意力机制对所有图像块进行交互,并生成全局图像表示。下层路由器则使用局部自注意力机制对每个图像块与其邻近的图像块进行交互,并生成局部图像表示。通过这种双层路由注意力机制,BiFormer能够同时捕捉全局和局部的特征信息,从而提高了模型在视觉任务中的性能。

本文主要通过对YOLOv9模型添加Biformer机制为例,让大家对于YOLOv9模型添加注意力机制有一个深入的理解,通过本文你不只能够学会添加Biformer注意力机制,同时可以举一反三学会其它的注意力机制的添加。

Biformer适用检测目标->适合处理大尺度目标、小尺度目标、密集目标和遮挡目标的检测

目录

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/991546

推荐阅读

相关标签