- 1转正申请范文_java工程师 转正申请csdn

- 2【WebForms王者归来】在 ASP.NET Core 中运行 WebForms 业务代码,99%相似度!

- 3startActivityForResult()方法被弃用_startactivityforresult弃用怎么解决

- 4一文读懂|Apollo自动驾驶平台9.0全面解读_apollo 9

- 5程序员需要达到什么水平才能顺利拿到 20k 无压力?_20几k

- 6计算机网络(2

- 7【Python日志模块全面指南】:记录每一行代码的呼吸,掌握应用程序的脉搏_python 日志 分析

- 8js数组常用方法_map((item)

- 9去中心化技术的变革力量:探索Web3的潜力

- 10mysql乘法函数_数据库入门(MySQL):mySQL运算符与mySQL常用函数

【视频异常检测】VadCLIP: Adapting Vision-Language Models for Weakly Supervised Video Anomaly Detection 论文阅读

赞

踩

VadCLIP: Adapting Vision-Language Models for Weakly Supervised Video Anomaly Detection 论文阅读

文章信息:

发表于:AAAI2024

原文链接:https://arxiv.org/abs/2308.11681

源码链接:https://github.com/nwpu-zxr/VadCLIP

Abstract

最近,对比语言-图像预训练(CLIP)模型在各种图像级任务中取得了巨大成功,展现了学习丰富语义的强大视觉表示能力。一个开放且值得探讨的问题是如何高效地将这样一个强大的模型适应到视频领域,并设计一个健壮的视频异常检测器。在这项工作中,我们提出了VadCLIP,一种利用冻结的CLIP模型直接进行弱监督视频异常检测(WSVAD)的新范式,无需任何预训练和微调过程。与当前直接将提取的特征馈送到弱监督分类器进行帧级二分类的方法不同,VadCLIP充分利用了CLIP的视觉和语言之间的细粒度关联,并涉及双分支。一个分支简单利用视觉特征进行粗粒度二分类,而另一个则充分利用了细粒度的语言-图像对齐。通过双分支的好处,VadCLIP通过将预训练知识从CLIP转移到WSVAD任务上,实现了粗粒度和细粒度视频异常检测。我们在两个常用基准数据集上进行了大量实验,结果表明VadCLIP在粗粒度和细粒度WSVAD上均取得了最佳性能,远远超过了现有方法。具体而言,VadCLIP在XDViolence和UCF-Crime上分别实现了84.51%的AP和88.02%的AUC。代码和特征已在https://github.com/nwpu-zxr/VadCLIP发布。

Introduction

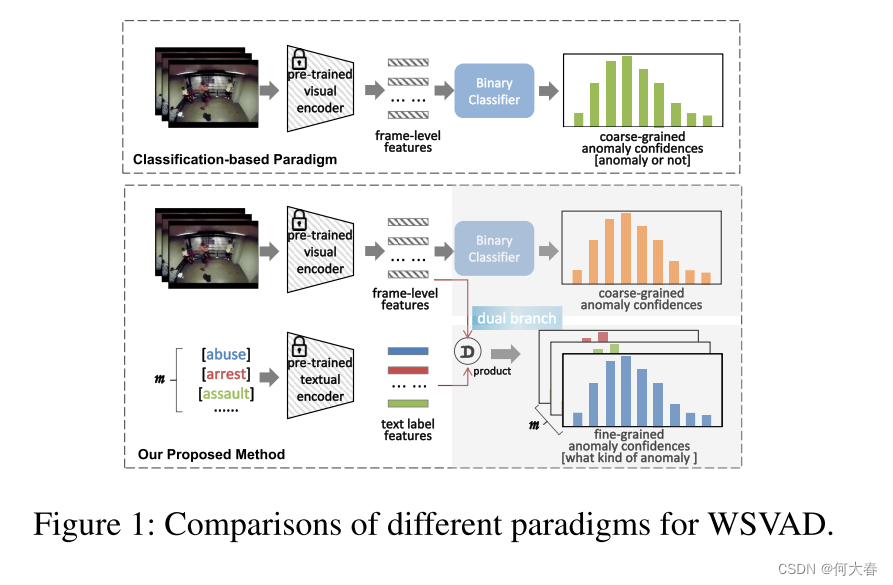

近年来,弱监督视频异常检测(WSVAD,VAD)因其广泛的应用前景而受到越来越多的关注。例如,在WSVAD的帮助下,可以方便地开发更强大的智能视频监控系统和视频内容审核系统。在WSVAD中,预期异常检测器能够仅基于提供的视频级别注释生成帧级别的异常置信度。目前该领域的大多数研究遵循一种系统化的流程,其初始步骤是利用预训练的视觉模型(例如,C3D(Tran等人,2015年;Sultani,Chen和Shah,2018年)、I3D(Carreira和Zisserman,2017年;Wu等人,2020年)、ViT(Dosovitskiy等人,2020年;Li,Liu和Jiao,2022年))提取帧级特征,然后将这些特征馈送到基于多实例学习(MIL)的二分类器中进行模型训练,最终根据预测的异常置信度检测异常事件。尽管这种基于分类的范式具有简单的结构和有前景的结果,但它未能充分利用跨模态关系,例如,视觉-语言关联。

在过去的两年中,我们目睹了视觉-语言预训练(VLP)模型(Kim,Son和Kim,2021年;Jia等,2021年;Wang等,2021年;Chen等,2023年)的巨大进展,例如,CLIP(Radford等,2021年),用于学习更通用的具有语义概念的视觉表示。CLIP的主要思想是通过对比学习来对齐图像和文本,即在联合嵌入空间中拉近图像和匹配的文本描述,同时将不匹配的对推开。由于从网络上爬取了数亿个嘈杂的图像-文本对,这样的大规模预训练模型展示了它们强大的表示学习能力以及视觉和语言之间的关联。鉴于CLIP的突破性性能,最近,在CLIP的基础上构建任务特定模型正在成为新兴的研究课题,并应用于广泛的视觉任务,这些模型取得了前所未有的性能。

尽管CLIP及其相关模型在各种视觉任务上展现了巨大潜力,但这些方法主要集中在图像领域。因此,如何将从图像-文本对学习到的模型有效地适应到更复杂的弱监督视频异常检测任务中,值得深入探索。最近,一些研究(Joo等,2023年;Lv等,2023年)尝试利用CLIP的学习知识,然而,这些方法局限于直接使用从CLIP的图像编码器中提取的视觉特征,并忽视了视觉与语言之间的语义关系的利用。

为了有效利用通用知识并使CLIP在WSVAD任务中发挥其全部潜力,基于WSVAD的特性,有几个关键挑战需要解决。

首先,探索跨时间捕获上下文依赖关系的方法至关重要。

其次,确定如何利用已学知识和视觉-语言连接至关重要。

第三,关键在于在弱监督下保持最佳的CLIP性能。

在这项工作中,我们提出了一个新的范例的基础上CLIP的WSVAD,这是被称为VadCLIP。VadCLIP由几个组件组成,以克服上述挑战。

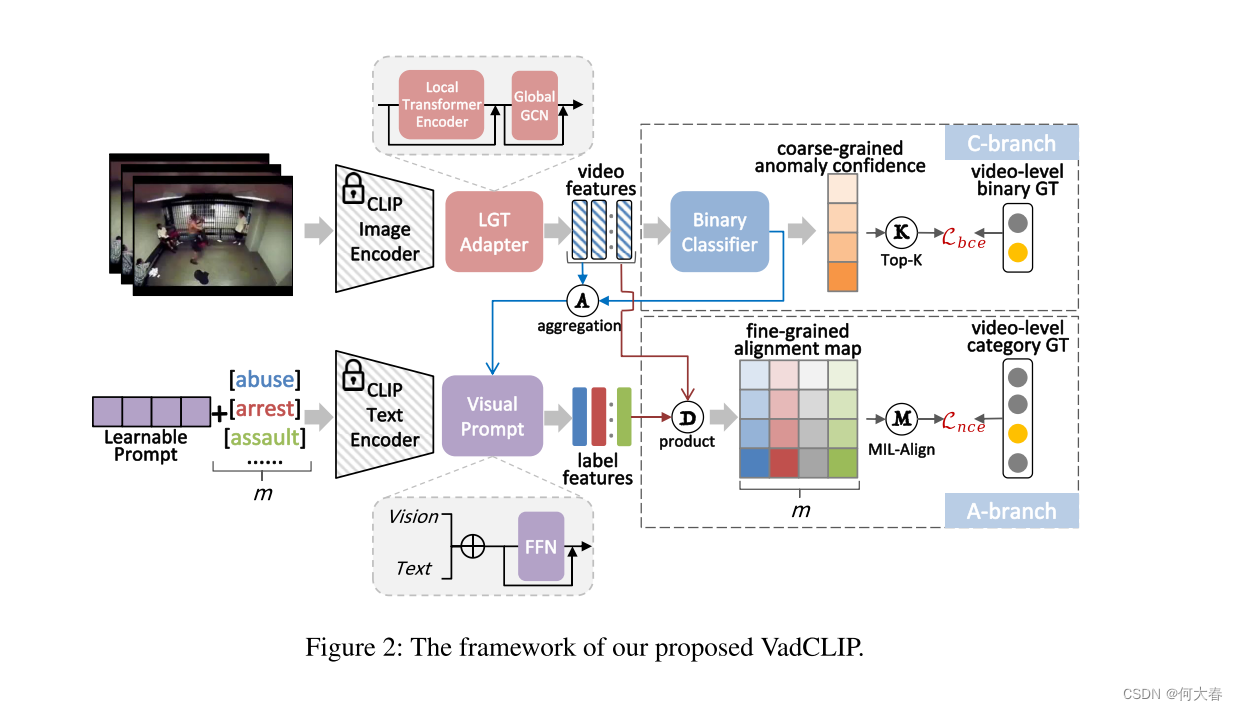

针对第一个挑战,我们提出了一个局部-全局时间适配器(LGT-Adapter),这是一个用于视频时间关系建模的轻量级模块。LGT-Adapter包括两个组件,即局部时间适配器和全局时间适配器,其中前者主要以高效率捕获局部时间依赖关系,因为在大多数情况下,当前事件与相邻事件高度相关,而后者以更全面的视角和更少的参数平滑特征信息。

针对第二个挑战,与当前方法(Joo等,2023年;Lv等,2023年)仅使用视觉特征不同,我们鼓励VadCLIP尽可能利用文本特征,以保留已学知识。如图1所示,VadCLIP被设计为双分支方式,其中一个分支(C-分支)简单直接地利用视觉特征进行二分类,而另一个分支(A-分支)则同时利用视觉和文本特征进行语言-图像对齐。此外,这种双分支无缝实现了粗粒度和细粒度的WSVAD(Wu,Liu和Liu,2022年)。对于A-分支,我们在视频和视频级文本标签之间建立桥梁。此外,我们提出了两种提示机制(Wu等,2023年),即可学习提示和视觉提示,以指定简洁的文本与视频的关系。与手工设计的提示相比,可学习提示不需要大量的专业知识,有效地将预训练知识转移到下游的WSVAD任务中。视觉提示的灵感来自于视觉上下文可以使文本更准确和有区别。想象一下,如果视频中有一辆车,"车祸"和"打架"这两种异常事件将更容易区分。因此,在视觉提示中,我们关注视频中的异常信息,并将C-分支中的这些异常焦点视觉内容与A-分支中的文本标签集成,用于自动提示工程。这种做法无缝地创建了双分支之间的连接。

针对第三个挑战,多实例学习(MIL)(Sultani,Chen和Shah,2018年;Wu等,2020年)是最常用的方法。对于A-分支中的语言-视觉对齐,我们引入了一个MIL-Align机制,其核心思想是为每个标签选择最匹配的视频帧来代表整个视频。

请注意,在训练期间,CLIP图像和文本编码器的权重保持固定,并且梯度被反向传播以优化设计的适配器和提示模块的这些可学习参数。

总体而言,我们工作的贡献有三个方面:

(1)我们提出了一种新颖的框架,即VadCLIP,它包含双分支来分别以视觉分类和语言-视觉对齐方式检测视频异常。凭借双分支的优势,VadCLIP实现了粗粒度和细粒度的WSVAD。据我们所知,VadCLIP是首个有效地将预训练的语言-视觉知识转移到WSVAD的工作。

(2)我们提出了三个非必要组件,以应对新框架带来的挑战。LGT-Adapter用于从不同角度捕获时间依赖关系;两种提示机制被设计出来,以有效地使冻结的预训练模型适应WSVAD任务;MIL-Align实现了在弱监督下对齐范式的优化,以尽可能保留预训练知识。

(3)我们展示了VadCLIP在两个大规模热门基准数据集上的强大和有效性,并且VadCLIP取得了最先进的性能,例如,在XD-Violence和UCF-Crime上分别获得了空前的结果,AP达到了84.51%,AUC达到了88.02%,大大超过了当前基于分类的方法。

Related Work

Weakly Supervised Video Anomaly Detection

最近,一些研究者(Zaheer等,2020年;冯,洪,郑,2021年;吴等,2021年;陈等,2023年)提出了用于VAD的弱监督方法。Sultani等人(Sultani,Chen和Shah,2018年)首次提出了一种深度多实例学习模型,将视频视为一个袋子,将其多个片段视为实例。随后的几项研究工作努力基于自注意力模型和transformers来建模时间关系。例如,钟等人(钟等,2019年)提出了一种基于图卷积网络(GCN)的方法,用于建模视频片段之间的特征相似性和时间一致性。田等人(田等,2021年)采用自注意力网络来捕获视频的全局时间上下文关系。李等人(李,刘,焦,2022年)提出了一种基于transformer的多序列学习框架,黄等人(黄等,2022年)提出了一种基于transformer的时间表示聚合框架。周等人(周,于,杨,2023年)提出了一个全局和局部多头自注意力模块,用于transformer层,以获得更具表现力的嵌入,以捕获视频中的时间依赖关系。上述方法只检测视频帧是否异常,相反,吴等人(吴,刘,刘,2022年)提出了一种细粒度的WSVAD方法,区分不同类型的异常帧。最近,CLIP模型也在VAD社区引起了极大关注。基于CLIP的视觉特征,吕等人(吕等,2023年)提出了一种新的MIL框架称为无偏MIL(UMIL),用于学习改善WSVAD性能的无偏异常特征。Joo等人(Joo等,2023年)提出了利用CLIP的视觉特征来有效提取有区别的表示,并通过时间自注意力来建模长短范围的时间依赖关系,并提名感兴趣的片段。所有上述方法都基于分类范式,通过预测异常帧的概率来检测异常事件。然而,这种分类范式没有充分利用文本标签的语义信息。

Vision-Language Pre-training

在过去几年中,视觉语言预训练取得了令人瞩目的进展,旨在通过在大规模数据上进行预训练,学习视觉和语言之间的语义对应关系。作为最具代表性的作品之一,CLIP在一系列视觉语言下游任务上展现了出色的性能,包括图像分类(Zhou等人,2022a)、图像字幕生成(Mokady,Hertz和Bermano,2021)、目标检测(Zhou等人,2022b)、场景文本检测(Yu等人,2023)、密集预测(Zhou等人,2022c;Rao等人,2022)等。最近,一些后续工作尝试利用预训练模型进行视频领域的应用。例如,CLIP4Clip(Luo等人,2022)将CLIP模型的知识转移到了视频-文本检索领域,一些作品(Wang,Xing和Liu,2021;Lin等人,2022;Ni等人,2022)试图利用CLIP进行视频识别,此外,CLIP被用于解决更复杂的视频动作定位任务(Nag等人,2022;Ju等人,2022)。更普遍地,Ju等人(Ju等人,2022)提出了一个简单但强大的基线,以高效地将预训练的基于图像的视觉语言模型进行适应,并利用其对于一般视频理解的强大能力。在本工作中,我们深入探讨了如何高效地将CLIP的预训练视觉语言知识从图像级别适应到视频级别的下游弱监督视频异常检测任务中。

Method

Problem Definition

WSVAD任务假定在训练阶段只提供视频级别的标签。对于给定的视频v,如果该视频的所有帧都不包含异常事件,则将此视频定义为正常,标签为y = 0;否则,如果至少有一帧包含异常事件,则将此视频标记为异常,标签为y = 1。WSVAD任务的目标是训练一个检测模型,能够在仅提供视频级别注释的情况下预测帧级别的异常置信度。

先前的研究通常利用预训练的3D卷积模型,例如C3D(Tran等人,2015年)和I3D(Carreira和Zisserman,2017年),来提取视频特征,然后将这些特征输入基于MIL的二元分类器中。这些范式在本文中被称为基于分类的范式。最近,作为大规模语言-视觉预训练模型的CLIP已经在计算机视觉领域的许多领域中取得了突破,展现出了在广泛的下游任务中的强大泛化能力。受到CLIP的启发,我们的工作不仅使用CLIP的图像编码器作为主干来提取视频特征,还尝试利用CLIP的文本编码器充分利用视觉内容和文本概念之间强大的关联。我们的工作在图2中展示。

Local and Global Temporal Adapter

据我们所知,CLIP是在从网络中爬取的大规模图像-文本对上进行预训练的。在本节中,我们研究如何建模时间依赖关系,以及如何弥合图像领域和视频领域之间的差距,以适用于CLIP。与此同时,学习WSVAD任务的长期和短期时间依赖关系也是非常重要的(Zhou、于和杨,2023年;吴和刘,2021年)。从效率和感受野的角度出发,我们设计了一种新的与局部和全局感受野兼容的时间建模方法。

Local Module.为了捕捉局部时间依赖关系,我们在来自CLIP冻结图像编码器的帧级特征 X c l i p ∈ R n × d X_{clip} ∈ \mathbb{R}^{n×d} Xclip∈Rn×d之上引入了一个Transformer编码器层,其中 n n n是视频的长度, d d d是维度大小,在本文中设置为512。需要注意的是,这一层与普通的Transformer编码器层不同,因为它将自注意力计算限制在局部窗口(Liu等人,2021年)而不是全局范围内。具体来说,我们将帧级特征分割成等长且重叠的窗口,自注意力计算被限制在每个窗口内,窗口之间没有信息交换。这样的操作具有类似卷积的局部感受野,并且导致较低的计算复杂度。

Global Module.为了进一步捕捉全局时间依赖关系,我们在局部模块之后引入了一个轻量级的GCN模块,由于GCN在VAD中被广泛采用并证明了其性能(Zhong等人,2019年;Wu等人,2020年;吴和刘,2021年),我们采用GCN来捕获全局时间依赖关系。根据(Zhong等人,2019年;Wu等人,2020年)的设置,我们使用GCN从特征相似性和相对距离的角度建模全局时间依赖关系,总结如下: X g = g e l u ( [ Softmax ( H sim ) ; Softmax ( H dis ) ] X l W ) X_g = gelu \left( \left[ \text{Softmax} (H_{\text{sim}}) ; \text{Softmax} (H_{\text{dis}}) \right] X_l W \right) Xg=gelu([Softmax(Hsim);Softmax(Hdis)]XlW)

其中, H sim H_{\text{sim}} Hsim和 H dis H_{\text{dis}} Hdis是邻接矩阵,Softmax标准化用于确保 H sim H_{\text{sim}} Hsim和 H dis H_{\text{dis}} Hdis的每一行的和等于 一。 X l X_l Xl是从局部模块获得的帧级视频特征, W W W是唯一的可学习权重,用于转换特征空间,这个设置展示了全局模块的轻量级特性。

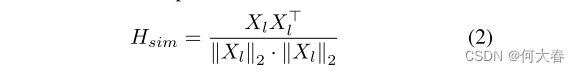

Feature similarity branch旨在为GCN生成相似性关系邻接矩阵。我们使用逐帧的余弦相似度来计算邻接矩阵

H

sim

H_{\text{sim}}

Hsim,其表达如下:

我们还使用阈值操作来过滤弱关系(Wu et al. 2020)。

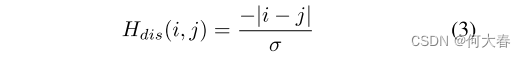

Position distance branch用于基于每两个帧之间的位置距离来捕获长范围依赖性。邻近邻接矩阵如下所示:

第i帧和第j帧之间的接近关系仅由它们的相对时间位置确定。 σ σ σ是一个超参数,用于控制距离关系的影响范围。局部Transformer和GCN层都采用残差连接来防止特征过度平滑。

Dual Branch and Prompt

Dual Branch.

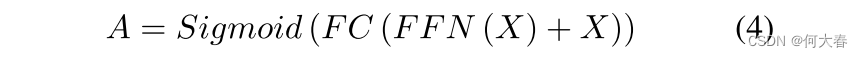

与先前的WSVAD工作不同,我们的VadCLIP包含双分支,更准确地说,除了传统的二元分类分支(C-Branch)外,我们还引入了一种新颖的视频-文本对齐分支,称为A-Branch。具体而言,在时间建模之后,视频特征

X

g

X_g

Xg被送入一个全连接(FC)层以获得最终的视频特征

X

∈

R

n

×

d

X \in \mathbb{R}^{n \times d}

X∈Rn×d。在C-Branch中,我们将

X

X

X馈入一个包含前馈网络(FFN)层、一个FC层和一个Sigmoid激活函数的二元分类器,以获得异常置信度

A

∈

R

n

×

1

A \in \mathbb{R}^{n \times 1}

A∈Rn×1。

在A-Branch中,文本标签,例如虐待、骚乱、打斗等,不再被编码为独热向量,相反,它们使用CLIP的文本编码器被编码为类嵌入。我们始终利用CLIP的冻结预训练文本编码器,因为文本编码器可以为视频异常检测提供语言知识先验。然后,我们计算类嵌入和帧级视觉特征之间的匹配相似性,以获得对齐映射

M

∈

R

n

×

m

M \in \mathbb{R}^{n \times m}

M∈Rn×m,其中

m

m

m是文本标签的数量,这样的设置类似于CLIP。在A-Branch中,每个输入文本标签表示一类异常事件,因此自然实现了细粒度的WSVAD。

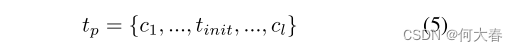

Learnable Prompt.在WSVAD中,文本标签是单词或短语,它们过于简洁,无法很好地总结异常事件。为了学习文本嵌入的强大可转移性,我们借鉴了CoOp(Zhou等人,2022a年)的灵感,并在原始类嵌入中添加了可学习的提示。具体而言,原始文本标签首先通过CLIP标记器转换为类令牌,即

t

i

n

i

t

=

Tokenizer(Label)

t_{init} = \text{Tokenizer(Label)}

tinit=Tokenizer(Label),其中Label是离散的文本标签,例如fighting,shooting,road accident等。然后,我们将

t

i

n

i

t

t_{init}

tinit与包含

l

l

l个上下文令牌的可学习提示

{

c

1

,

.

.

.

,

c

l

}

\{c_1, ..., c_l\}

{c1,...,cl}连接起来,形成一个完整的句子令牌,因此文本编码器的输入如下所示:

这里我们将类令牌放置在序列的中间。然后,将这个序列令牌加上位置嵌入以获取位置信息,最后,CLIP的文本编码器以

t

p

t_p

tp作为输入,并生成类嵌入

t

o

u

t

∈

R

d

t_{out} \in \mathbb{R}^d

tout∈Rd。

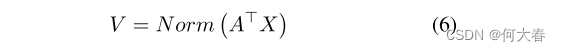

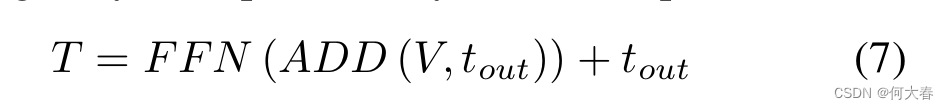

Anomaly-Focus Visual Prompt.为了进一步提高文本标签对异常事件的表示能力,我们研究如何利用视觉上下文来完善类嵌入,因为视觉上下文可以使简洁的文本标签更加准确。为此,我们提出了一个异常聚焦视觉提示,它聚焦在异常片段中的视觉嵌入,并将这些嵌入聚合为类嵌入的视频级提示。我们首先使用从C-Branch获得的异常置信度A作为异常注意力,然后通过异常注意力和视频特征X的点积计算视频级提示,如下所示:

其中,

N

o

r

m

Norm

Norm表示归一化,

V

∈

R

d

V ∈ \mathbb{R}^d

V∈Rd是异常聚焦视觉提示。然后,我们将V添加到类嵌入

t

o

u

t

t_{out}

tout中,并通过一个简单的前馈神经网络(FFN)层和一个跳跃连接获得最终的特定实例的类嵌入

T

T

T。

其中 A D D ADD ADD是逐元素加法。这样的实现允许类嵌入从视频中提取相关的视觉上下文。

有了 X X X和 T T T,我们计算所有类嵌入与帧级视觉特征之间的匹配相似度,以获得对齐图 M M M。

Objective Function

对于C-Branch,我们遵循以前的工作(Wu等人,2020年),使用Top-K机制在异常和正常视频中选择K个高异常置信度作为视频级预测。然后,我们使用视频级预测与地面实况之间的二元交叉熵来计算分类损失 L b c e \mathcal{L}_{bce} Lbce。

对于A-Branch,我们面临着新的挑战:

1)没有异常置信度;

2)面对的是多类而不是二元类别。

为了解决这个困境,我们提出了MIL-Align机制,它类似于普通的MIL。具体地,我们考虑对齐映射

M

M

M,因为它表示帧级视频特征与所有类别嵌入之间的相似性。对于每一行,我们选择前

K

K

K个相似性,并计算平均值来衡量该视频与当前类别之间的对齐程度。然后,我们可以得到一个向量

S

S

S = {

s

1

,

.

.

.

,

s

m

s_1,...,s_m

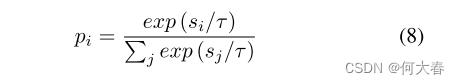

s1,...,sm},表示该视频与所有类别之间的相似度。我们希望视频及其配对的文本标签在其他标签中具有最高的相似度得分。为了实现这一点,首先计算多类预测,如下所示:

其中,

p

i

p_i

pi是关于第

i

i

i个类别的预测,

τ

τ

τ是用于缩放的温度超参数。最后,对齐损失

L

n

c

e

\mathcal{L}_{nce}

Lnce可以通过交叉熵来计算。

除了分类损失

L

b

c

e

\mathcal{L}_{bce}

Lbce和对齐损失

L

n

c

e

\mathcal{L}_{nce}

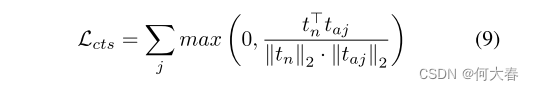

Lnce之外,我们还引入了对比损失,略微将正常类别嵌入和其他异常类别嵌入分开。首先,我们计算正常类别嵌入和其他异常类别嵌入之间的余弦相似度,然后计算对比损失

L

c

t

s

\mathcal{L}_{cts}

Lcts如下:

其中

t

n

t_n

tn是正常类嵌入,

t

a

t_a

ta是异常类嵌入。

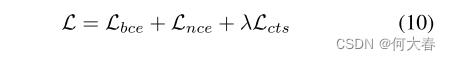

总体而言,VadCLIP的最终总目标由下式给出:

Inference

VadCLIP包含双分支,使其能够处理精细和粗粒度的WSVAD任务。

对于精细粒度的WSVAD,我们遵循以前的作品(Wu, Liu, and Liu 2022),并利用对齐映射M上的阈值策略来预测异常事件。

对于粗粒度的WSVAD,有两种计算帧级异常程度的方式。第一种是直接使用C-Branch中的异常置信度,第二种是使用A-Branch中的对齐映射,具体来说,将视频与正常类之间的相似度减去一即为异常程度。最后,我们选择这两种方式中最佳的一种来计算帧级异常程度。

Experiments

Datasets and Evaluation Metrics

Datasets.我们在两个流行的WSVAD数据集上进行实验,即UCF-Crime和XD-Violence。值得注意的是,这两个数据集上的训练视频仅具有视频级别的标签。

Evaluation Metrics.对于粗粒度的WSVAD,我们遵循先前的工作,使用XD-Violence数据集的帧级别平均精度(AP),以及UCF-Crime数据集的帧级别AUC和异常视频的AUC(称为AnoAUC)。对于细粒度的WSVAD,我们遵循视频动作检测中的标准评估协议,使用不同交并比(IoU)阈值下的平均精度(mAP)值。在这项工作中,我们使用从0.1到0.5的IoU阈值,步长为0.1,来计算mAP值。同时,我们还报告了mAP的平均值(AVG)。需要注意的是,我们仅在测试集的异常视频上计算mAP。

Implementation Details

网络结构方面,我们采用了预训练的CLIP(ViT-B/16)的冻结图像和文本编码器。FFN是Transformer中的标准层,ReLU被替换为GELU。对于超参数,我们将公式3中的σ设置为1,将公式8中的τ设置为0.07,上下文长度l设置为20。对于LGT-Adapter中的窗口长度,我们分别将其设置为64和8,用于XD-Violence和UCF-Crime。对于公式10中的λ,我们将其分别设置为XD-Violence上的 1 × 1 0 − 4 1 × 10^{-4} 1×10−4和UCF-Crime上的 1 × 1 0 − 1 1 × 10^{-1} 1×10−1。对于模型训练,VadCLIP在单个NVIDIA RTX 3090 GPU上使用PyTorch进行训练。我们使用AdamW作为优化器,批量大小为64。在XD-Violence上,学习率和总epoch分别设置为 2 × 1 0 − 5 2 × 10^{-5} 2×10−5和20,在UCF-Crime上,学习率和总epoch分别设置为 1 × 1 0 − 5 1 × 10^{-5} 1×10−5和10。

Comparison with State-of-the-Art Methods

VadCLIP可以同时实现粗粒度和细粒度的WSVAD,因此我们展示了VadCLIP的性能,并将其与几种最先进的方法在粗粒度和细粒度的WSVAD任务上进行比较。为了公平起见,所有比较方法都使用从CLIP提取的相同视觉特征,就像VadCLIP一样。

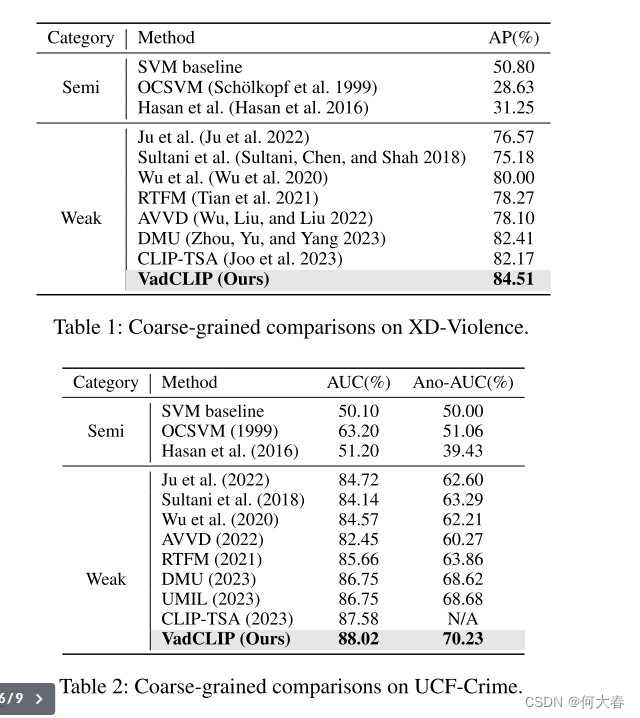

Coarse-grained WSVAD Results.我们在表1和表2中展示了比较结果。Ju等人(Ju et al. 2022)是一个基于CLIP的动作识别工作,与我们的方法相比明显不足。这样的结果展示了WSVAD任务的挑战,并且也展示了我们的方法相对于Ju等人(Ju et al. 2022)在特定的WSVAD任务上的优势。此外,我们发现VadCLIP在两个常用基准数据集上显著优于半监督方法和基于分类的弱监督方法,在所有评估指标上都是如此。更具体地说,VadCLIP在XD-Violence和UCF-Crime上分别达到了84.51%的AP和82.08%的AUC,成为了这两个数据集上的新的最先进水平。相比之下,在XD-Violence上,VadCLIP在AP方面比最佳竞争对手CLIP-TSA(Joo et al. 2023)和DMU(Zhou, Yu, and Yang 2023)分别提升了2.3%,在UCF-Crime上,VadCLIP在AUC方面也比它们提升了0.4%和1.3%。更重要的是,在所有比较方法中,AVVD(Wu, Liu, and Liu 2022)确实使用了精细的类标签,并且在XD-Violence和UCF-Crime上分别只达到了78.10%的AP和82.45%的AUC,远远落后于VadCLIP。这样的结果表明,简单地使用精细的标签不能带来性能提升,因为标签的过度输入增加了二分类的难度。VadCLIP的性能优势部分归因于视觉语言关联,因为所有比较基线都使用与VadCLIP相同的视觉特征。

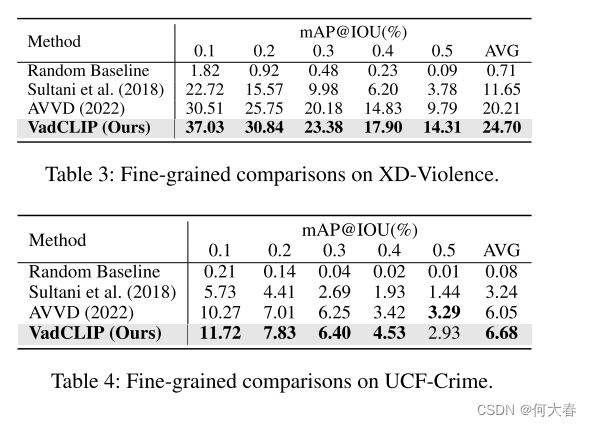

Fine-grained WSVAD Results.对于细粒度的WSVAD任务,我们在表3和表4中将VadCLIP与之前的作品AVVD和Sultani等人(Sultani, Chen, and Shah 2018; Wu, Liu, and Liu 2022)进行了比较。在这里,AVVD是第一个提出细粒度WSVAD的工作,我们重新使用CLIP的视觉特征对其进行了实现,然后我们还根据AVVD中的设置对Sultani等人的方法进行了微调,以适应细粒度的WSVAD。正如我们所看到的,细粒度的WSVAD相对于粗粒度的WSVAD是一个更具挑战性的任务,因为前者需要考虑多类别分类准确性和检测段的连续性。在这项任务上,VadCLIP在XD-Violence和UCF-Crime数据集上也明显优于这些优秀的比较方法。例如,在XD-Violence上,与Sultani等人和AVVD相比,VadCLIP在AVG方面的性能提升分别为13.1%和4.5%。

Ablation Studies

在XD-Violence数据集上进行了广泛的消融。在这里,我们选择相似性图来计算粗粒度WSVAD的帧级异常度。

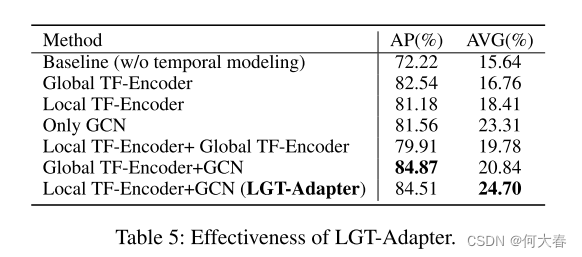

Effectiveness of LGT-Adapter.如表5所示,首先,没有LGT-Adapter的时间建模辅助,基线模型仅实现了72.22%的AP和15.64%的AVG,导致AP下降了12.3%,AVG下降了9.1%。其次,仅使用全局Transformer编码器层、局部Transformer编码器层或GCN层都明显提升了性能,特别是在AP方面,这明确表明Transformer编码器和GCN都能通过视频帧之间的自注意力机制高效捕获时间依赖性。第三,全局Transformer编码器和GCN的组合在AP方面略有提高(+0.4%),而局部Transformer编码器和GCN的组合在AVG方面表现显著更好(+3.9%)。我们还尝试了局部Transformer编码器和全局Transformer编码器的组合,但在AP方面性能显著下降,可能的原因是,与Transformer相比,GCN可以被视为是一种轻量级变体,较少的参数可以防止CLIP的学习知识在传输过程中受到影响。因此,局部Transformer编码器和GCN是最佳组合,可以捕获不同范围的时间依赖性。

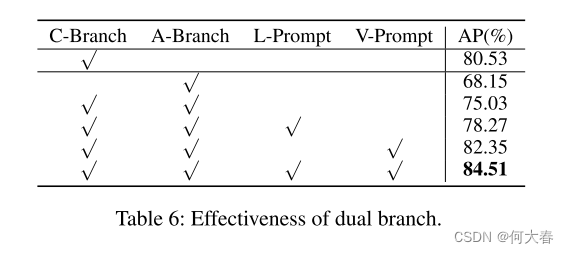

Effectiveness of Dual Branch.如表6所示,我们仅使用C-Branch的方法属于基于分类的范式,并且在XD-Violence上可以与当前最先进的方法竞争。另一方面,我们仅使用A-Branch的方法在AP方面表现不佳,因为它主要专注于细粒度的WSVAD。在C-Branch中利用粗粒度分类对特征优化的帮助下,A-Branch获得了约7%的AP改进。通过进一步添加A-Branch中的可学习提示和视觉提示,这些是A-Branch中的专门设计,我们注意到可以实现一致的性能提升,从而达到新的最先进水平。这些结果清楚地表明,包含粗粒度分类范式和细粒度对齐范式的双分支可以通过利用不同粒度的互补性来提高性能。

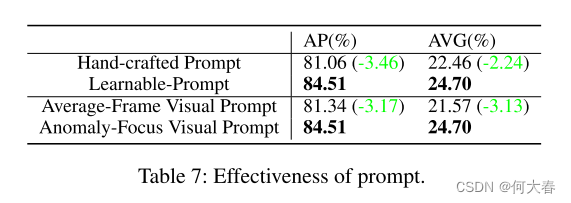

Effectiveness of Prompt.如表7所示,使用手工设计的提示会导致AP下降3.5%,AVG下降2.2%,这表明可学习的提示更有潜力,可以更好地适应从大型语言-视觉模型到WSVAD任务的预训练知识。此外,简单地使用视觉提示中的帧级特征的平均值(Ni等人,2022年)导致AP下降3.2%,AVG下降3.1%,这样的结果表明,关注视频中的异常片段可以支持VadCLIP获得更准确的实例特定文本表示,从而增强了视频-语言对齐的能力,对WSVAD任务很有用。我们建议读者参考补充材料进行更多消融研究和定性可视化。

Qualitative Analyses

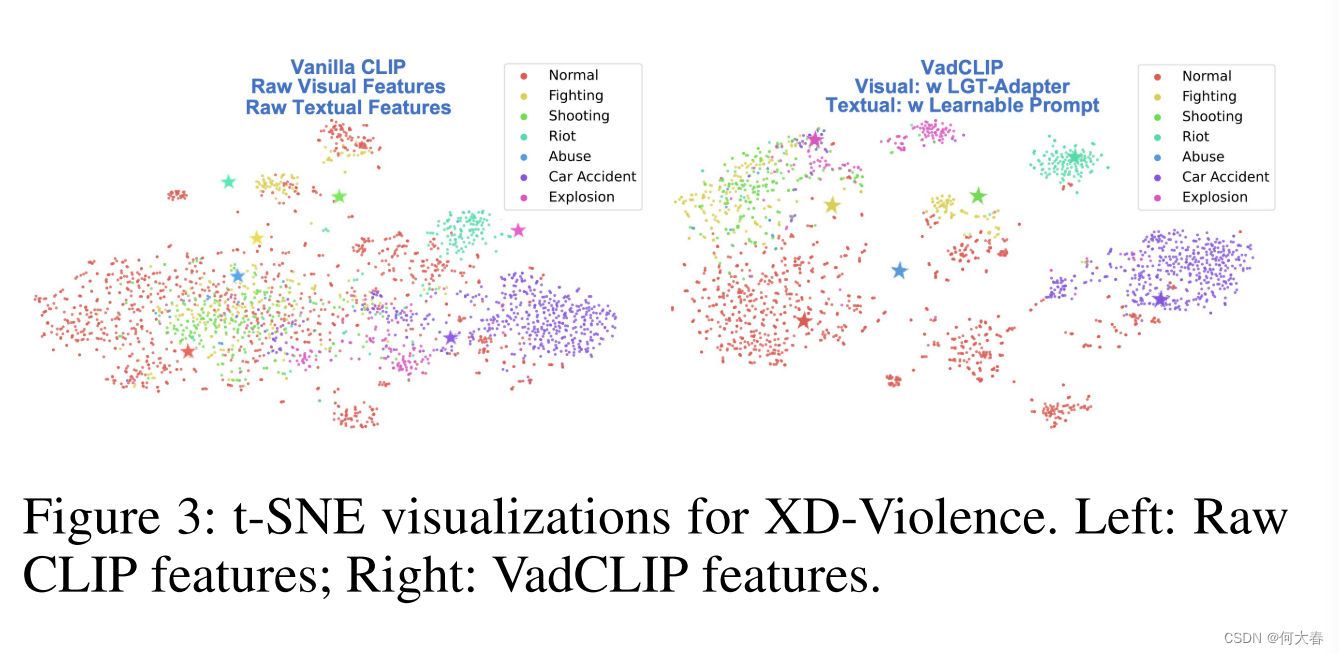

Feature Discrimination Visualization.我们使用 t-SNE 对 XD-Violence 的特征分布进行可视化,结果如图3所示,其中星形图标表示文本标签特征。正如我们所看到的,尽管 CLIP 基于图像-文本对学习了广义的能力,但由于 WSVAD 任务的内在问题,这样的能力仍然不能让它有效区分不同的类别。经过 VadCLIP 的专门优化后,这些视觉特征具有更明显的边界,并且围绕着相应的文本类特征。

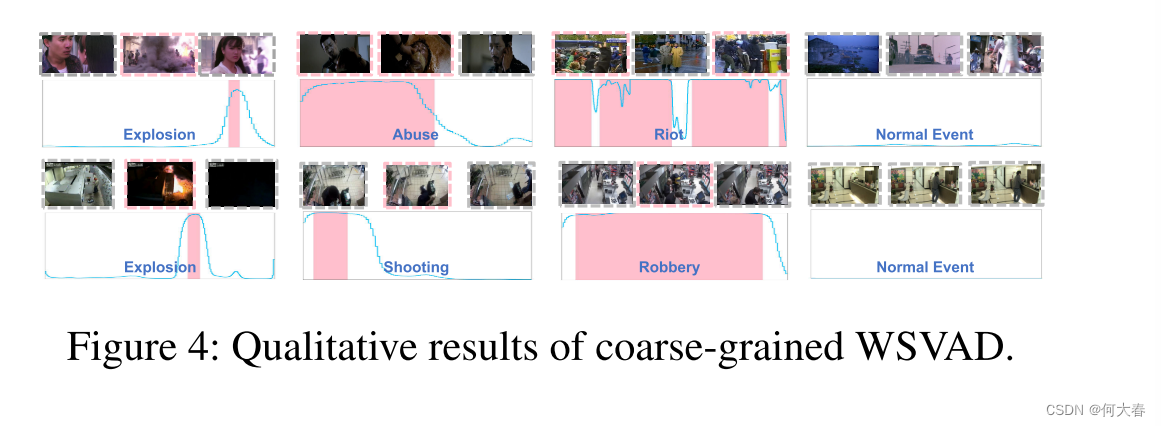

Coarse-grained Qualitative Visualization.我们在图 4 中展示了粗粒度 WSVAD 的定性可视化结果,其中蓝色曲线代表异常预测,粉色区域对应着地面真实的异常时间位置。正如我们所看到的,VadCLIP 准确地检测到了两个基准测试中不同类别的异常区域,同时,它还在正常视频上产生了相当低的异常预测值。

Conclusion

在这项工作中,我们提出了一种名为VadCLIP的新范式,用于弱监督视频异常检测。为了有效地将预训练的知识和视觉-语言关联从冻结的CLIP适应到WSVAD任务中,我们首先设计了一个LGT-Adapter来增强时间建模的能力,然后我们设计了一系列的提示机制来提高一般知识对特定任务的适应性。最后,我们引入了MIL-Align操作,以促进在弱监督下的视觉-语言对齐的优化。我们通过对两个WSVAD基准测试进行了充分的实验证明了VadCLIP的有效性和最新性能。在未来,我们将继续探索视觉-语言预训练知识,并进一步致力于开放集VAD任务。