热门标签

热门文章

- 1git-提交代码等命令基本操作,本地项目如何提交到远程github,修改用户名密码_git 提交

- 2AI复活「她」!用GPT-3复刻逝去未婚妻,美国小哥让挚爱以数字形态永生

- 3论文笔记:联邦学习——Federated Learning: Challenges, Methods, and Future Directions

- 4【Java架构-包管理工具】-Maven基础(一)_java包管理工具

- 52022 Robocom世界机器人开发者大赛 CAIP编程赛道 本科组-决赛 挨打记录+题解_2022睿抗机器人开发者大赛caip-编程技能赛初赛题目

- 6基于FPGA的自动售货机Verilog代码Quartus仿真_自动售货机verilog代码仿真图

- 7docker弄oracle,Docker搭建Oracle

- 8MACOS如何从官网下载maven并安装_mac安装maven下载

- 9Android Studio之修改module名称_androidstudio修改module名字

- 10软件测试十大必问面试题(附答案和解析)_软件测试技能面试题目_软件测试面试经常问的问题

当前位置: article > 正文

【AI学习指南】轻量级模型-用 Ollama 轻松玩转本地大模型

作者:神奇cpp | 2024-08-01 00:57:21

赞

踩

【AI学习指南】轻量级模型-用 Ollama 轻松玩转本地大模型

目录

安装 CUDA 驱动程序(可选 - 适用于 Nvidia GPU)

探索

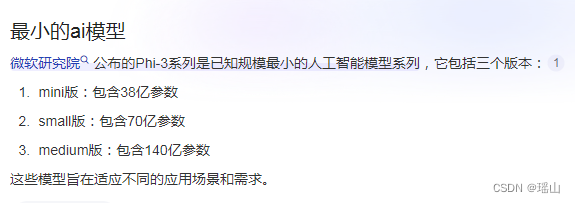

最小的AI模型

发现

其实最近受限于个人电脑配置和工作经历,对AI的探索几乎停滞了下来,直到今天无意中看到了这个

本来以为是个噱头,大家都知道模型越大,参数越多,性能就更好,同样的对硬件的要求就越高,只是看热闹似的搜索了下

Phi-3 Mini模型:这是一款专为手机和其他移动设备设计的轻量级语言模型。它能在手机上本地运行,提供高级语言处理功能,如个性化智能助理、实时语言翻译以及增强现实交互等

性能逼近GPT3.5ÿ

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/神奇cpp/article/detail/911575

推荐阅读

相关标签