- 1区块链应用实例_区块链应用实践的实例分析

- 2c语言自动阅卷系统概要设计,VC++自动阅卷系统设计与实现(源代码及全套资料).doc...

- 3关于如何自定义spring-boot-starter起步依赖_aliyun-oss-spring-boot-starter

- 4创建 vite+vue3+ts 移动端项目_vue 3.0 搭建移动端项目

- 5Windows下使用海康相机SDK获取图像并在Qt显示_海康mvs

- 6CVE-2018-8120漏洞提权:Windows 7的安全剖析与实战应用

- 7django的继承(extends)和包含(include)_pycharm中django咋用继承

- 8word2vec论文翻译(5000字)

- 9深度学习图绘制工具汇总_convnetdraw

- 10使用pip安装TensorFlow & 相关问题_pip 3.12 可以下载tensorflow2.3.0吗

Linux下root用户安装单机Hadoop+Hive_hadoop hive安装

赞

踩

Linux下root用户安装单机Hadoop+Hive

1.首先需要一台安装了JDK8的Centos7虚机,这里不再进行介绍

2.官网下载Hadoop以及Hive安装包

这里我使用的是hadoop-3.2.4以及hive-3.1.3

可以到官网下载,或者我的网盘链接下载

hadoop:

链接:https://pan.baidu.com/s/1fiJ6yhTaJ4TB01GaX9rutg

提取码:9g5l

hive:

链接:https://pan.baidu.com/s/1GUcr1FpAS3DJir8A6voBDQ

提取码:9pvm

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

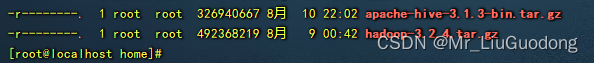

3.将下载好的安装包上传至服务器

可以借助finallshell、xshell、rz命令等方式

此处我上传至/home/下

- 1

- 2

- 3

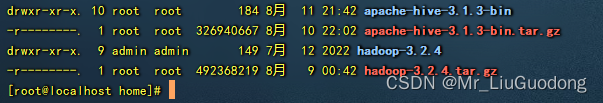

4.解压

tar -zxvf hadoop-3.2.4.tar.gz

tar -zxvf apache-hive-3.1.3-bin.tar.gz

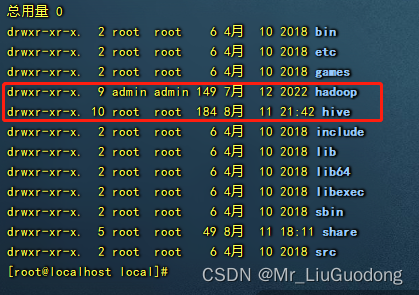

#此处我将解压好的hadoop和hive移动到/usr/local/下,重命名为hadoop和hive

mv hadoop-3.2.4 /usr/local/hadoop

mv apache-hive-3.1.3-bin /usr/local/hive

- 1

- 2

- 3

- 4

- 5

5.安装Hadoop

5.1 配置环境变量

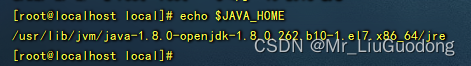

5.1.1 JAVA

如果你的虚拟机是自带的java,那么可以使用echo $JAVA_HOME看是否有配置JAVA_HOME

echo $JAVA_HOME

- 1

如果出现了内容,则是你的JAVA_HOME已经配置,如果是空,则没有配置

没有配置的情况下,需要查找java的安装路径

首先使用which java(which查看的是可执行命令的位置)(由于我已经配置过,所以这里借用以前的截图)

which java

- 1

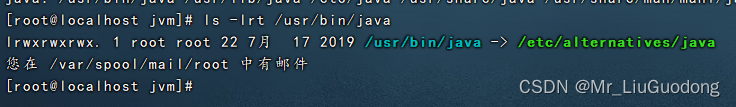

执行 ls -lrt /usr/bin/java

ls -lrt /usr/bin/java

- 1

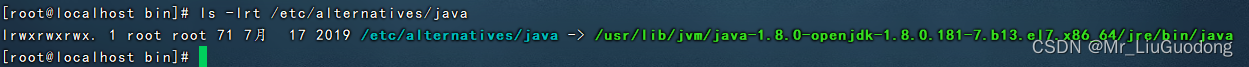

接下来继续执行ls -lrt /etc/alternatives/java

ls -lrt /etc/alternatives/java

- 1

这里可以看到java的安装路径

/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.181-7.b13.el7.x86_64/jre

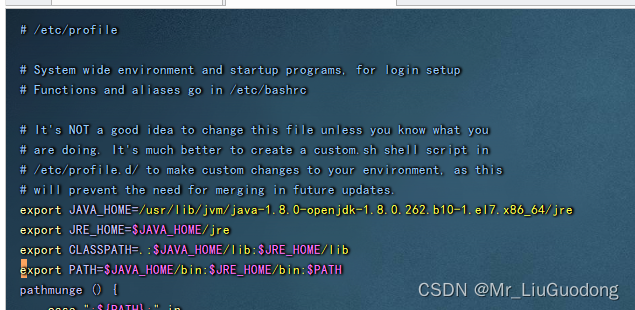

现在可以配置环境变量

vim /etc/profile

- 1

加入下面的配置

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.181-7.b13.el7.x86_64/jre

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

- 1

- 2

- 3

- 4

退出编辑并保存,然后让文件生效

source /etc/profile

- 1

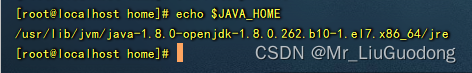

再次执行echo $JAVA_HOME查看结果,如果可以看到刚刚配置的安装位置即为成功

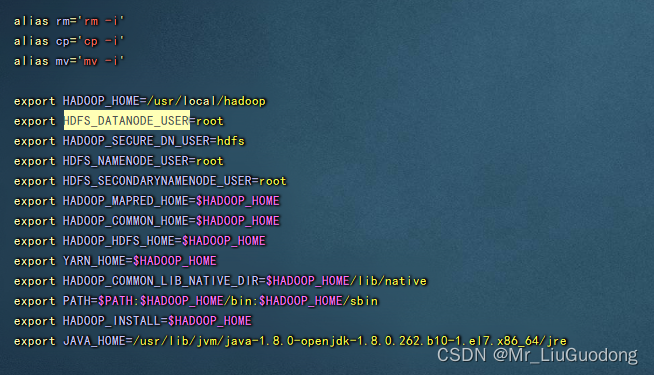

5.1.2

配置hadoop变量

vim ~/.bashrc

- 1

加入以下内容

#这里是上面hadoop的文件所在目录,我这里使用的是/usr/local/hadoop

export HADOOP_HOME=/usr/local/hadoop

export HDFS_DATANODE_USER=root

export HADOOP_SECURE_DN_USER=hdfs

export HDFS_NAMENODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_INSTALL=$HADOOP_HOME

#这里和上面/etc/profile里的JAVA_HOME内容一样

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.181-7.b13.el7.x86_64/jre

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

退出编辑并保存

使配置生效

创建/data/logs/hadoop目录,后面要用到

mkdir -p /data/logs/hadoop

- 1

source ~/.bashrc

- 1

配置Hadoop环境配置文件hadoop-env.sh,以root配置hadoop-env.sh添加自己的环境变量

vim /usr/local/hadoop/etc/hadoop/hadoop-env.sh

- 1

加入以下内容

export HADOOP_OS_TYPE=${HADOOP_OS_TYPE:-$(uname -s)}

export HDFS_NAMENODE_OPTS=" -Xms1024m -Xmx1024m -XX:+UseParallelGC"

export HDFS_DATANODE_OPTS=" -Xms1024m -Xmx1024m"

#这里的目录需要提前创建

export HADOOP_LOG_DIR=/data/logs/hadoop

- 1

- 2

- 3

- 4

- 5

- 6

- 7

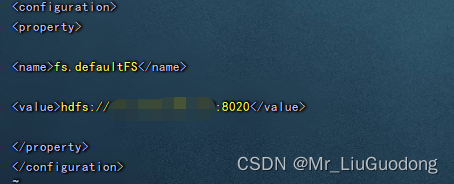

配置Hadoop的Web配置文件core-site.xml;

vim /usr/local/hadoop/etc/hadoop/core-site.xml

- 1

加入以下内容,注意将本机IP替换为你的IP

<property>

<name>fs.defaultFS</name>

<value>hdfs://本机IP:8020</value>

</property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

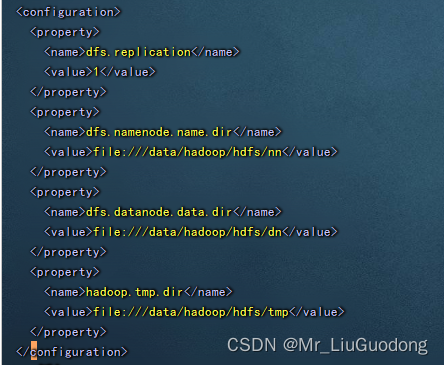

配置Hadoop的HDFS配置文件hdfs-site.xml

vim /usr/local/hadoop/etc/hadoop/hdfs-site.xml

- 1

加入以下内容

<property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:///data/hadoop/hdfs/nn</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:///data/hadoop/hdfs/dn</value> </property> <property> <name>hadoop.tmp.dir</name> <value>file:///data/hadoop/hdfs/tmp</value> </property>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

创建上面配置要用到的目录

mkdir -p /data/hadoop/hdfs/nn

mkdir -p /data/hadoop/hdfs/dn

mkdir -p /data/hadoop/hdfs/tmp

- 1

- 2

- 3

关闭防火墙,并取消防火墙的自启动

#停止firewall

systemctl stop firewalld.service

#禁止firewall开机启动

systemctl disable firewalld.service

- 1

- 2

- 3

- 4

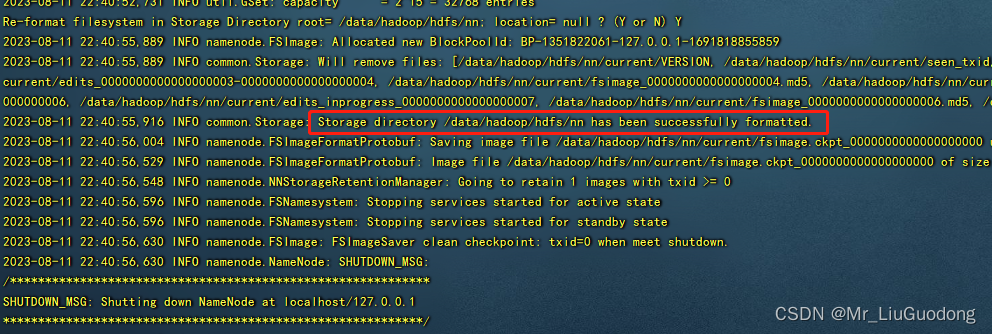

5.2 格式化namenode

hdfs namenode -format

- 1

出现下图中红框内内容为成功

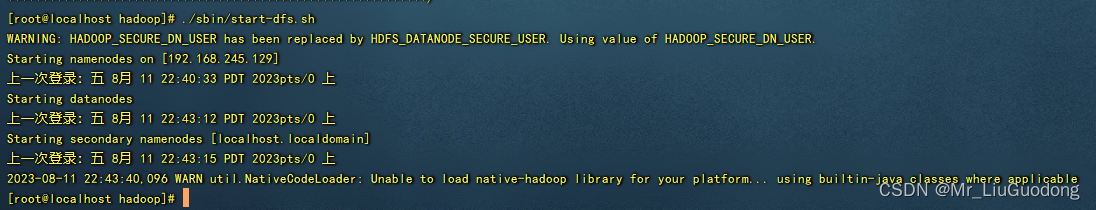

5.3 启动hadoop

cd /usr/local/hadoop/

./sbin/start-dfs.sh

- 1

- 2

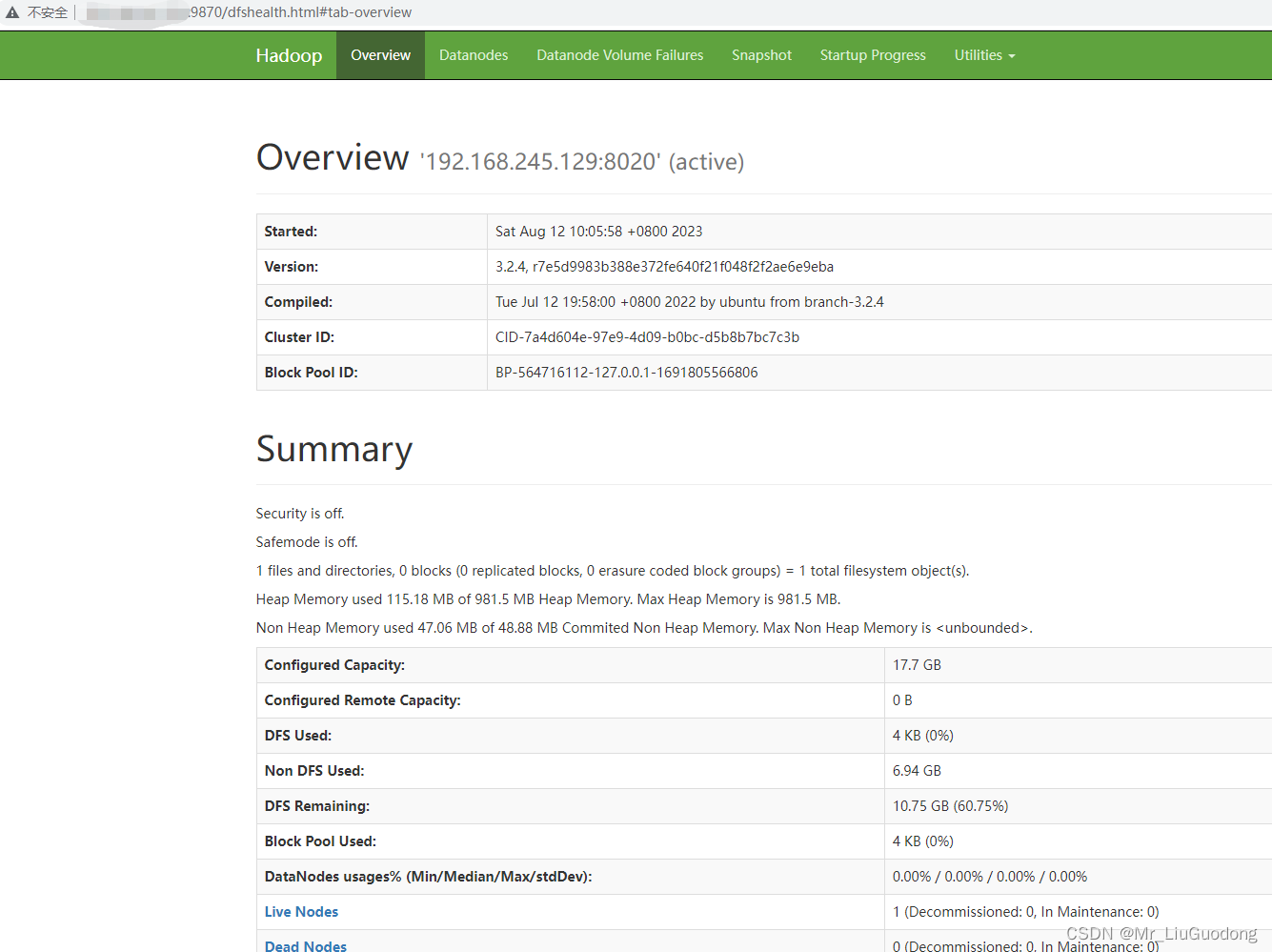

启动之后访问你的IP:9870,出现下图页面即为成功

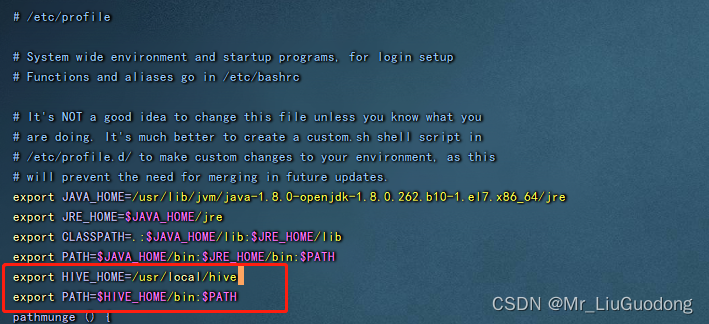

6.安装Hive

6.1 配置环境变量

vim /etc/profile

- 1

加入以下内容

export HIVE_HOME=/usr/local/hive

export PATH=$HIVE_HOME/bin:$PATH

- 1

- 2

使配置生效

source /etc/profile

- 1

在 hive 安装目录的 conf 目录下,创建 hive-site.xml 配置文件。并将以下内容写入其中 注意将你的数据库IP,数据库用户名,数据库密码替换为你的

<?xml version="1.0" encoding="UTF-8" standalone="no"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration> <property> <name>hive.metastore.warehouse.dir</name> <value>/usr/local/hive/warehouse</value> </property> <property> <name>hive.metastore.db.type</name> <value>mysql</value> </property> <property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://你的数据库IP:3306/hive?createDatabaseIfNotExist=true</value> </property> <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.cj.jdbc.Driver</value> </property> <property> <name>javax.jdo.option.ConnectionUserName</name> <value>你的数据库用户名</value> </property> <property> <name>javax.jdo.option.ConnectionPassword</name> <value>你的数据库密码</value> </property> <property> <name>hive.metastore.schema.verification</name> <value>false</value> <description>关闭schema验证</description> </property> <property> <name>hive.cli.print.current.db</name> <value>true</value> <description>提示当前数据库名</description> </property> <property> <name>hive.cli.print.header</name> <value>true</value> <description>查询输出时带列名一起输出</description> </property> </configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

替换guava包

将hive自带的guava包删除

将hadoop带的guava包复制过来

cd /usr/local/hive/

rm -rf ./lib/guava-19.0.jar

cp /usr/local/hadoop/share/hadoop/common/lib/guava-27.0-jre.jar ./lib/

- 1

- 2

- 3

放置MySQL jdbc jar包

取maven中央仓库下载,或者下载我准备好的,我使用的是mysql-connector-java-8.0.26.jar

链接:https://pan.baidu.com/s/1wGiAm7vu8ZSbrk24VJAt8Q

提取码:mn77

将jar包放到/usr/local/hive/lib/下

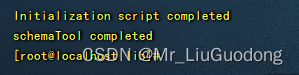

初始化元数据库

schematool -initSchema -dbType mysql

- 1

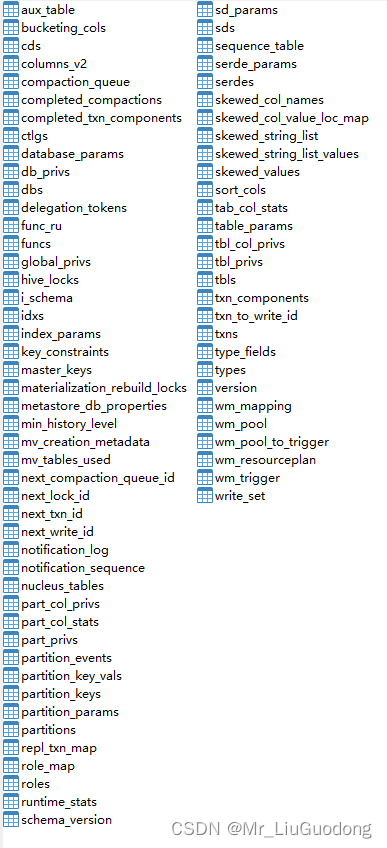

出现下图内容则为初始化成功,可以到你的数据库中查看是否已经有了名为hive的mysql数据库

hive库的表

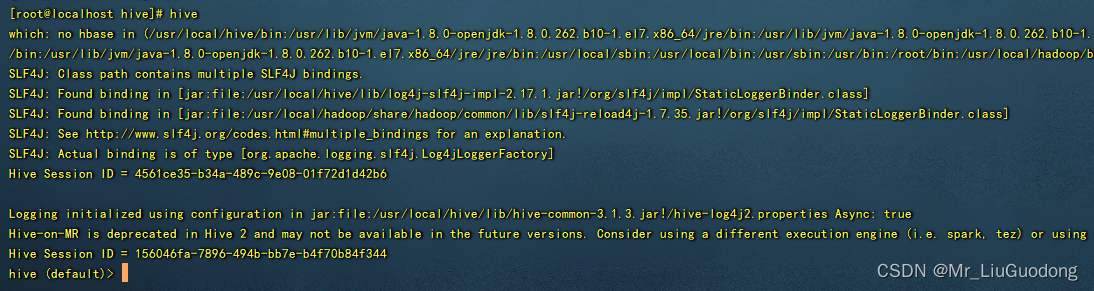

至此,hive安装完成,启动成功。可以输入hive,进行操作

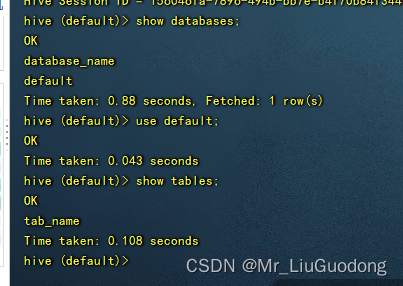

默认在default库下,可以查看有哪些数据库,查看库中的表。

show databases;

use default;

show tables;

- 1

- 2

- 3

顺便说一下,本次搭建的hadoop没有添加开机启动,hive是开机自启的。

至此,linux下单机版hadoop+hive安装完成。感谢观看!

如有发现错误,请批评指正,感谢