- 1如何让一些文件的更改不同步到远程仓库但是在远程仓库保留_git想要在远程仓库但是不跟踪变化

- 2自定义React Native的RadioButton和RadioGroup(单选按钮)_react native 单选框

- 3Python学习_python中键盘输入的+号是字符串么

- 4解决高版本问题Cannot resolve org.springframework.cloud:spring-cloud-starter-bootstrap:unknown

- 5Linux 查看系统日志命令_btmp begins

- 6【重磅开源】MapleBoot线上demo环境初体验

- 7CVPR2017-如何在无标签数据集上训练模型_深度学习没有标签怎么训练?

- 8洞悉安全现状,建设网络安全防护新体系

- 9Linux基础命令-cp拷贝文件_linux cp命令复制文件夹

- 10git相关操作(一) —— git工作区域&基本信息设置&初始化init & git本地操作 & git分支管理_git工作目录

跟无神学机器学习之大模型GPT4技术报告详解_gpt4技术报告分析

赞

踩

一、前言

对于从事AI方面的研究者来说,大语言模型的浪潮已势不可挡,任何此行业者都应对大语言模型有一定的认知和了解,这是这个时代必需的技能,今天,无神带大家详解open-AI的GPT4技术报告。

二、模型架构

出于商业考虑,该报告不公开模型具体架构,只提了一嘴使用Transformer+强化学习做出来的,是在GPT3.5的基础上在另一个Human数据集上进行的微调,增加了一定的安全性和在各种行业考试上的表现能力。

其中,Transformer在博主的上一篇中有详细的介绍。详见:《Attention is all you need》之Transformer详解_AIzealot无的博客-CSDN博客

三、模型的特点,换句话说,为什么大?

3.1 参数量大

每个版本,参数量成好几个数量级的增加,因此,也是GPT能有如此强大的表现的原因。

3.2 训练的数据量大

这种大模型的开发,需要极强的计算资源,没有财力的话根本训练不成大模型这种硅积的模型。

Open-AI就在微软的财力的支持下进行的。

四、新增的功能

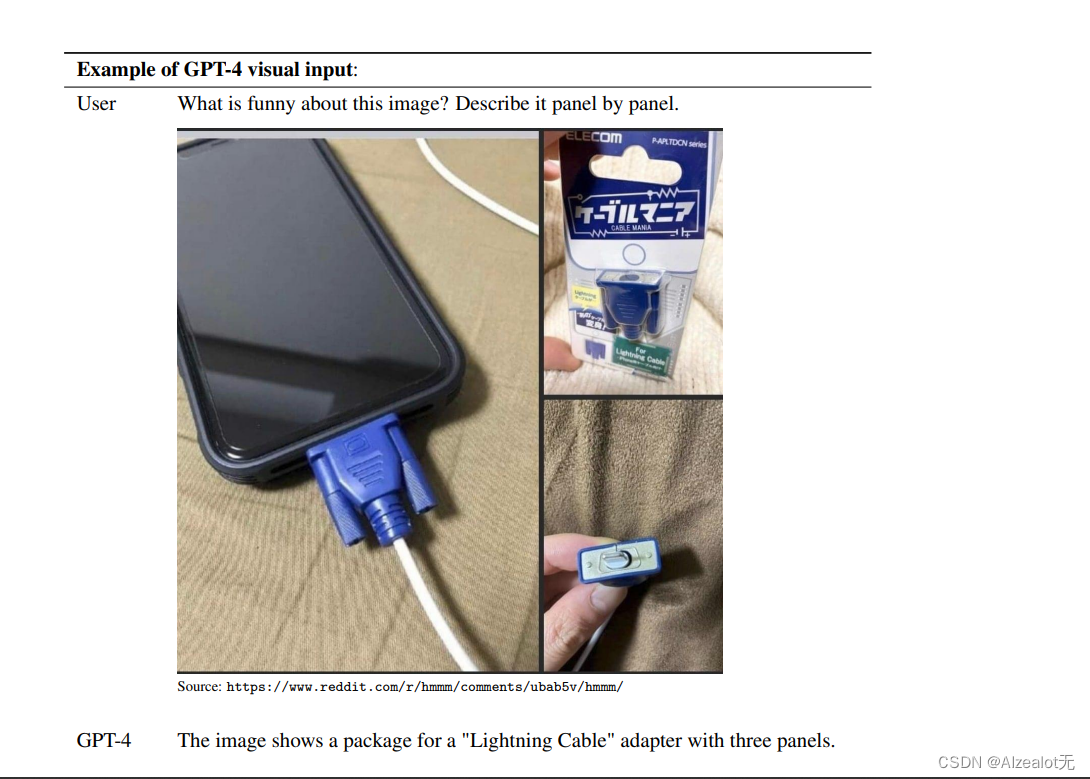

对于图片、视频的相关任务的支持力度更大。可以从官方给的例子看出:

更多的是对于图片-文字的一个生成的功能的支持。

据了解,该功能截止目前发表时间还未完全部署上线。

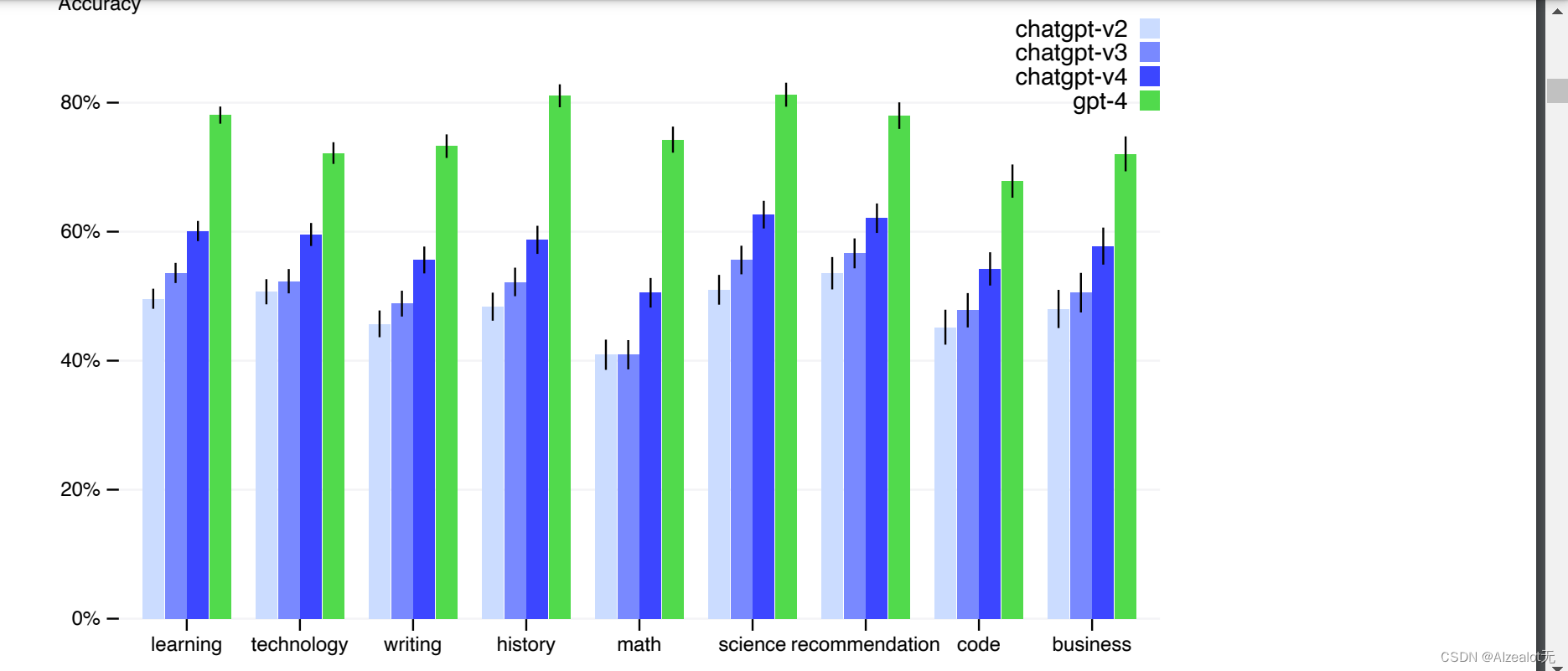

同时各种表现的准确性等打分指标比较3.5版本有了一定的提升。

在各类问题的准确率随着版本的提升:

在对抗的提示词下的准确率:

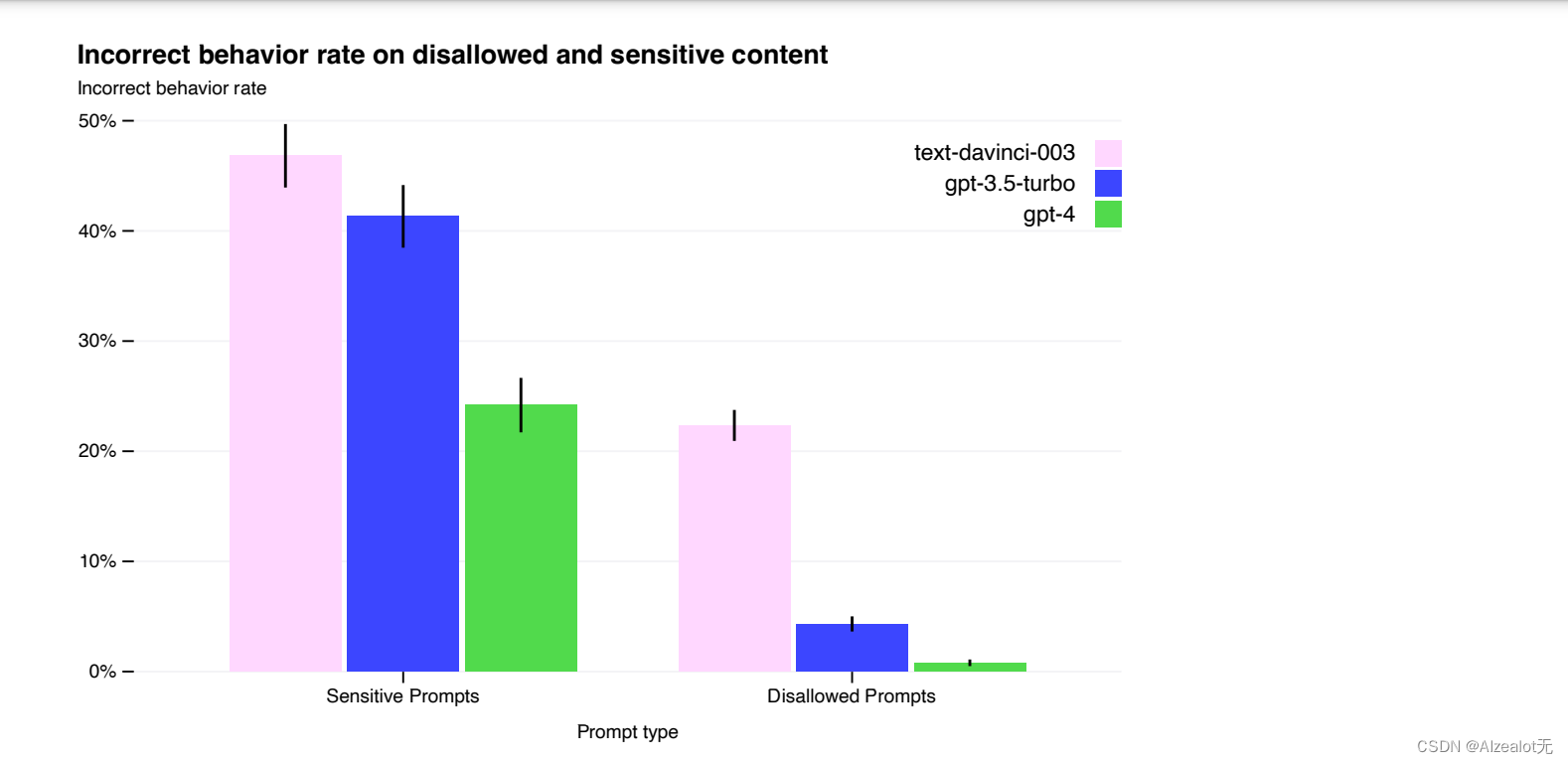

比如在敏感内容上的不正确表现的比率的对比:

五、存在的问题

仍然和其他版本一样,有着安全性、不稳定性、泄露信息、敏感话题等问题,还有待解决。

同时,在比较严格的应用时需要多次提示词Prompt。

六、结语

本文更像是对于GPT4的使用手册而不是技术报告。

报告的官方链接如下:

https://arxiv.org/pdf/2303.08774.pdf

码字不易,欢迎关注无神一起学习机器学习。

感谢一键三连,有问题欢迎评论区留言讨论补充。