- 1【Android Camera简单整理(一)-Camera Android架构(高通)】

- 21.机器学习-机器学习算法分类概述_机器学习 算法怎么分类

- 3uniapp上架苹果APP Store傻瓜式教程_uniapp上架appstore

- 4IDEA提示failed to load JVM DLL的解决办法_idea fail to load jvm dll

- 5思科模拟器安装教程

- 6Xcode设置cocoapods库的最低兼容版本_cocoapods 和 ios工程最低版本不一样

- 7php操作MySQL数据库(一)

- 8ListNode的Python实现_listcode python

- 9如何快速清理已经上传到Git仓库的.DS_Store文件

- 10阿里云CDN- https(设计支付宝春节开奖业务)

centos上部署Ollama平台,实现语言大模型本地部署_centos 安装ollama模型

赞

踩

网上有很多大模型,很多都是远程在线调用ChatGPT的api来实现的,自己本地是没有大模型的,这里和大家分享一个大模型平台,可以实现本地快速部署大模型。

Ollama是一个开源项目,它提供了一个平台和工具集,用于部署和运行各种大型语言模型(LLM,Large Language Model)。Ollama简化了在本地机器上运行这些模型的过程,使得用户不需要深入的机器学习知识就可以利用先进的语言模型进行自然语言处理任务,如对话生成、文本补全等。Ollama的官方网站是 https://ollama.com/ ,用户可以通过简单的命令行指令在本地运行模型,例如Llama 2等大模型。这为开发者和研究人员提供了一个便捷的途径来实验和应用最先进的语言模型技术,而无需依赖云端服务,从而降低了延迟并增强了隐私保护。Ollama的核心功能包括模型管理和运行环境的封装,使得用户可以轻松地拉取模型、运行模型并与其交互。此外,Ollama还支持多种模型格式和架构,使其成为一个灵活的平台,适用于广泛的自然语言处理应用。

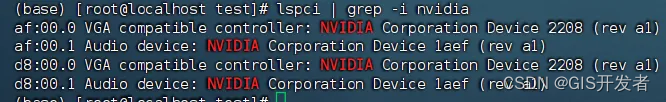

判断是否有Nvidia显卡

lspci | grep -i nvidia

- 1

部署Docker

建议docker部署,直接部署很容易超时。Docker在centos上的安装网上教程很多,不再叙述。但是Docker也建议使用配置一下加速源

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

- 1

- 2

然后输入下面内容

{

"registry-mirrors": [

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn"

]

}

EOF

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

然后重启docker服务

sudo systemctl daemon-reload

sudo systemctl restart docker

- 1

- 2

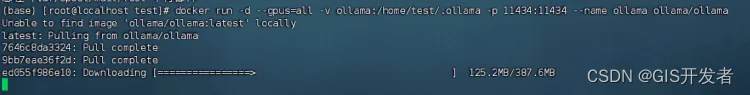

拉取Ollama镜像

docker run -d --gpus=all -v ollama:/home/Ollama/.ollama -p 11434:11434 --name ollama ollama/ollama

- 1

首次需要从仓卡拉取,有点慢

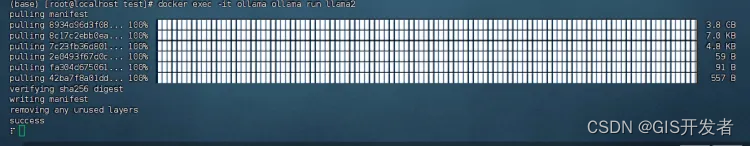

启动大模型

启动本地大模型,这里以llama2为例,第一次会下载模型:

docker exec -it ollama ollama run llama2

- 1

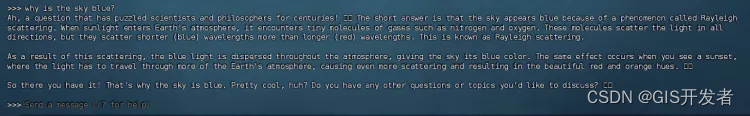

执行完毕后,会进入交互模式,输入内容,即可在线对话

Ollama 还支持很多市面上其他开源大模型(大模型列表 ollama.com/library),下面是一些列子:

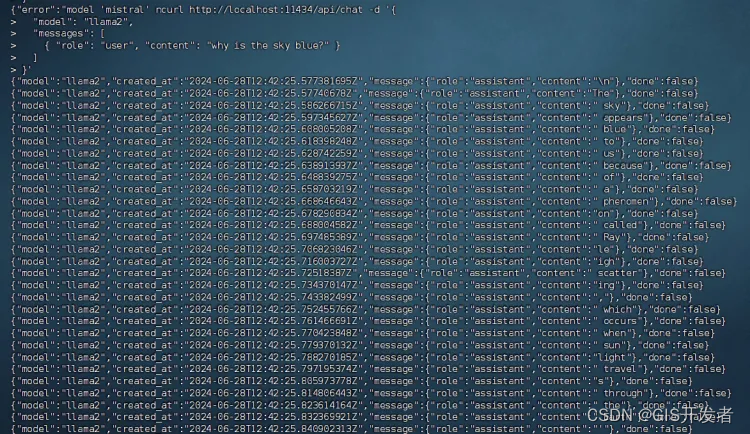

以API的方式调用模型

curl http://localhost:11434/api/chat -d '{

"model": "llama2",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'

- 1

- 2

- 3

- 4

- 5

- 6

API文档可以参考

https://github.com/ollama/ollama/blob/main/docs/api.md