- 1【Quart 框架——来源于Flask的强大且灵活的异步Web框架】

- 2IDEA支付宝小程序开发流程——授权登录_支付宝小程序 minidev identitykeypath

- 3【计算机网络】域名劫持无处遁形:基于HTTPDNS打造可靠且安全的域名解析体系_域名解析接口

- 4什么是同步整流和异步整流_同步整流和异步整流的区别

- 525K Stars! Open WebUI + Ollama + Llama3搭建本地私人ChatGPT

- 6Postman 接口测试神器_在线postman

- 7RENISHAW雷尼绍双读数头系统应用分享

- 8亚马逊云科技 EC2服务搭配SD Webui开箱即用的AIGC文生图/图生图平台_aws sd-webui 配额

- 9elasticsearch配置文件详解_cluster.name

- 10MyBatis查询数据库之四(动态SQL -- if、trim、where、set、foreach 标签)_insert into和if标签

AWS上(Ubuntu 22.04)系统配置自己的AI大模型_在ubuntu上使用ollama部署llama3大模型

赞

踩

介绍

本文将介绍在AWS上使用Ubuntu系统,使用开源工具Ollama部署LLaMa大模型,安装Docker以及使用Open WebUI搭建前端Web交互界面的方法。

初次记录有不对的地方,欢迎大神们随时纠正我。

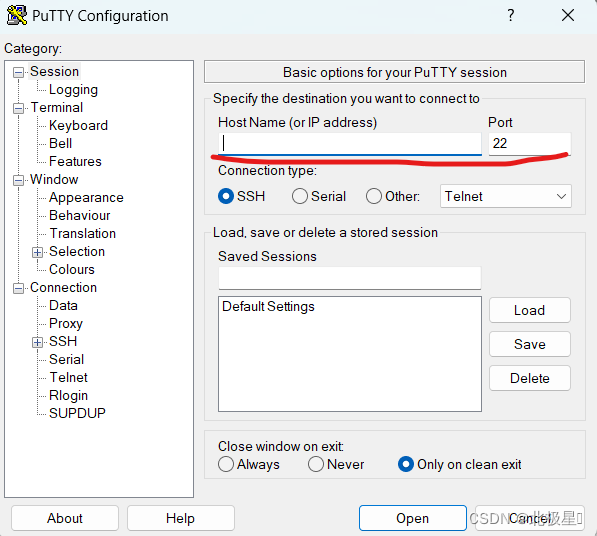

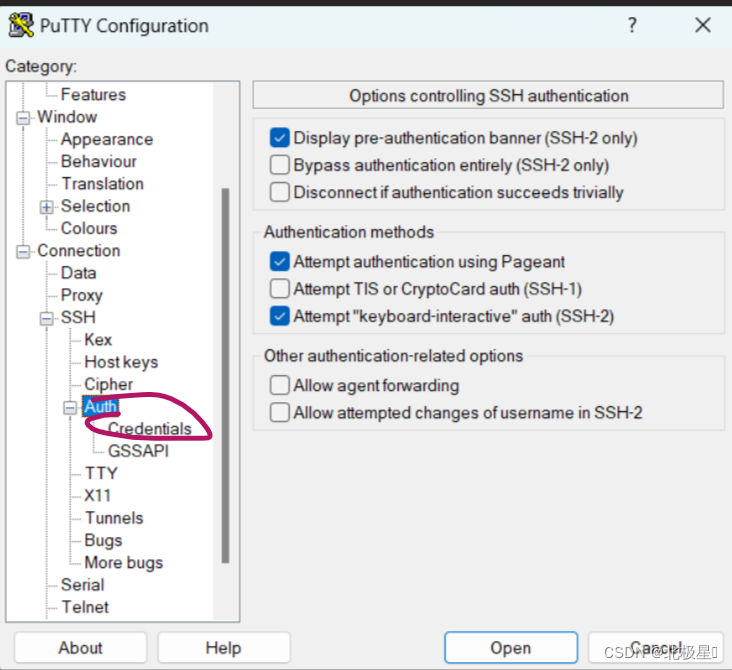

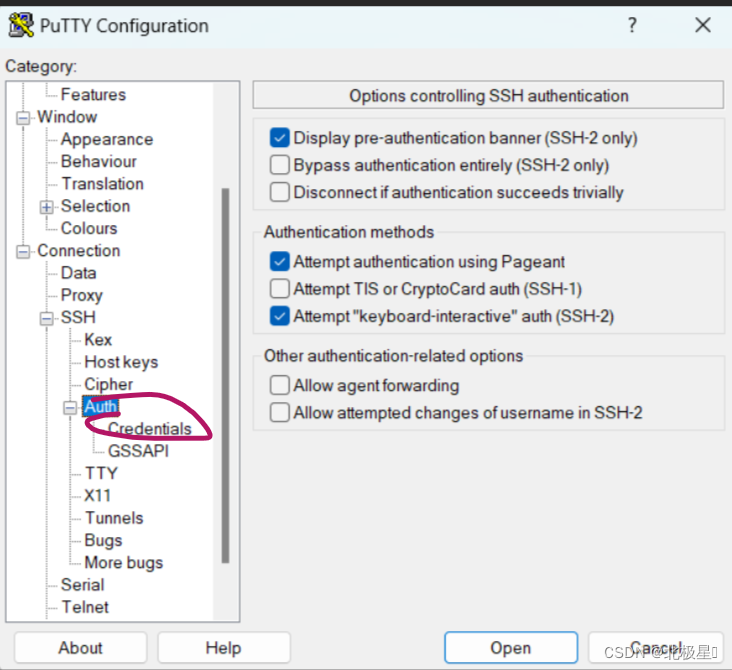

连接AWS的工具

我这边用的是PUTTY,我个人觉得不好用,但是奈何我也没有其他好的办法,时间紧任务重~~~

大概的截图我放这里:

进入Root用户

sudo su -

- 1

连接上之后输入此代码就进入到root用户了

安装Ollama

curl -fsSL https://ollama.com/install.sh | sh

- 1

下载llama3模型

ollama run llama3

- 1

llama3是其中的一个模型,其他的模型在这里可以找到library

上述命令将自动拉取模型,并进行sha256验签。处理完毕后自动进入llama3的运行环境,可以使用中文或英文进行提问,ctrl+D退出。

配置Ollama的服务

为使外网环境能够访问到服务,需要对HOST进行配置。

1、打开配置文件:

vim /etc/systemd/system/ollama.service

- 1

根据情况修改变量Environment:

服务器环境下:Environment=“OLLAMA_HOST=0.0.0.0:11434”

虚拟机环境下:Environment=“OLLAMA_HOST=服务器内网IP地址:11434”

Ollama.service配置文件: [Unit] Description=Ollama Service After=network-online.target [Service] Environment="OLLAMA_HOST=0.0.0.0:11434" ExecStart=/usr/local/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 Environment="PATH=/root/.cargo/bin:/usr/local/cmake/bin:/usr/local/bin:.:/root/.bin/go1.21.4/bin:/root/go/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/root/bin" "OLLAMA_HOST=0.0.0.0" [Install] WantedBy=default.target

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

2、启动服务的命令:

systemctl daemon-reload

systemctl restart ollama

关闭服务

systemctl stop ollama

启动服务

systemctl start ollama

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

首次启动可能会出现以下两个提示:

Couldn’t find ‘/home/用户名/.ollama/id_ed25519’. Generating new private

key.

该提示表示文件系统中不存在ssh私钥文件,此时命令将自动帮我们生成该文件,并在命令行中打印相应的公钥。

Error: listen tcp 127.0.0.1:11434: bind: address already in use

看到该提示,大概率服务已在运行中,可以通过 netstat -tulpn | grep 11434命令进行确认。

3、在外网环境验证连接:

命令行:输入执行curl http://ip:11434命令,若返回“Ollama is running”,则表示连接正常。

浏览器:访问http://ip:11434,若页面显示文本“Ollama is running”,则表示连接正常。

安装Docker

sudo curl -sSL https://get.docker.com/ | sh

安装完成之后

sudo docker --version

- 1

- 2

- 3

安装Open webui

南京大学的镜像:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

- 1

- 2

- 3

- 4

-运行Open webui

sudo docker start open-webui

- 1

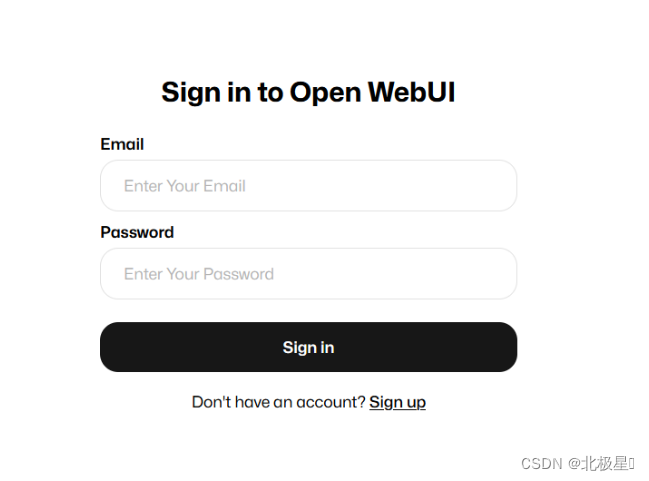

-登录Open-webui

浏览器:访问 http://loacalhost:3000(客户端部署)或 http://服务器ip:3000。

页面加载完成后,新注册一个账号(随便注册一个邮箱),第一个注销的人就是管理员。

连接Ollama

管理界面导航栏-连接,在“Ollama 基础 URL”这一项输入 http://loacalhost:11434(客户端部署)或 http://服务器ip:11434。

基本配置完毕,可以开始愉快的提问了。