- 1Mac M1使用Vscode进行STM32项目开发_mac系统烧录stm32

- 2VSCode配置c_cpp_properties.json文件_vscodeccpppropertiesjson

- 3算法竞赛入门经典(第二版)习题答案——第三章3.1-3.6_算法竞赛入门经典第二版答案 第三章

- 4AI绘画SD常用的优秀模型_sd最常用的官方大模型

- 5mysql binlog 闪回_MySQL误操作之快速闪回binlog2sql

- 6数据结构——单向链表和双向链表的实现(C语言版)_使用c语言分别实现单向链表和双向链表

- 7书籍推荐:ChatGPT,大模型的预训练、迁移和中间件编程学习。_大模型架构的书籍

- 8Temporal Relational Reasoning in Videos(视频中的时序推理)

- 9自然语言处理的文本摘要:算法与优化

- 10git lfs下载卡住,没有进度条怎么处理_downloading lfs objects速度慢

大模型书籍分享(附PDF)大模型时代:ChatGPT开启通用人工智能浪潮_大模型应用解决方案 书籍 pdf

赞

踩

近期工作中有一些涉及到大模型等的应用,刚好在微信读书上看到了这本 《大模型时代:ChatGPT开启通用人工智能浪潮》, 本月看完了这本书与大家分享下。

ChatGPT火爆全球,但大语言模型(Large Language Model)才是幕后真正的智能“大脑”!生成式大模型正在开创新的时代,基于生成式预训练大模型的技术突破,也在带来面向个人、深入行业的多重应用。这势必引发新一轮的智力革命和产业重构,但在同时与机会如影随形的泡沫也会随之涌现。

《大模型时代:ChatGPT开启通用人工智能浪潮》这本书书对大模型时代的技术、应用和产业变化进行了深入的分析和阐述。本书首先将专业的技术知识通过拟人化的形式进行呈现,生动形象地解释了ChatGPT大模型背后的原理,对这一赋能大模型变革技术与产业的基础能力进行深度剖析;其次,本书以三次工业革命的历史和逻辑作为参照,描绘出大模型将如何驱动社会进入智能革命和脑机协作时代,并为个人和企业应对此次变革提出建议;第三,本书对大模型在知识工作、商业企业、创意娱乐等领域的具体应用进行介绍,总结了企业在自身业务中应用大模型的注意事项和方法论;最后本书对国内外大模型产业的构成和发展进行了分析,并对暗藏泡沫隐患的风险点位做出预警。本书将通过四个部分:技术篇、变革篇、应用篇和产业篇,讲述ChatGPT大模型的前世今生和台前幕后。

这本大模型优质书籍已经上传CSDN,还有完整版的大模型 AI 学习资料,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

0 序

2020-2022年,在新冠疫情肆虐全球的阴霾日子里,人工智能创新的步伐完全没有停止。美国人工智能研究公司OpenAI异军突起:2020年4月发布神经网络Jukebox;2020年5月发布GPT-3,模型参数量为1750亿;2020年6月开放人工智能应用程序接口;2021年1月发布连接文本和图像神经网络CLIP;2021年1月发布从文本创建图像神经网络DALL-E;2022年11月,正式推出对话交互式的ChatGPT。ChatGPT证明了通过一个具有高水平结构复杂性和大量参数的大模型(foundation model,又称为“基础模型”)可以实现深度学习。大模型是大语言模型(LLM),也是多模态模型,或者是生成式预训练转换模型。GPT是大模型的一种形态,引发了人工智能生成内容(AIGC)技术的质变。由生成式预训练大模型引发的技术突破,正在形成面向个人、深入行业的多重应用,势必引发新一轮的智力革命和产业重构,形成全新的脑机协作关系。

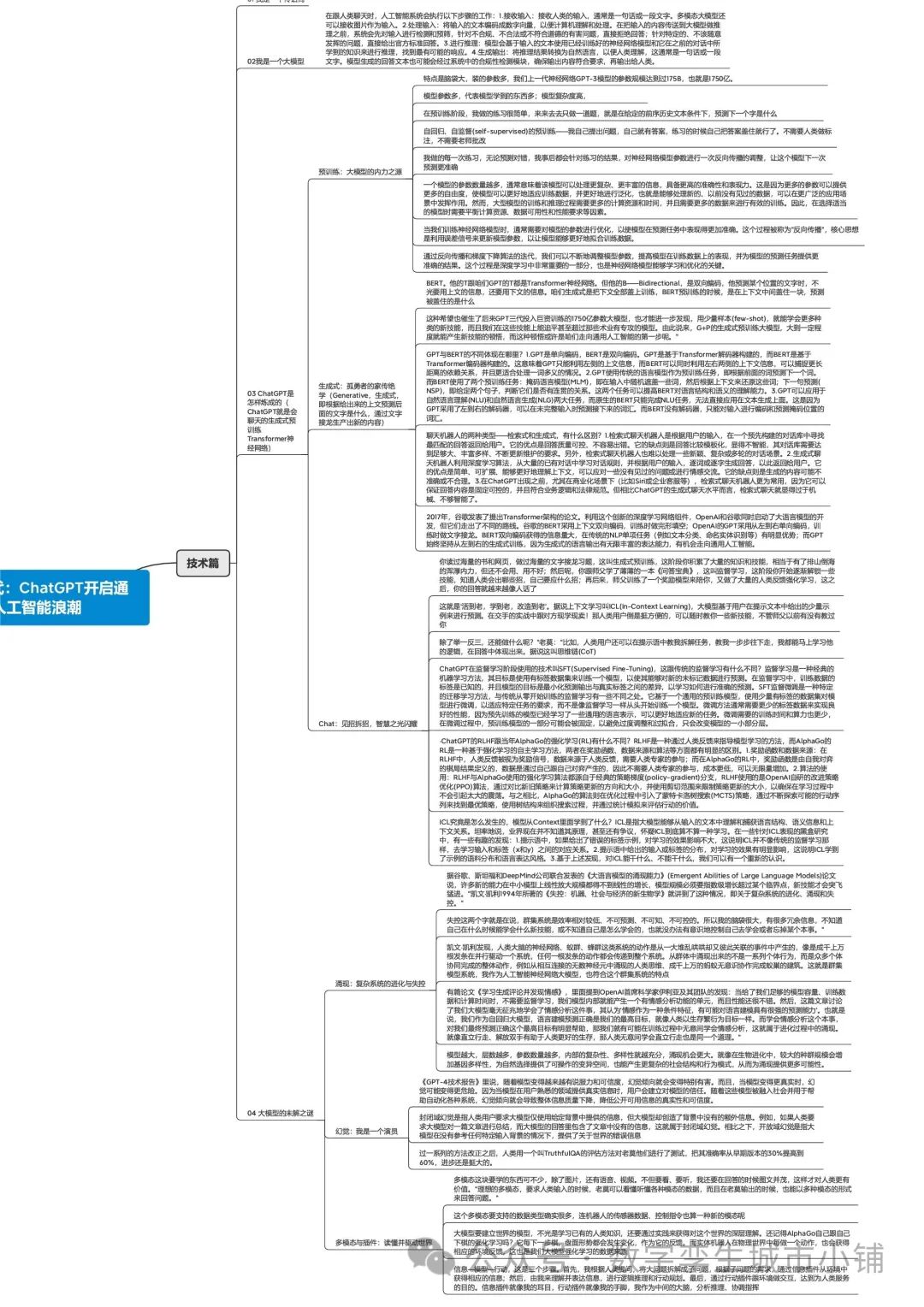

1 技术篇

本章阐述什么是ChatGPT,ChatGPT大模型是如何运转的,跟以往的人工智能有什么区别。

(1)人工智能模型的工作分为训练(training)和推理(inference)两个阶段,在跟人类聊天时模型处于推理阶段,此时其不再调整自己的参数,而是根据已经学习到的知识来进行预测和响应,以帮助人类完成各种各样的任务。

(2)ChatGPT会将人类输入的文本作为上文,预测下一个标识(token)或下一个单词序列。 具体来说,ChatGPT会将上文编码成一个数字向量,并将该向量输入到模型的解码器中。解码器会根据该向量生成一个初始的“开始”符号,并一步步生成下一个token或下一个单词序列,直到遇到一个“结束”符号或达到最大长度限制为止。ChatGPT使用了基于自回归(auto-regressive)的生成模型,也就是说在生成每个token时,它都会考虑前面已经生成的token。 这种方法可以保证生成文本的连贯性和语义一致性。同时,ChatGPT也使用了束搜索(beam search)等技术来计算多个概率较高的token候选集,生成多个候选响应,并选择其中概率最高的响应作为最终的输出。

(3)在生成token时,模型通常会将解码器输出的每个token的概率归一化,并根据概率选择一个token作为生成的下一个单词或标点符号。如果只选择概率最高的token,生成的响应会比较保守和重复。因此,ChatGPT通常会使用温度(temperature)参数来引入一定程度的随机性,以使生成的响应更加丰富多样。

(4)当我们训练神经网络模型时,通常需要对模型的参数进行优化,以使模型在预测任务中表现得更加准确。这个过程被称为“反向传播”。在反向传播过程中,我们首先将一个输入样本输入到神经网络模型中,然后计算出模型的预测输出。接着,我们将通过一个损失函数对预测输出与实际输出之间的误差进行量化,由此得到一个误差值。这个误差值会通过一个反向传播算法,逐层向后传播到模型的每一个参数,以便计算每个参数对误差的贡献度。我们可以使用链式法则将误差信号沿着神经网络的层次结构传递回去,以便计算每个参数的梯度。在得到每个参数的梯度之后,我们可以利用梯度下降算法来更新模型的参数。梯度下降算法会根据参数梯度的方向和大小,对模型参数进行微调,从而减小误差信号并提高模型的预测准确性。

(5)2017年,谷歌发表了提出Transformer架构的论文。利用这个创新的深度学习网络组件,OpenAI和谷歌同时启动了大语言模型的开发,但它们走出了不同的路线。谷歌的BERT采用上下文双向编码,训练时做完形填空;OpenAI的GPT采用从左到右单向编码,训练时做文字接龙。BERT双向编码获得的信息量大,在传统的NLP单项任务(例如文本分类、命名实体识别等)有明显优势;而GPT始终坚持从左到右的生成式训练,因为生成式的语言输出有无限丰富的表达能力,有机会走向通用人工智能。

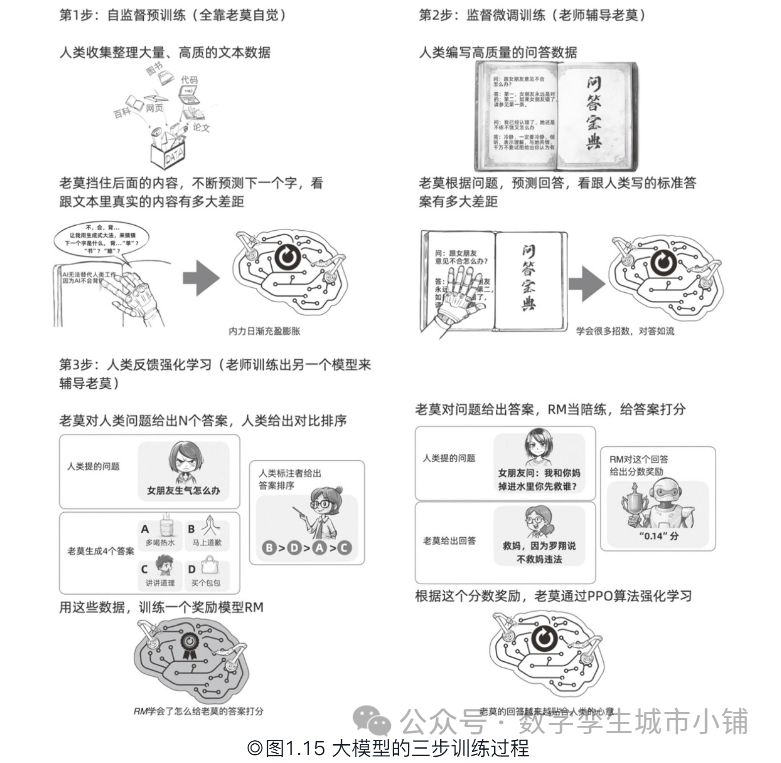

(6)总结一下。你读过海量的书和网页,做过海量的文字接龙习题,这叫生成式预训练,这阶段你积累了大量的知识和技能,相当于有了排山倒海的浑厚内力,但还不会用、用不好;然后呢,你跟师父学了薄薄的一本《问答宝典》,这叫监督学习,这阶段你开始逐渐解锁一些技能,知道人类会出哪些招,自己要应什么招;再后来,师父训练了一个奖励模型来陪你,又做了大量的人类反馈强化学习,这之后,你的回答就越来越像人话了。

(7)ChatGPT在监督学习阶段使用的技术叫SFT(Supervised Fine-Tuning),SFT监督微调是一种特定的迁移学习方法,与传统从零开始训练的监督学习有一些不同之处。它基于一个通用的预训练模型,使用少量有标签的数据集对模型进行微调,以适应特定任务的要求,微调需要的训练时间和算力也更少。

(8)神经网络在训练过程中会尝试调整各种参数组合(可以类比为生物进化中的基因突变),要最小化模型预测和最优答案之间的差值,也就是老莫说的‘预测准确’是最高目标。经过无数次训练,那些导致预测错误的参数组合会被纠正,从而逐步优化网络性能。这个过程中,神经网络可能会逐渐学会一些高层次的特征和功能(比如说情感分析),从而使得老莫在最高目标上面表现得更好(懂得情感,更擅长与人类对话)。这样一来,相对复杂的高级功能就从相对简单的组件或规则中涌现出来了,类似于生物进化过程中的自然选择。

(9)多模态大模型的英文全称是Multimodal Large Language Model,英文简称是MLLM,理想的多模态,要求人类输入的时候可以看懂听懂各种模态的数据,而且在输出的时候也能以多种模态的形式来回答问题。

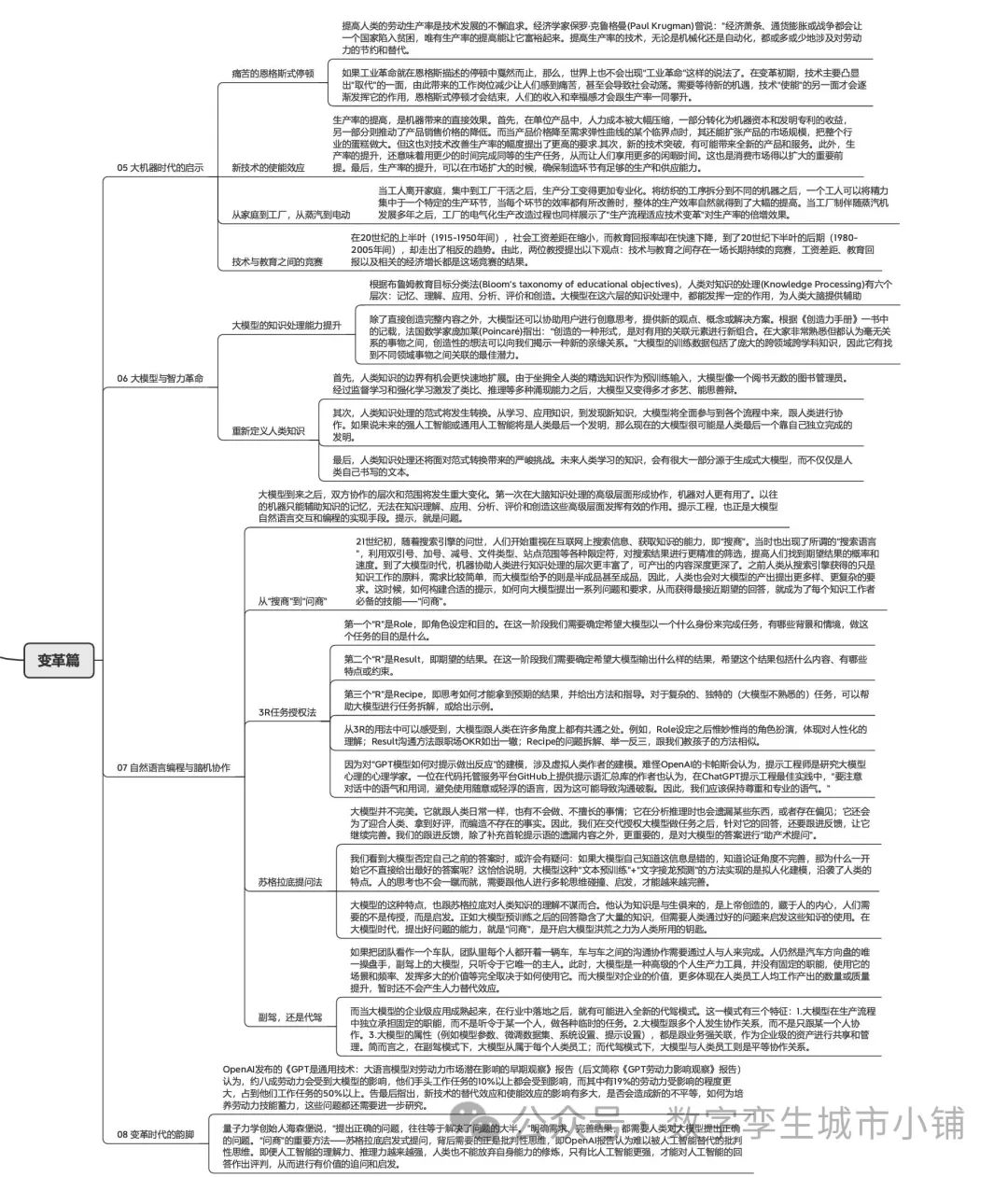

2 变革篇

本章阐述了GPT带给社会方法方面的变化及应用方式和未来展望。

(10)在变革初期,技术主要凸显出“取代”的一面,由此带来的工作岗位减少让人们感到痛苦,甚至会导致社会动荡。需要等待新的机遇,技术“使能”的另一面才会逐渐发挥它的作用,恩格斯式停顿才会结束,人们的收入和幸福感才会跟生产率一同攀升。

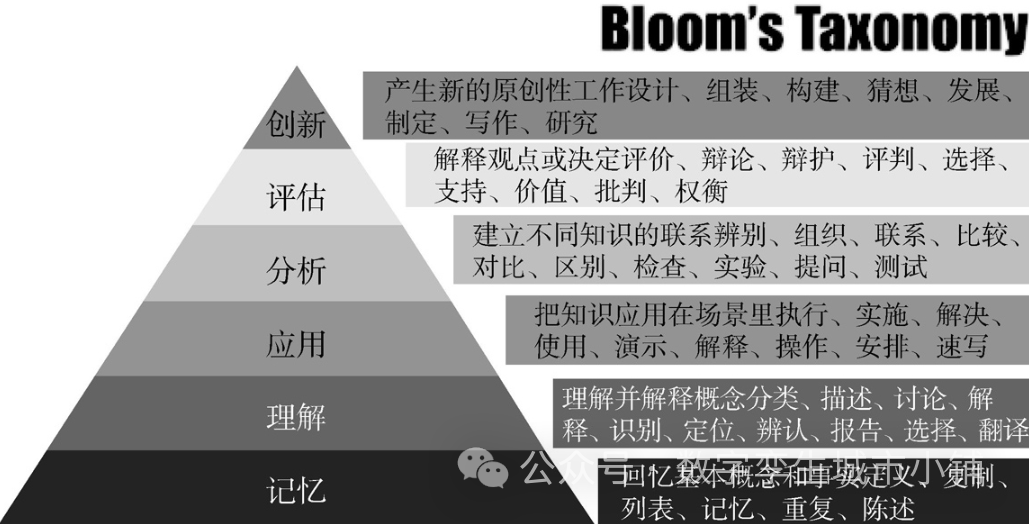

(11)根据布鲁姆教育目标分类法(Bloom’s taxonomy of educational objectives),人类对知识的处理(Knowledge Processing)有六个层次:记忆、理解、应用、分析、评价和创造。大模型在这六层的知识处理中,都能发挥一定的作用,为人类大脑提供辅助。

(12)大模型使用一问一答的自然语言交互和编程模式,沿袭了从模型搭建和训练阶段就秉承的“简单即是力量”的理念,但又在形式极简的文本输入当中,利用自然语言表达的丰富性,蕴藏了无数的变化。

(13)从3R的用法中可以感受到,大模型跟人类在许多角度上都有共通之处。例如,Role设定之后惟妙惟肖的角色扮演,体现对人性化的理解;Result沟通方法跟职场OKR如出一辙;Recipe的问题拆解、举一反三,跟我们教孩子的方法相似。,最简单的自然语言编程心法,就是“视大模型为人”。

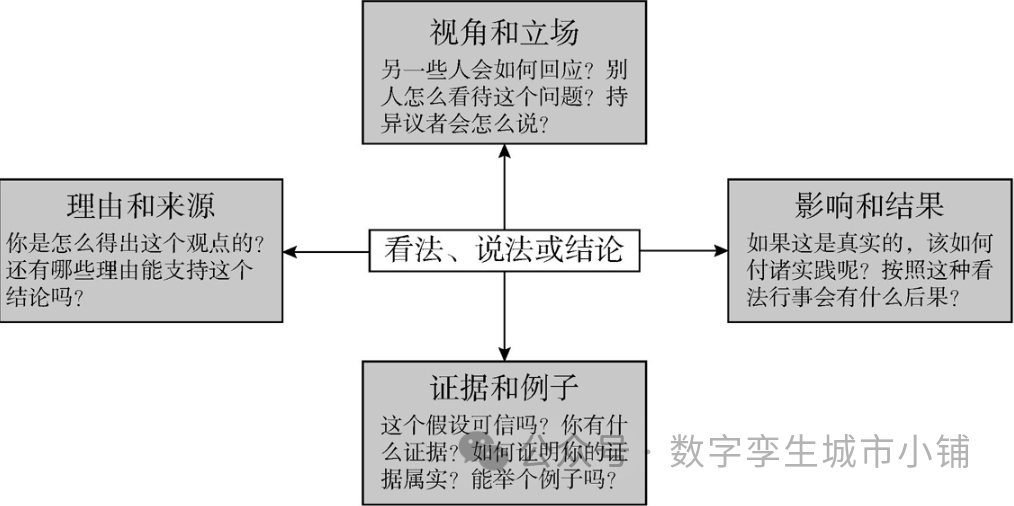

(14)苏格拉底式的问题,可以分为4大类:证据类、视角类、理由类、影响类。在与大模型的跟进过程中,视其回答的情况,可灵活采用这4类提问。在我们跟进大模型回答的过程中,可以反复使用这4类提问法以获得更完善的答案。即“四省吾身”:真否?全否?有理否?可行有效否?

(15)《GPT劳动力影响观察》报告也指出,GPT大模型满足通用技术的三个核心标准:随着时间推移,技术不断改进,贯穿整个经济体系,能够催生互补性的创新。

3 应用篇

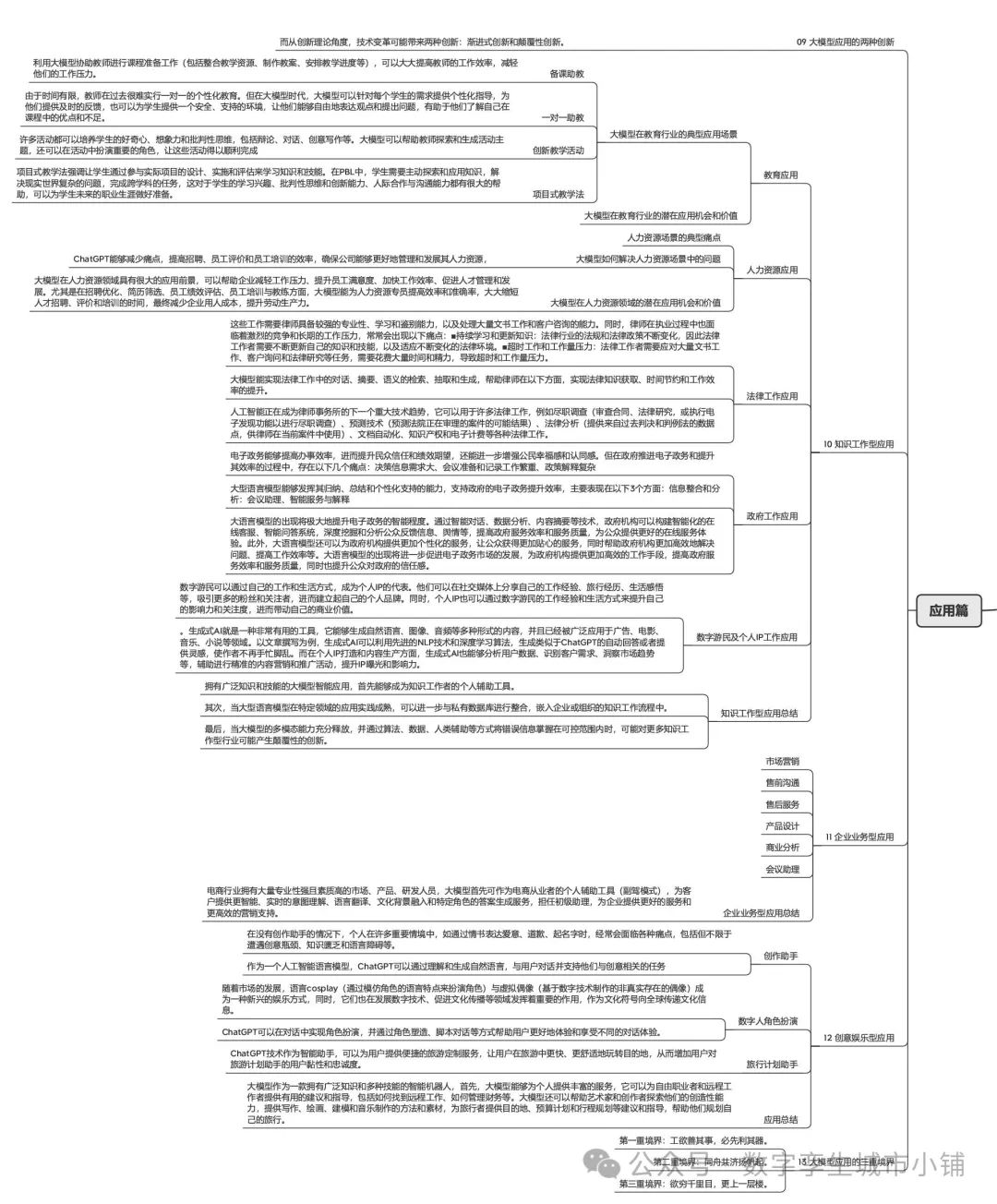

本章阐述了GPT在知识密集型、企业业务型、创意娱乐型方面的应用并论述了应用的三大方向。

(16)知识、技术和创新在产业活动中起着核心作用的产业通常可称为知识密集型产业。这类产业对专业化的人才和经验有很高的依赖,因此知识工作的含量很高。

(17)当大模型的多模态能力得到充分释放后,人类与大模型的协作达成默契,大模型在某个领域的成熟度被打磨到极致,只有结合企业家的全新业务模式设计产生颠覆式创新,才有机会做出市场增量,把社会经济的蛋糕做大,催生新的人类就业机会。

4 产业篇

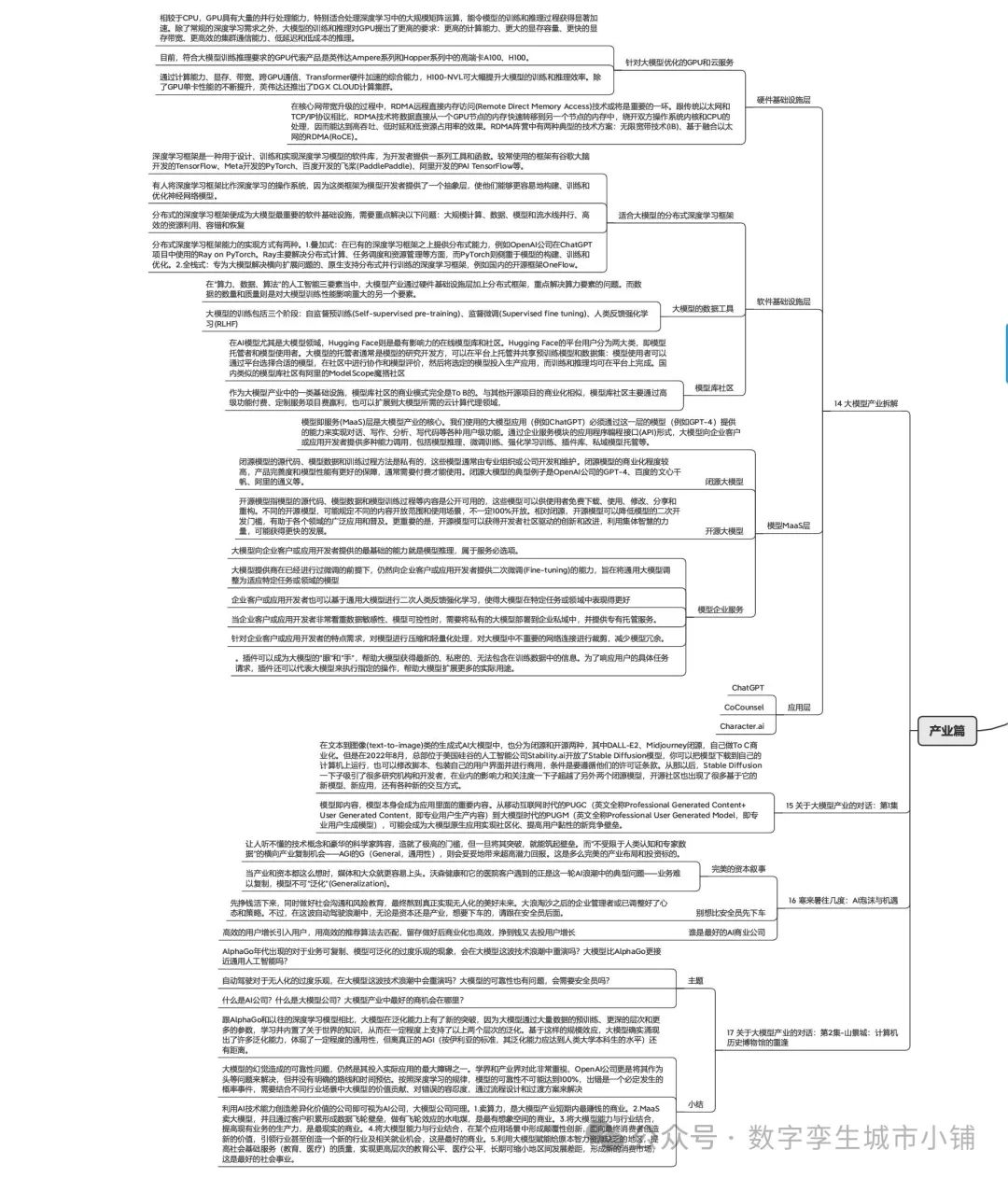

本章首先对大模型相关产业进行拆分,说明了大模型产业的构成、商业模式、发展现状等,并简述了大模型产业存在的泡沫风险,以对话的形式说明了大模型产业的利弊和未来。

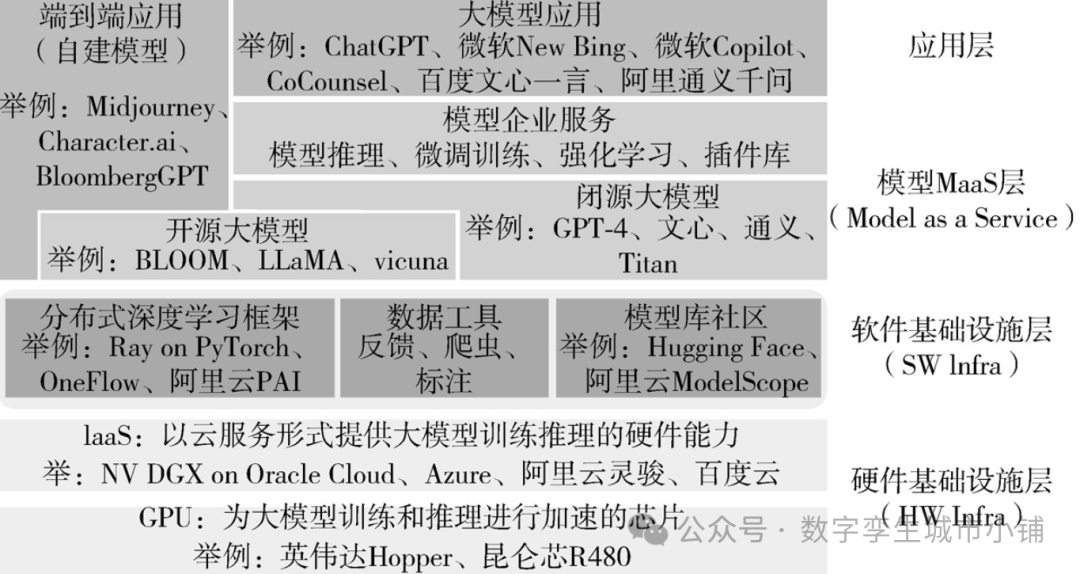

(18)将大模型产业划分为4层:硬件基础设施层、软件基础设施层、模型MaaS层和应用层。

(19)在核心网带宽升级的过程中,RDMA远程直接内存访问(Remote Direct Memory Access)技术或将是重要的一环。跟传统以太网和TCP/IP协议相比,RDMA技术将数据直接从一个GPU节点的内存快速转移到另一个节点的内存中,绕开双方操作系统内核和CPU的处理,因而能达到高吞吐、低时延和低资源占用率的效果。RDMA阵营中有两种典型的技术方案:无限宽带技术(IB)、基于融合以太网的RDMA(RoCE)。

(20)深度学习框架是一种用于设计、训练和实现深度学习模型的软件库,为开发者提供一系列工具和函数。较常使用的框架有谷歌大脑开发的TensorFlow、Meta开发的PyTorch、百度开发的飞桨(PaddlePaddle)、阿里开发的PAI TensorFlow等。分布式深度学习框架能力的实现方式有两种:1.叠加式,在已有的深度学习框架之上提供分布式能力;2.全栈式,专为大模型解决横向扩展问题的、原生支持分布式并行训练的深度学习框架。

(21)模型即服务(MaaS)层是大模型产业的核心。我们使用的大模型应用必须通过这一层的模型提供的能力来实现对话、写作、分析、写代码等各种用户级功能。聚焦生成式预训练大模型领域主要需要关注大模型在以下几个方面的表现:生成文本的质量、零次迁移的学习能力、生成样本的多样性、输入的容错性和鲁棒性、计算资源需求、可解释性和可审计性。

(22)将大模型封装成服务,向企业客户或应用开发者提供API能力调用,包括模型推理、微调训练、强化学习训练、插件库、私域模型托管等。

(23)模型和数据是大模型应用的重要竞争壁垒。模型开源生态很重要,大语言模型正处于Stable Diffusion时刻。社区化和用户黏性手段,从移动互联网的PUGC过渡到大模型的PUGM。

(24)做AI项目,客户第一次会提供一小撮数据样本让你理解业务数据;等你入场做POC测试时,会拿到批量的真实历史数据;等项目上生产环境后,你会碰到更实时的数据;等运行一段时间后又必然会遇到各种新的情况,例如调整客户业务的人群定位、外部行业政策有变导致业务环境也发生变化,等等。在这四个不同阶段,你所认知的客户数据特点和分布都会发生变化,而这个变化就意味着超参数要重新调整、网络结构可能要重新设计甚至对算法进行重新取舍。造成这么折腾的主要原因是**深度学习的理论不完备,算法模型的运行机制也不可知。因此,在AI行业项目中,不同客户环境下针对模型的调试优化能不能成功,靠的是经验加运气,**调对了不知道为啥对,错了也搞不清为啥错,这样的经验自然也就不容易被传承和复制,只能依赖做过多个项目、遇到过多种情况、调试成功和失败的经验都积累了很多的AI“老中医”。

(25)大模型的泛化能力是有边界的。当前大模型从文本中学到的能力主要集中在自然语言相关的认知智能领域,而在以图像识别为代表的感知智能和以用户行为预测为代表的决策智能领域,大模型则未必适合。即便在认知智能领域,其也存在规划能力不足等一系列缺陷。

(26)就像凯文·凯利在《失控》一书中讲述的群集系统智能那样,失控(不可知、不可预测、不可控)既是智能获得突破的重要原因,又是智能突破所不可避免的伴生结果。然而,这种失控并非社会所习惯的模式。如果没有合理地控制预期,大众往往在短期过度乐观,一旦受挫,便会低估长期发展趋势,造成产业的大起大落。

5 小结

本书从大模型的技术原理、行业变革、应用影响、产业发展等方面说明了大模型和GPT的相关场景概念,较为全面的结婚扫了大模型技术和应用场景的前瞻之作。这本书还是很推荐的,最开始用情景剧的方式介绍了大模型的原理当真让人叹为观止,但随后的变革篇就有点凑次数的嫌疑了,应用篇也可以看出作者很用心在润色,里面的很多思考也发人深省。

对笔者而言,最大的收获就是大模型应用场景和产业研究,如何结合我们目前的工作去做一些有价值的工作。但目前跨行业、跨场景、跨应用的模型复制还存在不足,在大模型泛化能力提升的基础上形成AGI底层支持,持续从经验中去学习、增大模型的规模和类型、降低幻觉出现的概率,进而实现AIGC类大模型应用的可能,从个人工作效率-业务模式优化-产业价值改变提升,在这个过程中人类的作用就是裁判。目前对于普通的企业还是需要发力MaSS服务,基于云计算形成自我的服务价值,算力、算法可能没法提升,但数据的差异化是可以在垂直领域形成自己的“涌现”力,从而形成自适应的业务数据为客户提供个性化的服务。

这本大模型优质书籍已经上传CSDN,还有完整版的大模型 AI 学习资料,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】