热门标签

热门文章

- 1北京大学创新推出ManipLLM黑科技 | 大幅提升机器人操作的鲁棒性与智能性

- 2conv-tasnet网络结构+mobilenet网络结构+VQ-VAE-2模型_convtasnet

- 3python进行中文文本聚类实例(TFIDF计算、词袋构建)_中文文本聚类分析实例

- 4设置vscodium采用微软官方扩展源_vscodium 官方源

- 5攻略 | 如何拿下奖金534万的全国人工智能大赛?_ai+视觉特征编码

- 6Stable Diffusion:详细版安装教程!_stable diffusion 云盘安装需要多大

- 7最新类ChatPDF及AutoGPT开源18大功能平台——闻达手把手超详细环境部署与安装——如何在低显存单显卡上面安装私有ChatGPT GPT-4大语言模型LLM调用平台_闻达框架

- 8Python深度学习026:基于Pytorch的典型循环神经网络模型RNN、LSTM、GRU的公式及简洁案例实现(官方)_python gru库

- 9朱晔的互联网架构实践心得S1E3:相辅相成的存储五件套

- 10Python:高级聊天机器人_chatterbot要哪个版本的python

当前位置: article > 正文

生成式大语言模型论文导读

作者:笔触狂放9 | 2024-04-01 07:24:09

赞

踩

生成式大语言模型论文导读

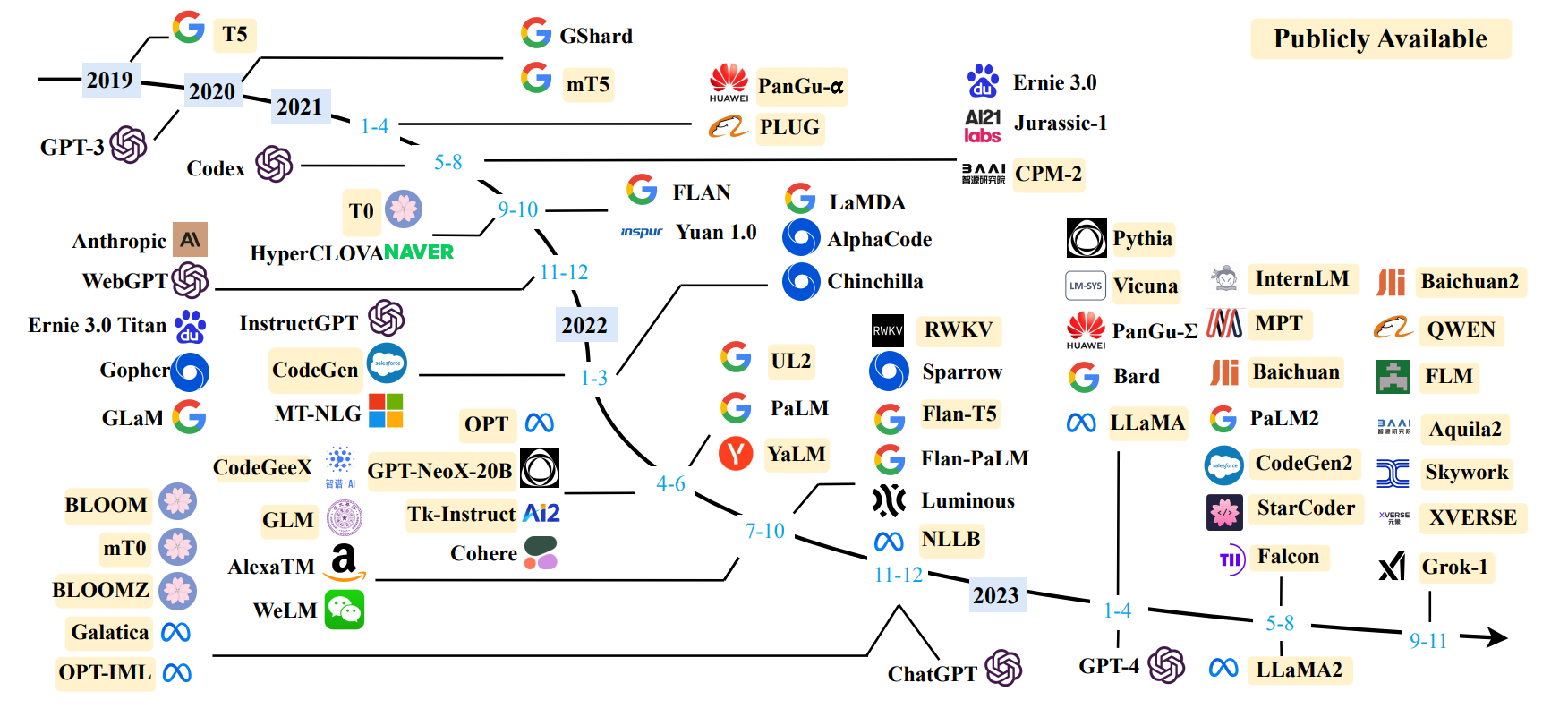

当下,最火的人工智能无疑就是生成式大模型,包括纯大语言模型和多模态模型,所以本次也抱着学习的态度,以大模型发展的时间线来对主要节点的一些生成式语言模型的论文进行分享(论文和分享内容会动态更新)。

分享目录

transformer原理-Attention Is All You Need -2017(待补充)

GPT-1原理-Improving Language Understanding by Generative Pre-Training -2018

BERT原理-Pre-training of Deep Bidirectional Transformers for Language Understanding -2018

GPT-2原理-Language Models are Unsupervised Multitask Learners -2019

T5原理-Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer -2019(待补充)

GPT-3原理-Language Models are Few-Shot Learners -2019(待补充)

【动态更新中】

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/笔触狂放9/article/detail/347782

推荐阅读

相关标签