热门标签

热门文章

- 1【送书福利-第三十八期】《 SaaS产品实践方法论:从0到N构建SaaS产品》

- 26-闭包和装饰器_带参数的装饰器。定义一个没有参数的函数foo,用于输出语句;定义一个装饰器函

- 3迅为RK3568开发板Debian系统安装ToDesk_debian rk3568版本

- 4php 生成水印输出图片,PHP的生成图片或文字水印的类

- 5SpringBoot3.x整合Nacos和Redis

- 6365天挑战LeetCode1000题——Day 109 贝壳周赛

- 7kubernetes 二进制部署

- 8Mysql-基本练习(07-修改表-添加主键、唯一、外键约束、添加/删除默认约束、删除约束)_alter table tb1 drop foreign key tb1____ibfk ____1

- 9神经网络学习笔记——神经网络基础(一)

- 10SpringBoot如何正确连接SqlServer_spring sqlserver

当前位置: article > 正文

【深度学习 九】transformer_transformer的encoder输出什么

作者:笔触狂放9 | 2024-04-01 10:17:00

赞

踩

transformer的encoder输出什么

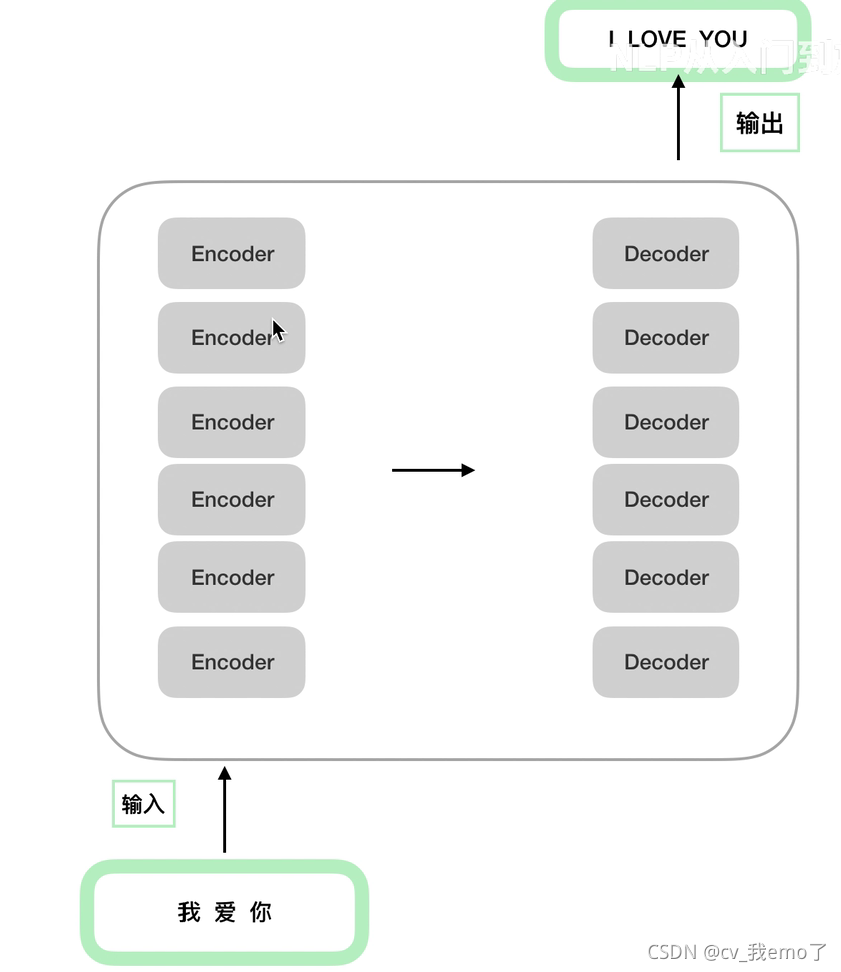

1 transformer的encoder-decoder结构:

结构内部:

2 encoder:

2.1 输入部分

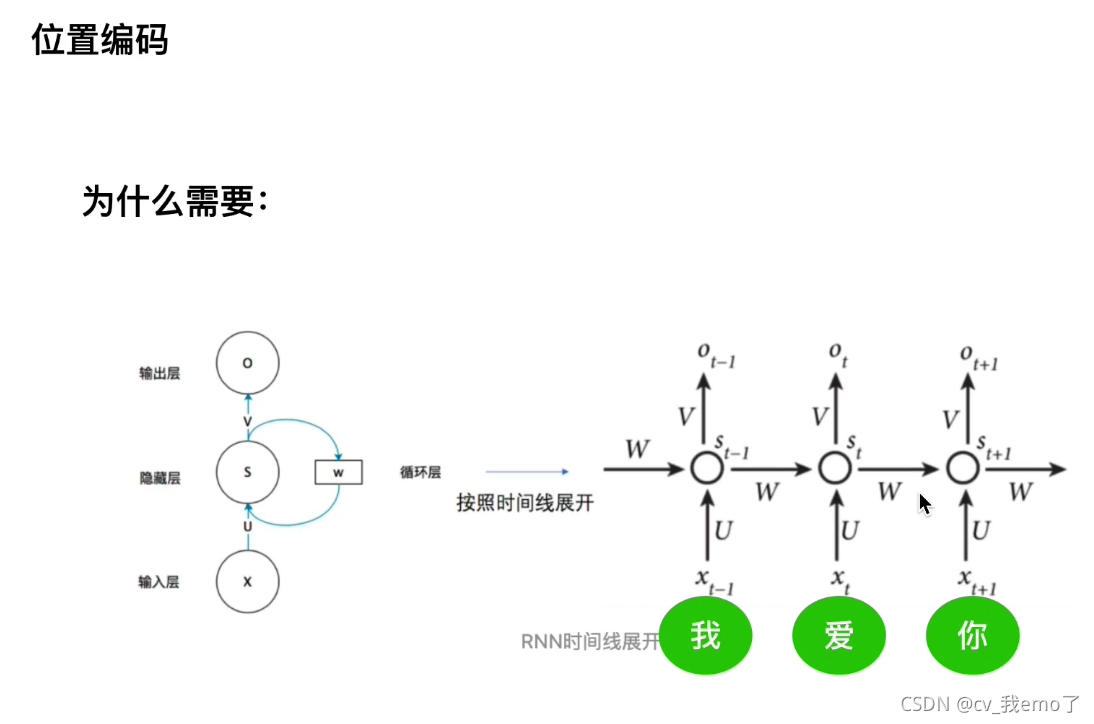

embedding和postitional encoding(位置编码)

为什么需要位置编码:如RNN每一time steps共享一套参数,串行输入输出,而transformer采用可以并行出入几个单词或者一串句子,优点是处理效率高,缺点是无法表示时序关系,所以要对输入的embedding加上postitional encoding。

最终输入的数据:

2.2 注意力机制

2.2.1 基本的注意力机制

推荐阅读

相关标签