热门标签

热门文章

- 1ubuntu18.04更换gcc版本_unbutu18.04修改gcc版本

- 2NLP中的嵌入层_嵌入层维度

- 3【AI视野·今日NLP 自然语言处理论文速览 第七十期】Thu, 4 Jan 2024_《gpt-4v(ision) is a generalist web agent, if groun

- 4自然语言处理[信息抽取]:MDERank关键词提取方法及其预训练模型----基于嵌入的无监督 KPE 方法 MDERank_关键词提取 mderank

- 5UML 的九种模型图.UML用例图.ER图.UML项目结构图总结_er图还有啥图

- 6jupyter notebook保存文件默认路径更改方法汇总(亲测可以)_enter a notebook path relative to notebook dir

- 7Docker启动rabbitmq失败Failed to create thread: Operation not permitted (1)

- 8ubuntu20.04之--CUDA和CUDNN的安装_ubuntu20.04安装cuda和cudnn

- 9Using WebView from more than one process at once with the same data directory is not supported

- 10关于Mac配置逆向工程

当前位置: article > 正文

Auto-Encoder_autoencoder加注意力机制

作者:笔触狂放9 | 2024-04-01 10:22:59

赞

踩

autoencoder加注意力机制

视频链接:第八节 2021 - 自编码器 (Auto-encoder) (上) – 基本概念_哔哩哔哩_bilibili

参考博客:【机器学习】李宏毅——AE自编码器(Auto-encoder)_FavoriteStar的博客-CSDN博客

自监督学习

- 自监督学习需要采用大量未标注的信息去训练一个模型

- 我们需要发现一些不需要标注的任务来进行学习,这个不用标注的任务叫做self-supervised Learning 或者Pre-trainning。Auto-encoder也是其中的一种古老的任务。

- 我们可以将模型进行微调用到下游的任务中。

与encoder-decoder的区别

auto-encoder本身是个固定的方法,但是他提供了一种编码-解码的思路,世人可以沿用这个思路和框架去研究新的方法。

encoder-decoder是一个框架,框架中有很多模块,可以引入attention机制作为一个模块形成一中方法。其中encoder是用来特征编码,decoder是将特征解码出我们需要的输出,中间为了提升性能可以增加各种模块。

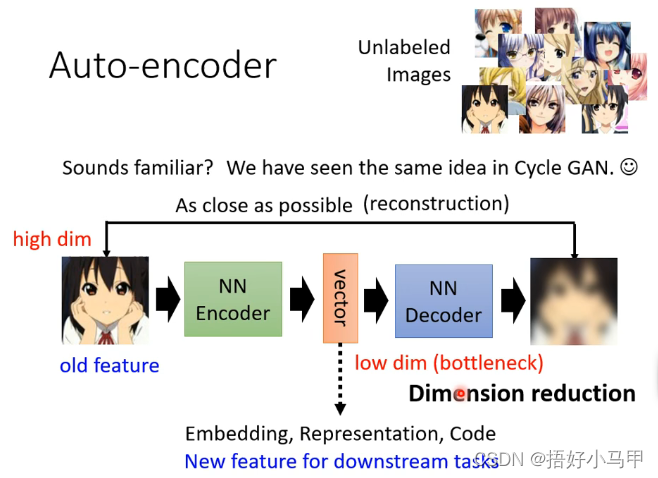

Auto-encoder

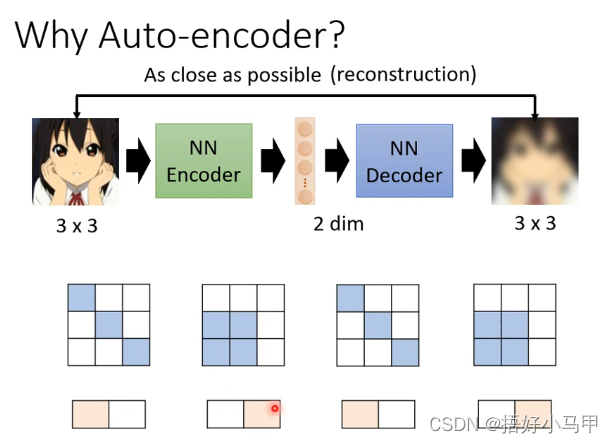

Auto-encoder 具有两个神经网络 ,分别为 Encoder和Decoder。

- encoder将原始的数据转换为一个向量(又可以称为编码,embedding)

- decoder将向量还原成原始的数据

编码就是将输入的序列转换成一个固定长度的向量,解码是将之前生成的向量转换为输出序列。

我们希望输出的图像和输出的图片两者越接近越好。

由于图片的变化是有限的,不是所有的变化都是图片。如果encoder能找到复杂输入中所有有限的变化,我们就能将原始问题简化。在下游任务中也能用较少的训练资料获得更好的结果。

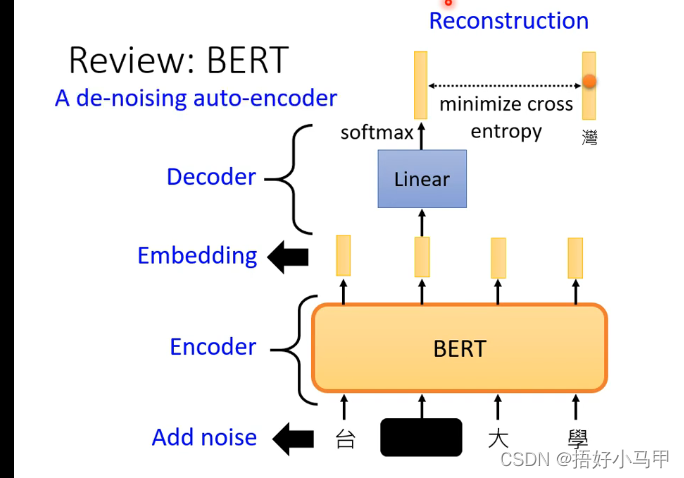

De-noising Auto-encoder 和 Bert之间的关系

- De-noising Auto-encoder中的 Encoder的输入并不是原始的图像,而是将图像加上一定的噪声之后再作为Encoder的输入,而在输出的时候是要求Decoder输出能够与未加噪声之前的图像越接近越好。

- Bert如图所示也采用了Mask方法,所以两者有相似之处。

应用可以看参考博客。

对encoder-decoder不了解的可以参考博客Encoder-Decoder 模型架构详解__Summer tree的博客-CSDN博客

声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:【wpsshop博客】

推荐阅读

相关标签