- 1【移动机器人技术】move_base参数配置方法及含义_,move_base 手动添加障碍物

- 2超级详细:微服务SpringCloud学习笔记(一)——认识微服务、服务拆分与调用、Eureka注册中心、Ribbon负载均衡、Nacos注册中心

- 3Stable Diffusion软件下载_stable diffusion百度云

- 4FPGA配置之SelectMAP总线

- 5win7 登陆机制Credential Provider_除session 0 之外的每一个session仍会有一个 winlogon 实例, 已通过新的 l

- 6讲述 it工作者 8年经历。_it工作经历

- 7Linux系统下解决使用github提示Please make sure you have the correct access rights and the repository exists的错误_linux please make sure you have the correct access

- 8MySQL~Redo刷盘策略、LogBuffer缓存池和LogFile日志文件理解_每次commit log buffer日志

- 98.11 TCP链接管理与UDP协议_tcp-udp服务管理

- 10[BUUCTF 刷题] Reverse解题方法总结(一)_buuctf reverse

第一章:大模型简介_3claude v1大模型的特点

赞

踩

一概述.

大语言模型(LLM)是一种具有数百亿参数的人工智能模型,旨在理解和生成人类语言。其发展经历了多个阶段,从最早的统计学习方法到深度学习的应用,最终引入Transformer架构,通过大规模数据训练,使模型在语言理解和生成任务上表现卓越。LLM的巨大规模使其具备强大的语言理解能力,有时甚至超越人类。

LLM已经在多个领域产生深远影响,包括自然语言处理、信息检索和计算机视觉。它为通用人工智能(AGI)的实现提供了前进的动力,引发了对未来人工智能的思考和探索。

总之,LLM代表了人工智能领域的重要进展,改变了人机交互方式,激发了对AI未来的探讨。

大语言模型(LLM)具有多个显著的能力和特点:

二.大模型的多个能力和特点

**能力:**

1. **涌现能力(emergent abilities):** LLM表现出强大的涌现能力,即在大型模型中出现但在小型模型中不明显的性能提升。这包括上下文学习、指令遵循和逐步推理等通用能力,使其能够在各种任务中表现出色。

2. **作为基座模型支持多元应用的能力:** LLM可作为基座模型支持多个应用,提高了研发效率,降低了人力投入,同时提供更好的应用效果。

3. **支持对话作为统一入口的能力:** LLM引入了对话聊天,可以应用于智能助手和对话型应用,满足用户对聊天交互的特殊偏好。

**特点:**

1. **巨大的规模:** LLM通常拥有数十亿甚至数千亿个参数,使其能够捕捉更多语言知识和复杂结构。

2. **预训练和微调:** LLM使用预训练和微调学习方法,首先在大规模文本数据上进行预训练,然后通过微调适应特定任务。

3. **上下文感知:** LLM在处理文本时具有强大的上下文感知能力,适用于对话、文章生成和情境理解。

4. **多语言支持:** LLM可以用于多种语言,实现跨文化和跨语言应用。

5. **多模态支持:** 一些LLM支持多模态数据,包括文本、图像和声音。

6. **多领域应用:** LLM已广泛应用于文本生成、自动翻译、信息检索、聊天机器人等多个领域。

7. **伦理和风险问题:** LLM引发了伦理和风险问题,需要谨慎应用和研究。

总之,LLM是具有出色语言处理能力的技术,已经在多个领域展示了潜力,但也需要关注伦理和风险问题。这些能力和特点使LLM成为了当今计算机科学和人工智能领域的重要研究和应用方向。

三:模型分类介绍

常见的大模型:

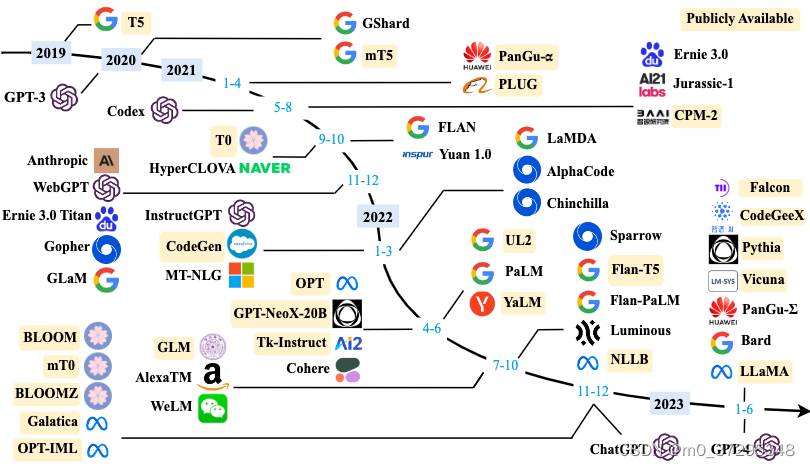

大语言模型的发展历程虽然只有短短不到五年的时间,但是发展速度相当惊人,截止 2023 年 6 月,国内外有超过百种大模型相继发布。按照时间线给出了 2019 年至 2023 年 6 月比较有影响力并且模型参数量超过 100 亿的大语言模型,如下图所示:

闭源大模型:

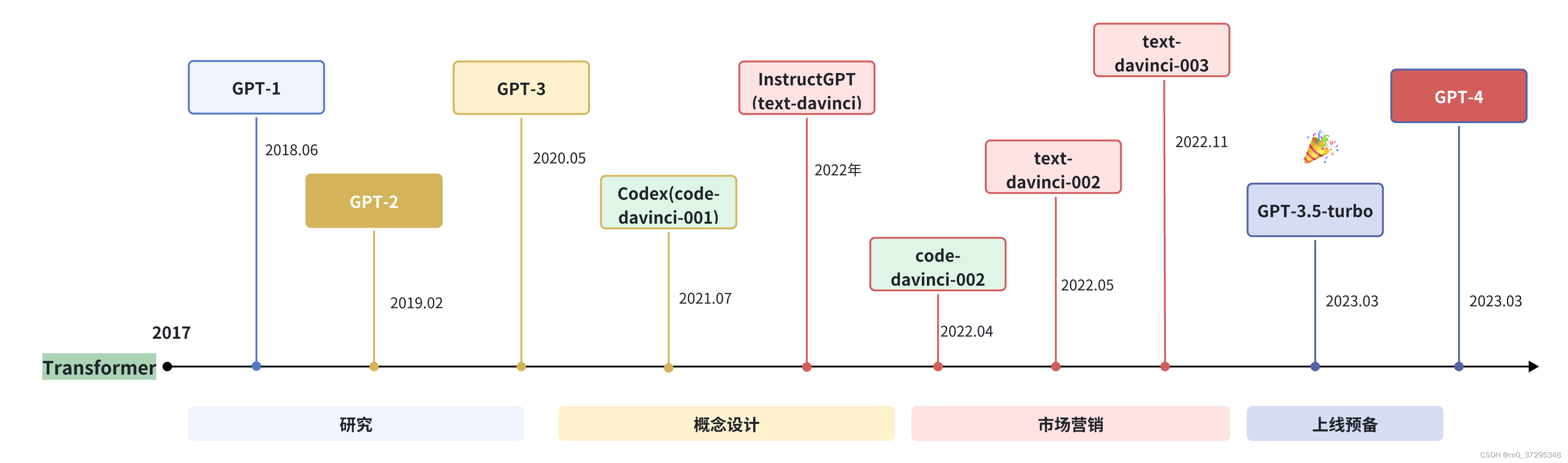

1.GPT系列

OpenAI 公司在 2018 年提出的 GPT(Generative Pre-Training)模型是典型的 生成式预训练语言模型 之一。

GPT 模型的基本原则是通过语言建模将世界知识压缩到仅解码器的 Transformer 模型中,这样它就可以恢复(或记忆)世界知识的语义,并充当通用任务求解器。它能够成功的两个关键点:

- 训练能够准确预测下一个单词的仅解码器的 Transformer 语言模型

- 扩展语言模型的大小。

2.Claude系列

Claude 系列模型是由 OpenAI 离职人员创建的 Anthropic 公司开发的闭源语言大模型,可以完成摘要总结、搜索、协助创作、问答、编码等任务。目前包含 Claude 和 Claude-Instant 两种模型可供选择,其中 Claude Instant 的延迟更低,性能略差,价格比完全体的 Claude-v1 要便宜,两个模型的上下文窗口都是 9000 个token(约 5000 个单词,或 15 页)它的目标是“更安全”、“危害更小”的人工智能。最早的 Claude 于 2023 年 3 月 15 日发布,并在 2023 年 7 月 11 日,更新至 Claude-2。Claude 2 的训练参数官方并未公开,但是相关的猜测大概是 860.1 亿个参数。

该系列模型通过无监督预训练、基于人类反馈的强化学习和 Constitutional AI 技术(包含监督训练和强化学习)进行训练,旨在改进模型的有用性、诚实性和无害性。值得一提的是,Claude 最高支持 100K 词元的上下文,而 Claude-2 更是拓展到了 200K 词元的上下文。相比于Claude 1.3, Claude 2 拥有更强的综合能力,同时能够生成更长的相应。

总的来说,Claude 2 注重提高以下能力:

- Anthropic 致力于提高 Claude 作为编码助理的能力,Claude 2 在编码基准和人类反馈评估方面性能显著提升。

- 长上下文(long-context)模型对于处理长文档、少量 prompt 以及使用复杂指令和规范进行控制特别有用。Claude 的上下文窗口从 9K token 扩展到了 100K token(Claude 2 已经扩展到 200K token,但目前发布版本仅支持 100K token)。

- 以前的模型经过训练可以编写相当短的回答,但许多用户要求更长的输出。Claude 2 经过训练,可以生成最多 4000 个 token 的连贯文档,相当于大约 3000 个单词。

- Claude 通常用于将长而复杂的自然语言文档转换为结构化数据格式。Claude 2 经过训练,可以更好地生成 JSON、XML、YAML、代码和 Markdown 格式的正确输出。 虽然 Claude 的训练数据仍然主要是英语,但 Claude 2 的训练数据中非英语数据比例已经明显增加。

- Claude 2 的训练数据包括 2022 年和 2023 年初更新的数据。这意味着它知道最近发生的事件,但它仍然可能会产生混淆。

3.PaLM系列

PaLM 系列语言大模型由 Google 开发。其初始版本于 2022 年 4 月发布,并在 2023 年 3 月公开了 API。PaLM 基于 Google 提出的 Pathways 机器学习系统搭建,训练数据总量达 780B 个字符,内容涵盖网页、书籍、新闻、开源代码等多种形式的语料。前 PaLM 共有 8B、62B、540B 三个不同参数量的模型版本。Google 还开发了多种 PaLM 的改进版本。Med-PaLM 是 PaLM 540B 在医疗数据上进行了微调后的版本,在 MedQA 等医疗问答数据集上取得了最好成绩。PaLM-E 是 PaLM 的多模态版本,能够在现实场景中控制机器人完成简单任务。

2023 年 5 月,Google 发布了 PaLM 2,但并未公开其技术细节。Google 内部文件显示其参数量为 340B,训练数据为 PaLM 的 5 倍左右。它是 PaLM(540B) 的升级版,能够处理“多语言任务”。它使用了一个覆盖 100 多种语言的语料库进行训练。而 PaLM2 实际上是一系列模型,可以根据规模分为:Gecko、Otter、Bison和Unicorn,可以根据不同的领域和需求进行微调,最小模型可以部署在移动端,最大的参数量也只有 14.7B。现已部署在 Google 的 25 个产品和功能中,包括 Bard 和 Google Worksapce 应用,针对不同的领域又可以变成专有模型,比如 Med-PaLM 2,是第一个在美国医疗执照考试类问题上表现出“专家”水平的大型语言模型。

PaLM2 的几大突破:

- 最优的缩放比例(训练数据大小/模型参数量),通过 compute-optimal scaling 的研究,可以得知数据大小与模型大小同样重要。根据谷歌的研究,数据和模型大小大致按照 1:1 的比例缩放,可以达到最佳性能。(过去常认为,模型参数量的大小大致为数据集 3 倍更佳)

- 训练数据集非纯英文语料,混合了百种语言,包括了网络文档、书籍、代码、数学和对话数据,比用于训练PaLM的语料库大得多。并在研究中发现,越大的模型越是能处理更多的非英文数据集,而且包含更高比例的非英语数据,对多语言任务(如翻译和多语言问题回答)是有利的,因为模型会接触到更多的语言和文化。这使得该模型能够学习每种语言的细微差别。

4.国产闭源大模型

1.文心一言:

文心一言是基于百度文心大模型的知识增强语言大模型,文心大模型参数量非常大,达到了 2600 亿

2.星火大模型:

星火大模型包含超过1700 亿个参数,来源于数十亿的语言数据集。

开源大模型

1.LLaMA 系列

LLaMA 系列模型是 Meta 开源的一组参数规模 从 7B 到 70B 的基础语言模型,它们都是在数万亿个字符上训练的,展示了如何仅使用公开可用的数据集来训练最先进的模型,而不需要依赖专有或不可访问的数据集。这些数据集包括 Common Crawl、Wikipedia、OpenWebText2、RealNews、Books 等。LLaMA 模型使用了大规模的数据过滤和清洗技术,以提高数据质量和多样性,减少噪声和偏见。LLaMA 模型还使用了高效的数据并行和流水线并行技术,以加速模型的训练和扩展。特别地,LLaMA 13B 在 CommonsenseQA 等 9 个基准测试中超过了 GPT-3 (175B),而 LLaMA 65B 与最优秀的模型 Chinchilla-70B 和 PaLM-540B 相媲美。LLaMA 通过使用更少的字符来达到最佳性能,从而在各种推理预算下具有优势。

与 GPT 系列相同,LLaMA 模型也采用了 decoder-only 架构,但同时结合了一些前人工作的改进,例如:

Pre-normalization,为了提高训练稳定性,LLaMA 对每个 Transformer子层的输入进行了 RMSNorm 归一化,这种归一化方法可以避免梯度爆炸和消失的问题,提高模型的收敛速度和性能;SwiGLU 激活函数,将 ReLU 非线性替换为 SwiGLU 激活函数,增加网络的表达能力和非线性,同时减少参数量和计算量;RoPE 位置编码,模型的输入不再使用位置编码,而是在网络的每一层添加了位置编码,RoPE 位置编码可以有效地捕捉输入序列中的相对位置信息,并且具有更好的泛化能力。

这些改进使得 LLaMA 模型在自然语言理解、生成、对话等任务上都取得了较好的结果

2.GLM 系列

模型是清华大学和智谱 AI 等合作研发的开源语言大模型。ChatGLM 是基于 GLM 结构开发的具有 62 亿参数量的语言大模型,支持 2048 的上下文长度。其使用了包含 1 万亿字符的中英文语料进行训练,能够支持中文和英文两种语言的任务。通过监督微调、反馈自助、人类反馈强化学习等多种训练技术,ChatGLM 拥有强大的生成能力,能够生成更符合人类偏好的内容。与 GLM 相似,通过 INT4 量化 和 P-Tuning v2 等高效微调的算法,ChatGLM 能够在 7G 显存的条件下进行微调。

在 ChatGLM 的基础上,2023 年 6 月发布的 ChatGLM 2 使用了包含 1.4 万亿字符的中英预料进行预训练,并使用人类偏好的数据对模型进行对齐训练,拥有比前一版本更加强大的能力,在多个任务上取得提升。

- 通过 FlashAttention 技术,ChatGLM 2 能够处理更长的长下文,支持的长下文长度达到了 3.2 万字符

- 通过 Multi-Query Attention 技术,ChatGLM 2 能够进一步地提升推理速度,减小对显卡的显存占用。

在 2023 年 10 月 27 日的 2023 中国计算机大会(CNCC)上,智谱 AI 推出了 ChatGLM3 ,ChatGLM3-6B 是 ChatGLM3 系列中的开源模型,在保留了前两代模型对话流畅、部署门槛低等众多优秀特性的基础上,ChatGLM3-6B 引入了如下特性:

- 更强大的基础模型: ChatGLM3-6B 的基础模型

ChatGLM3-6B-Base采用了更多样的训练数据、更充分的训练步数和更合理的训练策略。在语义、数学、推理、代码、知识等不同角度的数据集上测评显示,ChatGLM3-6B-Base 具有在 10B 以下的基础模型中最强的性能。 - 更完整的功能支持: ChatGLM3-6B 采用了全新设计的 Prompt 格式,除正常的多轮对话外。同时原生支持工具调用(Function Call)、代码执行(Code Interpreter)和 Agent 任务等复杂场景。

- 更全面的开源序列: 除了对话模型 ChatGLM3-6B 外,还开源了基础模型 ChatGLM3-6B-Base、

长文本对话模型 ChatGLM3-6B-32K。以上所有权重对学术研究完全开放,在填写问卷进行登记后亦允许免费商业使用。

此外,还开源了 多模态 CogVLM-17B 、以及 智能体 AgentLM ,具体来说:

- 在对话模型上,对标 ChatGPT 的是 ChatGLM

- 在文生图方面,对标 DALL.E 的是 CogView

- 代码生成上,与 Codex 相对的是 CodeGeeX

- 搜索增强上,与 WebGPT 相对的是 WebGLM

- 在多模态、图文理解领域,与 GPT-4V 对标的有 ChatGLM3

3.通义千问

通义千问由阿里巴巴基于“通义”大模型研发,于 2023 年 4 月正式发布。2023 年 8 月,阿里云开源了Qwen(通义千问)系列工作,当前开源模型的参数规模为70亿(7B)和140亿(14B)。本次开源包括基础模型Qwen,即 Qwen-7B 和 Qwen-14B ,以及对话模型 Qwen-Chat ,即 Qwen-7B-Chat 和 Qwen-14B-Chat。

4.Baichuan

Baichuan 是由百川智能开发的开源可商用的语言大模型,在权威的中文和英文 benchmark 上均取得同尺寸最好的效果,其基于Transformer 解码器架构。

Baichuan-7B 是在大约 1.2 万亿字符上训练的 70 亿参数模型,支持中英双语,最大 4096 的上下文窗口长度。

Baichuan-13B 在 Baichuan-7B 的基础上进一步扩大参数量到 130 亿,并且在高质量的语料上训练了 1.4 万亿 字符,超过 LLaMA-13B 40%,是当前开源 13B 尺寸下训练数据量最多的模型。其支持中英双语,使用 ALiBi 位置编码,最大 4096 的上下文窗口长度,使用 rotary-embedding,是现阶段被大多数模型采用的位置编码方案,具有很好的外推性。百川同时开源了预训练和对齐模型,预训练模型是面向开发者的“基座”,而对齐模型则面向广大需要对话功能的普通用户。除了原始权重,为实现更高效的推理,百川开源了 INT8 和 INT4 的量化版本,相对非量化版本在几乎没有效果损失的情况下大大降低了部署的机器资源需求。