热门标签

热门文章

- 1Oracle数据库恢复时要建库吗_Oracle数据ASM实例不能mount怎么恢复数据

- 2Docker基础、进阶笔记,为k8s的学习预预热_下器好3ee5b1

- 3Kerberos安全认证-连载11-HBase Kerberos安全配置及访问_kerberos hbase(4)

- 4rabbitmq 清理消息队列 解决 启动消费者报错_由于队列不存在,启动消费者报错的这个问题

- 5vue videojs视频播放插件 动态资源

- 6Android13 适配指南_android 13适配

- 7Kimi创始人套现4000万美元疑云|「商汤」大模型一体机可节约80%推理成本,完成云端边全栈布局|中国AI活化石,熬成AIGC第一股| 谁在制造小米汽车?_月之暗面 推理成本

- 8python 主题5 字符串及正则表达式 单元作业_输入一个1000以内的正整数 n,在同一行内输出 [0,n] 之间各位数字之和为5的数,数字

- 9C++ 实现对战AI五子棋_c++五子棋实现ai下法

- 10别再分库分表了,试试TiDB!

当前位置: article > 正文

基于Pytorch学习Bert模型配置运行环境详细流程_pycharm bert模型 代码运行

作者:笔触狂放9 | 2024-05-29 02:06:29

赞

踩

pycharm bert模型 代码运行

基于Pytorch学习Bert模型配置运行环境详细流程

BERT是2018年10月由Google AI研究院提出的一种预训练模型。BERT的全称是Bidirectional Encoder Representation from Transformers。BERT在机器阅读理解顶级水平测试SQuAD1.1中表现出惊人的成绩: 全部两个衡量指标上全面超越人类,并且在11种不同NLP测试中创出SOTA表现,包括将GLUE基准推高至80.4% (绝对改进7.6%),MultiNLI准确度达到86.7% (绝对改进5.6%),成为NLP发展史上的里程碑式的模型成就。

一、安装配置初步运行环境

安装文章链接: 点击打开《基于Windows中学习Deep Learning之搭建Anaconda+Pytorch(Cuda+Cudnn)+Pycharm工具和配置环境完整最简版》文章

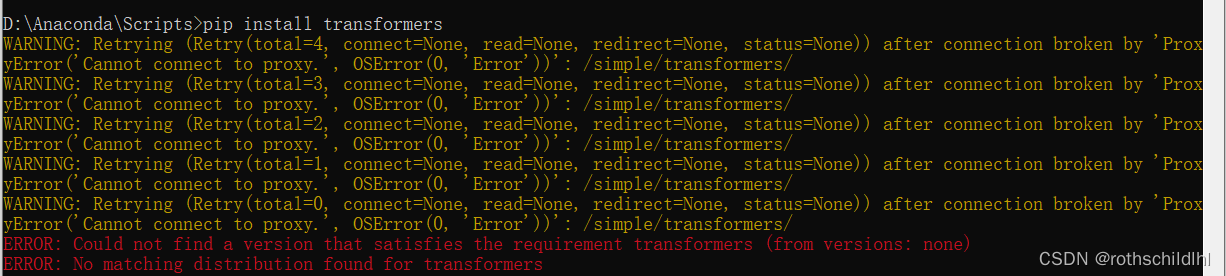

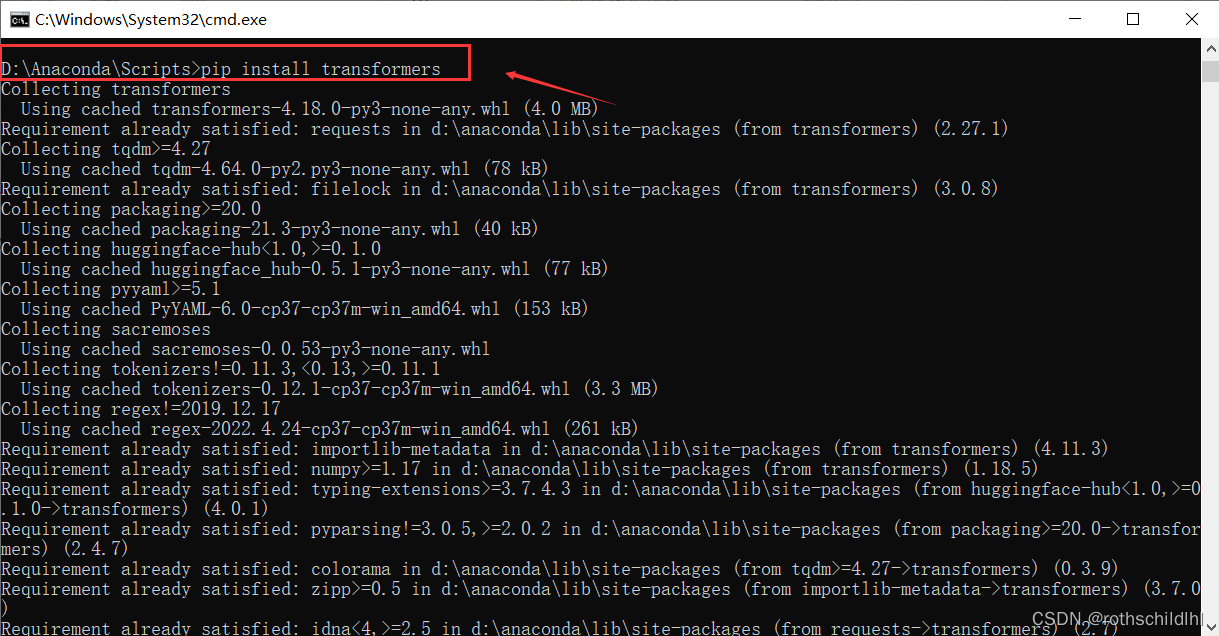

二、根据上面的文章配置好初步环境后,复制粘贴下面命令打开“D:\Anaconda\Scripts”路径下的控制平台CMD运行安装transformers,若出现下面图片中的错误无法正常安装则继续往后操作进行,没出现问题直接跳转到第九步(注意:博主配置运行环境是在Anaconda默认base的环境和新建的python虚拟环境transformers下都进行配置,其实可以只配置一个就行,一般选择新建的python虚拟环境,然后将配置好的虚拟环境的python运行环境和Pycharm对应的项目进行连接,然后即可正常运行项目程序)。

pip install transformers

- 1

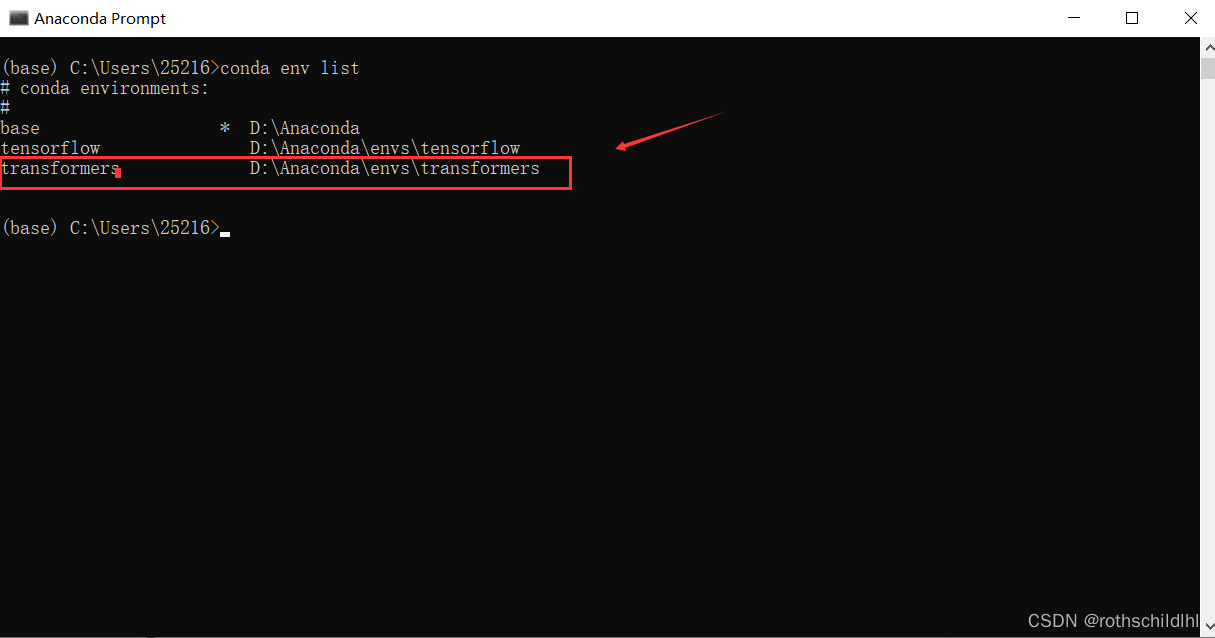

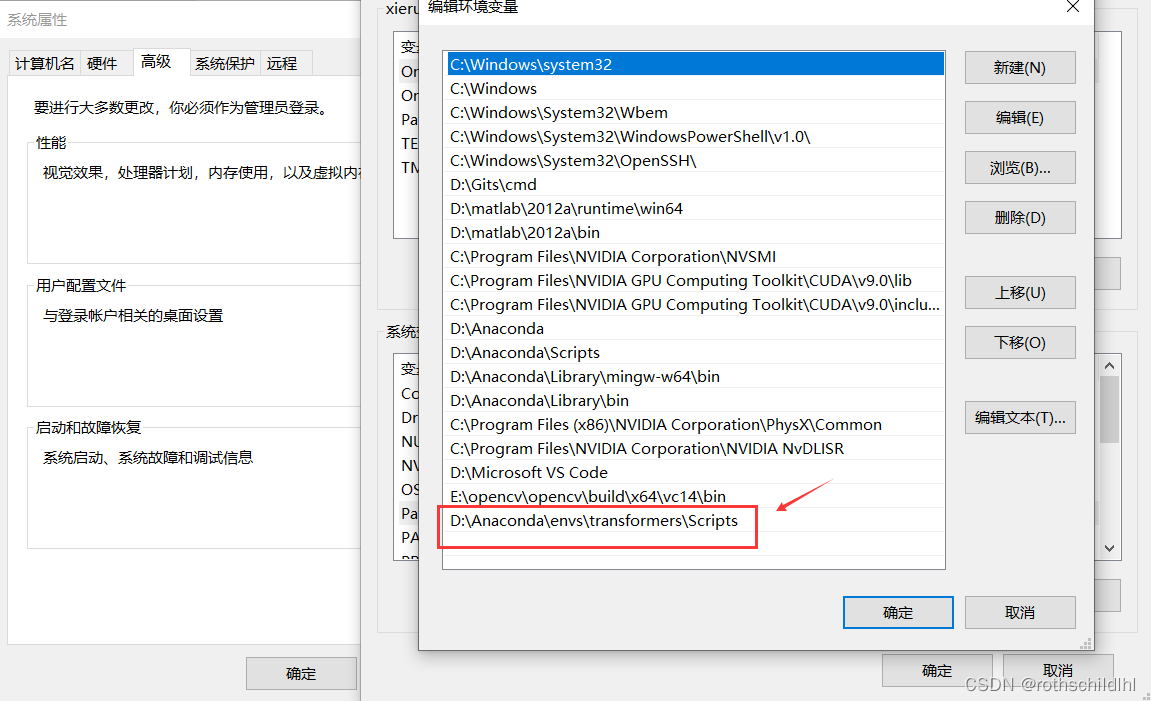

三、打开Anaconda Prompt,依次复制下面的命令运行建立Anaconda的python虚拟环境transformers,然后将“D:\Anaconda\envs\transformers\Scripts”添加到环境变量PATH中。注意:下面命令中的python=3.7是根据博主安装的python版本对应的,若你安装的是其他版本可以进行对应的修改。

conda create -n transformers python=3.7

- 1

conda env list

- 1

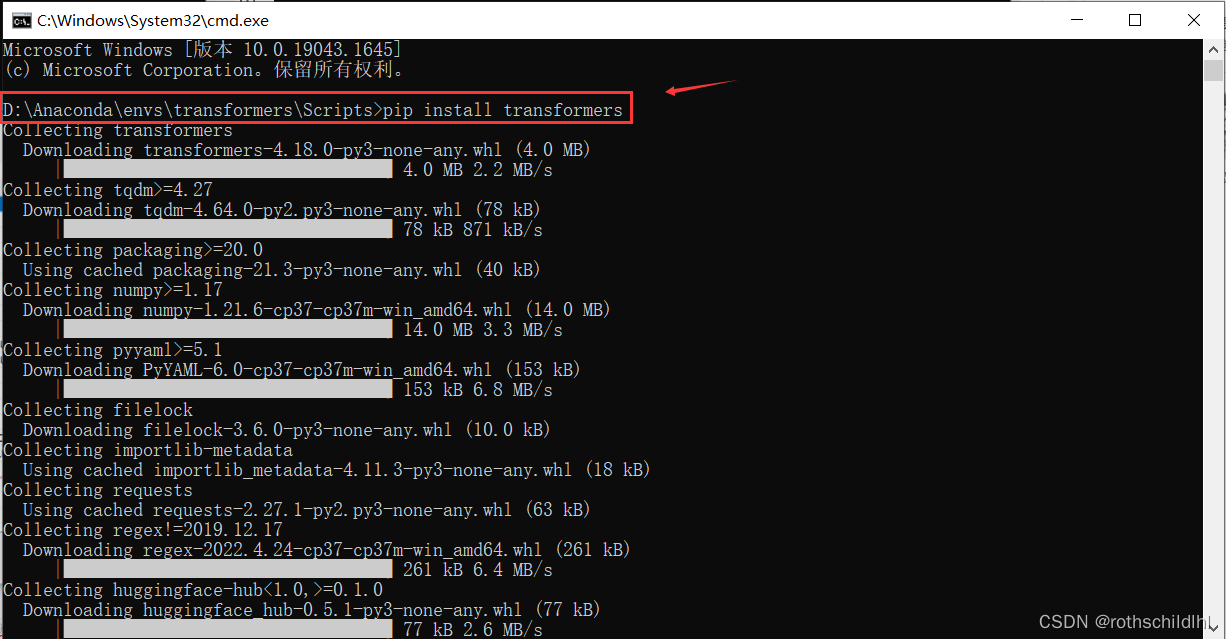

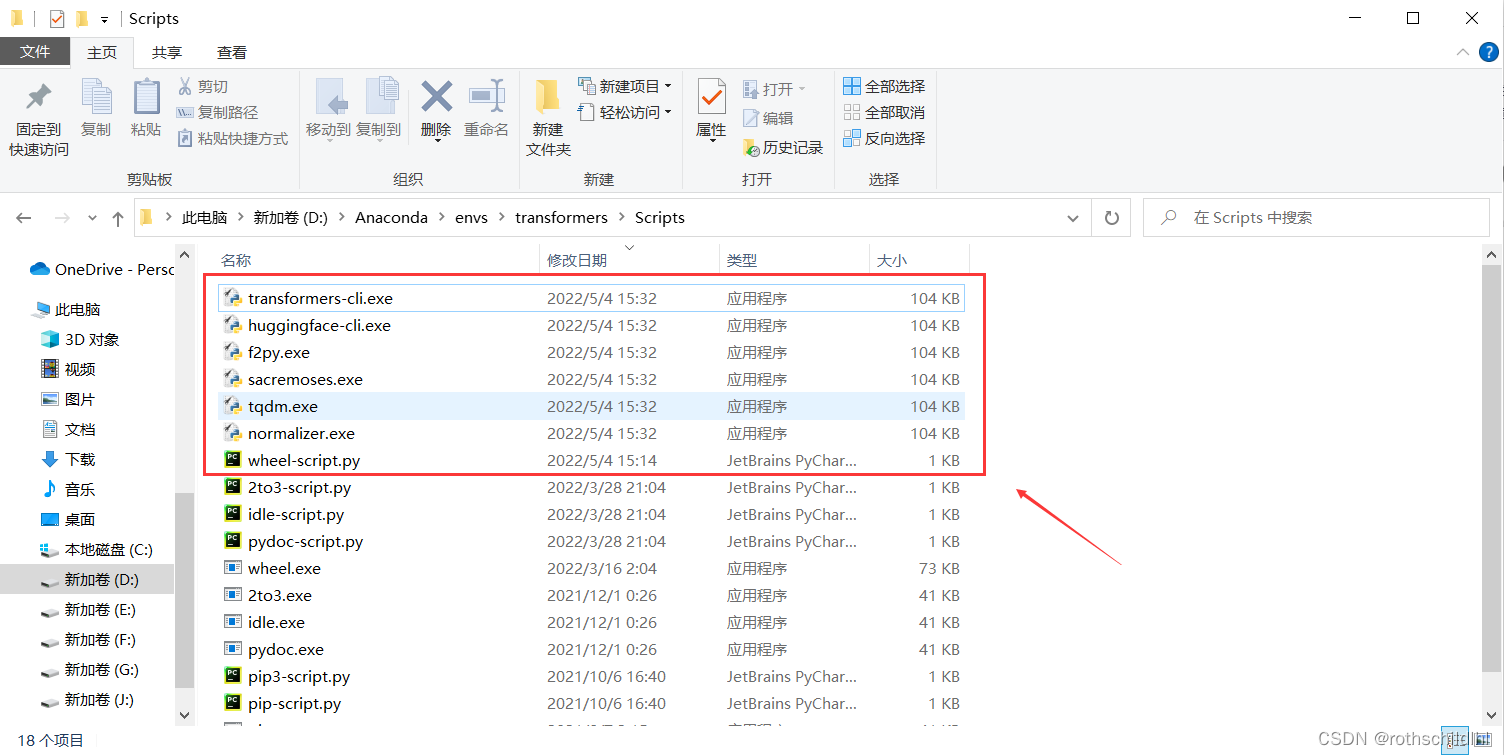

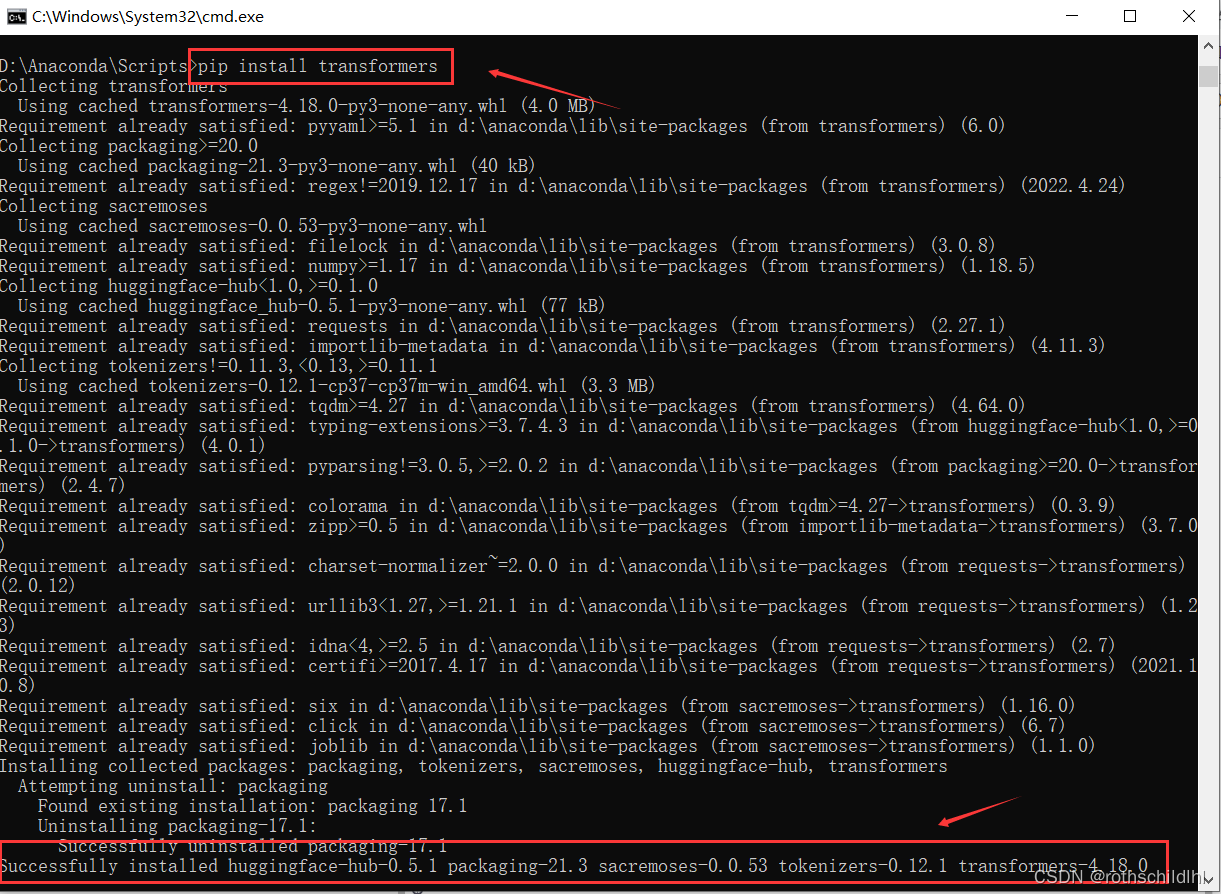

四、复制粘贴下面命令打开“D:\Anaconda\envs\transformers\Scripts”路径下的控制平台CMD运行安装transformers,等待一分钟左右进行安装。

pip install transformers

- 1

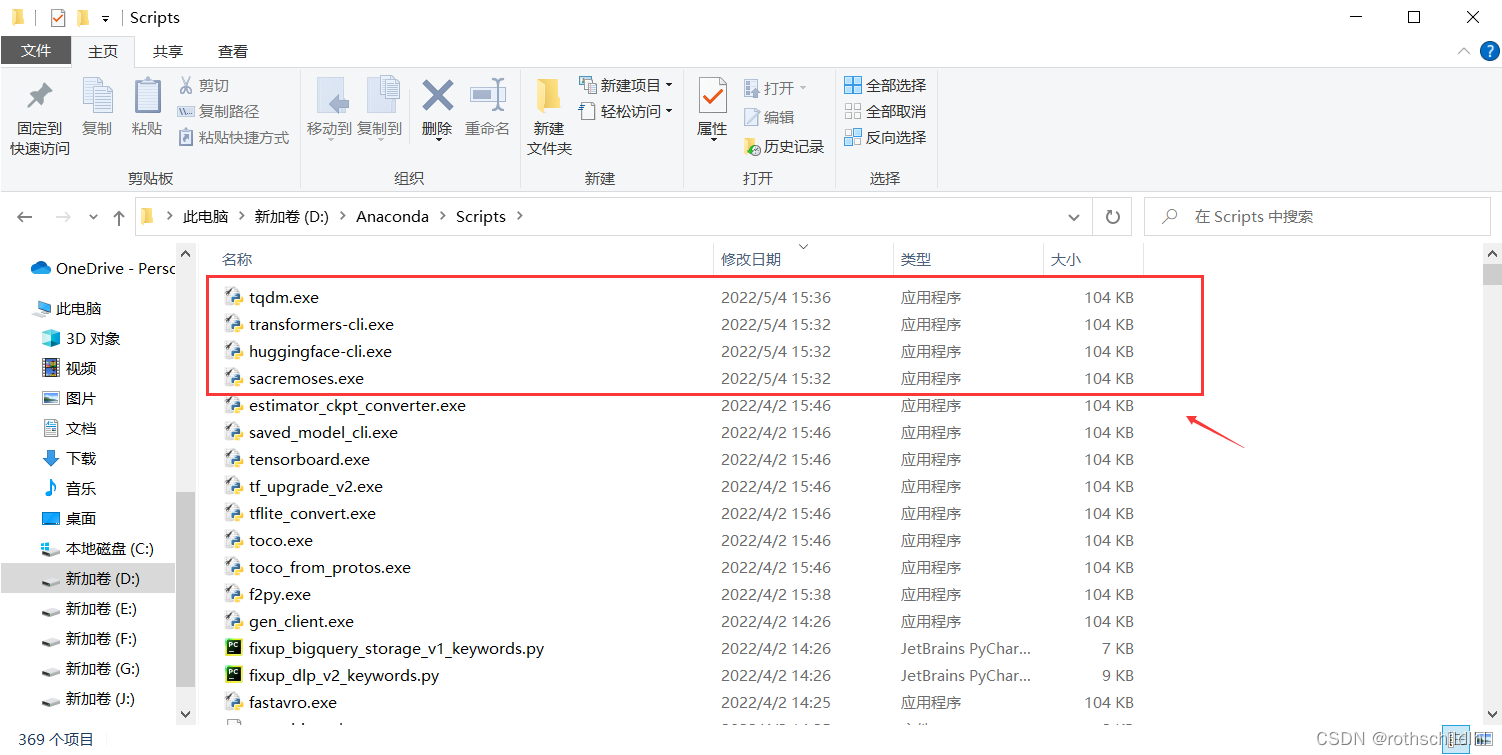

五、下载完成后将对应下载的文件复制粘贴到“D:\Anaconda\Scripts”路径下,复制粘贴过程中若提示重复的文件,要选择直接跳过。

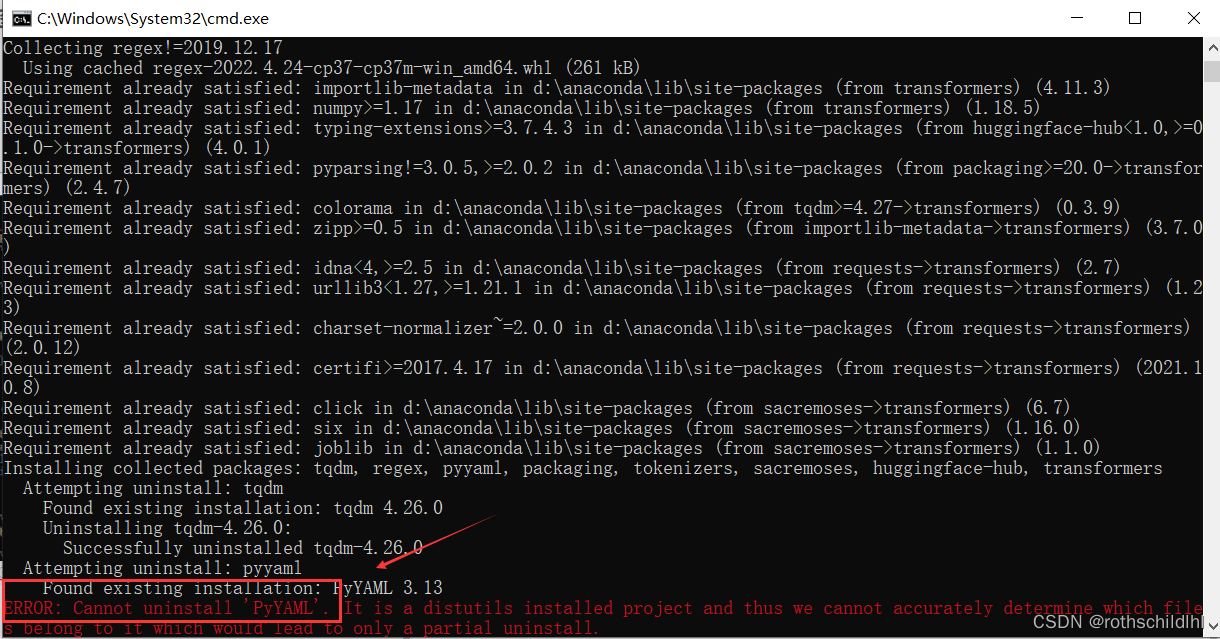

六、复制粘贴下面命令打开“D:\Anaconda\Scripts”路径下的控制平台CMD运行安装transformers,可能会出现下面图片中的部分小问题,如:ERROR: Cannot uninstall ‘PyYAML’。

pip install transformers

- 1

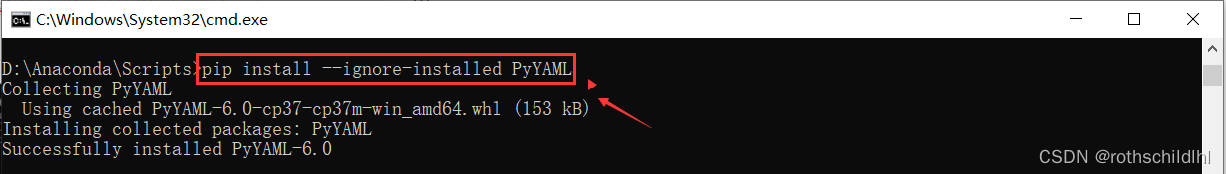

七、复制粘贴下面命令继续运行即可解决上面的小问题。

pip install --ignore-installed PyYAML

- 1

八、复制粘贴下面命令运行,等待十秒成功安装见下图。

pip install transformers

- 1

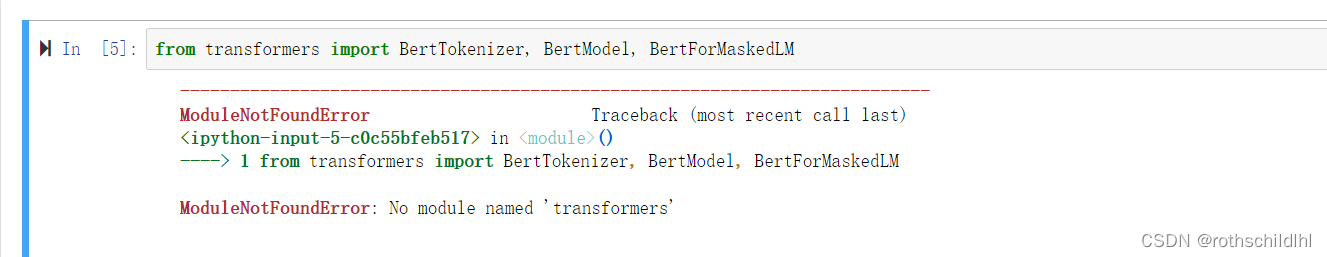

九、测试安装transformers是否成功,运行下面的代码是否报错,若报错表示没有安装成功见下图。

from transformers import BertTokenizer, BertModel, BertForMaskedLM

- 1

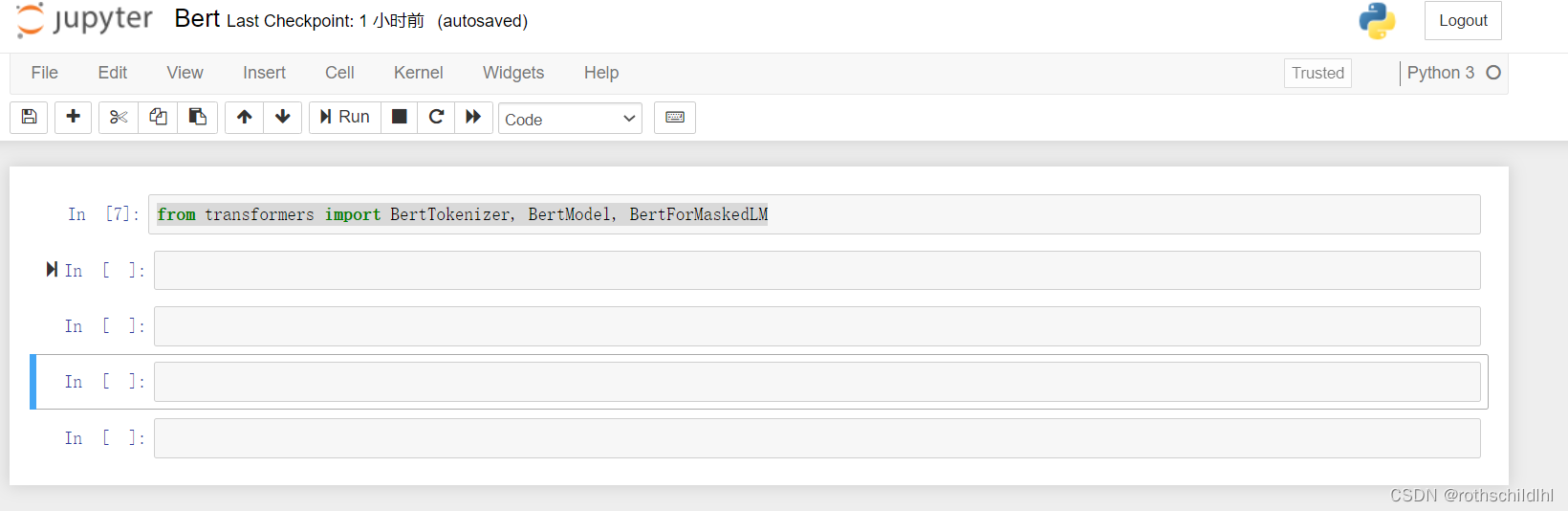

十、若没有报错表示安装成功,见下图。

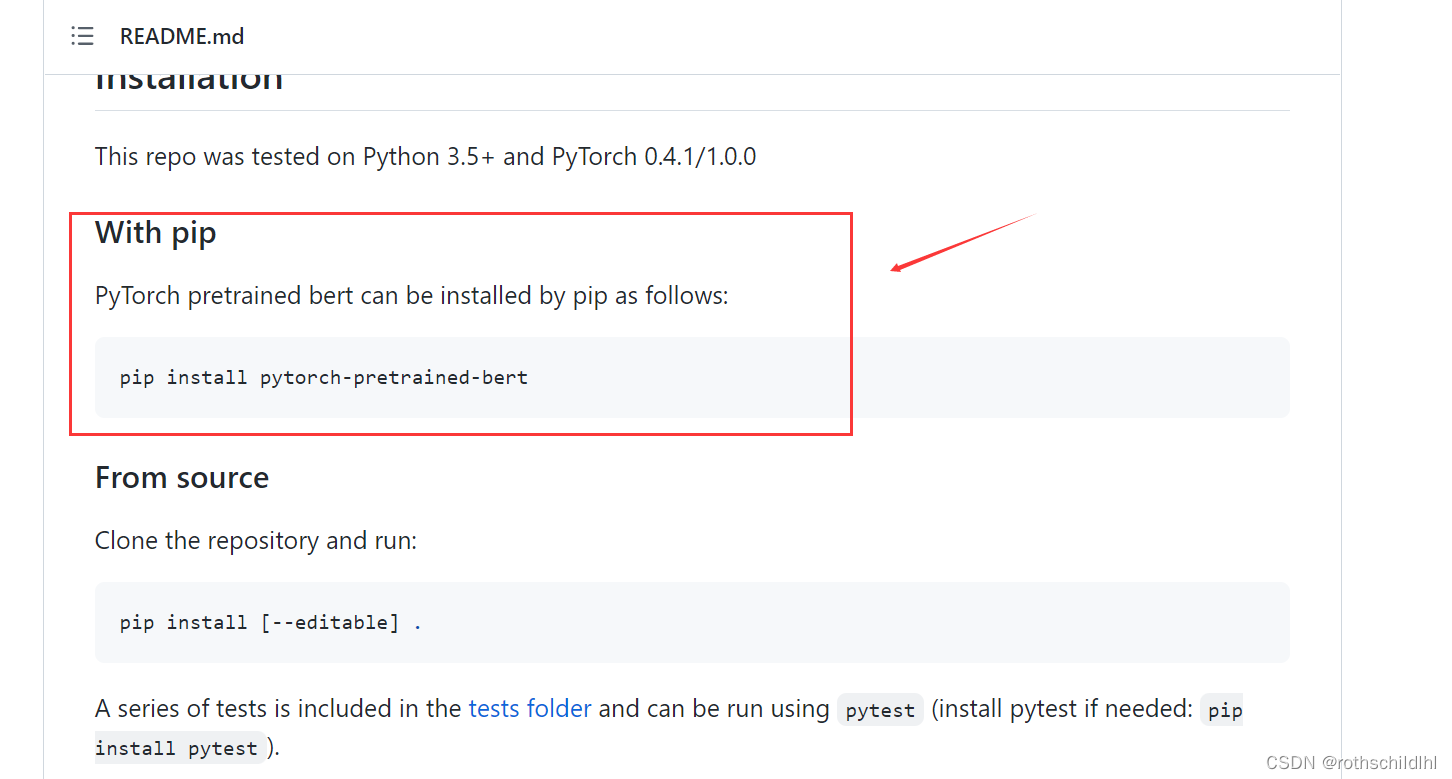

注意:有些涉及Bert模型配置运行环境的文章和github仓库依旧使用下面的命令进行环境的安装,但是总是提示无法安装,原因是Hugging Face的这款BERT工具以前称为pytorch-transformers和pytorch-pretrained-bert,在不断的更新迭代中已经更名为transformers这个名字,自然安装pytorch-pretrained-bert是无法正常安装的,所以要改成安装transformers。

pip install pytorch-pretrained-bert

- 1

pip install transformers

- 1

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/笔触狂放9/article/detail/640133

推荐阅读

相关标签