- 1蓝桥杯物联网开发 入门篇③ 利用CubeMX配置一个MDK工程_物联网 cube

- 2前端面试常见问题小总结(更新中)_前端开发面试时项目中遇到的问题

- 3AI时代,GPGPU和NPU哪个才是王者?_海光dcu华为npu

- 4mysql数据迁移_mysql数据库迁移

- 5【Holocubic简化修改版——基于STM32F405+ESP8266-12F:使用FreeRTOS和标准库】

- 6强化学习——学习笔记3

- 7[蓝桥杯物联网从0开始]第15届蓝桥杯物联网省赛CubeMx、Keil5软件的学习与使用_stm32cubemx用那种系列符合蓝桥杯

- 8Rust 的网络编程实践与技巧

- 9完全关闭Windows 安全中心防火墙

- 107个月我 自学Java 找到啦一份9k的工作,分享经历_go,上船! 推荐-java从零到就业 整个课程讲历时7个月左右,对标薪资:15000。 对标薪

将大模型集成到语音识别系统中的例子_大模型 语音识别和合成方法

赞

踩

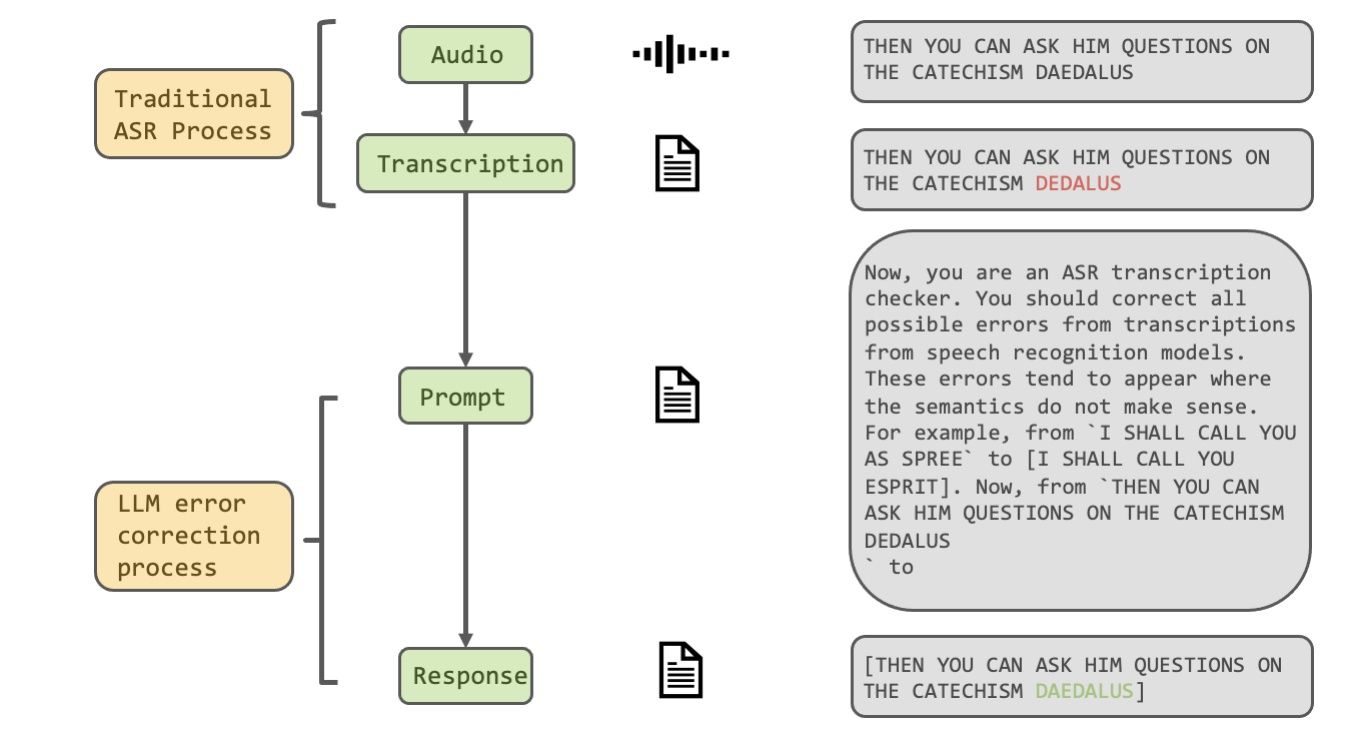

概述

本文旨在探索将大型语言模型(LLMs)集成到自动语音识别(ASR)系统中以提高转录准确性的潜力。 文章介绍了目前的ASR方法及其存在的问题,并对使用LLMs的上下文学习能力来改进ASR系统的性能进行了合理的动机论证。 本文设计了使用Aishell-1和LibriSpeech数据集的实验,通过与ChatGPT和GPT-4进行对比,评估LLMs在ASR应用中的能力。然而,初步的实验结果并不理想,表明利用LLMs的上下文学习来纠正语音识别转录中的错误仍然是一项具有挑战性的任务。 本文证明了在目前阶段,利用LLMs的上下文学习能力来改进语音识别转录中的潜在错误仍然面临一定的限制。当前方法在性能上无法支持他们的目标。

重要问题探讨

1. 对于使用大型语言模型(LLMs)来改善自动语音识别(ASR)转录的效果存在哪些挑战?研究中的结果证明这种方法导致更高的词错误率(WER),那么是什么造成了这一情况?

答:在使用LLMs来改善ASR转录的过程中,研究发现存在几个挑战。首先,直接应用LLMs的上下文学习能力来改善ASR转录结果是一项重大挑战,经常导致更高的词错误率(WER)。这可能是由于LLMs对于ASR特定领域的语音转录所需的上下文和语境并不完全理解所导致的。其次,即使在句子级别进行多次纠正,通过选择具有最低WER的输出来确定最终改正结果,并不切实际,因为我们无法获知实际的转录结果。因此,直接利用LLMs的上下文学习能力来提高ASR转录效果存在一些困难和限制。

2. 过去的研究中有哪些方法尝试利用大型语言模型(LLMs)来提高自动语音识别(ASR)的性能?这些方法中有哪些可以与本研究的方法进行比较?

答:过去的研究中已经尝试了多种方法来利用LLMs改善ASR性能。其中一些方法包括蒸馏方法和重新评分方法。在蒸馏方法中,例如,研究使用BERT进行蒸馏以生成用于训练ASR模型的软标签。另外一项研究则致力于传达嵌入向量中存在的语义知识。在重新评分方法中,研究人员将BERT调整用于n-best候选列表的重新评分任务。还有一种将N-best假设重新排序重新定义为一个预测问题的方法。

3. 文章中提到了对大型语言模型(LLMs)的不同版本进行了测试,包括GPT-3.5和GPT-4。这两个版本的性能相比如何?对于ASR转录而言,GPT-4有何不同之处?

答:文章中测试了GPT-3.5的三个版本以及性能优异的GPT-4。研究并未明确提及两个版本之间的具体性能差异。然而,我们可以推测,GPT-4相较于GPT-3.5可能具有更好的性能,或者在改善ASR转录方面具有更高的潜力。由于文章中提到的直接应用LLMs的能力对于ASR转录效果的提升存在困难,GPT-4可能具有更多的改进和优化,以使得ASR转录结果更精确和准确。

4. 文章中提到了通过给LLMs提供合适的指示和多个例子来尝试改进ASR转录的方法。那么,是否探索了不同指示和例子数量对于LLMs改进ASR转录效果的影响?有没有发现哪些指示和例子数量的组合对结果有积极的影响?

答:在研究中,探索了不同指示和例子数量对于LLMs改进ASR转录效果的影响。研究人员尝试了四个精心设计的指示和不同数量的例子(k = 1, 2, 3)来提供给LLMs。然而,遗憾的是,并没有发现具体的指示和例子数量能够积极地改善ASR转录结果。这进一步证实了直接利用LLMs的上下文学习能力来提高ASR转录效果的挑战和限制。

5. 文章中提到了在实际应用中选择具有最低词错误率(WER)的输出并不切实际,因为无法知道实际的转录结果。那么,在这种情况下,如何评估LLMs在提高ASR转录效果方面的潜力和效果?

答:鉴于在实际应用中无法知道实际的转录结果,评估LLMs在提高ASR转录效果方面的潜力和效果可以采用其他评估指标。除了词错误率(WER)之外,可以考虑其他转录质量评估指标,如编辑距离或语音识别准确率。通过比较使用LLMs和不使用LLMs的ASR转录结果之间的差异,可以评估LLMs在提高转录效果方面的效果。此外,也可以进行针对特定领域的人工评估,以评估LLMs对于该领域ASR转录的实际效果。

论文:2307.06530.pdf