- 1无人驾驶汽车系统入门(十八)——使用pure pursuit实现无人车轨迹追踪_小车无人驾驶最常用的局部路径跟踪方法

- 2Spring boot使用easy-es操作elasticsearch_easy-es学习

- 3阿里: 高效两阶段知识迁移的多实体跨域推荐

- 415个经典面试问题及回答思路,,大厂面试必问_程序员面试问公司问题

- 5在 Golang 中执行 Shell 命令_go语言执行shell脚本

- 6.gitignore文件不生效解决方法_git:下列路径根据您的一个.gitignore

- 7【无标题】安装ROS E: 无法定位软件包 ros-melodic-desktop-full_unable to locate package ros-melodic-desktop-full

- 8SpringBoot整合RabbitMQ,实现MQ动态配置交换机-路由-队列信息_spring boot 接入rabbitmq,使用外部配置文件(如yaml或properties)来

- 9buildroot创建最小根文件(支持驱动与QT)_buildroot qt

- 10Python-VBA函数之旅-len函数_excel的len函数在vba如何用

GPt-4o重磅发布,快速试试自己能否免费试用?_gpt4o新功能什么时候能用

赞

踩

今天一早打开电脑,论坛、推。基本被gpt-4o霸屏了!!!

链接:https://chatgpt.com/?model=gpt-4o

GPT-4o发布

北京时间2024年5月14日凌晨1点整,GPT-4o的发布会在举行,该模型能够实时跨音频、视觉和文本进行推理。发布会当天,GPT-4o也正式对外发布。这标志着人工智能领域的一个新里程碑,为未来的多模态人机交互开辟了新的可能性。

同时, GPT-4o将在免费套餐中提供,并向 Plus 用户提供高达 5 倍的消息限制。我们将在未来几周内在 ChatGPT Plus 中推出带有 GPT-4o 的新版本语音模式。

以下是发布会现场

GPT-4o介绍

GPT-4o(“o”代表“omni”,意为“全方位的”)是迈向更自然的人机交互的一大步——它能够接受文本、音频和图像的任意组合作为输入,并生成文本、音频和图像的任意组合作为输出。

GPT-4o主要特点:

- GPT-4o 是OpenAI的新旗舰模型,能够实时跨音频、视觉和文本进行推理。GPT-4o将在ChatGPT和API中作为文本和视觉模型提供(ChatGPT将继续通过现有的Voice Mode功能支持语音)。

- GPT-4 Turbo 与GPT-4o相比,GPT-4o在智能水平相同的情况下更快、更便宜,并且有更高的速率限制。

- GPT-4o目前的上下文窗口为128k,并且知识截止日期为2023年10月。

- 在API中使用GPT-4o:任何拥有OpenAI API账户的用户都可以使用这个模型,并且可以在Chat Completions API、Assistants API和Batch API中使用此模型。

我们来具体看看:

GPT高速发展

至2022年GPT发布以来,飞快的在更新大家的认知:

- 2022年11月30日:OpenAI首次介绍了ChatGPT。

- 2023年2月7日:Microsoft宣布将ChatGPT功能引入Bing。

- 2023年3月:GPT-4发布,成为当时ChatGPT最强大的大型语言模型。

- 2023年11月6日:推出了可以创建定制版本的ChatGPT,称为GPTs。

- 2023年11月21日:所有用户都可以使用带有语音功能的ChatGPT。

- 2024年2月16日:OpenAI发布的一个能够根据文本指令创建视频的AI模型Sora。

- 2024年5月13日:OpenAI宣布其新旗舰模型GPT-4o。

GPT-4o又是一里程碑的版本:

多模态能力的革命

GPT-4o的最大亮点在于其多模态能力。与以往的模型相比,GPT-4o能够处理和理解更加复杂的数据类型。无论是语音指令、图像内容还是文本信息,GPT-4o都能够提供精准的反馈和解答。这种能力使得GPT-4o在各种场景下都能发挥出色的表现,无论是在聊天应用中作为虚拟助手,还是在API中作为强大的数据处理工具。

性能与效率的双重提升

除了多模态能力之外,GPT-4o在性能和效率方面也有显著提升。GPT-4o的速度是GPT-4 Turbo的两倍,同时定价也更为经济,使得它在保持相同智能水平的同时,成本更低,速度更快。这一点对于开发者和企业来说尤为重要,因为它意味着能够以更低的成本实现更高的AI应用性能。

全球化视野下的语言支持

GPT-4o对非英语语言的支持也有所改进,这使得它能够更好地服务于全球用户。无论用户使用何种语言,GPT-4o都能提供准确的理解和响应,这对于构建全球化的AI应用至关重要。

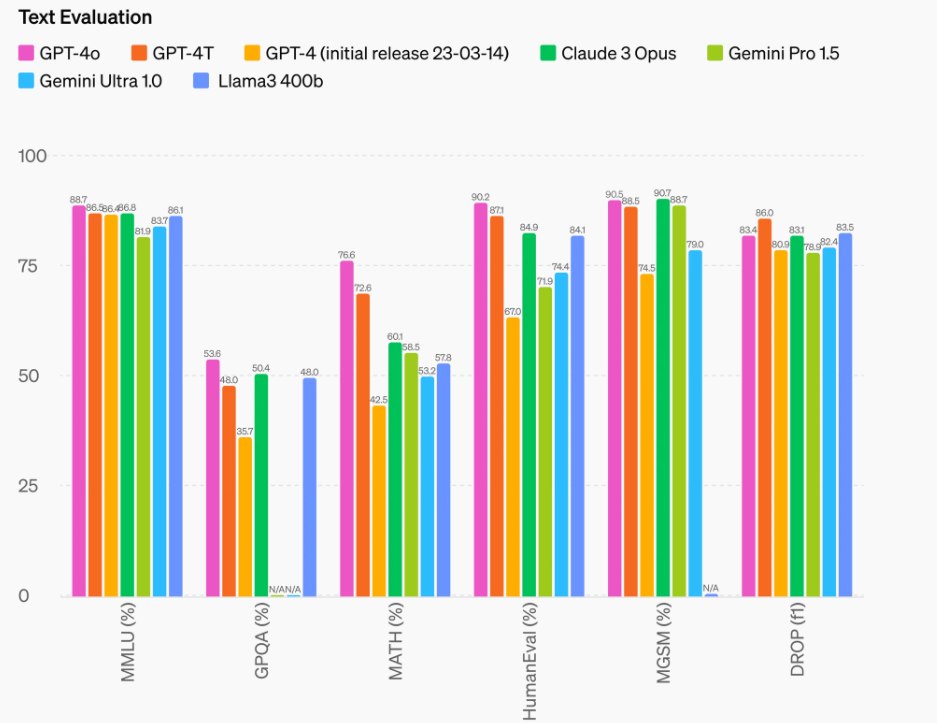

文本能力的提升

改进的推理能力 - GPT-4o在0-shot COT MMLU(常规知识问答)上设定了新的高分,达到了88.7%。所有这些评估都是通过我们新的简易评估库收集的。此外,在传统的5-shot no-CoT MMLU上,GPT-4o也设定了新的高分,达到了87.2%。(注:Llama3 400b仍在训练中)

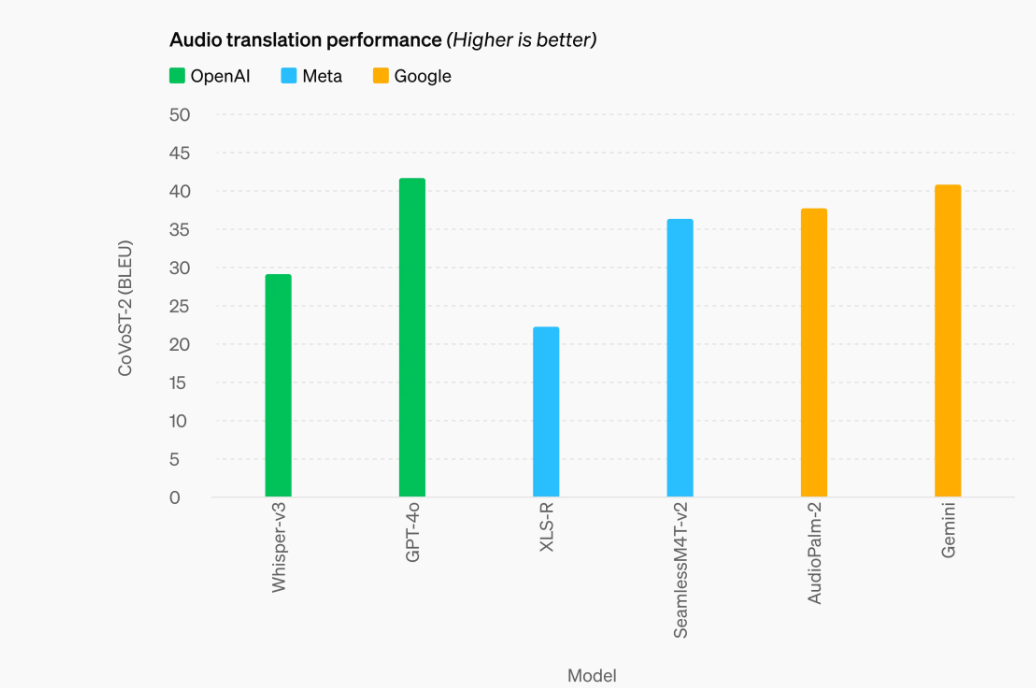

音频翻译性能的提升

GPT-4o 在语音翻译方面创下了新的领先地位,并在 MLS 基准测试中优于 Whisper-v3。

GPT-4o vs 同声传译

GPT-4o的语音响应速度令人印象深刻,能够在短至232毫秒内处理音频输入,平均响应时间仅为320毫秒。这一速度与人类在对话中的反应时间相媲美,使得与GPT-4o的互动变得更加流畅和自然,为用户提供了一种近似于与真人交谈的体验。

这种性能的飞跃意味着GPT-4o能够以更高的准确率和速度进行语音翻译,这对同声传译领域来说是一次质的飞跃。同声传译是一项对译员要求极高的工作,不仅需要流利的语言技能,还要求在高压环境下保持专注和冷静,这对人类来说是一项巨大的挑战。

当然这只是它其中的一项能力,未来相信它还会有更多的惊喜!