热门标签

热门文章

- 1直律云所——让法律变得简单_让法律更简单

- 2Redis迁移-RedisShake工具_redis-shake

- 3终于有人总结了大模型技术!(非常详细)零基础入门到精通,收藏这一篇就够了_大模型入门

- 4图书管理系统数据库设计_图书管理系统的数据库设计

- 5全网最全的网络安全学习(自学)路线!整理了一个月时间!!_网安学习资料

- 6mysql中hive库的编码_[转载]Hive设置MySQL元数据编码问题

- 7Django计算机毕业设计企业固定资产信息管理系统python(源码程序+lw+远程部署)_python固定资产管理程序源代码

- 8Java数据结构:双向链表的实现_双向链表java实现

- 9【华为OD机考 统一考试机试C卷】CPU算力分配(Java题解)_cpu算力分配算法题

- 10Spring && SpringMVC && Mybatis_java速成

当前位置: article > 正文

怎样解决Kafka出现数据积压问题?_kafka 积压数据无法写入

作者:笔触狂放9 | 2024-06-19 02:04:09

赞

踩

kafka 积压数据无法写入

Kafka消费者消费数据的速度是非常快的,但如果由于处理Kafka消息时,由于有一些外部IO、或者是产生网络拥堵,就会造成Kafka中的数据积压(或称为数据堆积)。如果数据一直积压,会导致数据出来的实时性受到较大影响。

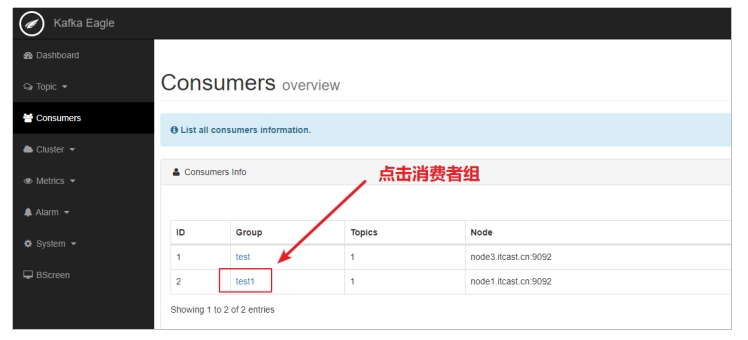

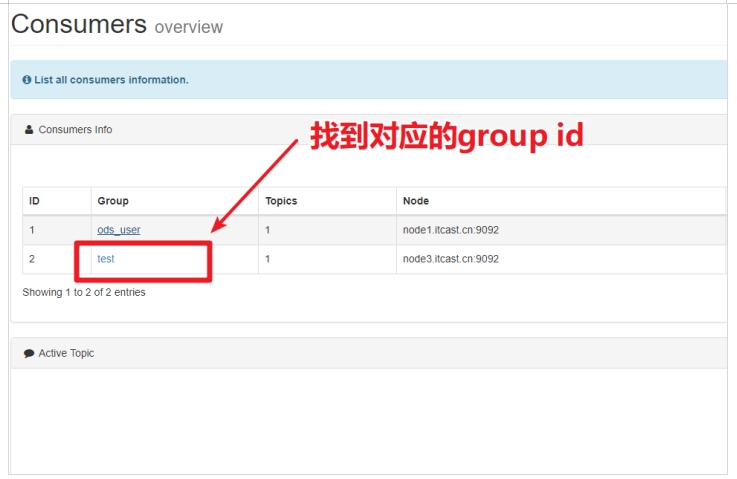

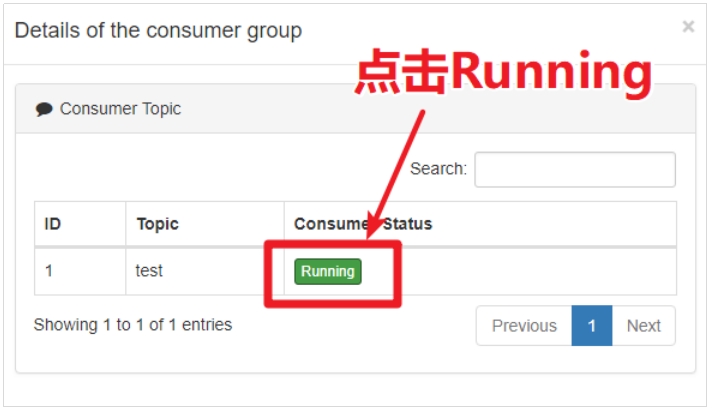

使用Kafka-Eagle查看数据积压情况

按照以下步骤查看分区消费数据的积压情况。

解决数据积压问题

当Kafka出现数据积压问题时,首先要找到数据积压的原因。以下是在企业中出现数据积压的几个类场景。

1.数据写入MySQL失败

某日运维人员找到开发人员,说某个topic的一个分区发生数据积压,这个topic非常重要,而且开始有用户投诉。运维非常紧张,赶紧重启了这台机器。重启之后,还是无济于事。

消费这个topic的代码比较简单,主要就是消费topic数据,然后进行判断在进行数据库操作。运维通过kafka-eagle找到积压的topic,发现该topic的某个分区积压了几十万条的消息。

最后,通过查看日志发现,由于数据写入到MySQL中报错,导致消费分区的offset一自没有提交,所以数据积压严重。

2.因为网络延迟消费失败

基于Kafka开发的系统平稳运行了两个月,突然某天发现某个topic中的消息出现数据积压,大概有几万条消息没有被消费。

通过查看应用程序日志发现,有大量的消费超时失败。后查明原因,因为当天网络抖动,通过查看Kafka的消费者超时配置为50ms,随后,将消费的时间修改为500ms后问题解决。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/笔触狂放9/article/detail/735016

推荐阅读

相关标签