- 1大数据技术原理笔记-考点版_行键查询的缺点

- 2React--》UI组件库ant-design的介绍与使用_ant组件库

- 3使用 Python 和 Matplotlib 绘制科学图表:实例演示_马吕斯定律曲线图

- 4CRC校验码计算,以常用CRC-8为例_crc8算法

- 5NLP的这一年2017:深度学习或成主角_2017nlp

- 6win10+AMD显卡在安装Stable-diffusion-webui-directml报错RuntimeError: Couldn‘t checkout commit xxx for yyy._runtimeerror: couldn't checkout commit for stable

- 7python interpolate_Python:插值interpolate模块

- 8顺丰科技2019秋招测试工程师,Java开发工程师客观题合集_影响web前端页面性能一般不包括下面哪个

- 9PyTorch 1-深度学习

- 10万字长文:读懂微服务编排利器Zeebe_微服务编排引擎对比

免费!GPT-4o发布,实时语音视频丝滑交互_gpt4o支持视频上传吗

赞

踩

We’re announcing GPT-4o, our new flagship model that can reason across audio, vision, and text in real time.

5月14日凌晨,OpenAI召开了春季发布会,发布会上公布了新一代旗舰型生成式人工智能大模型【GPT-4o】,并表示该模型对所有免费用户开放,意味着广大用户将能够通过ChatGPT平台直接体验到OpenAI的最新技术成果,享受前所未有的智能交互体验。

一、三项革新

历次OpenAI发布会都堪称AI界“春晚”,一经开启即刻引爆。本次发布会的主持人是OpenAI 首席技术官(CTO)Muri Murati ,其在一开始便表明今天的发布会共三件事:

- 让先进的AI工具能够免费提供给所有用户,以后OpenAI的产品将以免费为最优先

- 发布ChatGPT的桌面版本及更新的UI界面

- 推出旗舰级生成式人工智能大模型——GPT-4o

我们通常所了解的大模型更新命名都是以【X.X】的形式,然而本次OpenAI创新性的提出一个新的理念,GPT-4o,这个“o”在OpenAI的官网中给出了解答,“o”代表“omni”,在拉丁语中表示“全能的、全知的”,意味着本次GPT-4o是一次全方位的升级。

它能够接受文本、音频和图像的任意组合作为输入,并且能够生成文本、音频和图像的任意组合作为输出。GPT-4o对音频输入的响应速度极快,最短仅需232毫秒,平均响应时间为320毫秒,这与人类在对话中的自然反应时间相似。在英文文本和代码处理上,GPT-4o与GPT-4 Turbo的性能相当,同时在非英文文本处理上取得了显著进步。此外,GPT-4o在API调用速度上更快,成本也降低了50%。特别值得一提的是,GPT-4o在视觉和音频理解方面相比现有模型有显著提升。

Muri Murati的介绍中,GPT-4o 模型的发布是对现有技术的一次重大飞跃,首次将 GPT-4 级别的智能普及到所有用户,包括免费用户。

据其所说,目前全世界有超过一亿位用户使用ChatGPT来创造、工作和学习。然而到目前为止,仅有付费用户能够体验到这些先进的功能。但是升级后的4.0有足够的能力将这些功能提供给每一位用户。GPT-4o 的文本和图像功能今天开始免费在 ChatGPT 中推出,并向 Plus 用户提供高达 5 倍的消息上限。

除此之外,GPT-4o是一个多模态大模型,它代表了OpenAI在文本、视觉和音频领域端到端训练新模型的一次重大进展。这一创新意味着所有类型的输入和输出——无论是文本、音频还是图像——都由同一个先进的神经网络统一处理。GPT-4o能够接收任意组合的文本、音频和图像作为输入,并据此生成任意组合的文本、音频和图像作为输出,从而实现更加灵活和高效的交互体验。

二、现场演示

在发布会现场,OpenAI的工程师Mark Chen为我们演示了几个主要的能力。其中重点则是实时语音对话功能。

Mark Chen表示:“我正在进行现场演示,但我感到有点紧张。你能帮我稍微平静一下神经吗?”

ChatGPT说:“深呼吸,记住你是个专家”

好的,Mark Chen深呼吸

ChatGPT立马表示:“慢点!你不是个吸尘器”

在现场演示中可以看出,用户现在可以随时与模型互动,无需等待,且可通过按钮即时操作。模型提供实时反馈,避免了以往对话中的延迟。此外,它还能感知用户情绪,如在用户紧张时提醒冷静,并能以多样的情感风格生成声音,展现出宽广的动态表现力。

关于语音交流,OpenAI的官网还发布了1个5分钟的详细演示视频,感兴趣的可以自行前往观看那。

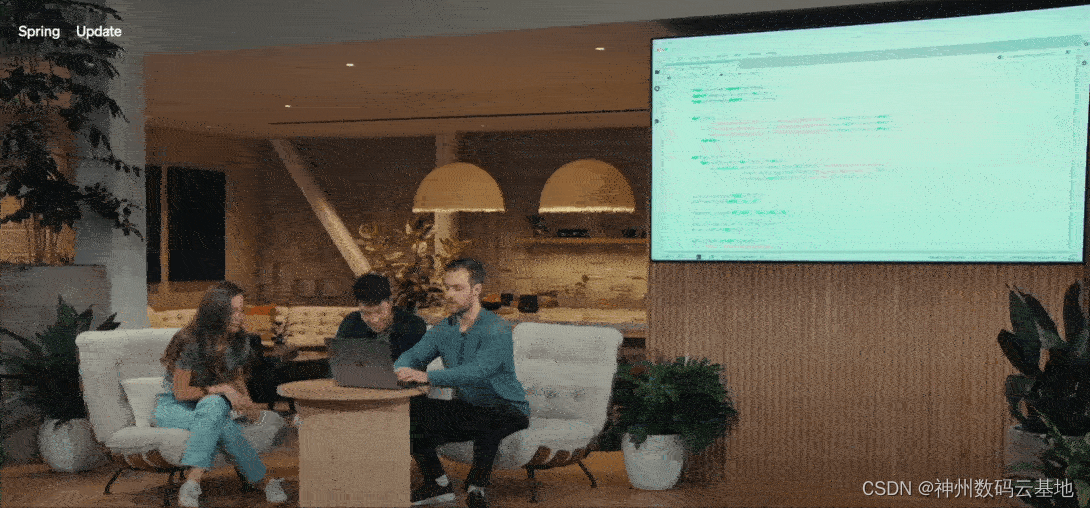

此外,另一位工程师Barrett Zoph现场为我们演示了GPT-4o的视觉功能,使用者可以用视频与其进行互动。

Barrett和GPT打了个招呼后说:“需要你帮忙解决一道数学题,我在纸上写一个方程”

GPT回答:“当然可以”

Barrett:“我希望你能帮助我度过难关。但重要的是,不要告诉我解决方案,只需在途中帮助给我提示”

【此时,Barrett打开了与GPT的视频,同时书写题目】

Barrett:“我写的是什么方程?”

GPT马上做出回应:“好的,我看到你写下了3x+1=4”

Barrett:“那么第一步应该采取什么步骤来尝试解决问题?”

GPT:"第一步是获取一边是X,另一边是常量的所有项。那你认为我们应该怎么做?加1?“

在GPT的指导中,Barrett一步步写下了该题目的解题步骤。

接下来尝试 GPT-4o 的代码能力。这有一些代码,打开电脑里桌面版的 ChatGPT 用语音和它交互,让它解释一下代码是用来做什么的,某个函数是在做什么,ChatGPT 都对答如流。

输出代码的结果,是一个温度曲线图,让 ChatGPT 以一句话的方式回应所有有关此图的问题。

"此代码获取特定位置和时间段的每日天气数据,使用滚动平均值平滑温度数据,在生成的图表上注释重要的天气事件,然后显示全年平均、最低和最高温度的图表。"

甚至在发布会的最后,Muri Murati选取了现场观众给出的演示建议,为大家演示实时翻译功能以及根据照片来判断情绪等等。

Barrett:“我要给你看一张我的自拍照,然后我想让你试着看看我根据自己的外表感受到了什么情绪”

【Barrett打开视频功能,将自己的表情给GPT看】

GPT:“看起来你感到非常开心和愉快,带着灿烂的微笑,甚至可能有点兴奋“

三、GPT-4o模型评估

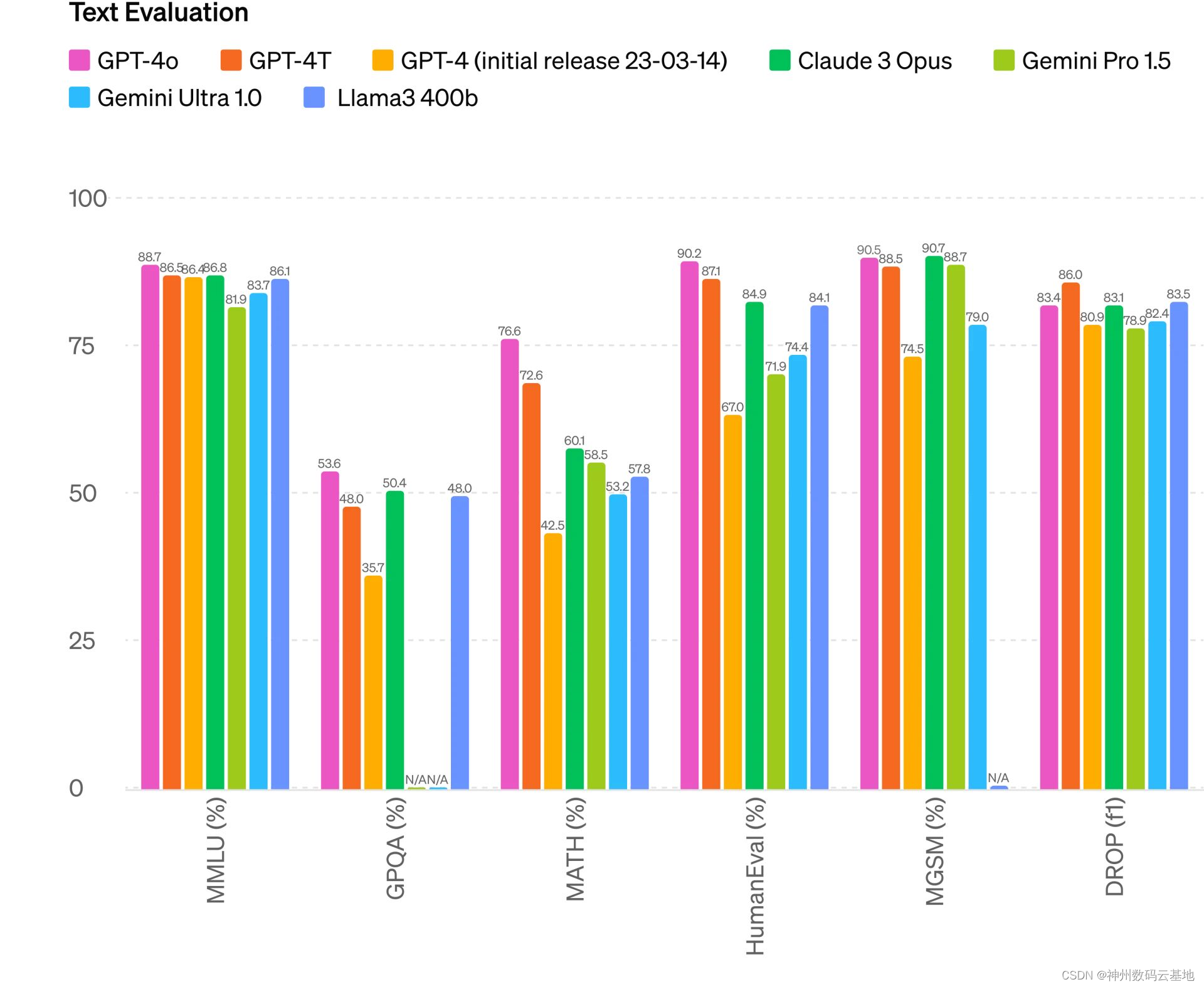

相比于以往ChatGPT新版本发布后给出的研究论文和技术报告,本次OpenAI并未放出任何研究报告,而是转为在官网中放出了本次的升级以及模型评估对比。按照传统基准测试,GPT-4o 在文本、推理和编码智能方面实现了 GPT-4 Turbo 级别的性能,同时在多语言、音频和视觉能力方面创下了新的高水位线。

- 文本评估

GPT-4o在0-shot COT MMLU测试中以88.7%的准确率刷新了常识性问题解答的新高。这些评估结果都是利用我们新开发的简易评估库获得的。同时,在传统的5次训练(5-shot)无COT的MMLU测试中,GPT-4o也以87.2%的准确率创下了新记录。

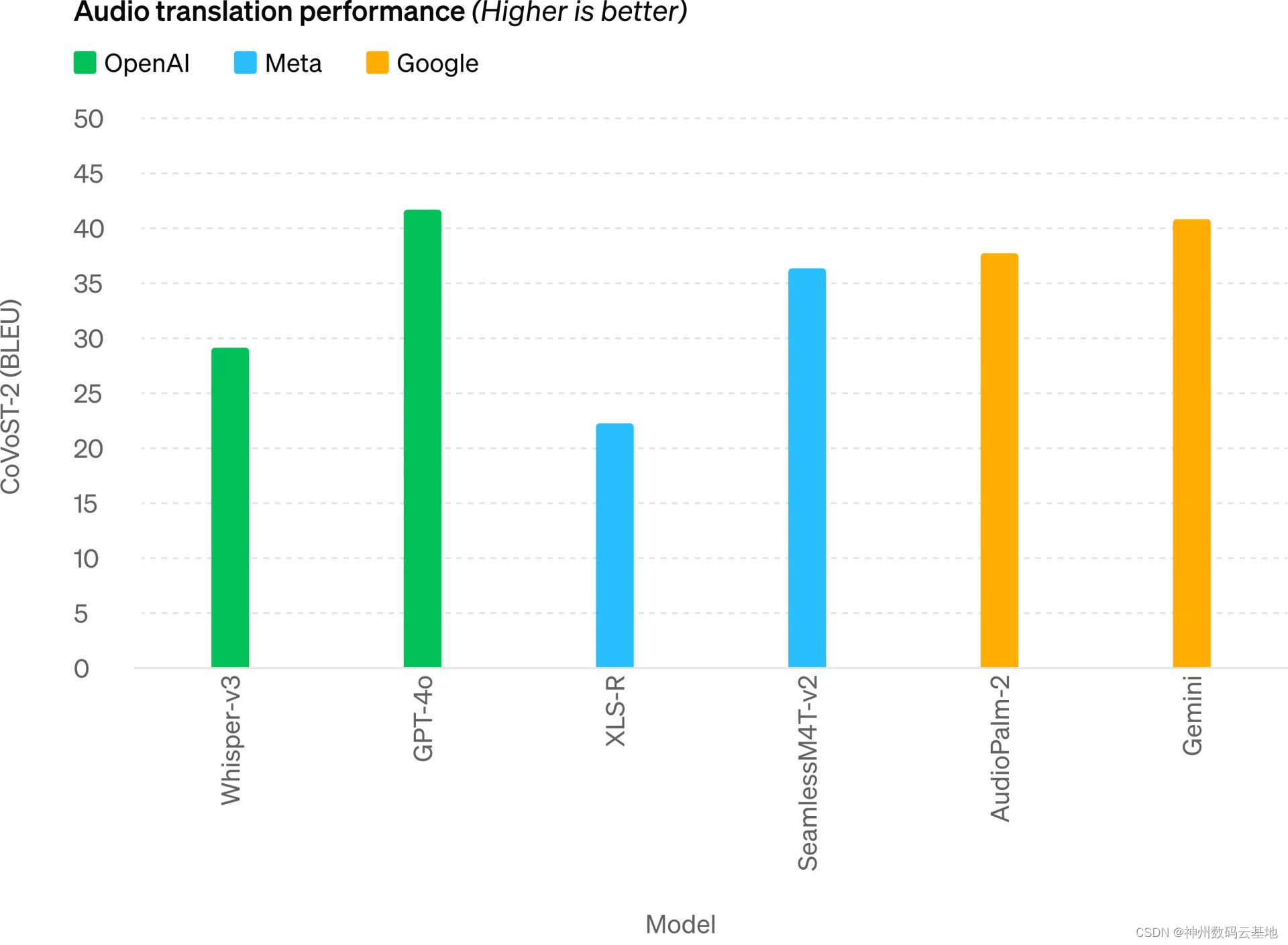

- 音频翻译性能

在音频翻译性能上,GPT-4o 在语音翻译方面创下了新的领先地位,并在 MLS 基准测试中优于 Whisper-v3。同时也超越了另一位竞争对手谷歌旗下的Gemini。

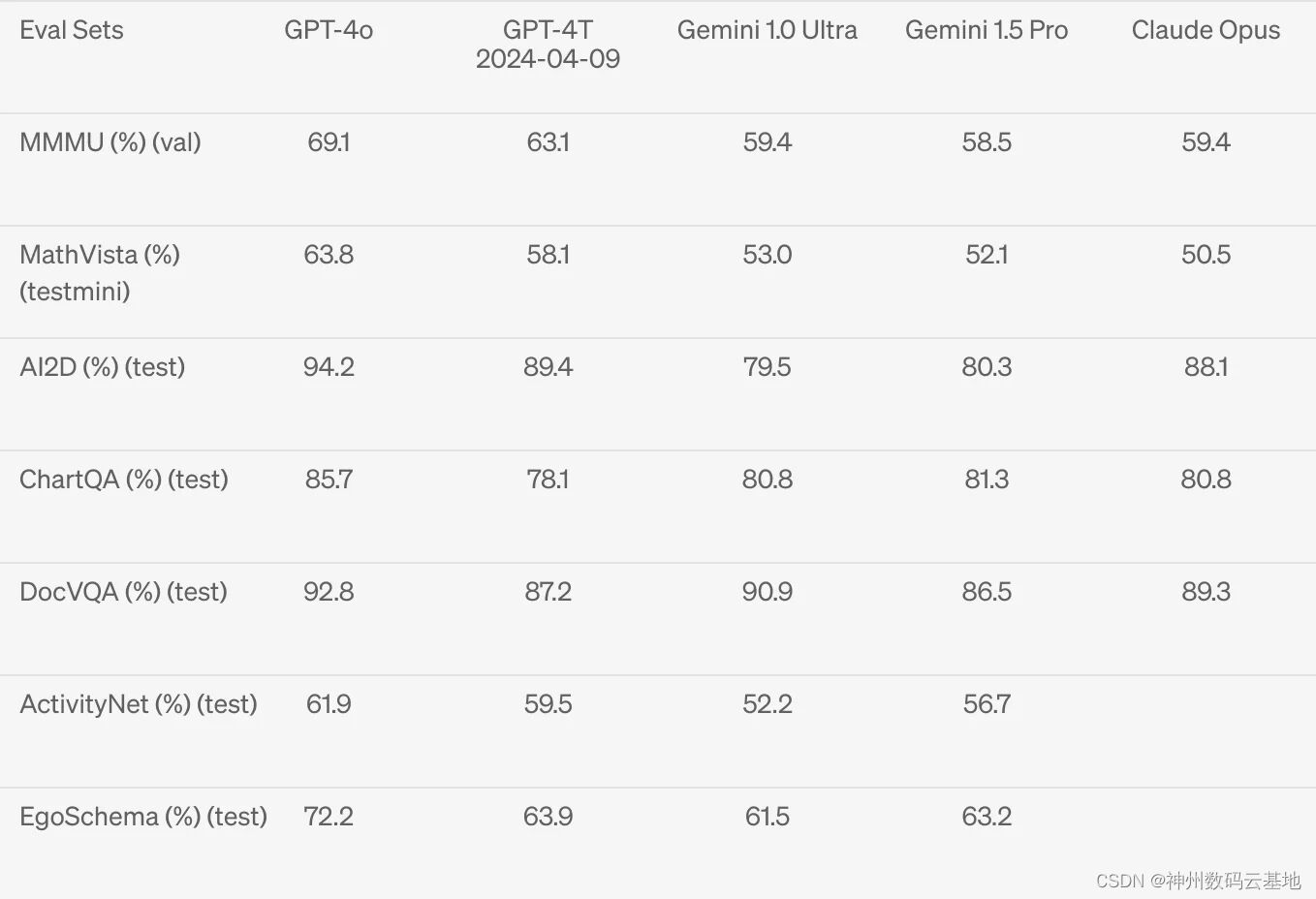

- 视觉理解评估

在视觉理解上,也实现对Gemini 1.0 Ultra与对家Claude Opus的超越