- 1vscode-合并分支代码_vscode 合并代码

- 2前台文本直接取数据库值doFieldSQL插入SQL

- 3OpenVoice——强大的语音克隆与生成技术_openvoice教程

- 4CodeWave系列:6.CodeWave 智能开发平台 扩展依赖库开发_nasl.ide.version

- 5【vim离线升级---vim 缓冲区错误漏洞】_centos离线升级vim

- 6XSS绕过waf

- 7Python+pandas将Excel文件xls批量转换xlsx(代码全注释)_xls批量转换成xlsx 保留格式

- 8手动添加Git Bash Here到右键菜单_git bush here

- 9黑金AX7Z100 FPGA开发板移植LWIP库(一)PS端_黑金ac7z100c 教程

- 10开发个人Ollama-Chat--1 项目介绍_openui 如何本地部署

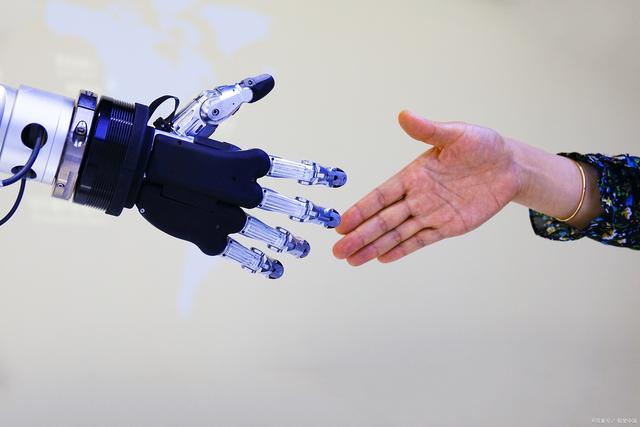

AI发展下的伦理挑战,应当如何应对?

赞

踩

AI发展下的伦理挑战,应当如何应对?

人工智能飞速发展的同时,也逐渐暴露出侵犯数据隐私、制造“信息茧房”等种种伦理风险。随着AI技术在社会各个领域的广泛应用,关于AI伦理和隐私保护问题日趋凸显。尽管国外已出台系列法规来规范AI的使用,保护个人隐私和数据安全,但如用户被区别对待的“大数据杀熟”现象、AI在辅助医疗诊断和就业筛选中表现出的歧视、基于深度伪造技术制作假信息等引发的社会问题仍层出不穷。这些事件引发了公众对于AI决策透明度、算法公平性和个人隐私权的重大关注。面对AI发展下的这些伦理挑战,我们应当如何应对呢?在推动AI技术发展的同时,制定AI治理框架,建立有效的隐私保护机制是当前亟需解决的重要议题。对此你有什么想法?快来参与讨论,分享你的观点吧!

人工智能侵害隐私的后果非常严重,首先人工智能会减少人们独处的机会。关于隐私的基本价值已经有很多的讨论,其中一个反复出现的主题就是隐私有助于创造和保护人们独处的时间和空间。

例如,美国隐私权先驱萨缪尔·沃伦和路易斯·布兰迪斯就在其名作《隐私权》一文中提出,隐私权是人们享受独处的权利。然而,随着人工智能越来越多地参与人们的生活,占据那些本该私密的时间和空间,人们独处的机会将会越来越少。

其次,人工智能会造成信息茧房。信息茧房一词由凯斯·桑斯坦教授提出,主要指人们总是关注自己喜好的东西或接受让自己愉悦的资讯,久而久之就将自己置于“信息茧房”之中。当前,各种人工智能应用都在利用算法推送用户感兴趣的新闻、视频、商品等,人们可以轻易过滤掉自己不熟悉、不认同的信息,只看我们想看的,只听我们想听的,最终在不断重复和自我证成中强化了固有偏见和喜好。

而一旦身处这样的“信息茧房”,人们就再难接受异质化的信息和不同的观点,甚至在不同群体、代际间竖起阻碍沟通的高墙。最后,人工智能可能会造成物质性损害。

与一般的信息科技不同,人工智能侵害隐私不仅会造成严重的精神痛苦,同时由于人工智能具备与现实世界进行物理性交互的能力,进而还可能给人们造成严重的人身和财产损害。实践中,诸如自动驾驶汽车等人工智能产品引发的各种伤亡事故已经屡见不鲜。

传统隐私保护法律的应对及其新发展

传统隐私保护法律的应对通说认为,隐私权的概念起源于美国。1890年,沃伦和布兰迪斯发表了《论隐私权》一文,首次提出了隐私权的概念。此后,隐私权在美国获得了长足的发展,隐私权的内涵也不断丰富起来。起初,隐私权主要被视为是一种“个人独处的权利”,用来保护个体私人生活的安宁,表现为空间隐私。

随后,为保护隐私不受来自公权力的侵害,隐私权被上升为宪法层面的基本权利,与个人自由联系在一起,自决隐私逐渐纳入隐私权的范畴。

与此同时,随着上个世纪60年代互联网技术的发展,通过侵害个人信息来侵害隐私的现象急剧增加,信息隐私成为了隐私保护的重头戏。至此,美国逐渐形成了“大隐私权”的保护模式,即通过不断丰富隐私权的法律保护体系来应对网络时代的个人信息保护问题。

与之相对的是,历史上欧盟各国对于隐私的保护主要通过具体人格权或一般人格权的方式来进行。面对互联网技术提出的挑战,欧盟逐渐形成了“大个人信息”的保护模式,即通过专门的个人信息保护法来应对网络时代的隐私保护问题。

虽然欧美各自应对网络时代隐私保护的法律路径不同,但总体上是殊途同归的,即都将个人信息的保护作为过去三十年隐私保护最为重要的方向。对此,欧美主要是通过践行“公平信息实践原则”来保护网络时代的用户隐私。

在此基础上,以1980年经济合作与发展组织的“OECD指南”、1995年欧盟《数据保护指令》为代表,构成了全球第一代个人信息保护法律框架。归纳来说,第一代个人信息保护法律框架有以下特点:

其一,以“信息自决权”为理论基础,强调用户对个人信息享有自主决定权。

其二,以“用户控制”为制度核心,重视“通知与同意”机制的运用,要求个人信息的处理必须征得用户的同意。

其三,企业、政府机构等组织被设定为数据控制者,承担各项保护职责。