- 1python异步方法asyncio的使用3_task.print_stack()

- 2机器学习和统计学的区别?

- 3vue中文本超出显示省略号最优方案_vue text省略

- 4Mysqldump参数解析大全_mysqldump解析字段

- 5php中函数禁用绕过的原理与利用_ini_set()绕过

- 6springboot集成邮件功能_springboot集成mail

- 7quill编辑器自定义音频、视频、行内style样式(字符边框、首行缩进)_react-quill设置自定义样式

- 8前端项目上线后,浏览器缓存未刷新问题_前端静态页面缓存问题怎么解决

- 9【Unity3d】如何解决在开发中添加了新场景后,需要手工维护BuildSettings中场景列表的问题_unity创建新场景,原场景不见了

- 10【YOLOv8改进-论文笔记】SCConv :即插即用的空间和通道重建卷积

Global Average Pooling对全连接层的可替代性分析(转)_使用了global average pooling(gap)层取代全连接层

赞

踩

版权声明:本文为williamyi原创,未经许可禁止转载或直接挪作他用! https://blog.csdn.net/williamyi96/article/details/77530995

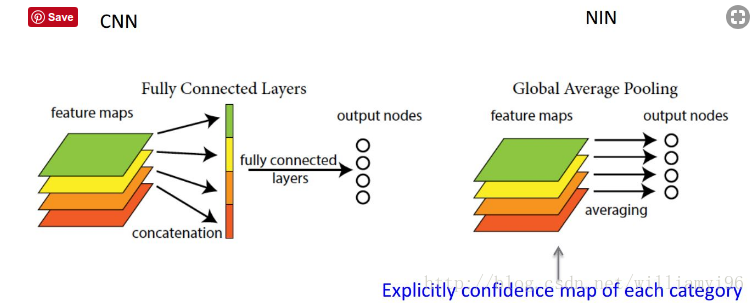

在NIN(Network in Network) 这篇论文中有很多的思想让人受益匪浅,其中之一就是全局平均池化(Global Average Pooling) 对于全连接层的替代性分析。刚开始由于觉得之后的研究不需要NIN,因此就没去看论文,看了一下其他人的博客,发现关于其原因讲得并不清楚,只说是那么用的。后来实在是受不了了,看了看论文,而且找到了一个较好的讲解,现在算是完全弄懂了。

首先我们来看一下全连接层的缺点:

在AlexNet及其之前的大抵上所有的基于神经网络的机器学习算法都要在卷积层之后添加上全连接层来进行特征的向量化,此外出于神经网络黑盒子的考虑,有时设计几个全连接网络还可以提升卷积神经网络的分类性能,一度成为神经网络使用的标配。

但是,我们同时也注意到,全连接层有一个非常致命的弱点就是参数量过大,特别是与最后一个卷积层相连的全连接层。一方面增加了Training以及testing的计算量,降低了速度;另外一方面参数量过大容易过拟合。虽然使用了类似dropout等手段去处理,但是毕竟dropout是hyper-parameter, 不够优美也不好实践。

那么我们有没有办法将其替代呢?当然有,就是GAP(Global Average Pooling)。

我们要明确以下,全连接层将卷积层展开成向量之后不还是要针对每个feature map进行分类吗,GAP的思路就是将上述两个过程合二为一,一起做了。如图所示:

由此就可以比较直观地说明了。这两者合二为一的过程我们可以探索到GAP的真正意义是:对整个网路在结构上做正则化防止过拟合。其直接剔除了全连接层中黑箱的特征,直接赋予了每个channel实际的内别意义。

实践证明其效果还是比较可观的,同时GAP可以实现任意图像大小的输入。但是值得我们注意的是,使用gap可能会造成收敛速度减慢。