- 1鸿蒙(API 12 Beta2版)媒体开发【Audio Kit简介】音频服务

- 2六十五、Spark-综合案例(搜狗搜索日志分析)_spark搜狗搜索引擎日志下载

- 3mysql的锁_mysql加行级写锁后,其他事务还能读取相应行的数据

- 4Caused by: java.lang.IllegalArgumentException: Unsupported class file major version 61

- 5损失函数总结(二):L1Loss、MSELoss_l1损失函数表达式

- 6https,udp,socket区别_sslsocket和socket区别

- 7Python Qt GUI设计:QTabWidget、QStackedWidget和QDockWidget容器控件类(提升篇—2)_python qtabwidget

- 8Big Data Tools安装_hadoop.dll下载

- 9关闭iis 错误页面显示详细内容

- 10【雕爷学编程】Arduino智能家居之图像识别并执行相应控制操作_arduino视觉识别

本地部署Ollama+qwen本地大语言模型Web交互界面_[apps.ollama.main] connection error: cannot connec

赞

踩

什么是 Ollama WebUI?

Ollama WebUI 已经更名为 Open WebUI. Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 WebUI,旨在完全离线操作。它支持各种 LLM 运行程序,包括 Ollama 和 OpenAI 兼容的 API。

Ollama WebUI 是一个革命性的 LLM 本地部署框架,具有类似 ChatGPT 的 Web 界面。让我们为您的 Ollama 部署的 LLM 提供类似 ChatGPT Web UI 的界面,只需按照以下 5 个步骤开始行动吧。

除了webui,还有其他优秀的ui如下:

五个优秀的免费 Ollama WebUI 客户端推荐 · LobeHub

安装和使用 Ollama Web UI 的 5 个步骤

在 Windows 计算机上深入研究 Ollama 和 Ollama WebUI 是进入人工智能和机器学习世界的激动人心的旅程。本详细指南将引导您完成每个步骤并提供示例以确保顺利启动。

第 1 步 - 安装 Ollama

Ollama下载地址:https://ollama.com/download

可以从以下网站查看安装方法,我是选择linux安装版本。

第 2 步 - 安装 Ollama WebUI

运行以下 docker 命令以在本地计算机上部署 llama-webui docker 容器。如果您的计算机上有 Ollama,请使用以下命令:

docker run -d -p 1158

第 3 步 - 登录打开 WebUI

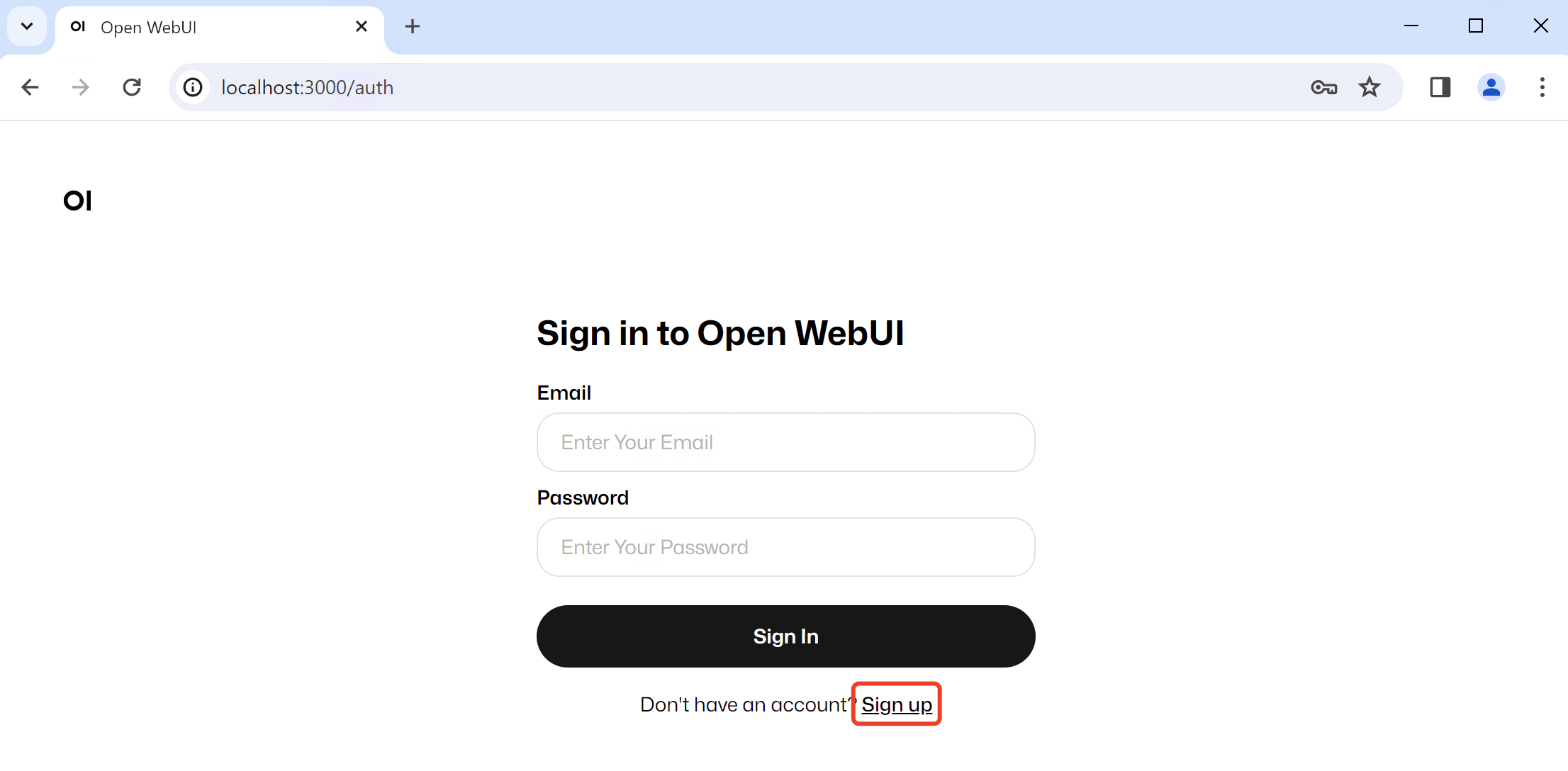

安装完成后,您可以通过http://localhost:1158访问Open WebUI。第一次您需要点击“注册”进行注册。

:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

要连接到另一台服务器上的 Ollama,请将 OLLAMA_BASE_URL 更改为服务器的 URL。因此,如果 Ollama 在不同的服务器上,请使用以下命令:

- docker run -d -p 1158:8080 \

- -e OLLAMA_BASE_URL=http://192.168.0.1:11434 \

- -v open-webui:/app/backend/data \

- --name open-webui \

- --restart always

- ghcr.io/open-webui/open-webui:main

docker run: 启动一个新的 Docker 容器。-d: 以守护进程模式运行容器,容器将在后台运行。-p 3000:8080: 将本地机器的端口 3000 映射到容器内的端口 8080。这意味着你可以通过访问http://localhost:3000来访问运行在容器内的服务。--add-host=host.docker.internal:host-gateway: 将主机名host.docker.internal映射到 Docker 网关。这对于在容器内访问主机服务很有用。-v open-webui:/app/backend/data: 将本地的open-webui卷映射到容器内的/app/backend/data目录。这用于持久化数据,确保即使容器停止或重新启动,数据也不会丢失。--name open-webui: 为容器指定一个名称open-webui,以便于管理和识别。--restart always: 设置容器的重启策略为always,这意味着容器如果停止(例如由于崩溃或系统重启),Docker 会自动重启它。ghcr.io/open-webui/open-webui:main: 使用来自 GitHub 容器注册表(GitHub Container Registry)的open-webui镜像,并指定使用main标签的版本。

注意:使用 Docker 安装 Open WebUI 时,请确保在 Docker 命令中包含 -v open-webui:/app/backend/data。此步骤至关重要,因为它确保您的数据库正确安装并防止任何数据丢失。

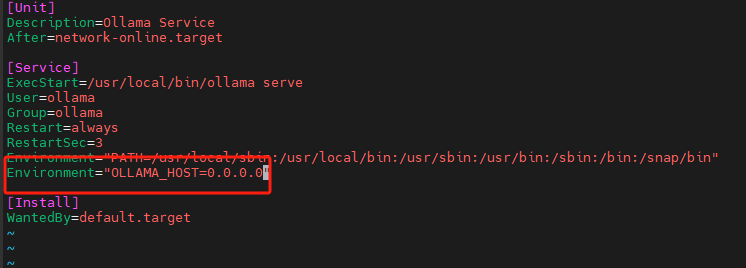

open-webui无法链接ollama 报错ERROR:apps.ollama.main:Connection error: Cannot connect

解决办法:修改启动配置, 默认ollama绑定在127.0.0.1的11434端口,修改/etc/systemd/system/ollama.service,在[Service]下添加如下内容,使ollama绑定到0.0.0.0的11434端口

Environment="OLLAMA_HOST=0.0.0.0"

sudo systemctl daemon-reload

sudo systemctl restart ollama

第 3 步 - 登录打开 WebUI

安装完成后,您可以通过http://localhost:3000访问Open WebUI。第一次您需要点击“注册”进行注册。