- 1新魔百和M301H_关于CW代工_JL(南传)代工_zn及sm代工区分及鸿蒙架构全网通卡刷包刷机教程_m301h刷机

- 2ajax请求报parsererror错误_ajax parsererror是什么错误

- 3云端技术驾驭DAY15——ClusterIP服务、Ingress服务、Dashboard插件、k8s角色的认证与授权

- 4kubeCon2020重磅演讲:基于k8s构建新一代私有云和容器云_captain k8s

- 5HTML+CSS:3D轮播卡片

- 6Python+医学院校二手书管理 毕业设计-附源码201704_基于python的校园二手交易平台论文开题报告

- 7python函数递归求和详解_Python函数中多类型传值和冗余参数及函数的递归调用

- 8【毕业设计】ASP.NET 网上选课系统的设计与实现(源代码+论文)_aspnet毕业设计含代码

- 9Stable Diffusion提示词总结_stable diffusion 提示词详解

- 10玩转k8s:Pod详解_k8s pod配置文件查看

AIGC - Qwen大模型:Qwen-7B模型推理部署_部署qwen7b

赞

踩

硬件环境

作为AIGC方面的小白来说,我抱着非常天真的想法,想让它在我的工作笔记本上用i5的CPU去跑,至于为什么这么想,当然是因为我没有GPU,身边也没有其他的带显卡电脑

恰好,在腾讯云看到了GN7的显示优惠活动,60块钱15天,Nvidia T4的AI卡,直接斥巨资购买了15天;不过这段时间准备搭一台自己用的服务器,初步计划是可以插4块GPU,内存上到200G,还是用DeepSpeed做下全量训练啥的。

软件环境

腾讯云的服务器,我选择了自己常用ubuntu镜像,同时此模型都是基于python语言,pytorch框架训练的模型,为了便于管理python版本库,使用anaconda来管理。

具体软件环境版本如下:

conda 4.8.2

python 3.9

pytorch2.0.1

cuda 11.7

具体的软件环境搭建过程,另起一篇去记录

模型部署使用

克隆github库:git clone https://github.com/QwenLM/Qwen.git

pip install -r requirements.txt

安装时,与其他模型要求的transformers库版本冲突,由于选择的conda环境不对,切换到之前创建的langchain环境 conda acitivate langchain

此环境最大GPU显存为16GB,但跑7B模型的FP16需要20几个G,所以这里跑量化后的模型INT4版本的

运行cli_demo.py

python cli_demo.py

此DEMO还融合了使用GPT回答相关问题,所以需要安装GPT相应依赖库

pip install optimum auto-gptq

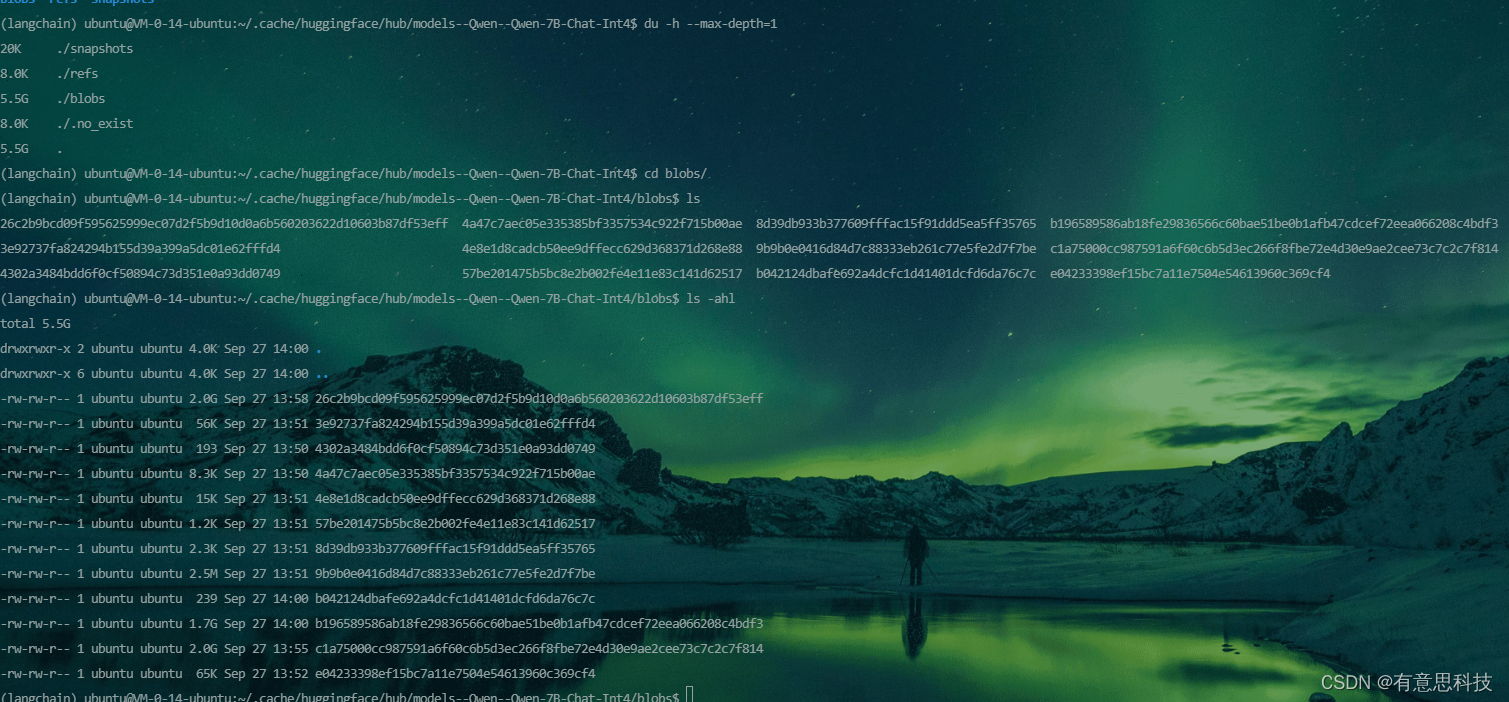

通过此方式从huggingface下载的模型文件会以缓存的形式存放在如下目录