- 1springboot + dubbo + nacos + seata 快速集成_spring boot 整合seata saga模式

- 2使用最近未使用页淘汰(NRU)算法模拟实现页淘汰进程 _nru算法

- 3内网穿透的应用-使用Docker本地部署可编辑导航页结合内网穿透实现远程访问

- 4本届挑战赛冠军方案:基于LLM的多场景智能运维

- 5动态库和PIC-位置无关代码_static pic模式

- 6Python | 使用turtle库绘制太阳花_使用turtle模块绘制一个太阳花

- 7vue登录页面cookie的使用及页面跳转_vue 新窗口打开外部链接,改变给新窗口的cookie

- 8【Android +Tensroflow Lite】实现从基于机器学习语音中识别指令讲解及实战(超详细 附源码和演示视频)_tensorflow部署到安卓移动端进行语音识别

- 9linux常用命令_在root目录下,创建文件夹

- 102023华为od机试C卷【内存冷热标记】Java 实现

人工智能(pytorch)搭建模型16-基于LSTM+CNN模型的高血压预测的应用_lstm模型结合哪种模型能提高准确率

赞

踩

大家好,我是微学AI,今天给大家介绍一下人工智能(pytorch)搭建模型16-基于LSTM+CNN模型的高血压预测的应用,LSTM+CNN模型搭建与训练,本项目将利用pytorch搭建LSTM+CNN模型,涉及项目:高血压预测,高血压是一种常见的性疾病,早期预测和干预对于防止其发展至严重疾病至关重要。

目录

- 项目背景

- LSTM-CNN模型原理

- 数据样例

- 数据加载

- 模型搭建

- 模型训练

- 模型预测

- 总结

1. 项目背景

高血压是全球面临的一项紧迫的公共卫生挑战,它被认为是全球疾病预防负担最重的因素之一,同时也是心血管疾病的主要风险因素。及时、定期地监测血压对于早期诊断和预防心血管疾病至关重要。人体的血压通常会随着时间的推移而波动,并受到多种因素的影响,如压力、情绪、饮食、运动和药物使用等。因此,进行持续监测而非仅在特定时间点监测血压,对于早期发现和治疗高血压具有重要意义。本项目采用深度学习中的LSTM-CNN模型,通过学习患者的历史健康数据,进行高血压的预测。

2. LSTM-CNN模型原理

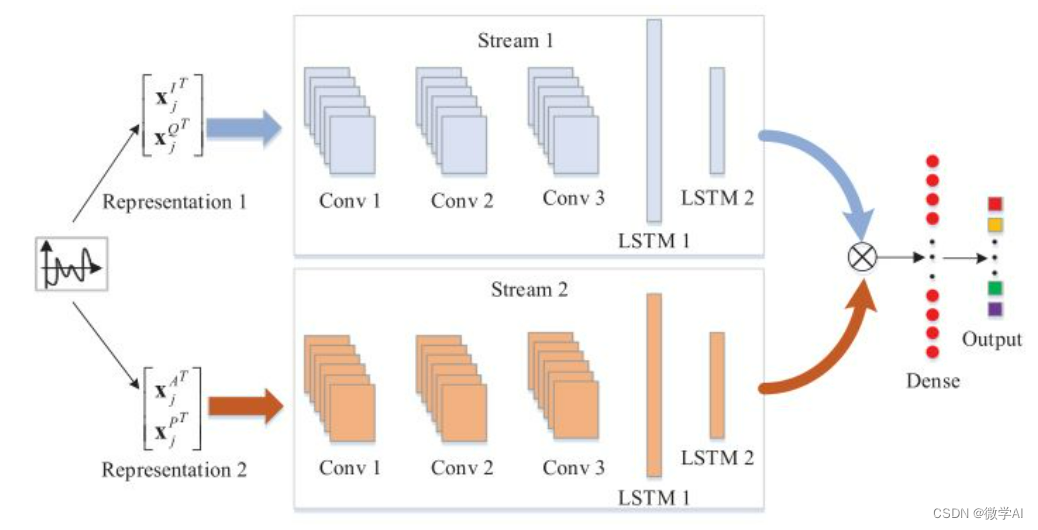

LSTM-CNN模型是一种混合模型,结合了长短期记忆网络(LSTM)和卷积神经网络(CNN)的优点。LSTM能够处理时序数据,学习长期依赖关系;而CNN则能够从局部特征中提取有用信息。在高血压预测中,LSTM用于学习患者的历史健康数据中的时间依赖关系,而CNN则用于从这些数据中提取有用的特征。

LSTM-CNN模型是一种结合了长短期记忆(Long Short-Term Memory,LSTM)和卷积神经网络(Convolutional Neural Network,CNN)的混合模型。其数学原理可以通过以下方式表示:

首先,我们定义输入序列为 X = { x 1 , x 2 , . . . , x T } \mathbf{X} = \{x_1, x_2, ..., x_T\} X={x1,x2,...,xT},其中 T T T 是序列的长度。在LSTM中,每个时间步的隐藏状态由记忆单元(cell) c t \mathbf{c}_t ct 和输出状态 h t \mathbf{h}_t ht 组成。

LSTM层的计算过程如下:

-

输入门(Input Gate):通过计算输入门向量 i t \mathbf{i}_t it 来控制当前时间步输入的影响。计算方式如下:

i t = σ ( W i x t + U i h t − 1 + b i ) \mathbf{i}_t = \sigma(\mathbf{W}_i\mathbf{x}_t + \mathbf{U}_i\mathbf{h}_{t-1} + \mathbf{b}_i) it=σ(Wixt+Uiht−1+bi)

其中, W i \mathbf{W}_i Wi、 U i \mathbf{U}_i Ui 和 b i \mathbf{b}_i bi 是可学习的参数, σ \sigma σ 是sigmoid函数。 -

遗忘门(Forget Gate):通过计算遗忘门向量 f t \mathbf{f}_t ft 来控制之前记忆的保留程度。计算方式如下:

f t = σ ( W f x t + U f h t − 1 + b f ) \mathbf{f}_t = \sigma(\mathbf{W}_f\mathbf{x}_t + \mathbf{U}_f\mathbf{h}_{t-1} + \mathbf{b}_f) ft=σ(Wfxt+Ufht−1+bf)

其中, W f \mathbf{W}_f Wf、 U f \mathbf{U}_f Uf 和 b f \mathbf{b}_f bf 是可学习的参数。 -

记忆更新(Memory Update):通过计算新的记忆单元 c t \mathbf{c}_t ct 来更新记忆。计算方式如下:

c t = f t ⊙ c t − 1 + i t ⊙ tanh ( W c x t + U c h t − 1 + b c ) \mathbf{c}_t = \mathbf{f}_t \odot \mathbf{c}_{t-1} + \mathbf{i}_t \odot \tanh(\mathbf{W}_c\mathbf{x}_t + \mathbf{U}_c\mathbf{h}_{t-1} + \mathbf{b}_c) ct=ft⊙ct−1+it⊙tanh(Wcxt+Ucht−1+bc)

其中, W c \mathbf{W}_c Wc、 U c \mathbf{U}_c Uc 和 b c \mathbf{b}_c bc 是可学习的参数, ⊙ \odot ⊙ 表示逐元素相乘。 -

输出门(Output Gate):通过计算输出门向量 o t \mathbf{o}_t ot 来控制当前时间步输出的影响。计算方式如下:

o t = σ ( W o x t + U o h t − 1 + b o ) \mathbf{o}_t = \sigma(\mathbf{W}_o\mathbf{x}_t + \mathbf{U}_o\mathbf{h}_{t-1} + \mathbf{b}_o) ot=σ(Woxt+Uoht−1+bo)

其中, W o \mathbf{W}_o Wo、 U o \mathbf{U}_o Uo 和 b o \mathbf{b}_o bo 是可学习的参数。

最后,LSTM的输出状态

h

t

\mathbf{h}_t

ht 和记忆单元

c

t

\mathbf{c}_t

ct 可以通过以下方式计算:

h

t

=

o

t

⊙

tanh

(

c

t

)

\mathbf{h}_t = \mathbf{o}_t \odot \tanh(\mathbf{c}_t)

ht=ot⊙tanh(ct)

接下来,将LSTM层的输出状态作为CNN的输入,进行卷积和池化等操作,然后通过全连接层进行最终的预测或分类。

LSTM层结果输入CNN的过程:

将LSTM层的输出状态作为CNN的输入时,通常会对输出状态进行重塑(reshape),以适应CNN的输入格式要求。具体的处理方式如下所示:

-

首先,假设LSTM层的输出状态形状为 ( B , T , H ) (B, T, H) (B,T,H),其中 B B B 表示批次大小(batch size), T T T 表示序列长度, H H H 表示隐藏状态维度。

-

接着,将输出状态进行重塑,使其形状变为 ( B × T , H ) (B \times T, H) (B×T,H)。这一步操作可以将 LSTM 输出的所有时间步连接起来,得到一个二维的矩阵,其中每行表示一个时间步的隐藏状态。

-

然后,将重塑后的输出状态作为输入传递给CNN模型。

-

在CNN模型中,通常会使用卷积层进行特征提取。卷积层通过定义卷积核的数目、大小和步长等参数来提取局部特征。

-

接下来,常见的操作是使用池化层对卷积层的输出进行下采样,以减少特征的维度和数量。池化可以通过取最大值(最大池化)或计算平均值(平均池化)等方式实现。

-

最后,经过池化层之后,可以将得到的特征向量输入到全连接层进行最终的预测或分类等任务。

3. 数据样例

以下是一些中文时序高血压csv数据样例:

id,年龄,性别,体重,身高,收缩压,舒张压,心率,血糖,血脂,是否高血压

1,45,男,75,175,120,80,70,5.6,1.2,否

2,50,男,80,180,130,85,72,6.0,1.3,是

3,55,女,65,165,110,70,68,52,1.1,否

4,35,女,60,160,110,70,75,4.8,1.0,否

5,42,男,78,173,125,82,68,5.2,1.1,是

6,58,男,85,177,140,90,80,6.5,1.4,是

7,47,女,62,165,115,75,72,5.3,1.2,否

8,52,男,79,179,128,84,70,5.9,1.3,是

9,43,女,66,162,112,73,70,5.5,1.1,否

10,50,男,83,176,125,82,75,6.2,1.2,是

11,37,女,64,163,110,70,68,5.0,1.0,否

12,49,男,76,178,130,85,72,5.8,1.2,是

13,57,男,88,183,145,92,80,6.8,1.5,是

14,41,女,63,164,112,73,70,5.4,1.1,否

15,55,男,82,175,127,83,75,6.1,1.3,是

16,38,女,61,158,108,68,67,4.9,1.0,否

17,53,男,80,181,132,87,74,6.0,1.4,是

18,46,女,67,167,114,75,72,5.1,1.2,否

19,48,男,77,180,128,84,70,5.7,1.2,是

20,60,男,90,185,150,95,78,7.0,1.6,是

21,39,女,59,156,106,66,65,4.7,0.9,否

22,54,男,81,178,130,85,72,6.0,1.3,是

23,44,女,68,168,115,76,73,5.2,1.1,否

...

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

4. 数据加载

我们使用pandas库来加载csv数据:

import pandas as pd

# 加载数据

data = pd.read_csv('hypertension.csv')

# 数据预处理

data['性别'] = data['性别'].map({'男': 0, '女': 1})

data['是否高血压'] = data['是否高血压'].map({'否': 0, '是': 1})

# 分割训练集和测试集

train_data = data.sample(frac=0.8, random_state=0)

test_data = data.drop(train_data.index)

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

5. 模型搭建

我们使用PyTorch来搭建LSTM-CNN模型:

import torch

import torch.nn as nn

class LSTM_CNN(nn.Module):

def __init__(self):

super(LSTM_CNN, self).__init__()

self.lstm = nn.LSTM(input_size=10, hidden_size=64, num_layers=2, batch_first=True)

self.conv1 = nn.Conv1d(in_channels=64, out_channels=128, kernel_size=1)

self.fc = nn.Linear(128, 2)

def forward(self, x):

x,_ = self.lstm(x)

x = x.transpose(1, 0)

x = self.conv1(x)

x = x.transpose(1, 0)

x = x.view(x.size(0), -1)

x = self.fc(x)

return x

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

6. 模型训练

我们使用Adam优化器和交叉熵损失函数进行模型训练:

# 模型训练

model = LSTM_CNN()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

criterion = nn.CrossEntropyLoss()

for epoch in range(100):

inputs = torch.tensor(train_data.drop('是否高血压', axis=1).values).float()

labels = torch.tensor(train_data['是否高血压'].values).long()

outputs = model(inputs)

loss = criterion(outputs, labels)

optimizer.zero_grad()

loss.backward()

optimizer.step()

print('Epoch [%d/100], Loss: %.4f' %(epoch+1, loss.item()))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

运行结果:

Epoch [72/100], Loss: 0.0001

Epoch [73/100], Loss: 0.0001

Epoch [74/100], Loss: 0.0001

Epoch [75/100], Loss: 0.0001

Epoch [76/100], Loss: 0.0001

Epoch [77/100], Loss: 0.0001

Epoch [78/100], Loss: 0.0001

Epoch [79/100], Loss: 0.0001

Epoch [80/100], Loss: 0.0001

Epoch [81/100], Loss: 0.0001

Epoch [82/100], Loss: 0.0001

Epoch [83/100], Loss: 0.0001

Epoch [84/100], Loss: 0.0001

...

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

7. 模型预测

训练完成后,我们可以输入数据进行预测:

# 模型预测

inputs = torch.tensor(test_data.drop('是否高血压', axis=1).values).float()

outputs = model(inputs)

_, predicted = torch.max(outputs.data, 1)

print('Predicted: ', predicted)

- 1

- 2

- 3

- 4

- 5

运行结果:

[[ 1. 45. 0. 75. 175. 120. 80. 70. 5.6 1.2]

[ 4. 35. 1. 60. 160. 110. 70. 75. 4.8 1. ]

[ 13. 57. 0. 88. 183. 145. 92. 80. 6.8 1.5]

[ 16. 38. 1. 61. 158. 108. 68. 67. 4.9 1. ]]

Predicted: tensor([0, 0, 1, 0])

- 1

- 2

- 3

- 4

- 5

8. 总结

本项目基于LSTM-CNN模型,通过学习患者的历史健康数据,实现了高血压的预测。这种方法具有较高的预测准确性,对于高血压的早期预测和干预具有重要意义。

LSTM-CNN模型的几个主要的应用领域:

文本分类:LSTM-CNN模型可以用于文本分类任务,例如情感分析、垃圾邮件过滤、新闻分类等。LSTM层能够捕捉序列中长距离依赖关系,而CNN层则能提取局部特征,两者结合可以更好地表示文本信息。

命名实体识别(Named Entity Recognition,NER):LSTM-CNN模型在NER任务中表现出色。LSTM层可以学习上下文信息和实体之间的依赖关系,而CNN层可以捕捉实体的局部特征,从而提高命名实体的识别准确率。

机器翻译:LSTM-CNN模型可以应用于机器翻译任务,将一种语言的文本转换为另一种语言。LSTM层可以处理输入序列和输出序列之间的长距离依赖关系,而CNN层可以提取局部特征,有助于改善翻译质量。

句子生成:LSTM-CNN模型可以用于生成句子、段落或对话等自然语言文本。通过训练模型,结合LSTM的生成能力和CNN的提取特征能力,可以生成具有上下文连贯性和语法正确性的文本。