热门标签

热门文章

- 1Windows本地部署ChatGLM3-6B模型_chatglm3-6b 下载

- 2Spring Boot 框架使用指南_springboot框架使用

- 3基于OpenAI实现的个人助理

- 4Android开发规范

- 5Jprofiler安装及使用教程_jprofiler使用教程

- 6魔百盒CM211-1-CH-S905L3B-UWE5621DS-开启ROOT-当贝桌面线刷固件包_魔百盒cm211-1刷机包

- 722.SELECT基本查询

- 8Kali Linux网络攻击_在同一个网络下怎么ip攻击啊

- 9超详细labelme批量处理json文件,json_to_dataset方法_labelme批处理json文件

- 10Linux中mysql的安装、远程访问、基础操作、文件导入

当前位置: article > 正文

flash-attn windows环境安装踩坑日记_windows flash_attn安装

作者:繁依Fanyi0 | 2024-03-20 03:28:14

赞

踩

windows flash_attn安装

flash-attn python包是对Flash attention的开源实现。Flash attention是一种具有IO-Awareness的快速和内存效率的精确注意力,具体信息参考:FlashAttention: 具有IO-Awareness的快速和内存效率的精确注意力 - 知乎

论文:https://arxiv.org/abs/2205.14135

因为官方发布的wheel是linux版的,所以在windows环境下安装时需要编译源码。编译源码过程非常慢,耗时很长且易于出错。尝试若干次,遇到各种疑难杂症后放弃。网上找到了有大牛编译好的windows版,下载地址:https://github.com/bdashore3/flash-attention/releases。这里有四个候选项:

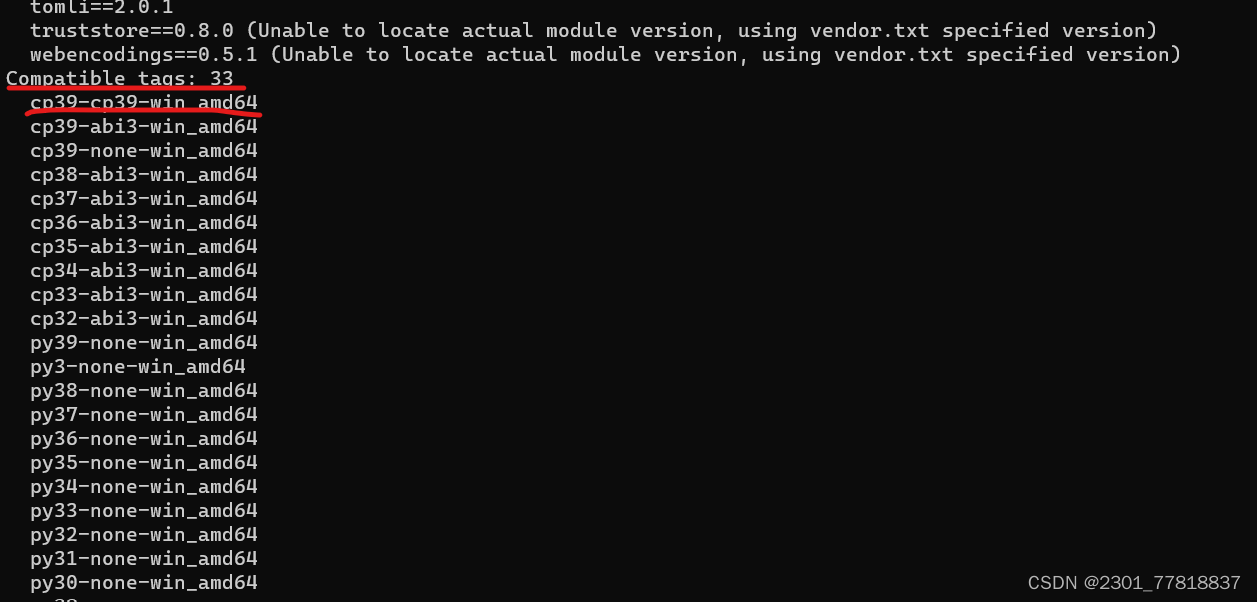

这里注意,需要安装PyTorch2.1.x和cuda 12.x。具体选择哪个下载,需要先运行pip debug --verbose,根据输出里面的Compatible tags来选择兼容的wheel文件。

下载相应的wheel文件并安装:pip install "flash_attn-2.4.1+cu121torch2.1cxx11abiFALSE-cp39-cp39-win_amd64.whl"

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/270347

推荐阅读

相关标签