SLAM学习笔记——(一)SLAM分类

赞

踩

SLAM( Simultaneous Localization and Mapping)是指同步定位与地图构建。定位和建图两个问题相互依赖,准确的定位依赖于正确的地图,而构建正确的地图又需要准确的定位,这是一个迭代的过程。

目前的SLAM根据硬件设备的不同主要有两种:

1.基于激光雷达的SLAM

基于激光雷达构建场景是古老并且可信的方法,激光雷达也是精确场景使用最多的SLAM传感器。它们提供机器人本体与周围环境障碍物间的距离信息。常见的激光雷达,例如SICK、Velodyne还有我们国产的rplidar等,都可以拿来做SLAM,但总体来说激光雷达的价格都是非常昂贵。激光雷达能以很高精度测出机器人周围障碍点的角度和距离,从而很方便地实现SLAM、避障等功能。

2.基于视觉的SLAM

基于视觉的SLAM主要是通过摄像头采集来的数据进行同步定位与地图构建。相比于激光雷达,摄像头的价格就是要低的多,但有些工业摄像头的价格还是很高的。此外视觉传感器采集的图像信息要比激光雷达得到的信息丰富,所以更加利于后期的处理

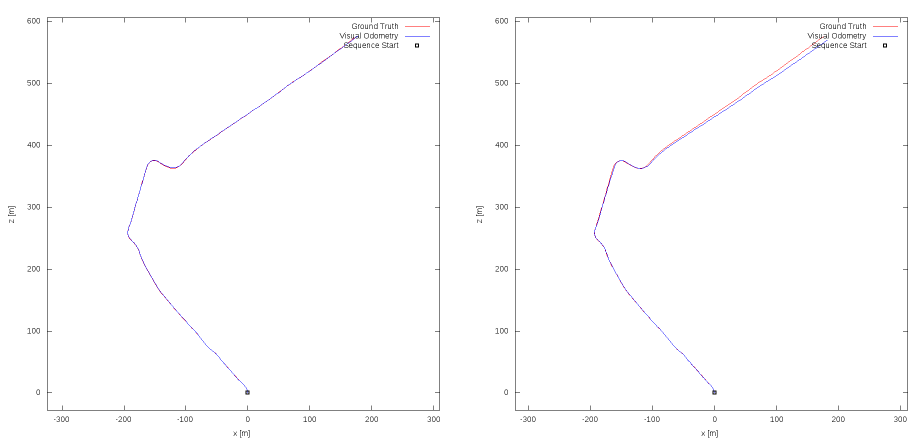

这里我们通过下图来比较比较两种方法的区别(数据来源于KITTI):

注意:左图为Lidar Odometry and Mapping (激光雷达)

右图为ORB-SLAM2 (视觉)

我们可以观察到对于同一个场景的测试,ORB-SLAM2在后半程出现了明显的误差,这是因为累积漂移(accumulated drift)所引起的,所以对于视觉SLAM要进行回环检测(Loop closure detection)。

由于个人主要是研究Visual SLAM,所以我们接下来对于这个方向进行细分。

(一)

按照视觉传感器主要分为三种:

单目摄像头(Monocular Camera)

双目摄像头(Binocular Camera)

深度摄像头(RGB-D Camera)

深度摄像头可以通过time of flight等方法来直接获得图像及对应的深度信息,优点在于方便获得深度数据,缺点在于成本高,体积大,室外环境基本报废。

双目摄像头可以通过三角方法计算出深度信息,市面上有一些深度摄像头也是直接基于双摄像头来做的。然而双目摄像头在目标距离较远的时候会退化成单目。因此近年来大量的研究都是围绕单目进行的。

单目SLAM可以通过临近图像匹配计算出摄像头位姿的变换,在两个视角上进行三角测距又可以得出对应点的深度信息。通过这样迭代的过程可以实现定位及建图。

(二)

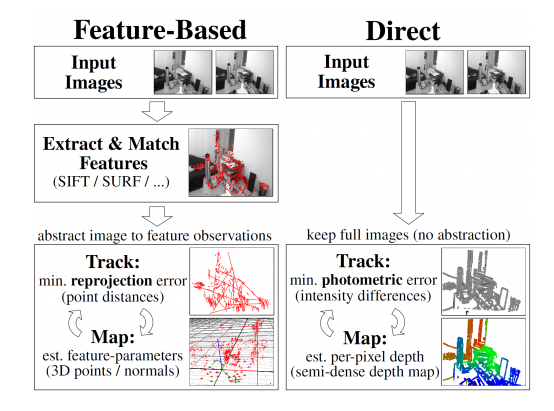

A、根据对图像处理的方式非为:

- 直接法(Direct)

- 非直接法(Indirect)(一般为基于特征(Feature-Based))

区别如下图:

B、根据构建地图的稀疏程度分为:

- 稀疏(Sparse)

- 稠密(Dense)

但注意:一般这两种方法会同时使用,具体的组合及方法(包含相关论文)如下:

(1)Sparse + Indirect:

monoSLAM:

A. Davison, I. Reid, N. Molton, and O. Stasse. MonoSLAM:

Real-time single camera SLAM. Transactions on Pattern

Analysis and Machine Intelligence (TPAMI), 29, 2007. 2

PTAM:

G. Klein and D. Murray. Parallel tracking and mapping for

small AR workspaces. In International Symposium on Mixed

and Augmented Reality (ISMAR), 2007. 2

ORB-SLAM

R. Mur-Artal, J. Montiel, and J. Tardos. ORB-SLAM: a versatile

and accurate monocular SLAM system. Transactions

on Robotics, 31(5):1147–1163, 2015. 2, 11

(2)Dense + Indirect

L. Valgaerts, A. Bruhn, M. Mainberger, and J. Weickert.

Dense versus sparse approaches for estimating the fundamental

matrix. International Journal of Computer Vision

(IJCV), 96(2):212–234, 2012. 2

R. Ranftl, V. Vineet, Q. Chen, and V. Koltun. Dense monocular

depth estimation in complex dynamic scenes. In International

Conference on Computer Vision and Pattern Recognition

(CVPR), 2016. 2

(3)Dense + Direct:

DTAM

R. Newcombe, S. Lovegrove, and A. Davison. DTAM:

Dense tracking and mapping in real-time. In International

Conference on Computer Vision (ICCV), 2011. 2, 3

J. St¨uhmer, S. Gumhold, and D. Cremers. Real-time dense

geometry from a handheld camera. In Pattern Recognition

(DAGM), 2010. 2, 3

LSD-SLAM

J. Engel, T. Sch¨ops, and D. Cremers. LSD-SLAM: Largescale

direct monocular SLAM. In European Conference on

Computer Vision (ECCV), 2014. 2, 11

(4)Sparse + Direct

DSO

J. Engel, V. Usenko and D. Cremers,

A Photometrically Calibrated Benchmark For Monocular Visual Odometry,

arXiv:1607.02555, July 2016.

J. Engel, V. Koltun and D. Cremers,

Direct Sparse Odometry,

arXiv:1607.02565, July 2016.