- 1自然语言处理中的文本特征提取和特征工程

- 2NineAi部署教程

- 3基于ROS搭建简易软件框架实现ROV水下目标跟踪(一)--简述_rov运动控制 csdn

- 4目标检测中的遮挡问题及优化_视觉检测针对重叠遮挡的优化

- 5聊聊软件研发质量管理(二)_研发质量体系怎么建

- 6通用人工智能(Artificial General Intelligence,AGI)概述

- 7python实现指纹识别毕业论文_指纹识别算法实现-毕业论文

- 8【LLM系列之Tokenizer】如何科学地训练一个LLM分词器_如何训练tokenizer

- 9“金融元宇宙”应用场景研究

- 10优先队列PriorityQueue —— Comparator_priorityqueue comparator

深度学习十大算法之生成对抗网络(GAN)

赞

踩

1. 引言

在过去的几年中,人工智能领域经历了翻天覆地的变化,尤其是在机器学习和深度学习领域。其中,生成对抗网络(GAN)作为一种革命性的新技术,自2014年由Ian Goodfellow及其同事提出以来,便在学术界和工业界引起了巨大的关注。GAN的核心理念是通过竞争而不是合作来训练网络,这一点与传统的神经网络训练方式截然不同。

GAN由两部分组成:生成器(Generator)和判别器(Discriminator)。生成器的任务是创建足以欺骗判别器的数据,而判别器的任务则是区分生成器产生的假数据和真实数据。这种对抗的过程激发了网络学习更深层次特征的能力,从而产生了极其逼真的合成结果。此外,GAN的这种独特结构和训练机制,使得它在图像生成、语音识别、自然语言处理等多个领域都显示出了巨大的潜力。

GAN的应用范围非常广泛,从最初的图像生成到后来的艺术创作、游戏开发、甚至是药物发现等,GAN都表现出了其独特的价值和广阔的应用前景。例如,在图像处理领域,GAN能够生成高度逼真的人脸图像、风景照片等,这在以往是难以想象的。在艺术领域,GAN可以帮助艺术家创造出新颖的艺术作品,甚至可以模仿历史艺术家的风格,创造出类似风格的新作品。

尽管GAN在多个领域表现出色,但它仍然面临着一些技术挑战,例如训练稳定性差、生成样本多样性不足等问题。然而,正是这些挑战,也激励着研究人员不断地探索和改进GAN的架构,以适应更多的应用场景。

总的来说,生成对抗网络(GAN)作为深度学习领域的一个重要里程碑,不仅展示了机器学习技术的新境界,也为人工智能的未来发展开辟了新的方向。本文将继续探讨GAN的基本原理、关键技术、主要变体以及它们在实际应用中的具体案例,以期给读者提供一个关于GAN的全面且深入的了解。

2. GAN的基本原理

生成对抗网络(GAN)的基本原理源自于博弈论中的对抗性思想。它包括两个关键部分:生成器(Generator)和判别器(Discriminator),这两部分相互竞争,相互促进,共同进步。

生成器(Generator)

生成器的目标是产生逼真的数据。它接收一个随机噪声向量作为输入,并通过一系列网络层的转换生成数据。这个过程可以用数学公式表示为 G ( z ; θ g ) G(z; \theta_g) G(z;θg),其中 G G G是生成器函数, z z z是输入的随机噪声, θ g \theta_g θg 是生成器的参数。

生成器的训练目标是使其产生的数据尽可能接近真实数据分布。理想状态下,生成器生成的数据将足以欺骗判别器,使其无法区分真假。

判别器(Discriminator)

判别器的角色类似于一个警察,需要判断输入的数据是来自真实数据集还是生成器。其结构通常是一个二元分类网络,输出一个标量表示输入数据为真实数据的概率。数学上,判别器可以表示为 D ( x ; θ d ) D(x; \theta_d) D(x;θd),其中 D D D 是判别器函数, x x x是输入数据, θ d \theta_d θd 是判别器的参数。

判别器的训练目标是最大化区分真实数据和生成器生成的假数据的能力。理想状态下,判别器能完美区分真假数据。

对抗训练

GAN的核心是生成器和判别器的对抗训练。在训练过程中,生成器试图产生越来越逼真的数据来欺骗判别器,而判别器则努力学习以区分真假数据。这个过程可以形象地比喻为一场“警匪游戏”。

GAN的训练目标可以用下面的最小化最大化公式表示:

min

G

max

D

V

(

D

,

G

)

=

E

x

∼

p

d

a

t

a

(

x

)

[

log

D

(

x

)

]

+

E

z

∼

p

z

(

z

)

[

log

(

1

−

D

(

G

(

z

)

)

)

]

\min_G \max_D V(D, G) = \mathbb{E}_{x \sim p_{data}(x)}[\log D(x)] + \mathbb{E}_{z \sim p_z(z)}[\log(1 - D(G(z)))]

GminDmaxV(D,G)=Ex∼pdata(x)[logD(x)]+Ez∼pz(z)[log(1−D(G(z)))]

其中, E x ∼ p d a t a ( x ) [ log D ( x ) ] \mathbb{E}_{x \sim p_{data}(x)}[\log D(x)] Ex∼pdata(x)[logD(x)]表示判别器识别真实数据的期望对数似然,而 $\mathbb{E}_{z \sim p_z(z)}[\log(1 - D(G(z)))] 表示判别器识别生成数据为假的期望对数似然。

损失函数的设计

在GAN的训练中,通常会使用交叉熵作为损失函数。对于判别器,损失函数是其正确分类真实数据和生成数据的能力的度量。对于生成器,损失函数则衡量其欺骗判别器的能力。

训练稳定性

GAN的训练是一个动态平衡的过程,要求生成器和判别器的能力相对均衡。如果判别器太强,则生成器可能无法有效学习;相反,如果生成器太强,则判别器可能无法正确区分真假数据。因此,保持这两者之间的平衡对于成功训练GAN至关重要。

GAN的基本原理虽然简单,但在实践中的应用却非常复杂。后续部分将详细介绍GAN的关键技术、主要变体以及在实际应用中的案例,帮助读者更深入地理解GAN的工作机制和应用价值。

3. GAN的关键技术

生成对抗网络(GAN)的核心技术在于如何有效地训练生成器和判别器,使它们在对抗的过程中达到动态平衡。以下是GAN关键技术的详细介绍:

卷积神经网络在GAN中的应用

卷积神经网络(CNN)在GAN中扮演着至关重要的角色。在大多数GAN模型中,生成器和判别器都采用了卷积神经网络的结构。这是因为CNN特别适合处理图像数据,能够有效提取图像的空间层次特征。

- 生成器通常使用逆卷积(Transposed Convolution)层来从随机噪声生成图像。

- 判别器则使用标准卷积层来判断图像是否为真实图像。

训练过程中的稳定性和收敛问题

GAN的训练过程著名的难点是其不稳定性。以下几个因素是导致这一问题的主要原因:

- 不平衡的竞争:如果生成器或判别器中的一个比另一个强大得多,会导致整个训练过程失衡。

- 梯度消失:当判别器过于完美时,生成器可能无法得到足够的梯度来更新自身。

为了解决这些问题,研究者们提出了多种技术,如使用不同的损失函数、引入梯度惩罚(Gradient Penalty)等。

模式坍塌(Mode Collapse)

模式坍塌是GAN训练中常见的一个问题,指的是生成器开始生成非常相似甚至相同的输出,失去多样性。这通常是因为生成器找到了欺骗判别器的“捷径”,而不是学习数据的真实分布。

解决模式坍塌的方法包括引入更复杂的网络结构、改进训练策略等。

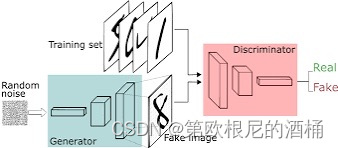

GAN的流程图

以下是一个简化的GAN训练流程图,用以说明生成器和判别器之间的对抗过程:

4. GAN的主要变体

自从生成对抗网络(GAN)被提出以来,研究人员在其基础上开发了多种变体,以适应不同的应用场景和解决特定问题。以下是一些重要的GAN变体及其特点:

条件GAN(Conditional GAN)

条件GAN(cGAN)在原始GAN的基础上引入了额外的条件信息,如标签或数据,使生成的结果不仅依赖于输入的噪声,还受到这些条件的影响。这种方式使得生成的数据更加多样化和控制性强。了解更多关于条件GAN,请访问这里。

循环GAN(CycleGAN)

循环GAN(CycleGAN)用于在没有成对数据的情况下,实现两个领域之间的图像转换。它引入了一个循环一致性损失(cycle-consistency loss),确保原始图像经过两次转换(A到B再回到A)后能保持不变。CycleGAN在风格迁移等应用中非常有效。更多信息可参考这里。

进阶GAN模型

随着GAN研究的深入,出现了一些进阶模型,如BigGAN和StyleGAN,它们在生成高质量、高分辨率图像方面取得了显著成就。

- BigGAN:通过增大模型和批量大小,BigGAN能够生成高分辨率且细节丰富的图像。它在ImageNet这样的大型数据集上表现出色。相关论文可在这里找到。

- StyleGAN:由NVIDIA开发的StyleGAN引入了风格转移的概念,它可以控制生成图像的风格,产生高度逼真的人脸图像。StyleGAN的细节可在这里阅读。

结论

GAN的这些变体显著扩展了其在图像合成、风格迁移、数据增强等领域的应用。每种变体都有其独特的特点和适用场景,这使得GAN成为一个非常灵活且强大的工具。尽管存在训练稳定性和模式坍塌等挑战,GAN及其变体仍然是深度学习和人工智能领域中最活跃和最具创新性的研究方向之一。

5. 实际应用

这个示例使用的是Keras库,一个广泛用于深度学习的Python库。我们将以最常见的数据集之一——MNIST手写数字数据集为例。

首先,您需要安装Keras和TensorFlow(如果还没安装的话),您可以使用如下命令安装:

pip install tensorflow keras

- 1

接下来是构建GAN的代码示例:

import numpy as np from tensorflow.keras.datasets import mnist from tensorflow.keras.models import Sequential, Model from tensorflow.keras.layers import Dense, LeakyReLU, BatchNormalization from tensorflow.keras.layers import Reshape, Flatten, Input from tensorflow.keras.optimizers import Adam # 加载数据 (x_train, _), (_, _) = mnist.load_data() x_train = x_train / 127.5 - 1.0 # 将图像标准化到[-1, 1] x_train = np.expand_dims(x_train, axis=3) # GAN参数 img_rows, img_cols, channels = 28, 28, 1 img_shape = (img_rows, img_cols, channels) latent_dim = 100 # 生成器 def build_generator(): model = Sequential() model.add(Dense(256, input_dim=latent_dim)) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization(momentum=0.8)) model.add(Dense(512)) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization(momentum=0.8)) model.add(Dense(1024)) model.add(LeakyReLU(alpha=0.2)) model.add(BatchNormalization(momentum=0.8)) model.add(Dense(np.prod(img_shape), activation='tanh')) model.add(Reshape(img_shape)) model.summary() noise = Input(shape=(latent_dim,)) img = model(noise) return Model(noise, img) # 判别器 def build_discriminator(): model = Sequential() model.add(Flatten(input_shape=img_shape)) model.add(Dense(512)) model.add(LeakyReLU(alpha=0.2)) model.add(Dense(256)) model.add(LeakyReLU(alpha=0.2)) model.add(Dense(1, activation='sigmoid')) model.summary() img = Input(shape=img_shape) validity = model(img) return Model(img, validity) # 编译判别器 discriminator = build_discriminator() discriminator.compile(loss='binary_crossentropy', optimizer=Adam(0.0002, 0.5), metrics=['accuracy']) # 编译生成器 generator = build_generator() z = Input(shape=(latent_dim,)) img = generator(z) # 固定判别器在训练生成器时 discriminator.trainable = False # 判别器将生成的图像作为输入并确定其有效性 validity = discriminator(img) # 整个模型,训练生成器来欺骗判别器 combined = Model(z, validity) combined.compile(loss='binary_crossentropy', optimizer=Adam(0.0002, 0.5)) # 训练 epochs = 10000 batch_size = 32 half_batch = int(batch_size / 2) for epoch in range(epochs): # --------------------- # 训练判别器 # --------------------- # 随机选择一半的图像 idx = np.random.randint(0, x_train.shape[0], half_batch) imgs = x_train[idx] noise = np.random.normal(0, 1, (half_batch, latent_dim)) # 生成一批新的图像 gen_imgs = generator.predict(noise) # 训练判别器 d_loss_real = discriminator.train_on_batch(imgs, np.ones((half_batch, 1))) d_loss_fake = discriminator.train_on_batch(gen_imgs, np.zeros((half_batch, 1))) d_loss = 0.5 * np.add(d_loss_real, d_loss_fake) # --------------------- # 训练生成器 # --------------------- noise = np.random.normal(0, 1, (batch_size, latent_dim)) # 生成器希望判别器将其识别为有效的 valid_y = np.array([1] * batch_size) # 训练生成器 g_loss = combined.train_on_batch(noise, valid_y) # 打印进度 print ("%d [判别器损失: %f, 准确度: %.2f%%] [生成器损失: %f]" % (epoch, d_loss[0], 100*d_loss[1], g_loss))

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

- 59

- 60

- 61

- 62

- 63

- 64

- 65

- 66

- 67

- 68

- 69

- 70

- 71

- 72

- 73

- 74

- 75

- 76

- 77

- 78

- 79

- 80

- 81

- 82

- 83

- 84

- 85

- 86

- 87

- 88

- 89

- 90

- 91

- 92

- 93

- 94

- 95

- 96

- 97

- 98

- 99

- 100

- 101

- 102

- 103

- 104

- 105

- 106

- 107

- 108

- 109

- 110

- 111

- 112

- 113

- 114

这段代码提供了一个简单的GAN模型,用于生成手写数字图像。请注意,GAN的训练可能需要较长时间,并且生成的图像质量与网络结构和训练时长有关。这只是一个基本示例,用于演示GAN的构建和训练过程。对于复杂的任务和数据集,需要更复杂的网络架构和调优。

6. 结论与展望

自从2014年生成对抗网络(GAN)的概念首次被提出以来,它已经在多个领域表现出了巨大的潜力和影响力。从生成逼真的图像和视频到新药开发,GAN的应用领域日益扩大,展现出令人惊叹的创新能力。然而,尽管GAN技术取得了显著的进展,它仍然面临着一系列挑战和局限性。

当前GAN的挑战

- 训练稳定性:GAN训练过程的不稳定性是一个主要挑战。这通常导致模型训练难以收敛,生成的图像质量不稳定。

- 模式坍塌:在模式坍塌中,生成器倾向于生成非常相似的输出,忽略输入噪声的多样性。这限制了GAN生成样本的多样性。

- 计算成本:训练高质量的GAN模型通常需要大量的计算资源和时间,这对资源有限的研究者和开发者来说是一个门槛。

- 伦理和社会问题:随着GAN生成的图像、视频和文本越来越逼真,伪造内容(如“深度伪造”技术)的滥用成为一个日益严重的社会问题。

GAN的未来发展方向

尽管面临挑战,GAN的未来发展仍充满希望。以下是一些可能的发展方向:

- 改善稳定性和多样性:研究者正在探索新的架构和训练方法,以提高GAN的训练稳定性和生成样本的多样性。

- 资源优化:通过改进算法和模型效率,使GAN的训练更加资源高效,为更广泛的用户群提供可行性。

- 探索新的应用场景:GAN在艺术创作、医学影像、数据增强等领域展现出巨大的应用潜力,未来可能在更多的领域找到应用。

- 伦理和监管:随着GAN技术的发展,伦理和监管问题也日益受到关注。制定相应的法律和伦理指导原则,以遏制GAN技术的滥用,将是一个重要议题。

结论

生成对抗网络(GAN)作为深度学习领域的一项革命性技术,已经表明了其强大的能力和广泛的应用前景。它不仅为我们提供了一个全新的生成数据的方法,也推动了人工智能技术的边界。尽管GAN仍然面临着许多技术和伦理挑战,但其在未来的潜力和影响不容小觑。我们期待着GAN在科技进步和社会发展中继续发挥着重要的作用。