热门标签

热门文章

- 1基于n-gram模型的中文分词_ngram分词

- 2java连接mysql增删改查(01单增删改查)_java连接mysq 增删改查

- 3论文aigc检测率为多少合格?论文ai免费润色_本科毕业论文aigc值多少合格

- 4Python中数据可视化的最新趋势和未来发展

- 5不相交集(The Disjoint Set ADT)_the array representation of a disjoint set contain

- 6Solana 与 DePIN 的双向奔赴,会带来 DePIN 之夏吗?

- 7matlab实现apriori算法源代码实验报告_apriori算法实验报告

- 8计算机毕业设计hadoop+spark知识图谱视频推荐系统 视频分析可视化大屏 视频爬虫 视频大数据分析 大数据毕业设计 机器学习 深度学习 人工智能

- 9对云原生整体解决方案的进一步复盘

- 10Java进阶-SpringCloud设计模式-工厂模式的设计与详解

当前位置: article > 正文

【Coursera】优化的梯度下降算法 RMSprop & Adam & Lr decay_梯度相关方法,如adam、lrdecay

作者:繁依Fanyi0 | 2024-05-05 12:24:15

赞

踩

梯度相关方法,如adam、lrdecay

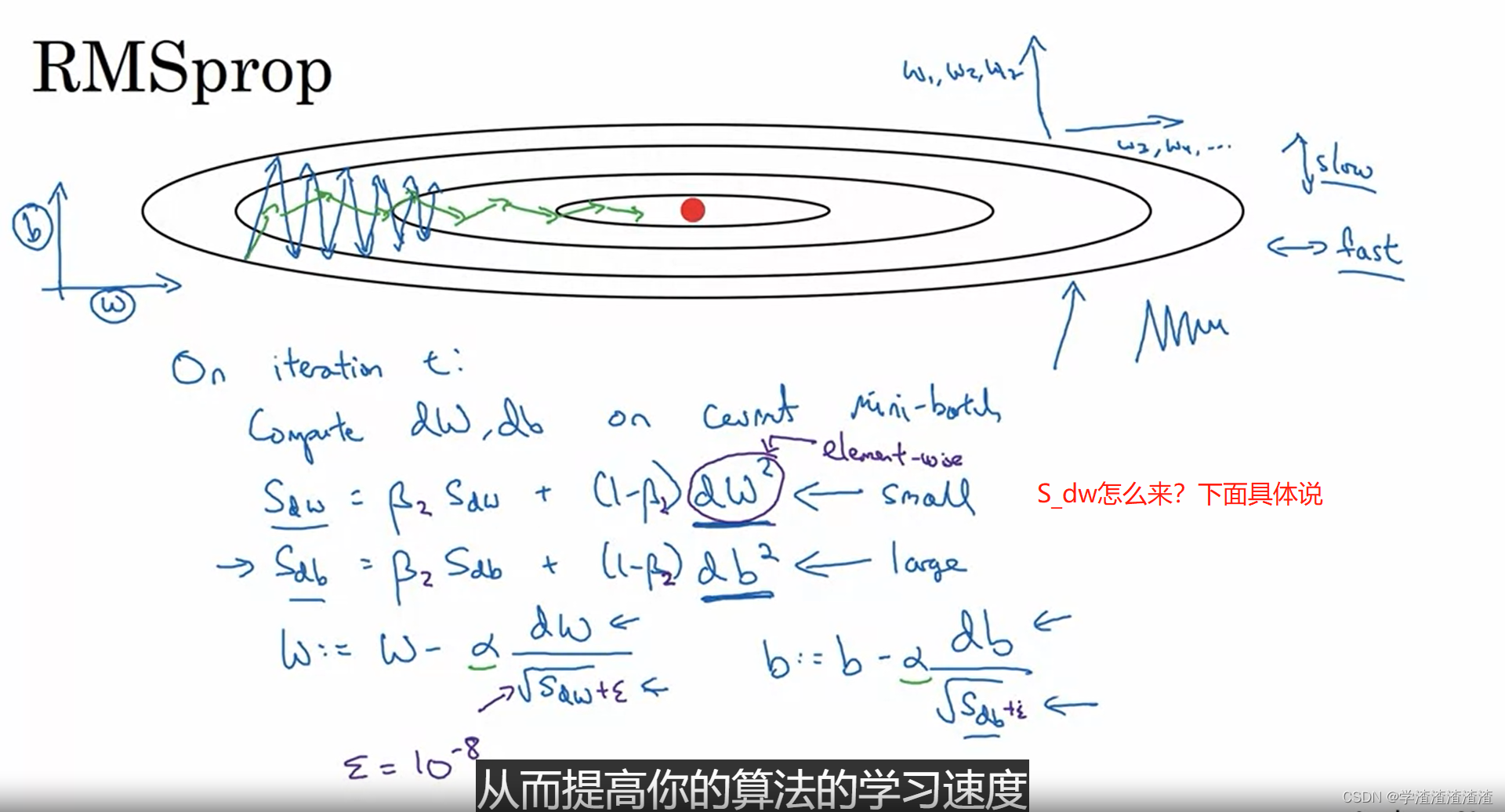

RMSprop

RMSprop(均方根传递) 是指数滑动平均(exponentially weighted average)的改编,用于降低梯度下降和小批量梯度下降中的振荡,加速机器学习训练,即下图绿色的线。

这里的

S

d

w

S_{dw}

Sdw 值得是

d

w

2

dw^{2}

dw2 ,这种训练方法更新的是方差,虽然走的很平稳,但是还不如下面介绍的 Adam 算法好。

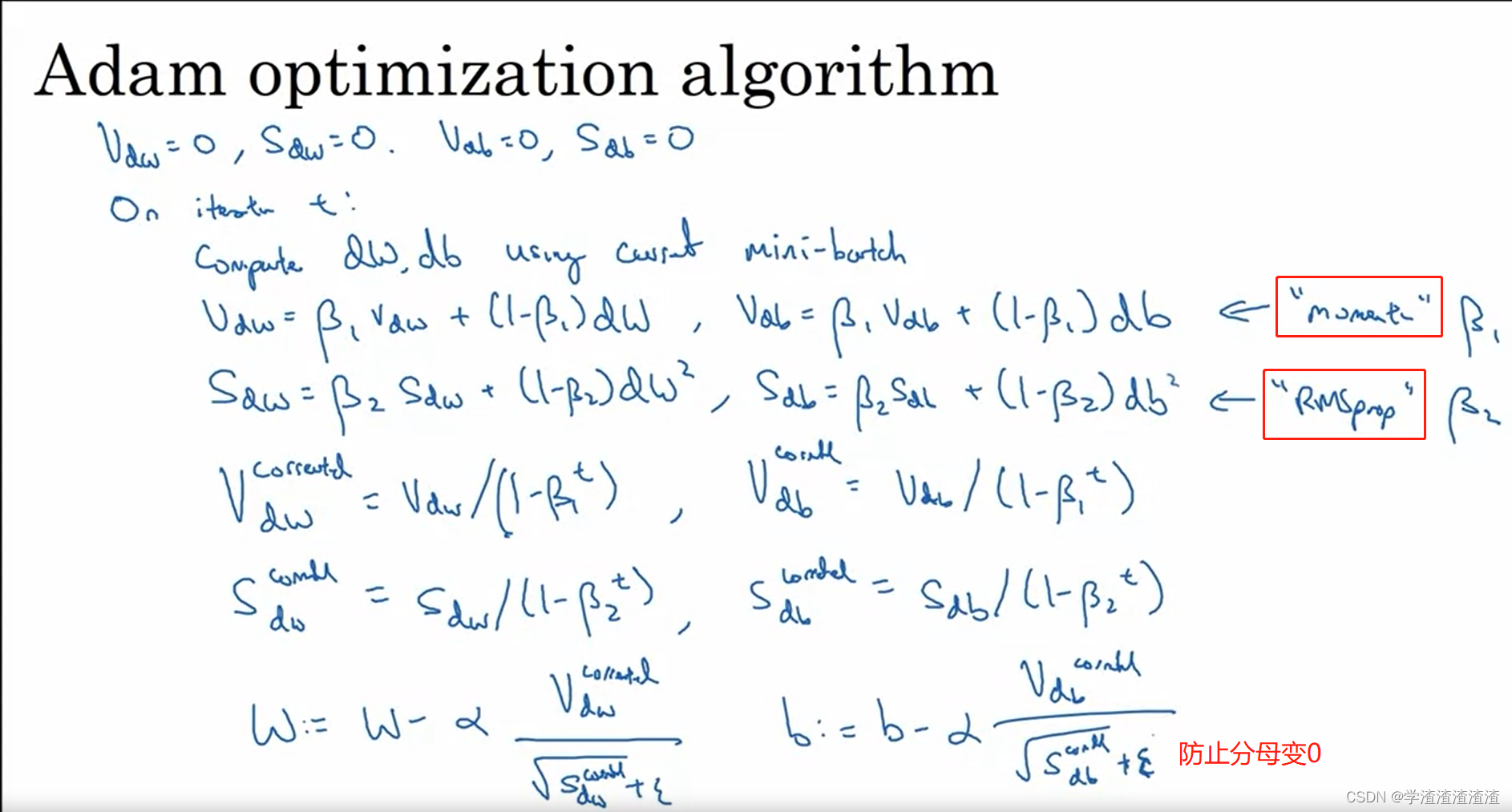

Adam

Adam 算法把 RMSprop 和 momentum 结合起来了。

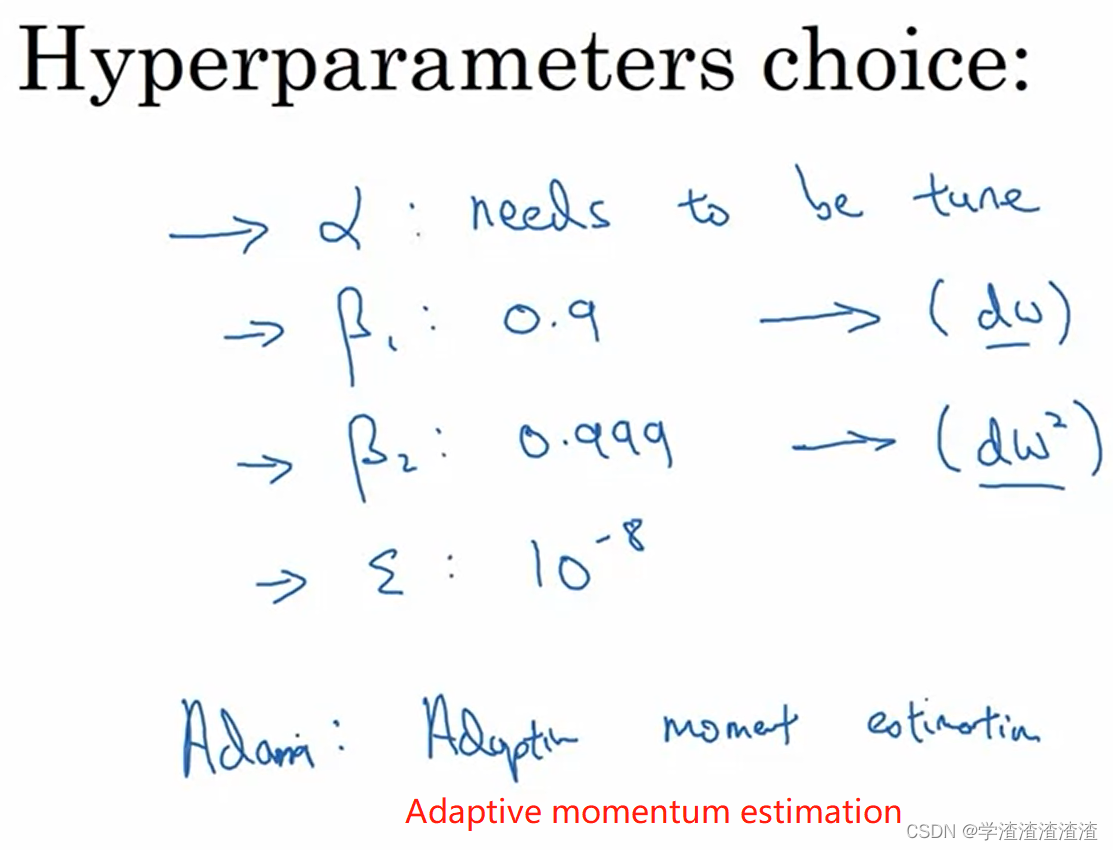

算法

参数的选择

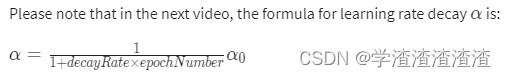

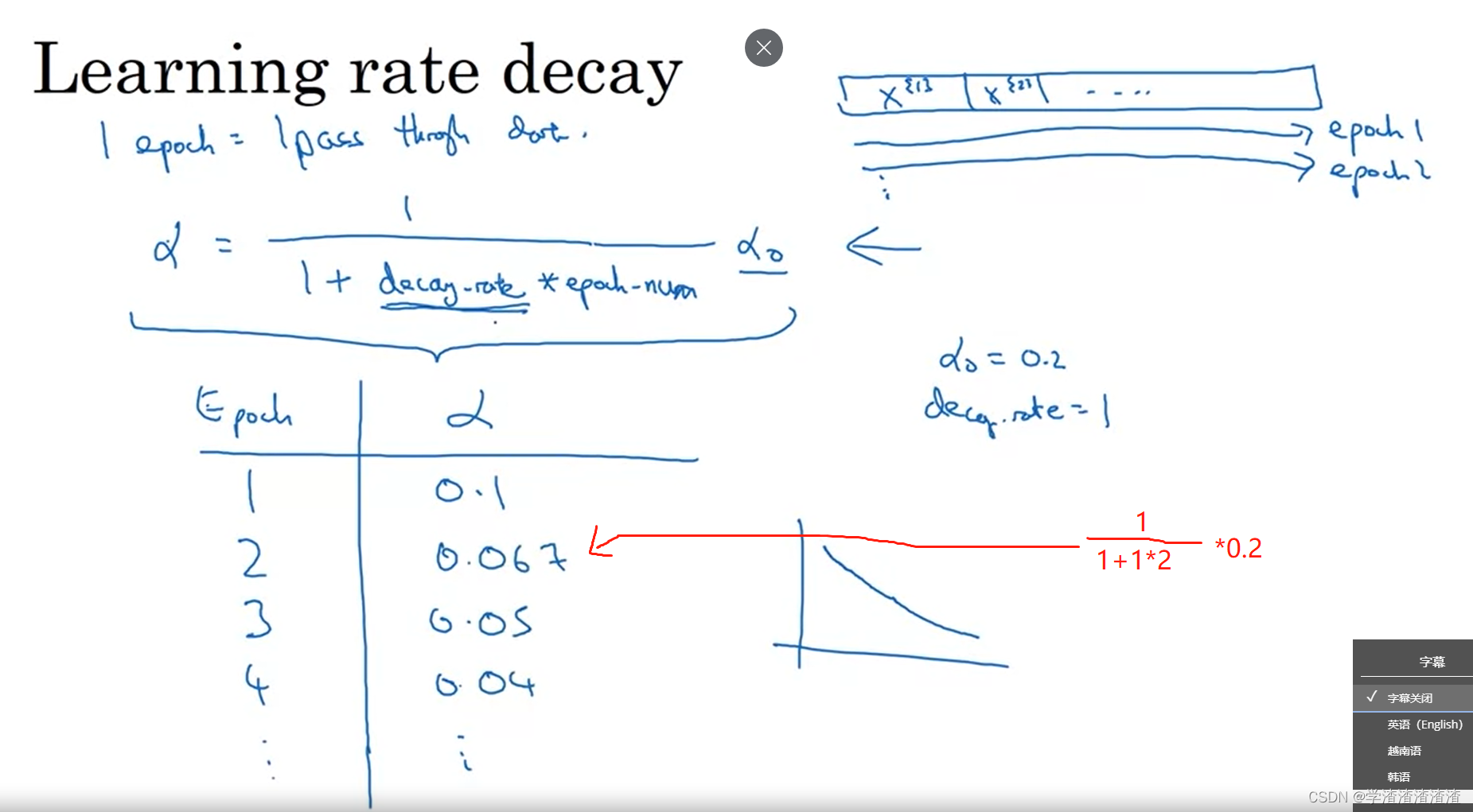

Learning Rate Decay

随着训练进程,调整 learning rate 逐渐变小。

下面介绍最简单的 learning rate decay:

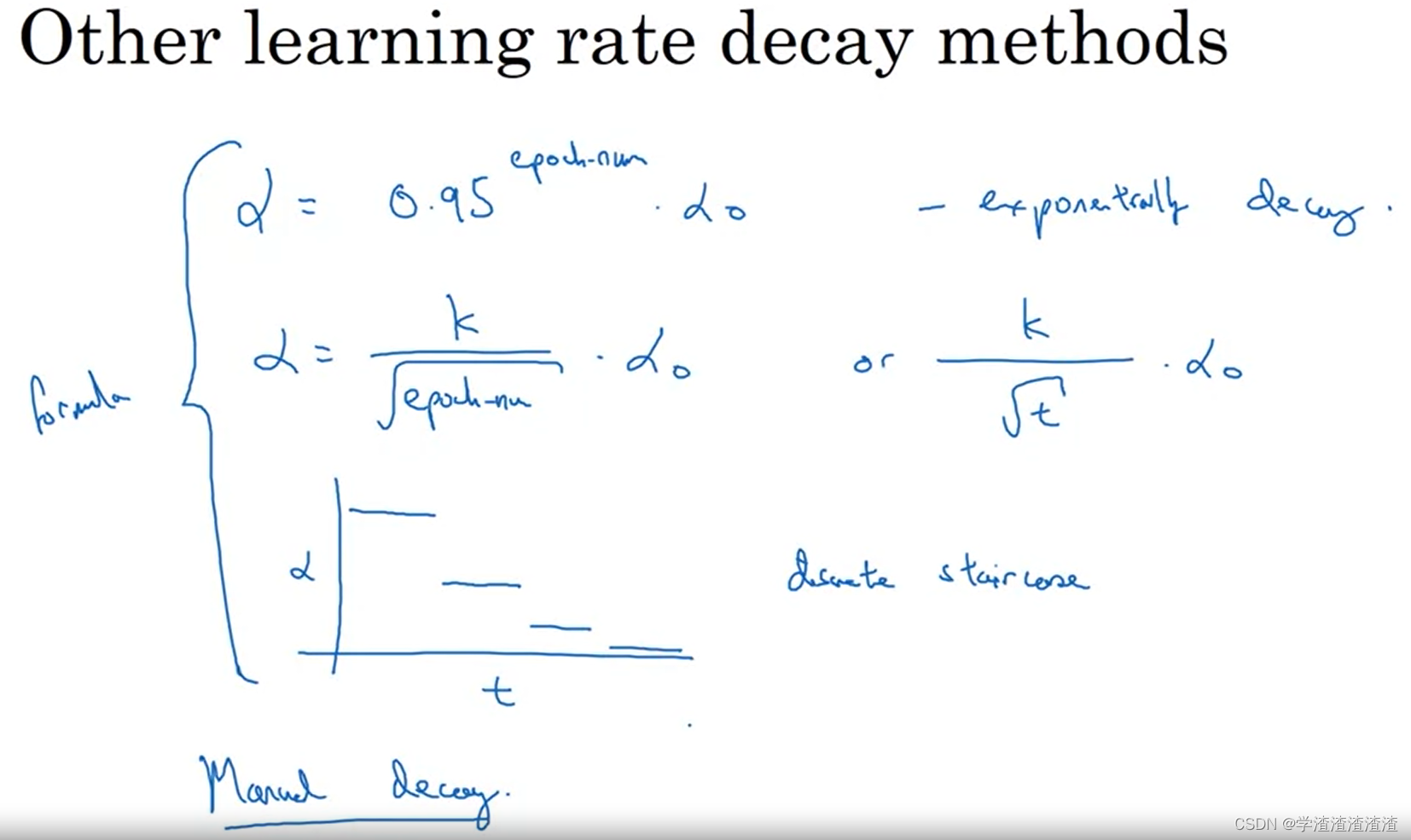

还有别的 decay 方法:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/538861

推荐阅读

相关标签