- 1信息安全概论课程练习与参考解答_bob综合

- 2基于kafka、nginx的web日志收集_nginx kafka

- 3请大家拿下软考,现在!立刻!马上!!

- 4大数据毕业设计PySpark+Hadoop航班延误预测 航班可视化 机票可视化 机票爬虫 航班大数据 机器学习 深度学习 人工智能 随机森林树 卷积神经网络 知识图谱 大数据毕业设计 计算机毕业设计_python 爬取飞猪机票

- 5OJ练习03(C语言):一元二次方程

- 62022年上半年软考报名时间最新汇总,快收藏

- 7IDEA下载Git中项目_idea怎么下载git代码

- 8WEB基础--数据库事务与连接池

- 9政安晨:【Keras机器学习示例演绎】(二十四)—— 使用具有对比损失的连体网络进行图像相似性估计

- 10Linux (CentOs) 统计文件单词数量_linux 统计单词个数

疲劳驾驶检测和识别2:Pytorch实现疲劳驾驶检测和识别(含疲劳驾驶数据集和训练代码)_疲劳驾驶python

赞

踩

疲劳驾驶检测和识别2:Pytorch实现疲劳驾驶检测和识别(含疲劳驾驶数据集和训练代码)

目录

疲劳驾驶检测和识别2:Pytorch实现疲劳驾驶检测和识别(含疲劳驾驶数据集和训练代码)

这是项目《疲劳驾驶检测和识别》系列之《Pytorch实现疲劳驾驶检测和识别(含疲劳驾驶数据集和训练代码)》;项目基于深度学习框架Pytorch开发一个高精度,可实时疲劳驾驶检测和识别算法;项目源码支持模型有resnet18,resnet34,resnet50, mobilenet_v2以及googlenet等常见的深度学习模型,用户也可以自定义自己的模型进行训练;项目源码配套了完整的训练代码和数据集,配置好开发环境,即可开始训练。

准确率还挺高的,采用轻量级mobilenet_v2模型的疲劳驾驶识别准确率也可以高达97.8682%左右,满足业务性能需求。

| 模型 | input size | Test准确率 |

| mobilenet_v2 | 112×112 | 97.8682 |

| googlenet | 112×112 | 98.4496 |

| resnet18 | 112×112 | 98.2558 |

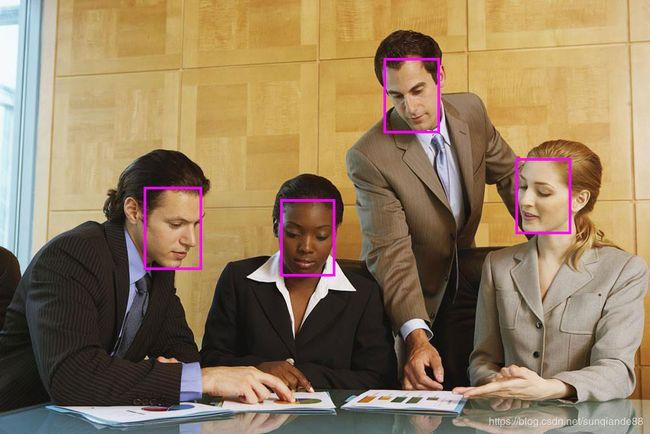

先展示一下,Python版本的疲劳驾驶检测和识别Demo效果

【尊重原创,转载请注明出处】https://blog.csdn.net/guyuealian/article/details/131834946

更多项目《疲劳驾驶检测和识别》系列文章请参考:

- 疲劳驾驶检测和识别1: 疲劳驾驶检测和识别数据集(含下载链接)https://blog.csdn.net/guyuealian/article/details/131718648

- 疲劳驾驶检测和识别2:Pytorch实现疲劳驾驶检测和识别(含疲劳驾驶数据集和训练代码)https://blog.csdn.net/guyuealian/article/details/131834946

-

疲劳驾驶检测和识别3:Android实现疲劳驾驶检测和识别(含源码,可实时检测)https://blog.csdn.net/guyuealian/article/details/131834970

-

疲劳驾驶检测和识别4:C++实现疲劳驾驶检测和识别(含源码,可实时检测)疲劳驾驶检测和识别4:C++实现疲劳驾驶检测和识别(含源码,可实时检测)_AI吃大瓜的博客-CSDN博客

1.疲劳驾驶检测和识别方法

疲劳驾驶检测和识别方法有多种实现方案,这里采用最常规的方法:基于人脸检测+疲劳驾驶分类识别方法,即先采用通用的人脸检测模型,进行人脸检测定位人体区域,然后按照一定规则裁剪人脸检测区域,再训练一个疲劳驾驶行为识别分类器,完成疲劳驾驶检测和识别任务;

这样做的好处,是可以利用现有的人脸检测模型进行人脸检测,而无需重新标注疲劳驾驶的人脸检测框,可减少人工标注成本低;而疲劳驾驶分类数据相对而言比较容易采集,分类模型可针对性进行优化。

当然,也可以直接基于目标检测的方法直接检测疲劳驾驶和非疲劳驾驶,项目也提供了疲劳驾驶目标检测的数据集

2.疲劳驾驶数据集

(1)疲劳驾驶数据集说明

在疲劳驾驶检测和识别算法开发中,我们需要定义疲劳驾驶的行为状态,项目将疲劳驾驶状态分为两个状态,分别为:疲劳(drowsy),不疲劳(undrowsy),为了便于大家理解,这里给出这两个状态的图示说明

- 疲劳(drowsy): 如果驾驶过程中出现闭眼,打哈欠等疲劳困倦等表情动作,则认为是疲劳驾驶(drowsy)

- 不疲劳(undrowsy):正常情况下,没有出现闭眼,打哈欠的表情动作,则认为是清醒状态,即非疲劳状态(undrowsy)

关于疲劳驾驶数据集的使用说明请参考我的一篇博客: https://blog.csdn.net/guyuealian/article/details/131718648

项目提供了疲劳驾驶检测数据集和疲劳驾驶分类数据集,由于我们的实现方案采用基于人脸检测+疲劳驾驶分类识别方法,因此模型训练只使用了疲劳驾驶分类数据集:Drowsy-Driving-Cls1,Drowsy-Driving-Cls2;疲劳驾驶检测数据集并未使用。

(2)自定义数据集

如果需要新增类别数据,或者需要自定数据集进行训练,可参考如下进行处理:

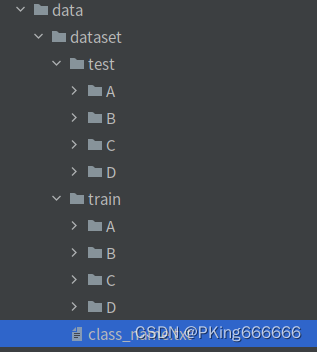

- 建立Train和Test数据集,要求相同类别的图片,放在同一个文件夹下;且子目录文件夹命名为类别名称,如

- 类别文件:一行一个列表:class_name.txt

(最后一行,请多回车一行)

- A

- B

- C

- D

-

- 修改配置文件的数据路径:configs/config.yaml

- train_data: # 可添加多个数据集

- - 'data/dataset/train1'

- - 'data/dataset/train2'

- test_data: 'data/dataset/test'

- class_name: 'data/dataset/class_name.txt'

- ...

- ...

3.人脸检测模型

本项目人脸检测训练代码请参考:https://github.com/Linzaer/Ultra-Light-Fast-Generic-Face-Detector-1MB

这是一个基于SSD改进且轻量化后人脸检测模型,很slim,整个模型仅仅1.7M左右,在普通Android手机都可以实时检测。人脸检测方法在网上有一大堆现成的方法可以使用,完全可以不局限我这个方法。

当然可以基于YOLOv5训练一个人脸检测模型:人脸检测和行人检测2:YOLOv5实现人脸检测和行人检测(含数据集和训练代码)

4.疲劳驾驶分类模型训练

准备好疲劳驾驶识别数据后,接下来就可以开始训练疲劳驾驶识别分类模型了;项目模型支持resnet18,resnet34,resnet50, mobilenet_v2以及googlenet等常见的深度学习模型,考虑到后续我们需要将疲劳驾驶识别模型部署到Android平台中,因此项目选择计算量比较小的轻量化模型mobilenet_v2;如果不用端上部署,完全可以使用参数量更大的模型,如resnet50等模型。

整套工程项目基本结构如下:

- .

- ├── classifier # 训练模型相关工具

- ├── configs # 训练配置文件

- ├── data # 训练数据

- ├── libs

- │ ├── convert # 将模型转换为ONNX工具

- │ ├── light_detector # 人脸检测

- │ ├── detector.py # 人脸检测demo

- │ └── README.md

- ├── demo.py # demo

- ├── README.md # 项目工程说明文档

- ├── requirements.txt # 项目相关依赖包

- └── train.py # 训练文件

(1)项目安装

推荐使用Python3.8或Python3.7,更高版本可能存在版本差异问题, 项目依赖python包请参考requirements.txt,使用pip安装即可:

项目安装教程请参考(初学者入门,麻烦先看完下面教程,配置好开发环境):

- 项目开发使用教程和常见问题和解决方法

- 视频教程:1 手把手教你安装CUDA和cuDNN(1)

- 视频教程:2 手把手教你安装CUDA和cuDNN(2)

- 视频教程:3 如何用Anaconda创建pycharm环境

- 视频教程:4 如何在pycharm中使用Anaconda创建的python环境

- 推荐使用Python3.8或Python3.7,更高版本可能存在版本差异问题

(2)准备数据

下载疲劳驾驶分类数据集:Drowsy-Driving-Cls1,Drowsy-Driving-Cls2,然后解压

关于疲劳驾驶数据集的使用说明请参考我的一篇博客: https://blog.csdn.net/guyuealian/article/details/131718648

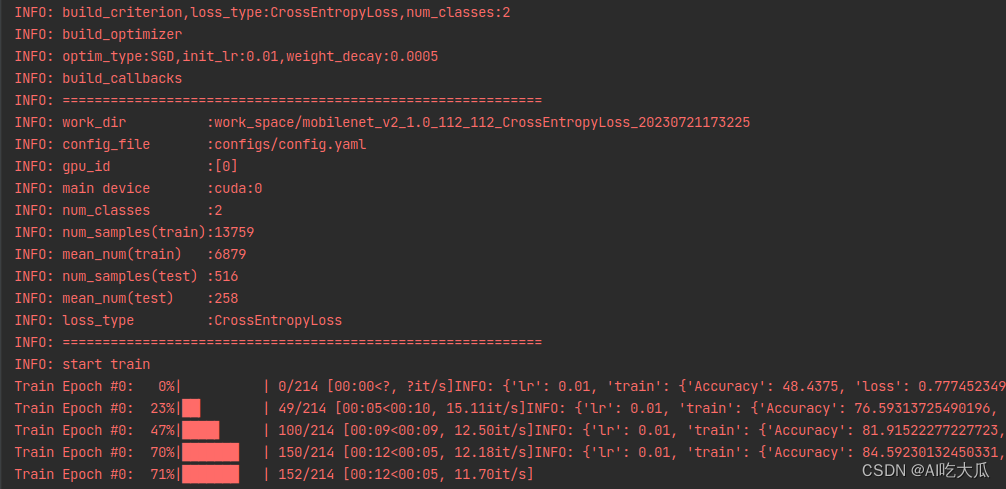

(3)疲劳驾驶识别分类模型训练(Pytorch)

项目在《Pytorch基础训练库Pytorch-Base-Trainer(支持模型剪枝 分布式训练)》基础上实现了疲劳驾驶识别分类模型训练和测试,整套训练代码非常简单操作,用户只需要将相同类别的图片数据放在同一个目录下,并填写好对应的数据路径,即可开始训练了。

训练框架采用Pytorch,整套训练代码支持的内容主要有:

- 目前支持的backbone有:googlenet,resnet[18,34,50], ,mobilenet_v2等, 其他backbone可以自定义添加

- 训练参数可以通过(configs/config.yaml)配置文件进行设置

修改配置文件的数据路径:configs/config.yaml:

- train_data和test_data修改为自己的数据路径

- 注意数据路径分隔符使用【/】,不是【\】

- 项目不要出现含有中文字符的目录文件或路径,否则会出现很多异常!

- # 训练数据集,可支持多个数据集(不要出现中文路径)

- train_data:

- - 'path/to/Drowsy-Driving-Cls1/trainval'

- - 'path/to/Drowsy-Driving-Cls2/trainval'

- # 测试数据集(不要出现中文路径)

- test_data:

- - 'path/to/Drowsy-Driving-Cls1/test'

-

- # 类别文件

- class_name: 'data/class_name.txt'

- train_transform: "train" # 训练使用的数据增强方法

- test_transform: "val" # 测试使用的数据增强方法

- work_dir: "work_space/" # 保存输出模型的目录

- net_type: "mobilenet_v2" # 骨干网络,支持:resnet18/50,mobilenet_v2,googlenet,inception_v3

- width_mult: 1.0 # 模型宽度因子

- input_size: [ 112,112 ] # 模型输入大小

- rgb_mean: [ 0.5, 0.5, 0.5 ] # for normalize inputs to [-1, 1],Sequence of means for each channel.

- rgb_std: [ 0.5, 0.5, 0.5 ] # for normalize,Sequence of standard deviations for each channel.

- batch_size: 128 # batch_size

- lr: 0.01 # 初始学习率

- optim_type: "SGD" # 选择优化器,SGD,Adam

- loss_type: "CrossEntropyLoss" # 选择损失函数:支持CrossEntropyLoss,LabelSmooth

- momentum: 0.9 # SGD momentum

- num_epochs: 120 # 训练循环次数

- num_warn_up: 0 # warn-up次数

- num_workers: 8 # 加载数据工作进程数

- weight_decay: 0.0005 # weight_decay,默认5e-4

- scheduler: "multi-step" # 学习率调整策略

- milestones: [ 30,60,100 ] # 下调学习率方式

- gpu_id: [ 2 ] # GPU ID

- log_freq: 50 # LOG打印频率

- progress: True # 是否显示进度条

- pretrained: True # 是否使用pretrained模型

- finetune: False # 是否进行finetune

开始训练,在终端输入:

python train.py -c configs/config.yaml

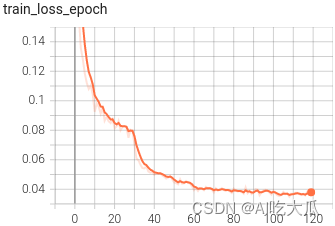

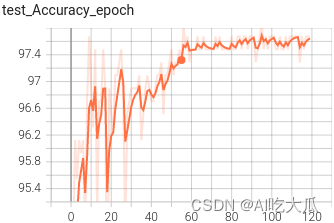

训练完成后,训练集的Accuracy在98.0%以上,测试集的Accuracy在97.5%左右

(4) 可视化训练过程

训练过程可视化工具是使用Tensorboard,在终端(Terminal)输入命令:

使用教程,请参考:项目开发使用教程和常见问题和解决方法

- # 需要安装tensorboard==2.5.0和tensorboardX==2.1

- # 基本方法

- tensorboard --logdir=path/to/log/

- # 例如

- tensorboard --logdir=tensorboard --logdir=data/pretrained/mobilenet_v2_1.0_112_112_CrossEntropyLoss_20230720174004/log

可视化效果

(5) 疲劳驾驶识别效果

训练完成后,训练集的Accuracy在99%以上,测试集的Accuracy在97.5%左右,下表给出已经训练好的三个模型,其中mobilenet_v2的测试集准确率可以达到97.8682%,googlenet的准确率可以达到98.4496%,resnet18的准确率可以达到98.2558%

| 模型 | input size | Test准确率 |

| mobilenet_v2 | 112×112 | 97.8682 |

| googlenet | 112×112 | 98.4496 |

| resnet18 | 112×112 | 98.2558 |

-

测试图片文件

- # 测试图片(Linux系统)

- image_dir='data/test_image' # 测试图片的目录

- model_file="data/pretrained/mobilenet_v2_1.0_112_112_CrossEntropyLoss_20230720174004/model/best_model_095_97.8682.pth" # 模型文件

- out_dir="output/" # 保存检测结果

- python demo.py --image_dir $image_dir --model_file $model_file --out_dir $out_dir

Windows系统,请将$image_dir, $model_file ,$out_dir等变量代替为对应的变量值即可,如

- # 测试图片(Windows系统)

- python demo.py --image_dir data/test_image --model_file data/pretrained/mobilenet_v2_1.0_112_112_CrossEntropyLoss_20230720174004/model/best_model_095_97.8682.pth --out_dir output/

-

-

测试视频文件

- # 测试视频文件(Linux系统)

- video_file="data/video-test.mp4" # 测试视频文件,如*.mp4,*.avi等

- model_file="data/pretrained/mobilenet_v2_1.0_112_112_CrossEntropyLoss_20230720174004/model/best_model_095_97.8682.pth" # 模型文件

- out_dir="output/" # 保存检测结果

- python demo.py --video_file $video_file --model_file $model_file --out_dir $out_dir

- # 测试视频文件(Windows系统)

- python demo.py --video_file data/video-test.mp4 --model_file data/pretrained/mobilenet_v2_1.0_112_112_CrossEntropyLoss_20230720174004/model/best_model_095_97.8682.pth --out_dir output/

-

-

测试摄像头

- # 测试摄像头(Linux系统)

- video_file=0 # 测试摄像头ID

- model_file="data/pretrained/mobilenet_v2_1.0_112_112_CrossEntropyLoss_20230720174004/model/best_model_095_97.8682.pth" # 模型文件

- out_dir="output/" # 保存检测结果

- python demo.py --video_file $video_file --model_file $model_file --out_dir $out_dir

- # 测试摄像头(Windows系统)

- python demo.py --video_file 0 --model_file data/pretrained/mobilenet_v2_1.0_112_112_CrossEntropyLoss_20230720174004/model/best_model_095_97.8682.pth --out_dir output/

下面是疲劳驾驶检测和识别的效果展示:

|  |

|  |

|  |

(6) 一些优化建议

如果想进一步提高模型的性能,可以尝试:

- 增加训练的样本数据: 建议根据自己的业务场景,采集相关数据,比如采集多个人的疲劳驾驶的数据,提高模型泛化能力;

- 使用参数量更大的模型: 本教程使用的是mobilenet_v2模型,属于比较轻量级的分类模型,采用更大的模型(如resnet50),理论上其精度更高,但推理速度也较慢。

- 尝试不同数据增强的组合进行训练

- 增加数据增强: 已经支持: 随机裁剪,随机翻转,随机旋转,颜色变换等数据增强方式,可以尝试诸如mixup,CutMix等更复杂的数据增强方式

- 样本均衡: 原始数据疲劳驾驶识别类别数据并不均衡,类别notsmoking的样本数据偏多,而smoking数据偏少,这会导致训练的模型会偏向于样本数较多的类别。建议进行样本均衡处理。

- 清洗数据集:原始数据已经进行人工清洗了,但依然存在一些模糊的,低质的,模棱两可的样本;建议你,在训练前,再次清洗数据集,不然会影响模型的识别的准确率。

- 调超参: 比如学习率调整策略,优化器(SGD,Adam等)

- 损失函数: 目前训练代码已经支持:交叉熵,LabelSmoothing,可以尝试FocalLoss等损失函数

(7) 一些运行错误处理方法

-

大部分异常都可以看这里解决:项目开发使用教程和常见问题和解决方法

-

项目不要出现含有中文字符的目录文件或路径,否则会出现很多异常!!!!!!!!

-

cannot import name 'load_state_dict_from_url'

由于一些版本升级,会导致部分接口函数不能使用,请确保版本对应

torch==1.7.1

torchvision==0.8.2

或者将对应python文件将

from torchvision.models.resnet import model_urls, load_state_dict_from_url

修改为:

- from torch.hub import load_state_dict_from_url

- model_urls = {

- 'mobilenet_v2': 'https://download.pytorch.org/models/mobilenet_v2-b0353104.pth',

- 'resnet18': 'https://download.pytorch.org/models/resnet18-5c106cde.pth',

- 'resnet34': 'https://download.pytorch.org/models/resnet34-333f7ec4.pth',

- 'resnet50': 'https://download.pytorch.org/models/resnet50-19c8e357.pth',

- 'resnet101': 'https://download.pytorch.org/models/resnet101-5d3b4d8f.pth',

- 'resnet152': 'https://download.pytorch.org/models/resnet152-b121ed2d.pth',

- 'resnext50_32x4d': 'https://download.pytorch.org/models/resnext50_32x4d-7cdf4587.pth',

- 'resnext101_32x8d': 'https://download.pytorch.org/models/resnext101_32x8d-8ba56ff5.pth',

- 'wide_resnet50_2': 'https://download.pytorch.org/models/wide_resnet50_2-95faca4d.pth',

- 'wide_resnet101_2': 'https://download.pytorch.org/models/wide_resnet101_2-32ee1156.pth',

- }

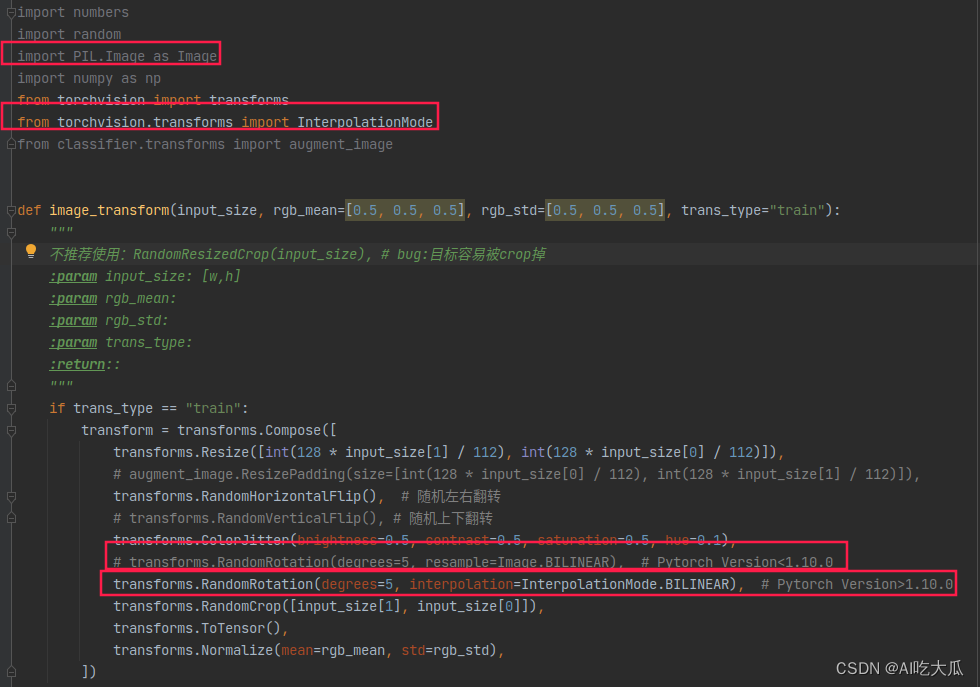

- cannot import name 'InterpolationMode' ,依然是版本问题

- # 如果你的Pytorch Version<1.10.0,则使用:

- import PIL.Image as Image

- transforms.RandomRotation(degrees=5, resample=Image.BILINEAR)

- # 如果你的Pytorch Version>1.10.0,则使用:

- from torchvision.transforms import InterpolationMode

- transforms.RandomRotation(degrees=5, interpolation=InterpolationMode.BILINEAR), #

5.项目源码下载(Python版)

项目源码下载地址:疲劳驾驶检测和识别2:Pytorch实现疲劳驾驶检测和识别(含疲劳驾驶数据集和训练代码)

整套项目源码内容包含:

提供疲劳驾驶检测数据集:包含Drowsy-Driving-Det1和Drowsy-Driving-Det1,总共13000+张图片;标注格式统一转换为VOC数据格式,其中人脸框标注了的两个状态:drowsy(疲劳),undrowsy(非疲劳),可用于深度学习疲劳驾驶目标检测模型算法开发。(本项目并未使用这个两个数据集)

提供疲劳驾驶分类数据集:包含Drowsy-Driving-Cls1,Drowsy-Driving-Cls2和Drowsy-Driving-Cls3,总共50000+张图片;所有人脸图片,都已经按照其所属类别存放于各自的文件夹下,可用于深度学习疲劳驾驶分类识别模型算法开发。(本项目主要使用Drowsy-Driving-Cls1,Drowsy-Driving-Cls2两个数据集)

- 提供疲劳驾驶分类模型训练代码:train.py

- 提供疲劳驾驶分类模型测试代码:demo.py

- Demo支持图片,视频和摄像头测试

- 支持自定义数据集进行训练

- 项目支持模型:resnet18,resnet34,resnet50, mobilenet_v2以及googlenet等常见的深度学习模型

- 项目源码自带训练好的模型文件,无需重新训练,可直接运行测试: python demo.py

- 在普通电脑CPU/GPU上可以实时检测和识别

6. C++实现疲劳驾驶检测识别

参考文章:疲劳驾驶检测和识别4:C++实现疲劳驾驶检测和识别(含源码,可实时检测)https://panjinquan.blog.csdn.net/article/details/131834980

7. Android实现疲劳驾驶检测识别

参考文章:疲劳驾驶检测和识别3:Android实现疲劳驾驶检测和识别(含源码,可实时检测)https://blog.csdn.net/guyuealian/article/details/131834970