- 1protues仿真微处理器8086实现交通灯_基于8086的智能交通灯设计

- 24万字c++讲解+区分c和c++,不来可惜了(含代码+解析)_如何分辨c和c++代码

- 3OWASP ZAP的使用教程_owaspzap使用教程

- 4Java——继承(含习题)_继承 练习题

- 5鸿蒙OS开发学习:【第三方库调用】_鸿蒙三方库

- 6前序遍历、中序遍历、后序遍历、层序遍历_前序遍历 中序遍历 后序遍历

- 7位运算符,位移运算符,交换变量,go语言_go int 移位

- 8计算机视觉学习14:图像分割----Graph Cut_watershed algorithm、minimum cut normalized cut和gra

- 9Golang运算符介绍_golang 三元运算符

- 10git上传gitee(超过100MB的文件问题)_gitee lfs

【comfyUI基础教程②】官方文档翻译和场景使用补充,纯干货!(二、核心节点解读之高级和部分条件节点)_comfyui 语法

赞

踩

目录

传送门:【comfyUI基础教程】(一、安装开始和使用技巧)

加载模型(带配置)(Load Checkpoint (With Config))

Apply ControlNet(应用 ControlNet 节点)

应用样式模型节点(Apply Style Model node)

CLIP 文本编码 (提示) 节点 (CLIP Text Encode (Prompt) Node)

前言:

本文主体来源是ComfyUI官方社区文档页面,由AI漫谈社整理翻译。由于官方文档还在更新,尤其缺少很多节点的使用说明、场景样例和常见其他自定义节点的补充说明。我也会在接下来持续翻译整理并补充这部分内容。

网页浏览效果不好,大家可以微信搜一搜AI漫谈社或者扫描文末的二维码关注我。发送“官方文档”获取以最新的完整中英文对照PDF文档下载链接。还有更多实用工作流持续更新分享!

高级

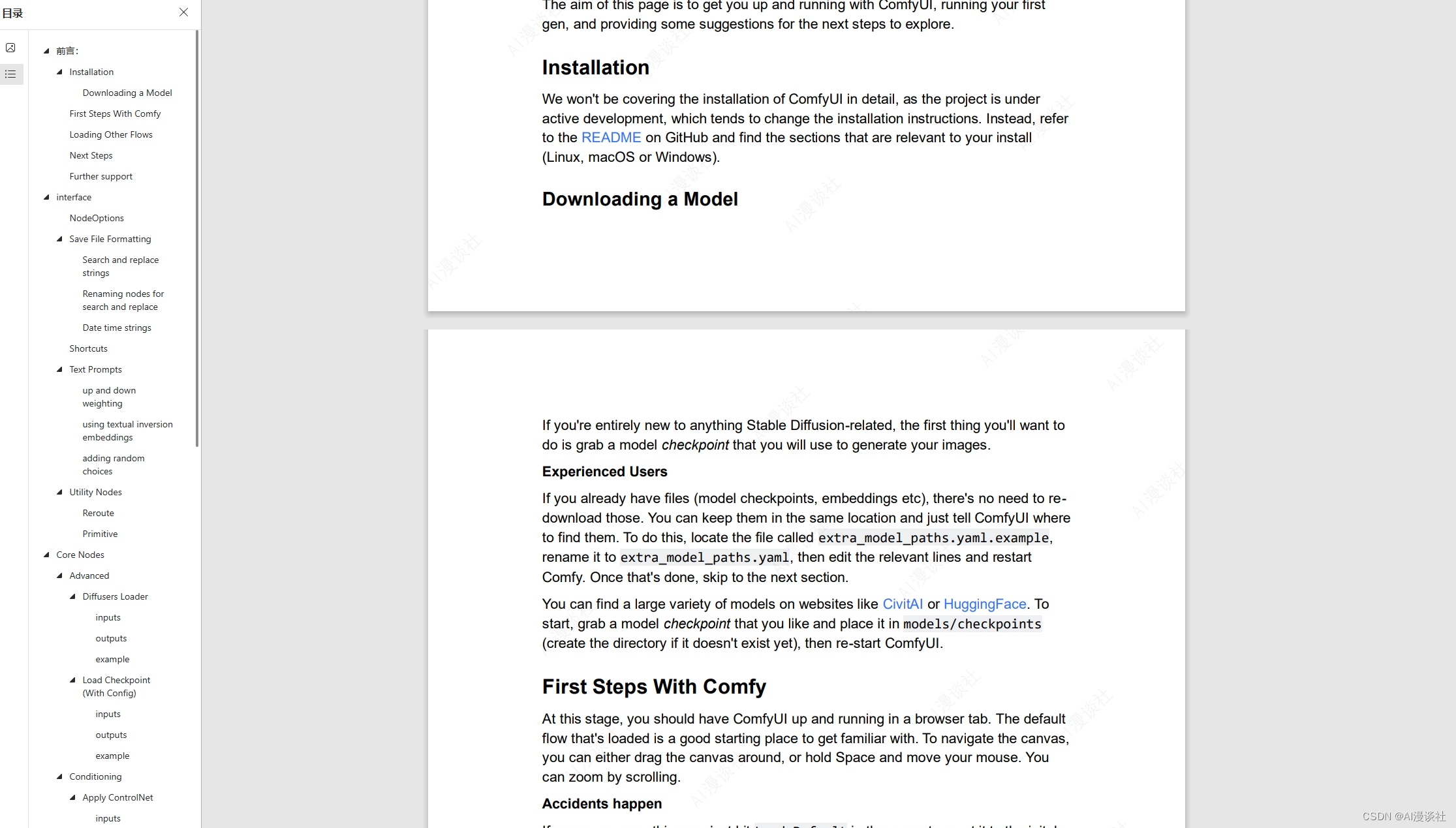

扩散模型加载器(Diffusers Loader)

扩散器加载器节点可用于从扩散器加载扩散模型。

model_path

扩散器模型的路径。

MODEL

用于去除噪声的模型。

CLIP

用于编码文本提示的CLIP模型。

VAE

用于编码和解码进出潜空间的图像的VAE模型。

使用上面的文生图例子即可

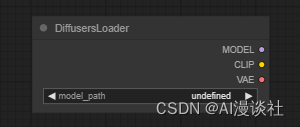

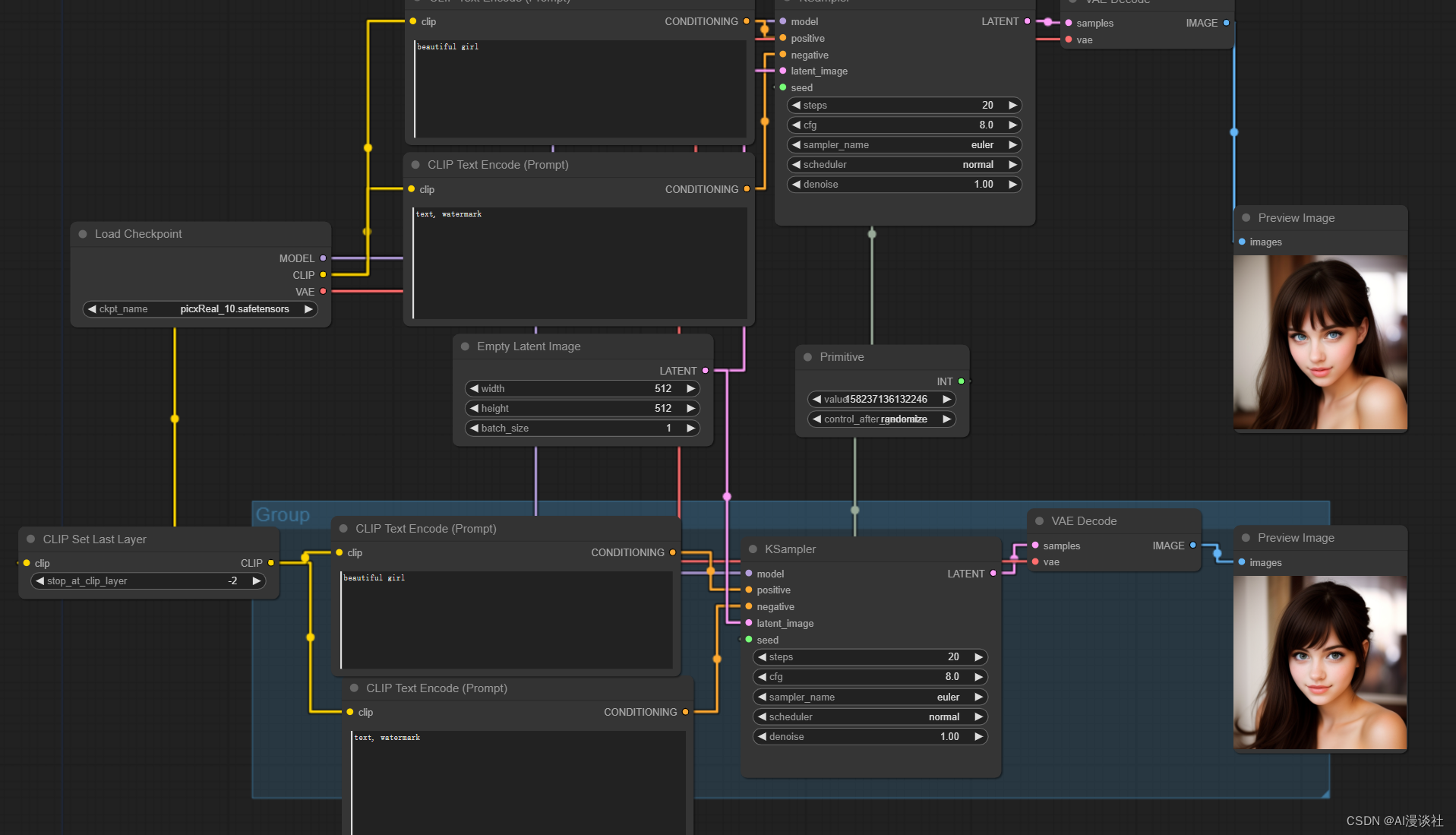

【补充解读】:这是最基础也是基本所有流程都要用到的节点,我们还是从完整的文生图流程来看:

可以把整个流程看成是私房菜馆

Diffusers Loader 节点所输出内容含义如下

MODEL:这个私房菜馆的菜系特点和原料储备,所有的成品都是在此基础上诞生的

CLIP: 代表点餐员的理解力,CLIP TEXT ENCODE 节点就是点菜员了。由于是私房菜馆没有菜单,需要一名点餐员去听你描述你的需求,理解并转述给厨房出餐。

VAE: 代表送餐员的取菜单,VAE decode节点就是送餐员。毕竟私房菜馆的厨房大都是保密的,他就专门负责将对应的“菜品”从厨房拿出来并送到你手上。

Empty Latent 节点相当于盛菜的容器,容器越大,菜品也越大。

Ksampler节点自然就相当于大厨了。他负责融汇所有的需求,勾勒出你想要的结果。

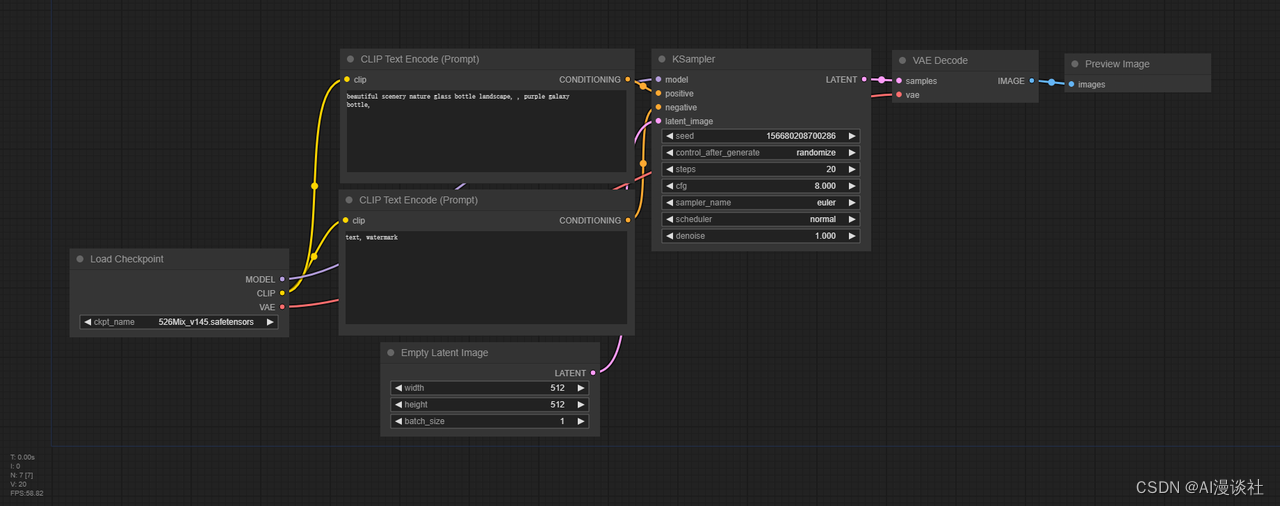

加载模型(带配置)(Load Checkpoint (With Config))

Load Checkpoint(With Config)节点可用于根据提供的配置文件加载扩散模型。请注意,在大多数情况下,常规加载模型节点能够自适应适当的配置。

【补充解读】:不懂配置和模型的关系,就没有必要自己随便调整

config_name

配置文件的名称。

ckpt_name

要加载的模型的名称。

MODEL

用于去除噪声的模型。

CLIP

用于编码文本提示的CLIP模型。

VAE

用于编码和解码进出潜空间的图像的VAE模型。

使用上面的文生图例子即可

条件设置节点(Conditioning)

在 ComfyUI 中,Conditioning(条件设置)被用来引导扩散模型生成特定的输出。所有条件都以CLIP使用Clip Text Encode节点嵌入的文本提示开始。然后,可以通过此段中的其他节点进一步增强或修改这些条件。

例如,使用某些绘制朝向组合节点如条件设置(Set Area)、条件设置(Set Mask)或GLIGEN Textbox Apply节点。

或者通过应用样式模型、应用ControlNet或unCLIP调节等节点提供额外的视觉提示。相关节点的完整列表可以在侧边栏中找到。

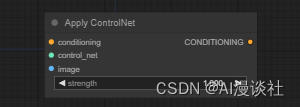

Apply ControlNet(应用 ControlNet 节点)

ControlNet 节点可用于为扩散模型提供进一步的视觉指导。与unCLIP嵌入不同,ControlNet和T2I适配器适用于任何模型。通过将多个节点链接在一起,可以使用多个ControlNet或T2I适配器指导扩散模型。这可以通过向该节点提供包含边缘检测的图像以及在边缘检测图像上训练的ControlNet模型来提示最终图像中的边缘应该在哪里。

Info

| 要使用T2IAdaptor样式模型,请参阅Apply Style Model 节点 |

conditioning

条件输入

control_net

一个已经训练过的controlNet或T2IAdaptor,用来使用特定的图像数据来引导扩散模型

image

引导扩散模型视觉的图像

CONDITIONING

经过controlNet和视觉图像引导过的新的条件设置输出

使用文生图流程

【补充解读】:官网纯纯懒狗,示例的文生图根本就不能代表这个节点的流程。

controlnet光基础模型的功能扩展起来就很多,这里就不详述了。只要知道它相当于引导我们最终生成的图像的骨架就行。比如常用的利用图形边缘约束,如下所示。

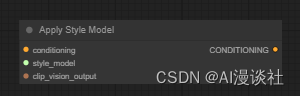

应用样式模型节点(Apply Style Model node)

应用样式模型节点可用于为扩散模型提供进一步的视觉指导,特别是与生成图像的样式相关的扩散模型。该节点采用T2I样式适配器模型和来自CLIP视觉模型的嵌入,以引导扩散模型朝着CLIP视觉嵌入的图像样式前进。(使用方式和controlnet没区别)

CONDITIONING

条件

style_model

T2I风格的适配器。

CLIP_vision_output

包含所需样式的图像,由CLIP视觉模型编码。

CONDITIONING

是一个包含T2I风格适配器和对期望风格的视觉指导的条件。

【补充解读】:功能上和controlnet 模型一致,都是控制引导图像生成,但comfyUI的作者更推荐他。因为

“T2I-Adapter 比 ControlNet 高效得多,因此我强烈推荐它们。ControlNet 会显着降低生成速度,而 T2I 适配器对生成速度的负面影响几乎为零。

在 ControlNets 中,ControlNet 模型每次迭代运行一次。对于 T2I-Adapter,模型总共运行一次。

T2I-Adapter 的使用方式与 ComfyUI 中的 ControlNet 相同:使用 ControlNetLoader 节点。”

使用方式如下图所示(使用方式也和controlnet没啥区别):

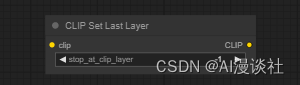

设置最后一层节点CLIP Set Last Layer

CLIP 设置最后一层节点 (CLIP Set Last Layer node)用于设置从哪个 CLIP 输出层获取文本嵌入。文本被编码成嵌入的过程是通过 CLIP 模型的多层变换实现的。虽然传统的扩散模型通常根据 CLIP 的最后一层的输出进行条件设定,但是有些模型组默认最后一层效果并不好。

clip

编码文本的 CLIP 模型。

CLIP

具有新设置输出层的CLIP模型

【补充解读】:很多时候设置为-2出图效果可能会更二次元。但还是需要根据情况自己尝试,效果如图所示。

CLIP 文本编码 (提示) 节点 (CLIP Text Encode (Prompt) Node)

CLIP Text Encode节点可用于将使用CLIP模型的文本提示编码作为嵌入,该嵌入可用于指导扩散模型生成特定图像。有关ComfyUI中所有文本提示相关功能的完整指南,请参阅此页面。

clip

用于编码文本的CLIP模型。

text

要编码的文本。

CONDITIONING

包含用于指导扩散模型的嵌入文本的条件。

【补充解读】:最最基础的节点之一,一般成对出现:一个用于正向提示词,一个用于图像反向提示词。反向提示词通用程度比较高,大多数情况可以用一套,大多是强调生成质量的如下所示:

例如:

Easynegative, negative_hand-neg, sketch, painting,(childish, childlike, child, minor, underage),nipples, nsfw,(worst quality:2), (low quality:2), (normal quality:2), lowres, ((grayscale)), ((monochrome)),

badly drawn hands, bad anatomy, bad proportions, asymmetric eyes, asymmetric face, long neck

crooked teeth, yellow teeth,(orange:1.4),text, watermark

其中nsfw比较特殊,是为了避免生成以下不健康的东西...

下一节将继续核心节点的使用介绍和场景样例,快点个关注吧!