热门标签

热门文章

- 1Python中函数的定义、函数可变参数传递以及简单示例_python可变参数如何定义

- 2支付宝新年五福新玩法,我用Python百行代码来实现!_支付宝扫福vr代码实现

- 3【计算机视觉】浅谈计算机视觉中的Transformer

- 4KVM_virt-install --console

- 5vue项目快速安装node-sass_vue安装node-sass

- 6archlinux安装到美化_archlinux reflector

- 7vue使用WebUploader做大文件的分块和断点续传_vue ts webuploader

- 8git 合并提交

- 9Eclipse通过jdbc连接SQLServer数据库_eclipse sqlserver数据源

- 10Ubuntu 20.04 安装 MySQL 8.0 并且远程连接数据库(包括后续遇到的新坑)_synchronizing state of mysql.service with sysv ser

当前位置: article > 正文

Pearl_pearl meta-rl

作者:繁依Fanyi0 | 2024-02-09 13:52:58

赞

踩

pearl meta-rl

用task encoding解决一下问题:

- 如何从过去学习的任务中针对新的任务获取有效的信息

- 如何对新任务的uncertainty作出更准确的判断

背景: 借用了POMDP的状态推理与学习分开的思想; 使用了SAC框架

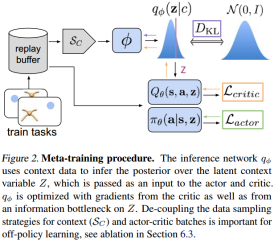

主要工作:本文Meta-learning的流程为,通过Meta-training过程,对过去积累的tasks experience进行encoding,相当于train出一个task encoder。随后,在Meta-testing的过程中,利用encoder来encoding新任务的关键信息,并在学习中不断地更新对新任务的判断,最后,使用encoder返回的信息进行新任务的learning过程。

Meta Test:完成encoder的training过后,面对一个新的任务,PEARL就可以非常自然的在学习中加入encoded过的信息,从而利用过去学习过的任务进行新任务的学习,即完成了Learn to learn。

总结:总结来说,这篇工作将task inference与learning过程分离的idea来自于POMDPs的探索过程,通过这样的分离,使得meta-RL中对样本的利用率提高了。但是元学习无法回避的对样本的依赖仍然没有解决,如何对learn to learn中的training sample进行选择,可能仍然是需要更多探索的问题。

感觉中的不足:此次的结果对比只和没有利用过expert data的数据进行对比,虽然确实快了一两个数量级,但是为体现出和metaBC之间对比的优势劣势,至少训练速度不占优。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/72275

推荐阅读

相关标签