- 1有什么比较好用的低代码开发平台?_无代码开发平台哪个好

- 2WordPress关键漏洞影响25000+站点;Cisco漏洞被勒索软件利用;朝鲜黑客瞄准全球国防公司 | 安全周报 0223

- 3Out-of-distribution Detection系列专栏(十)_oodl

- 4Pytest自动化测试框架详解_pytest框架详解

- 5kaggle:Digit Recognizer《手写数字识别》你的第一个图像识别竞赛项目_图像识别 竞赛

- 6LeetCode 单词接龙(bfs)_找到从 beginword 到 endword 的最 短转换序列的长度。转换需遵循如下规则:

- 7桥接生物信息学和化学信息学公开的方法数据库

- 8Python 的 os 库介绍_python os库详解

- 9【时序约束与分析】_spi时序约束

- 10运维(17) OHTTPS配置免费证书及宝塔网站管理配置_clear-site-data

大数据学习之HDP SANDBOX开始学习_hdp测试sandbox至少5种工具(可以是命令行或者ambari ui)

赞

踩

HDP

HDP是什么?

HDP全称叫做Hortonworks Data Platform。

Hortonworks数据平台是一款基于Apache Hadoop的是开源数据平台,提供大数据云存储,大数据处理和分析等服务。该平台是专门用来应对多来源和多格式的数据,并使其处理起来能变成简单、更有成本效益。HDP还提供了一个开放,稳定和高度可扩展的平台,使得更容易地集成Apache Hadoop的数据流业务与现有的数据架构。该平台包括各种的Apache Hadoop项目以及Hadoop分布式文件系统(HDFS)、MapReduce、Pig、Hive、HBase、Zookeeper和其他各种组件,使Hadoop的平台更易于管理,更加具有开放性以及可扩展性。

官网地址为:http://zh.hortonworks.com/

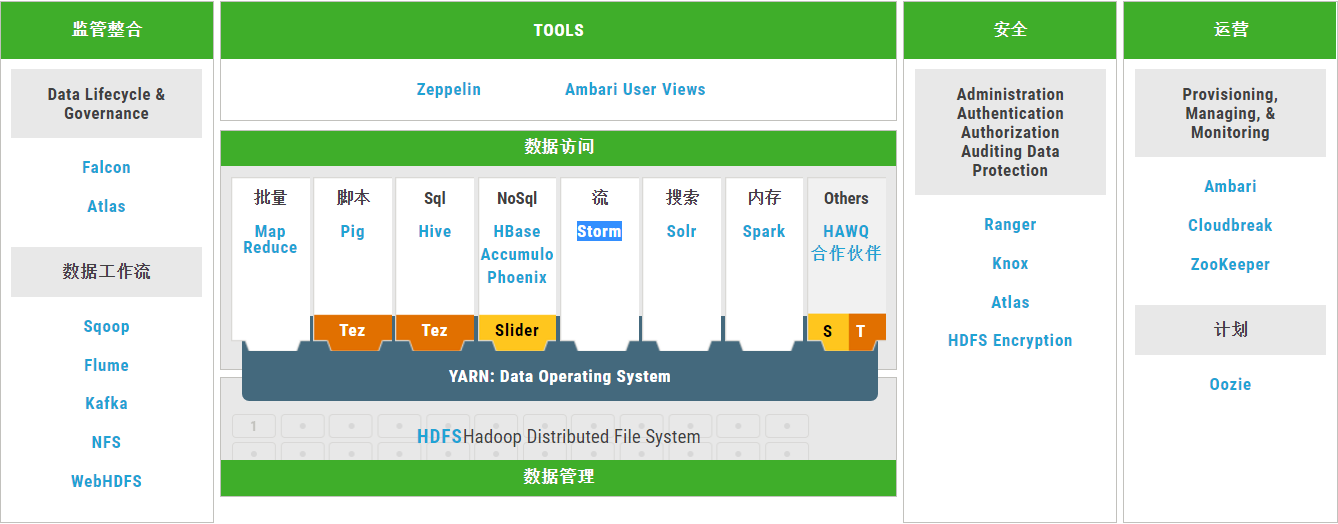

HDP的架构

学习路线:

由上图看出

大概分为这么几类工具:

数据管理:

HDFS、YARN

数据访问:

Hive、Tez、Pig、Storm、Spark、HBase、Accumulo、Solr

数据管制和集成:

Atlas、Falcon、Oozie、Sqoop、Flume、Kafka

安全性:

Knox、Ranger

运营:

Ambari Zookeeper

Cloud:

Cloudbreak

既然没有什么具体的路线那么就是一个类一个类的来学习好了。

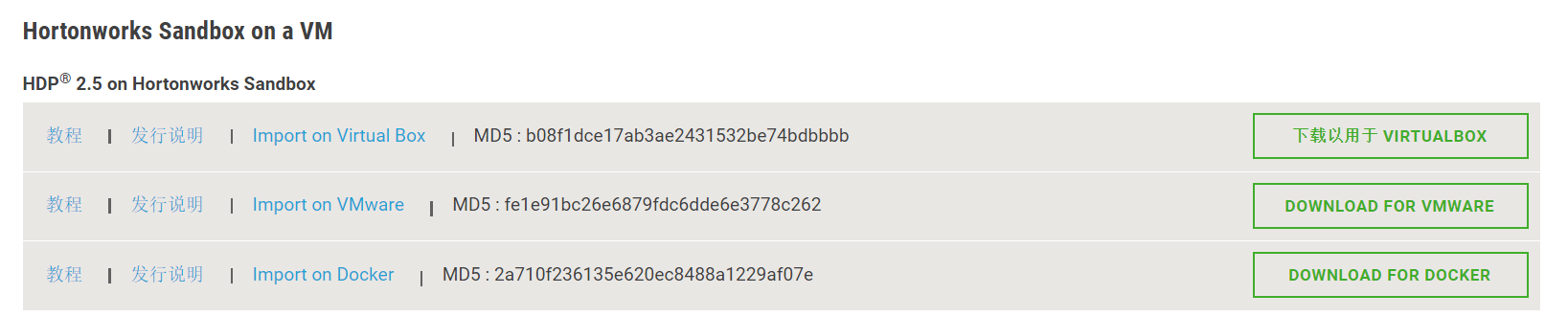

Hortonworks Sandbox的安装与使用:

官网上解释:Hortonworks Sandbox,可以使用它尝试一下最新的hdp特性和功能。

它可以装在一个VM上,如此来说,给我们学习大数据相关内容提供了极大的便利

下载地址:http://zh.hortonworks.com/downloads/#sandbox

安装的方法很简单,使用相应的虚拟机软件,直接导入就OK了。

注意:我的笔记本电脑是12g内存的,而HDP2.5所需要的最小内存是8G,而如果你的内存不够,可以选择低版本的SANDBOX。

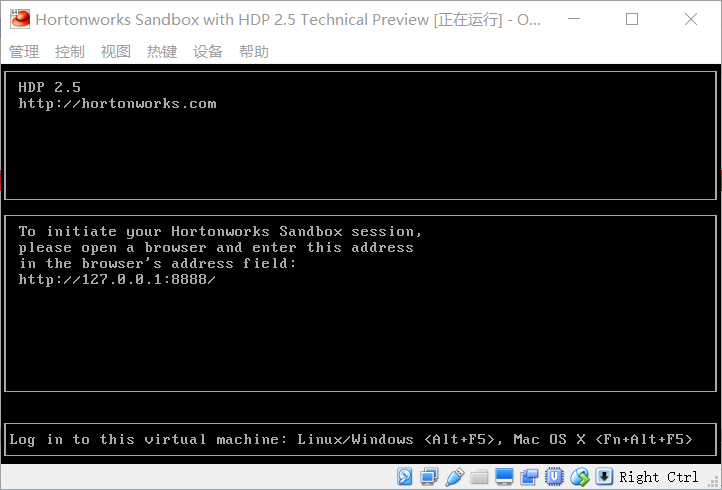

安装后,开启虚拟机就可以了

启动的过程可能会很久要耐心等待。

启动如下图所示:

打开浏览器,输入http://127.0.0.1:8888/即可。

进入后可以点开 view advanced options来查看更多的信息。

右下角有如下内容:

* Service disabled by default. To enable the service you need to log in as an ambari admin.

The ambari admin password can be set by following this tutorial

这里需要我们进行ssh登录后,添加admin账户的密码,并使用这个admin账户来登录虚拟机。

ssh工具登录使用地址127.0.0.1 端口为 2222

这里也可以使用浏览器进行登录:

在浏览器里输入127.0.0.1:4200,访问即可

用户名:root

密码: hadoop

登录后需要修改密码,这里的密码设置复杂一些,简单密码有可能通不过(不过经过本人测试,当你以后再次登录后,可以运行passwd root,修改成任意你想要的密码)

然后运行ambari-admin-password-reset命令,修改ambari的admin账户密码。

修改后,我们在浏览器里输入172.0.0.1:8080,并用admin账户登录。

截张图,

关于ambari的介绍如下: