- 1Tomcat中部署Web应用的四种方式_tomcat配置web项目

- 2【C/C++ 13】C++11高效特性

- 3推荐软考刷题工具

- 4计算机高级应用都有啥,计算机二级MS OFFICE高级应用都有什么题型?

- 5TS class类的定义、extends类的继承、属性修饰符、implements类的接口实现、abstract抽象类_ts implements

- 6chatgpt赋能python:Python自动打开软件:实现轻松便捷的操作_python 打开软件

- 7STM32之USART

- 8OpenCV-Python系列(二)—— 图像处理(灰度图、二值化、边缘检测、高斯模糊、轮廓检测)_使用opencv将图片转化为灰度图像 把灰度图像转化为二值度图像 使用foundcontours

- 9class extends实现继承

- 10java中hash算法实现原理_HashSet实现原理分析(Java源码剖析)

Meta祭出元宇宙「阿拉丁神灯」!LeCun称世界模型将带来像人一样的AI

赞

踩

视学算法报道

编辑:桃子 好困 袁榭 拉燕

【新智元导读】2022年2月24日凌晨,在Meta AI实验室讨论会上,小扎亲自带队公布了多项技术内容:语音生成元宇宙场景的Builder Bot、让AI赶上人类智慧的「世界模型」、超级AI助手CAIRaoke等等。

「Builder Bot,带我去海边转转。」

「再来点云吧。」

小扎一句话,阳光沙滩,蔚蓝大海,一缕云彩就出现了。

要知道,这些都是人工智能生成的(all AI-generated)。

Meta的首席执行官扎克伯格在今天「用人工智能构建元宇宙」的讨论会上,首次展示了用人工智能系统Builder Bot创建虚拟空间的过程。

只要你一句话,它便可以生成或者导入你想要的虚拟世界。

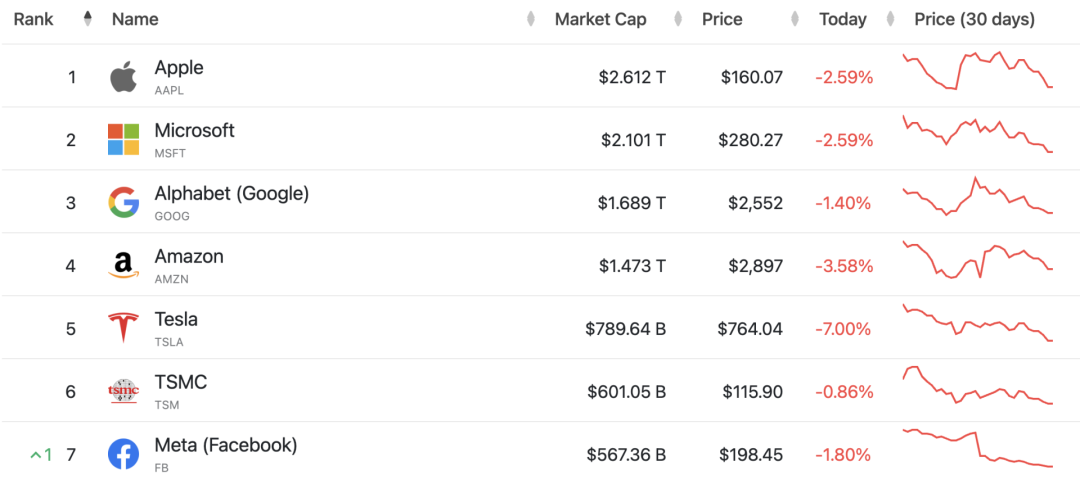

自从2021年11月31日,Facebook改名Meta后,市值被抹去了5000亿美元,可见全力奔向元宇宙的代价可不小。

第四季度财报公布后,Meta市值一夜蒸发2000多亿美元。不管怎么说,现在Meta市值排名也算是回归前十。

Builder Bot:让你说话有分量

市值惨跌,小扎对元宇宙的初心不改。

从「带我们去海边」开始,小扎的一系列语言命令,让AI在其周围一步步地创建了一个海边的卡通3D景观。

演示中还创建了公园、海中岛屿、椰子树、桌子、饮品等等。

更炫酷的是,Builder Bot还可以播放热带等各种音乐。

会上,小扎并没有具体说明Builder Bot究竟是基于有限人工创建的模型库,还是AI对任何内容能够实现自动生成。

作为人工智能项目CAIRaoke的一部分,Builder Bot的研发最终是为了可以吸引更多的人进入Meta的元宇宙社交平台Horizon。它还可以推进创造性人工智能技术前进,为机器生成的艺术提供动力。

目前,许多科技公司的人工智能项目已经演示了基于文本描述进行图像生成,包括OpenAI的 DALL-E、英伟达的GauGAN2和VQGAN+CLIP,以及更易访问的应用程序,如Dream by Wombo。

DALL-E生成的牛油果座椅

但是,目前这些项目仅能生成2D图像,而且还不带附件,而3D对象生成还处于研究阶段。

正如Meta在演示中所描述的那样,Builder Bot可以通过使用语音来生成3D对象,而Meta更加雄心勃勃的目标是交互。

扎克伯格表示,「你将能够创造微妙的世界,用你的声音探索并与他人分享经验。」

目前,Builder Bot目前还在测试中,暂时还未开放,因为Meta也不知道当前系统的局限性在哪。

如果用户要求提供不适当的内容,或者人工智能的训练再现了人类对世界的偏见和刻板印象,那么人工智能会带来许多问题。

此外,扎克伯格承认,「如果用户想要创建一个理想当然的事物,可能还真做不到。复杂的交互性带来了重大挑战。」

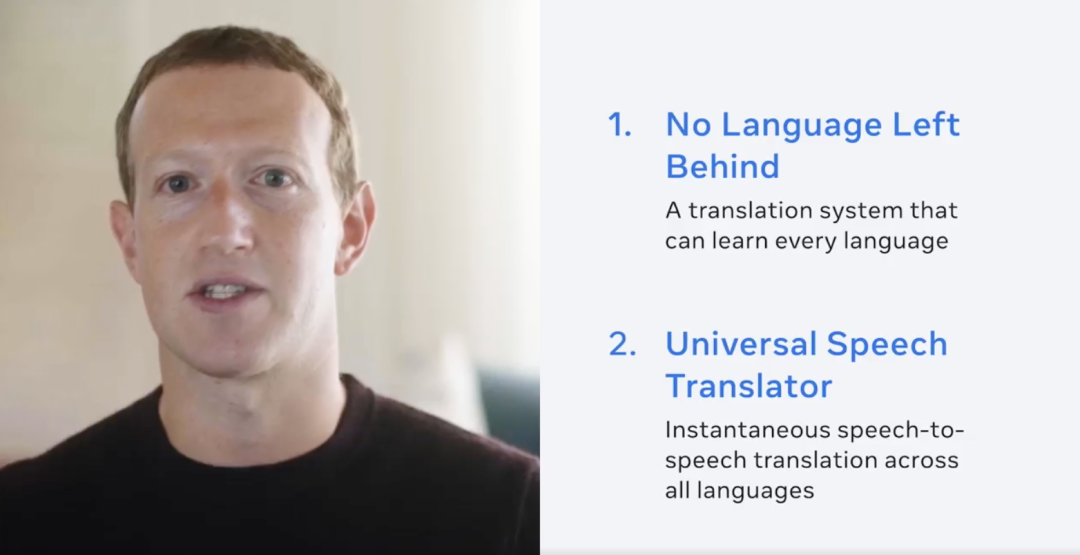

因此,这次会议上Meta公布了关于构建元宇宙的人工智能计划,其中就包括通用语言翻译系统、对话AI系统CAIRaoke,人工智能推荐系统TorchRec等。

此外,小扎介绍Meta还大力投资自监督学习(SSL) ,将类人认知构建到人工智能系统中。

并不是说需要喂大量标记好的数据来训练人工智能,而是输入原始数据,然后要求预测缺失的部分,让AI学会如何构建抽象表示。

在了解这些AI项目之前,不如先听听图灵奖得主Yann LeCun对当前人工智能的看法吧。

LeCun的愿景:让AI像人一样学习和推理

尽管AI研究最近取得了显著进展,但距离创造出能像人类一样思考和学习的机器,还有很长的路要走。

正如Meta AI首席人工智能科学家Yann LeCun所指出的,一个从未坐在方向盘后的少年可以在大约20小时内学会驾驶,而当今最好的智能驾驶系统AI需要数百万或数十亿条带标签的训练数据和数百万次在虚拟环境中的强化学习试验。

即便如此,它们也达不到与人类同等可靠的汽车驾驶能力。

构建接近人类智能的AI需要什么? 仅仅堆更多数据和更大模型就能搞定吗?

2022年2月24日Meta AI实验室新闻发布会中,LeCun为构建人类智能级别的AI勾画出另一种愿景。LeCun提出,AI学习「世界模型」(世界如何运作的内部模型)的能力可能是关键。

AI「世界模型」

LeCun提到了人类和动物的学习模式:「我常扪心自问,人类和动物使用了哪些我们无法在机器学习中复制的方法。人类和非人类动物学习大量关于世界如何运作的背景知识的方式,是观察,以及用独立于任务、无人监督方式进行的少量互动。可以假定,这种积累的知识可能构成了通常被称为常识的基础。」

常识可以被视为世界模型的集合,可以指导智能体何种行为可能、何种行为合理、何种行为不可能。

这使人类能够在不熟悉的情况中有效地预先计划。例如,一名少年司机以前可能从未在雪地上驾驶,但他预知雪地会很滑、如果车开得太猛将会失控打滑。

常识性知识让智能动物不仅可以预测未来事件的结果,还可以在时间或空间上填补缺失的信息。当司机听到附近有金属撞击声时,即使没有看到撞车现场,他也能立即知道车祸发生。

LeCun称:「我认为机器学习缺失的是人类和动物如何学习世界模型,即学习世界如何运作的能力」。

他引述了Bengio提到的首次到英国的人如何学习左侧驾驶的例子,「物理法则不会改变」,例如汽车方向盘怎么打,这就是个「世界模型」的例子。

人类、动物和智能系统使用世界模型的想法,可以追溯到数十年前的心理学、机械控制和机器人等学科。

LeCun提出,当今人工智能最重要的挑战之一是设计学习范式和架构,使机器能够以自监督的方式学习世界模型,然后用这些模型进行预测、推理和计划。

他的提议重新组合了认知科学、系统神经科学、最优化机械控制、强化学习和「传统」人工智能等各个学科中的各种观点,并将它们与机器学习中的新概念相结合,如自监督学习和联合-嵌入式架构。

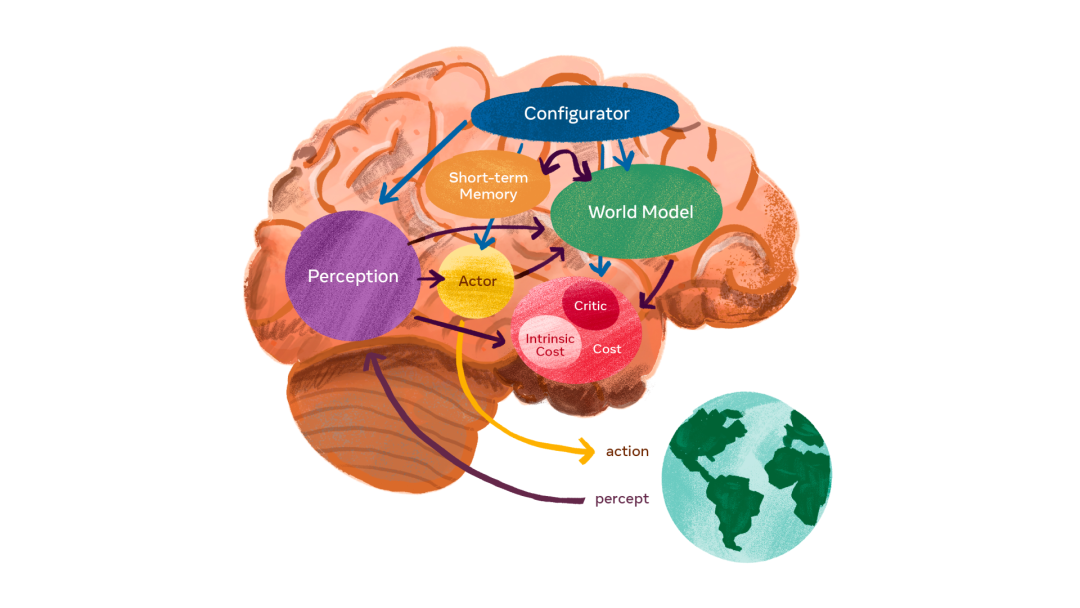

自主智能架构

LeCun提出了一个由六个独立模块组成的架构。

在每个模块中,都可以很容易地计算目标函数相对于其自身输入的梯度估计,并将梯度信息传递给上游模块。

自主智能的系统架构

1. 配置器模块负责控制任务的执行。

配置器模块会为特定的任务预先配置感知模块、世界模型、代价和行为者,并调节这些模块中的参数。

2. 感知模块负责接收来自传感器的信号并估计世界的当前状态。

对于一个特定任务来说,系统所感知到的世界状态只有一小部分是有用的。而通过与配置器模块的配合,感知模块可以提取与当前任务有关的信息。

3. 世界模型模块的作用有两点:(1)补全感知模块没有提供的信息;(2)预测合理的未来状态。

世界模型是一种与当前任务相关的世界模拟器,也是模型中最复杂的部分。它不仅可以预测世界的自然演变,也可以预测由行为者模块在一系列动作之后所产生的未来世界状态。

由于世界充满了不确定性,该模型必须能够涵盖多种可能的预测。

4. 代价模块负责计算一个单一的标量输出,并预测智能体的不适程度。

代价模块由两个子模块组成:(1)内在代价,用于直接计算(如对智能体的损害,违反硬编码的行为约束等),是不可训练的;(2)评价者,负责预测内在代价的未来值,是一个可训练的模块。

智能体的最终目标是在长期内使内在代价最小化。此外,代价的梯度可以通过其他模块反向传播,用于规划、推理或学习。

5. 行为者模块负责提供动作序列的建议。

行为者可以找到一个使未来代价最小化的最佳动作序列,并执行第一个动作,其方式类似于经典的最优控制。

6.短期记忆模块负责跟踪当前和预测的世界状态,以及相关代价。

世界模型和自监督训练

该架构的核心是预测世界模型。而建构它的关键挑战,是如何能使其呈现多种可能性的预测。

现实世界并不是完全可以单一预测的,特定情况的演变有多种可能途径,并且状况的许多细节与当下任务无关。人类司机可能需要预测驾驶时自己周围的汽车会做什么,但不需要预测道路附近树木中单个叶子的详细位置。

世界模型如何学习现实世界的抽象表示,从而保留关键细节、忽略不相关细节,且能在抽象表示的空间中进行预测?

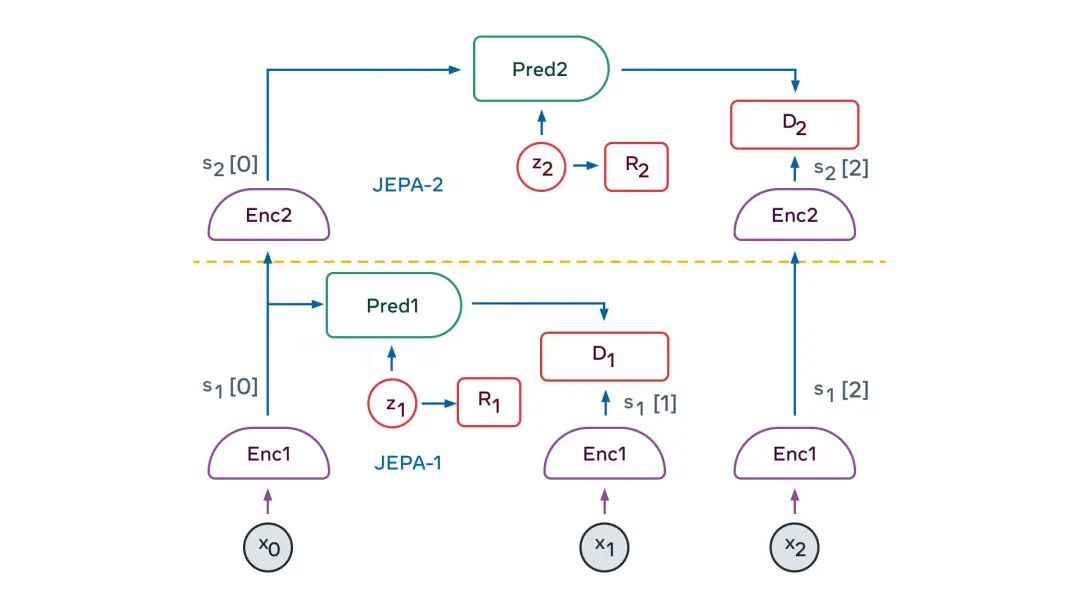

解决方案的关键要素是「联合嵌入式可预测架构」 (JEPA)。JEPA能捕获两个输入数据x和y之间的依赖关系。例如,x可以是一段视频,y可以是视频的下一段。输入数据x和y被馈送到可训练的编码器,这些编码器提取它们的抽象表示,即sx和sy。

训练预测器模块,以从sx预测sy。预测器可以使用潜在变量z来表示sy中存在但sx中不存在的信息。

JEPA以两种方式处理预测中的不确定性:(1)编码器可能会抛弃关于y的难以预测信息,(2)当潜在变量z在一个集合上有变化时,将导致在另一个可能性集合上的预测结果有变化。

JEPA如何训练?直到晚近,唯一的途径是使用对比方法,即提供足够多的兼容x和y的示例、兼容x但不兼容y的示例、不兼容x但兼容y的示例。

但是当抽象表示达到高维时,此方法不切实际。过去两年出现了另一种训练策略:正则化方法。当应用于JEPA时,该方法使用四个准则:

使关于x的表示,最大程度地提供关于x的信息

使关于y的表示,最大程度地提供关于y的信息

从关于x的表示中,最大程度地预测关于y的呈现

使预测器调用来自潜在变量的尽可能少的信息,来表示预测中的不确定性。

这些准则可以通过各种方式转化为可微的代价函数。其中一种方式是VICReg方法,它是「方差、不变性、协方差正则化」(Variance, Invariance, Covariance Regularization)的缩写。

在VICReg中,x和y表示的信息内容最大化方式,是将其分量的方差保持在阈值之上,并使这些分量尽可能地相互独立。同时,此方法试图让y的表示可以从x的表示中预测。此外,潜在变量的信息内容,被使其离散、低维、稀疏或噪声化的方式最小化。

JEPA的妙处,在于它自然地产生了关于输入信息的抽象表示,这些抽象表示消除了不相关的细节,基于其可以执行预测。

这使得JEPA可以相互堆叠,用来学习具有更高层次的、能藉以执行更长期预测的抽象表示。

例如,一个场景可以在高层次上抽象描述为「厨师正在制作法式薄饼」。

因此,人类智能可以预测:厨师会去取面粉、牛奶和鸡蛋;混合原料;把面糊舀进锅里;让面糊油炸;翻转薄饼;重复以上流程。

在低一级的层次上,人类智能可以预测:舀面糊动作,包括勺子舀面糊、倒进锅里、将面糊铺在锅面上。

这种层级的摊低可以一直持续到以毫秒为单位的厨师手部的精确运动轨迹。

在手部轨迹的低层次上,「世界模型」只能在短期内做出准确的预测。但在更高的抽象层次上,它可以做出长期的预测。

LeCun称:「我们应该让机器通过观察来学会现实世界中的最基础定律,这是让机器学习世界模型的最主要途径。」

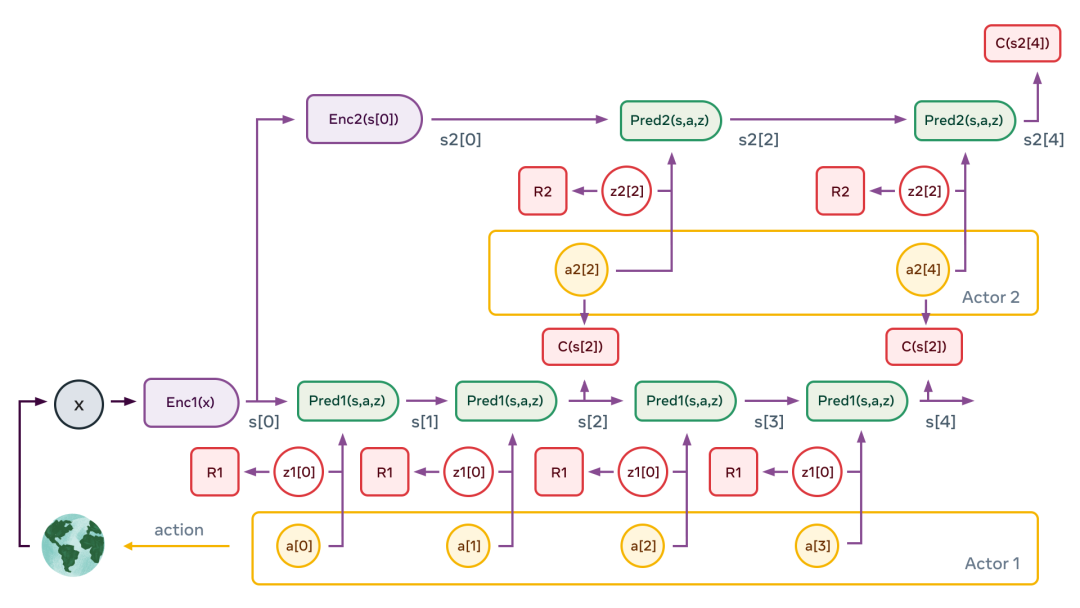

多层JEPA可用于在多个抽象级别和多个时间尺度上执行预测。训练的主要途径是被动观察,辅助途径是与环境互动。

正如婴儿在出生后头几个月,主要通过观察来了解世界是如何运作的。她了解到世界是三维的、有些物体排在其他物体的前面、当一个物体被遮挡时它仍然存在。

最终,在大约9个月大的时候,婴儿学会了直观的物理学——例如,不受支撑的物体会因重力而落下。

多层JEPA有望通过类似的观看视频、与环境交互等方式,来了解世界是如何运作的。

通过自训练来预测视频中会发生什么,它将产生世界的分层级表示。通过在现实世界上采取行动并观察结果,「世界模型」将学会预测其行动的后果,这将使其能够进行推理和计划。

举个例子

有了分层JEPA作为世界模型的适当训练,智能体就可以对复杂的动作进行分层规划,并将复杂的任务分解成一系列不那么复杂和抽象的子任务,一直到效应器上的低级动作。

两级层次结构

首先,感知模块提取世界状态的层次表示,s1[0]=Enc1(x),s2[0]=Enc2(s[0])。

接着,多次应用第二层的预测器,以预测未来的状态,并给同一层的行为者提出抽象的动作序列。

然后,行为者优化第二层动作序列,以使总代价最小化,C(s2[4])。

这个过程会重复对第二层的潜变量进行多次绘制,从而产生不同的高层方案。

不过,由此产生的高层次动作并不构成真正的动作,而只是定义了低层次状态序列必须满足的约束条件,进而构成真正子目标。

整个过程在低层重复:运行低层预测器,优化低层动作序列以最小化来自上层的中间代价,并对低层潜变量的多次绘制。

一旦这个过程完成,智能体就把第一个低层次的动作输出给效应器,整个情景也就可以重复进行。

如果能成功建立一个这样的模型,那么所有的模块都将是可微的。如此一来,整个动作的优化过程就可以用基于梯度的方式进行。

显然,LeCun的愿景需要更加深入的探索,其中最有趣也最困难的就是实例化世界模型的架构和训练程序的细节。

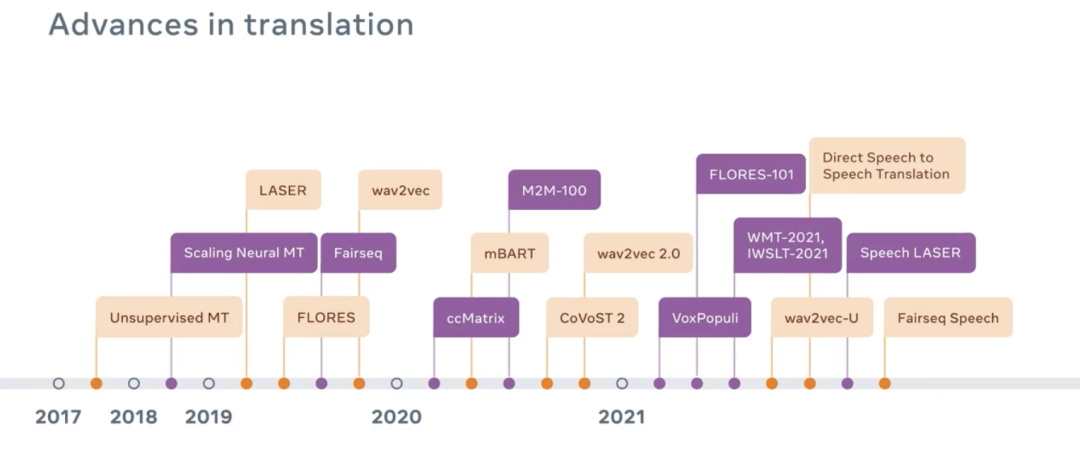

「万能」语音翻译系统

虽然训练世界模型可能会是未来几十年内让AI实现真正进步的主要挑战。

不过,让全世界所有人都能用自己的语言互相交流,似乎已经「胜利在望」了。

为了自己的元宇宙大局,Meta推出了一款堪称「万能」的翻译软件。

小扎表示,「能用任何语言和任何人沟通,是所有人一直都有的梦想。现在,AI可以帮我们实现这个梦想。」

尽管英语、汉语、西班牙语这类语言目前的翻译软件已经做得不错了,但还有差不多20%的世界语言没有被包括进去。

这类语言的语料库一般不太好获得,或者有时候压根就没有标准的书写系统。Meta将通过新的机器学习技巧来克服这些困难。

首先,Meta将会搭建一个可以使用较少训练样本的AI模型。其次,Meta的这款通用翻译语音翻译系统不需要文字作为中介,而是实时进行翻译。大部分翻译软件都会利用到文字作为中介。

从用户的角度来说,移除语言障碍可以让几十亿人用想用的语言上网,获得各类信息,还可以彻底改变所有人沟通和交往的方式。

从Meta自身来讲,这项技术的问世也可以帮助公司在世界范围内推广产品,扩大在全球范围内的影响力。这项技术会在未来成为AR和VR的关键技术。

翻译软件的底层技术存在着一些问题——机器学习往往会忽略说话者之前的一些细微差别。比如性别方面的差异和偏见。

另外,还有一些母语是非通用语言的人表示,「会担心大公司掌握翻译软件会让他们失去对本土语言和文化的控制」。

因此,尽管这款通用翻译软件的前景真的很诱人,但Meta要在实现技术的同时,向人们证明,作为一家有担当的公司,它可以公平地应用他们的技术和研究成果。

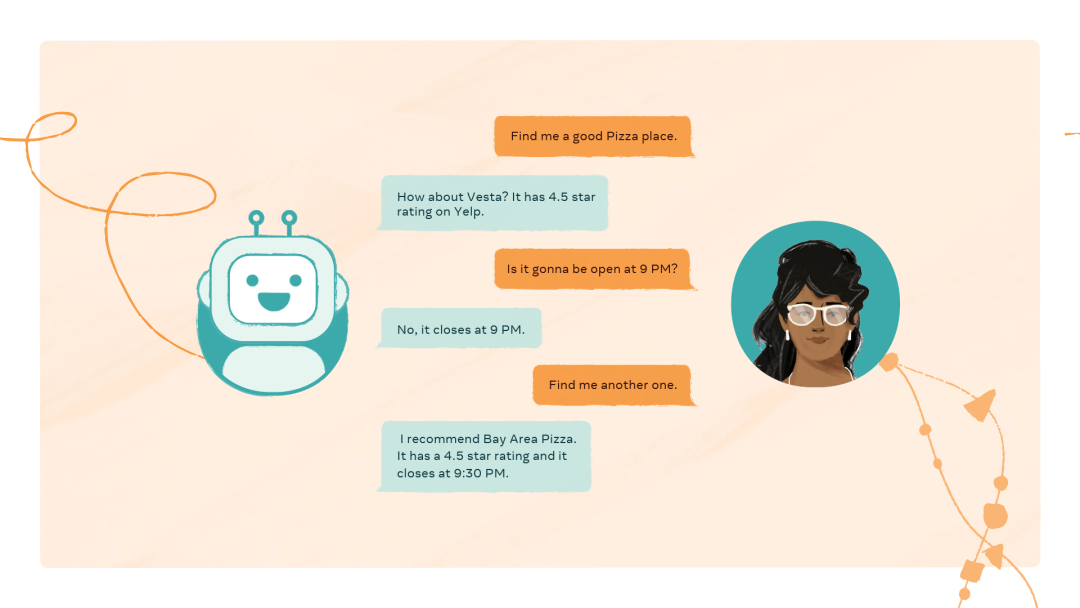

对话式超级AI助手

试想一下,如果和AI语音助手交流就像很人说话一样自如会是什么场景。就像,钢铁侠的智能AI助手贾维斯一样。

最近,Meta推出了一款AI语音助手——CAIRaoke项目。

这是一款端对端的神经模型,可以支持更加个性化、符合语境的对话,很像人和人之间的日常交流。

小扎甚至表示,CAIRaoke项目将是Meta的未来的核心。

设计出更会聊天的AI助手的困难主要集中在以下四个方面。自然语言理解(NLU)、对话状态跟踪(DST)、对话策略管理(DT)以及自然语言生成(NLG)。

这些系统必须被连接到一切,这就使得优化不那么容易,不能更好地适应新的或是不熟悉的任务,还会高度依赖劳动密集型注释数据集。

而CAIRRaoke设计出的模型就可以让人们更自如的和AI助手对话,可以再次提起之前对话中提到过的内容,改变话题,或是说一点需要细腻把握才能正确理解的内容。甚至还可以用手势或者别的新方式和AI助手进行互动。

目前,Portal已经使用了这项技术,用户可以轻松设置一个备忘录。

本文内容由网友自发贡献,转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/99162

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。