- 1Ceph的Block分析

- 2YOLOv1学习笔记以及代码介绍_yolov1代码

- 3CSS动画(1)_cssdonghua1

- 4【JAVA】数据存储位置

- 5pygame的安装_docker容器安装pygame

- 6ChatGPT 和文心一言哪个更好用? 这有什么好比的?!

- 7Windows 下 git的安装 + 可视化的小乌龟的安装

- 8最新 Node 初始化 vue 项目报错(npm init vue@latest)以及配置淘宝镜像(cnpm)

- 9基于JavaWeb学生成绩查询系统设计与实现(论文+源码)_kaic_java学生成绩管理系统界面设计

- 10什么是消息队列及消息队列原理和应用场景详解_消息队列和api有什么区别

机器学习 --- Adaboost_#encoding=utf8 from sklearn.tree import decisiontr

赞

踩

Educoder机器学习 --- Adaboost实训作业答案详解

目录

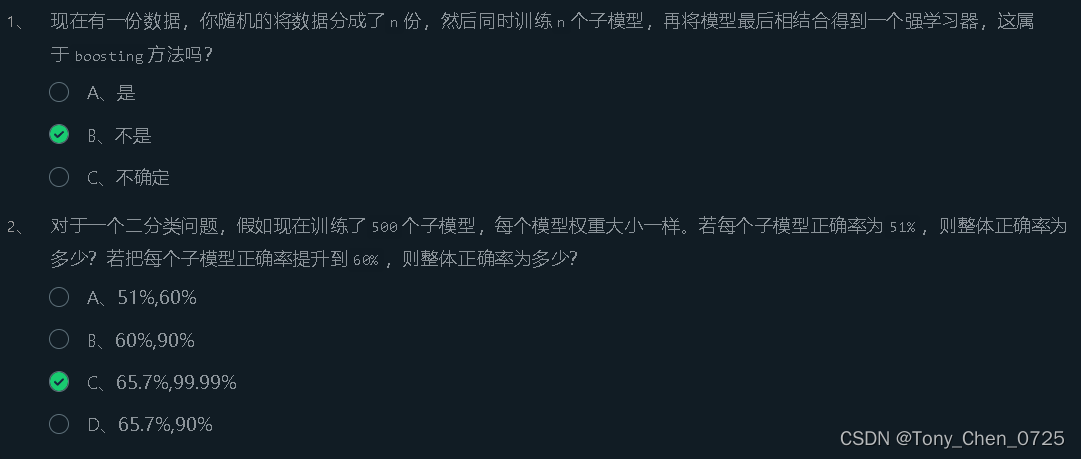

Boosting

什么是集成学习

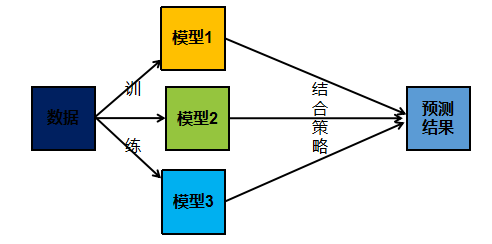

集成学习方法是一种常用的机器学习方法,分为 bagging 与 boosting 两种方法,应用十分广泛。集成学习基本思想是:对于一个复杂的学习任务,我们首先构造多个简单的学习模型,然后再把这些简单模型组合成一个高效的学习模型。实际上,就是“三个臭皮匠顶个诸葛亮”的道理。

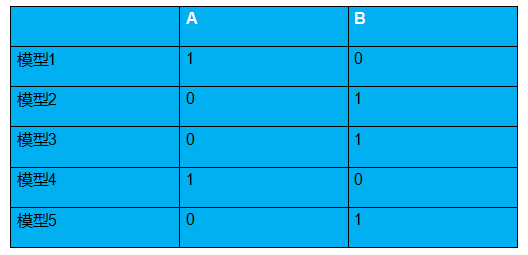

集成学习采取投票的方式来综合多个简单模型的结果,按 bagging 投票思想,如下面例子:

假设一共训练了 5 个简单模型,每个模型对分类结果预测如上图,则最终预测结果为: A:2 B:3 3>2 结果为 B

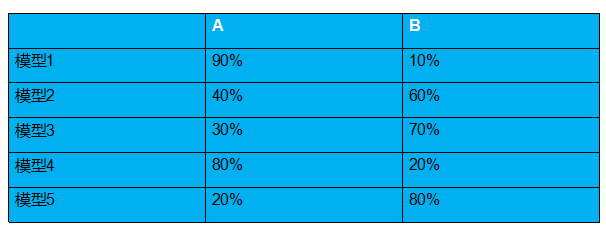

不过在有的时候,每个模型对分类结果的确定性不一样,即有的对分类结果非常肯定,有的不是很肯定,说明每个模型投的一票应该是有相应的权重来衡量这一票的重要性。就像在歌手比赛中,每个观众投的票记 1 分,而专家投票记 10 分。按 boosting 投票思想,如下例:

A:

(0.9+0.4+0.3+0.8+0.2)/5=0.52B:(0.1+0.6+0.7+0.2+0.8)/5=0.480.52>0.48结果为 ABoosting

提升方法基于这样一种思想:对于一个复杂任务来说,将多个专家的判断进行适当的综合所得出的判断,要比其中任何一个专家单独的判断好。

历史上, Kearns 和 Valiant 首先提出了强可学习和弱可学习的概念。指出:在 PAC 学习的框架中,一个概念,如果存在一个多项式的学习算法能够学习它,并且正确率很高,那么就称这个概念是强可学习的;一个概念,如果存在一个多项式的学习算法能够学习它,学习的正确率仅比随机猜测略好,那么就称这个概念是弱可学习的。非常有趣的是 Schapire 后来证明强可学习与弱可学习是等价的,也就是说,在 PAC 学习的框架下,一个概念是强可学习的充分必要条件是这个概念是弱可学习的。

这样一来,问题便成为,在学习中,如果已经发现了弱学习算法,那么能否将它提升为强学习算法。大家知道,发现弱学习算法通常要比发现强学习算法容易得多。那么如何具体实施提升,便成为开发提升方法时所要解决的问题。

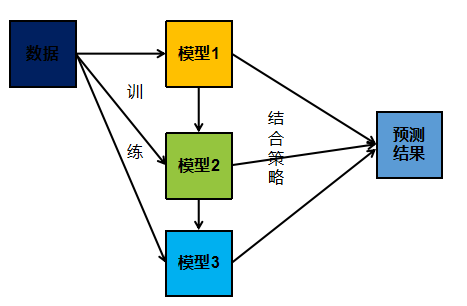

与 bagging 不同, boosting 采用的是一个串行训练的方法。首先,它训练出一个弱分类器,然后在此基础上,再训练出一个稍好点的弱分类器,以此类推,不断的训练出多个弱分类器,最终再将这些分类器相结合,这就是 boosting 的基本思想,流程如下图:

可以看出,子模型之间存在强依赖关系,必须串行生成。 boosting 是利用不同模型的相加,构成一个更好的模型,求取模型一般都采用序列化方法,后面的模型依据前面的模型。

第1关:Boosting

第2关:Adaboost算法

- # encoding=utf8

- import numpy as np

- from sklearn.tree import DecisionTreeClassifier

- from sklearn.ensemble import AdaBoostClassifier

-

-

- # adaboost算法

- class AdaBoost:

- '''

- input:n_estimators(int):迭代轮数

- learning_rate(float):弱分类器权重缩减系数

- '''

-

- def __init__(self, n_estimators=50, learning_rate=1.0):

- self.clf_num = n_estimators

- self.learning_rate = learning_rate

-

- def init_args(self, datasets, labels):

- self.X = datasets

- self.Y = labels

- self.M, self.N = datasets.shape

- # 弱分类器数目和集合

- self.clf_sets = []

- # 初始化weights

- self.weights = [1.0 / self.M] * self.M

- # G(x)系数 alpha

- self.alpha = []

-

- # ********* Begin *********#

- def _G(self, features, labels, weights):

- '''

- input:features(ndarray):数据特征

- labels(ndarray):数据标签

- weights(ndarray):样本权重系数

- '''

- e = 0

- for i in range(weights.shape[0]):

- if (labels[i] == self.G(self.X[i], self.clif_sets, self.alpha)):

- e += weights[i]

- return e

-

- # 计算alpha

- def _alpha(self, error):

- return 0.5 * np.log((1 - error) / error)

-

- # 规范化因子

- def _Z(self, weights, a, clf):

- return np.sum(weights * np.exp(-a * self.Y * self.G(self.X, clf, self.alpha)))

-

- # 权值更新

- def _w(self, a, clf, Z):

- w = np.zeros(self.weights.shape)

- for i in range(self.M):

- w[i] = weights[i] * np.exp(-a * self.Y[i] * G(x, clf, self.alpha)) / Z

- self.weights = w

-

- # G(x)的线性组合

- def G(self, x, v, direct):

- result = 0

- x = x.reshape(1, -1)

- for i in range(len(v)):

- result += v[i].predict(x) * direct[i]

- return result

-

- def fit(self, X, y):

- '''

- X(ndarray):训练数据

- y(ndarray):训练标签

- '''

-

- # 计算G(x)系数a

- self.init_args(X, y)

- '''

- for i in range(100):

- classifier = DecisionTreeClassifier(max_depth=3)

- classifier.fit(X, y)

- self.clf_sets.append(classifier)

- e = 0

- for i in range(len(self.weights)):

- temp = -1

- if classifier.predict(X[i].reshape(1,-1))>0:

- temp = 1

- if(self.Y[i] == temp):

- e += self.weights[i]

- a = self._alpha(e)

- self.alpha.append(a)

- z = self._Z(self.weights, a, self.clf_sets)

- self._w(a, self.clf_sets, z)

- '''

-

- # 记录分类器

-

- # 规范化因子

-

- # 权值更新

-

- def predict(self, data):

- '''

- input:data(ndarray):单个样本

- output:预测为正样本返回+1,负样本返回-1

- '''

- ada = AdaBoostClassifier(n_estimators=100, learning_rate=0.1)

- ada.fit(self.X, self.Y)

- data = data.reshape(1, -1)

- predict = ada.predict(data)

- return predict[0]

-

- # ********* End *********#

第3关:sklearn中的Adaboost

- #encoding=utf8

- from sklearn.tree import DecisionTreeClassifier

- from sklearn.ensemble import AdaBoostClassifier

- def ada_classifier(train_data,train_label,test_data):

- '''

- input:train_data(ndarray):训练数据

- train_label(ndarray):训练标签

- test_data(ndarray):测试标签

- output:predict(ndarray):预测结果

- '''

- #********* Begin *********#

- ada=AdaBoostClassifier(n_estimators=80,learning_rate=1.0)

- ada.fit(train_data,train_label)

- predict = ada.predict(test_data)

- #********* End *********#

- return predict

-

-

-

如果采纳,谢谢您的点赞和收藏!!!