- 1论文:TransVG: End-to-End Visual Grounding with Transformers

- 2GIt远程仓库pull拉取代码_git从远程仓库拉取代码

- 3php mysql制作个人博客系统_使用前端技术和MySQL+PHP制作自己的一个个人博客网站...

- 42021-11-01_aes替换des

- 5unity3d-常用组件_unity组件使用csdn

- 6一个简单的 HTML 个人网页模板_个人单页html

- 700后会自动化就想拿20K?不,你还差点远呢···

- 821 个问题看 NLP 迁移学习的最新进展_lm ptm

- 9深度学习000:有关的名词以及课程的架构_深度学习中的相关名词

- 10【golang】动态生成微信小程序二维码实战上:golang整合github.com/silenceper/wechat/v2 实现生成 小程序二维码图片_golang wechat getqrticket

OpenAI又一吹哨人离职!拉响安全警报,风险隐患实在太大

赞

踩

一水 发自 凹非寺

量子位 | 公众号 QbitAI

OpenAI离职潮中,又一研究员官宣离职,并且还发出了“警告”信息:

Ilya和Jan Leike的担忧正是我的担忧,还有一些额外的问题。

我们需要做更多事来改进决策流程等基础性的事务,包括问责制、透明度、文档、策略执行、如何谨慎使用技术,以及减轻不平等、权利和环境影响的措施。

主人公名叫Gretchen Krueger(简称格姐),是OpenAI的AI策略研究员。

她在2019年加入OpenAI,参与过GPT-4和DALL·E 2的开发工作,还在2020年领导了OpenAI第一个全公司范围的“红队”测试。

此番出走,除了提到OpenAI的决策透明度问题,她还隐约暗示:

一般来说,科技公司剥夺那些寻求追究其责任的人的权力的方法之一,就是在那些提出担忧或挑战其权力的人之间制造分裂。我非常关心防止这种情况发生。

算上Ilya和Jan Leike,格姐已经是这个月第3位从OpenAI离开的安全相关人员——她提交辞呈还是在Ilya和Jan Leike确认离职之前。

本月第3位离职的OpenAI安全成员

先来简单回顾整个事情。

格姐是OpenAI的AI策略研究员,关于这个岗位的职责,有网友帮大家在评论区科普了。

由于感受到OpenAI存在巨大安全风险,格姐于5月14日通知公司自己即将离职。

在这之后,OpenAI首席科学家Ilya正式宣布他将离开公司去追求“下一个计划”。

紧随Ilya离职的,还有斥责OpenAI“产品优先于安全”的超级对齐负责人Jan Leike。

那么,到底是什么风险使得格姐早就想跑呢?

总结下来其实很简单,但也很关键:OpenAI在安全问题决策上不够透明且缺乏对决策人的问责。

(AI透明度等)问题对所有人都很重要,它们影响着未来如何被规划、由谁来规划。

我想强调的是,这些担忧不应该被误读为狭隘、投机或脱节的。它们并非如此。

另外,格姐还特意提及了为了保留对OpenAI的批评权、放弃85%家庭资产的OpenAI前员工Daniel Kokotajio,表示感谢他的勇气,使她有机会说出想说的。

此前,OpenAI被曝离职需签封口协议,“不签字就会影响股权”。

这件事的最新进展由格姐的另一位前同事Jacob Hilton曝出:

在Vox的深度调查发表之后,OpenAI已经联系了前员工们,解除了此前签署的保密协议。

回到安全的话题上,格姐还是给老东家保留了体面:

OpenAI仍在领导这些重要的工作。我也将继续对此保持关注和兴奋。

不过格姐的出走,还是引发更多网友的好奇:

当Ilya等人还在的时候,OpenAI如何决定重大安全问题?

当一批重要安全成员离开后,OpenAI当前又如何决定安全问题?

谁决定OpenAI的安全路线?

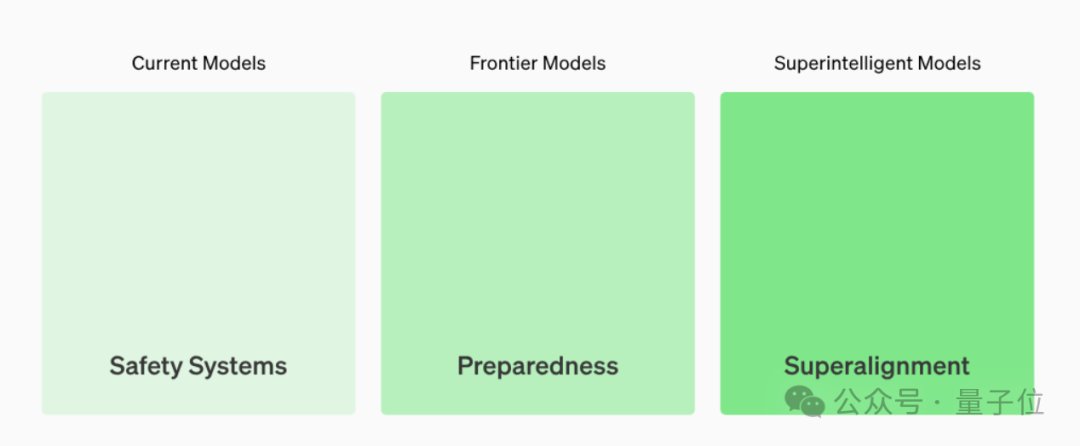

在关注谁握有最终决策权之前,我们先来看看OpenAI的安全团队有哪些。

从官网公布的信息来看,OpenAI目前的安全团队主要分为三大块。

超级对齐团队:拿出20%总算力,瞄准如何控制还不存在的超级智能

Safety Systems团队:专注于减少现有模型和产品(例如ChatGPT)的滥用

Preparedness团队:绘制前沿模型的新兴风险

首先,作为核心的超级对齐团队由Ilya和Jan Leike在2023年7月发起。

结果不到1年,两位灵魂人物接连出走,超级团队分崩离析。

其次,Safety Systems成立于2020年,该团队下面有4个部门,包括安全工程团队、风险管理团队、监控与响应团队以及政策与合规团队。

它曾负责了GPT-3和GPT-4的安全性评估。

当初领导它的Dario Amodei,后来离开OpenAI创办了Anthropic。

而且Dario Amodei之所以离职,原因恰恰在于想建立一个更可信的模型。

最后,OpenAI于2023年10月宣布建立Preparedness团队。

该小组由麻省理工可部署机器学习中心主任Aleksander Madry领导,旨在“跟踪、预测和防范未来人工智能系统的危险”,包括从AI“说服和欺骗”人类的能力(如网络钓鱼攻击),到恶意代码生成能力。

目前该团队主要进行模型能力评估、评价和内部红队(即对模型进行渗透测试的攻击方)。

说了这么多,但——

不管OpenAI有多少安全团队,其风险评估的最终决策权仍掌握在领导层手中。

宫斗风波之前,OpenAI核心管理团队中共有四名成员:CEO Sam Altman、总裁Greg Brockman、首席科学家Ilya Sutskever、CTO Mira Murati。

虽然一开始Ilya发动“宫变”让Sam Altman短暂下台,但很快奥特曼“熹妃回宫”,反而是Ilya“消失”了6个月。

且回归后的Sam Altman身边基本都是自己人了,包括最新顶替Ilya的Jakub。

不过关于安全问题的决策权,虽然领导层是决策者,但董事会拥有推翻决策的权利。

目前OpenAI的董事会成员包括,Salesforce共同首席执行官、董事会主席Bret Taylor,经济学家Larry Summers、Quora首席执行官Adam D’Angelo、前比尔及梅琳达·盖茨基金会CEO Sue Desmond-Hellmann、前索尼娱乐总裁Nicole Seligman、Instacart首席执行官Fidji Simo以及奥特曼本人。

参考链接:

[1]https://x.com/GretchenMarina/status/1793403475260551517

[2]https://futurism.com/the-byte/openai-cryptic-warning

— 完 —

量子位年度AI主题策划正在征集中!

欢迎投稿专题 一千零一个AI应用,365行AI落地方案

或与我们分享你在寻找的AI产品,或发现的AI新动向

点这里

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。