- 1智能合约常见10个漏洞_unchecked return value

- 2sha256加密_【总结】基于 FPGA 的 SHA256 高效数字加密研究(五)

- 3如何用编程代码来庆祝春节?_春节代码

- 4Nuxt+Vue3+TS+Vite入门教程_使用vue3框架搭建nuxt项目

- 5R语言(三)_r faithful数据

- 6LLaMA(大规模机器学习和分析)

- 7Chrome和edge报STATUS_STACK_BUFFER_OVERRUN错误的处理办法_错误代码:status_stack_buffer_overrun

- 8机器学习项目汇总,值得收藏!

- 9面向对象常见的4种开发方法_面向对象开发方法有几种

- 10[AIGC] Kafka 消费者的实现原理

文献学习-3-机器人操控辅助的全方位增强现实内腔介入远程手术

赞

踩

5.1.3 Robotic Manipulator‐Assisted Omnidirectional Augmented Reality for Endoluminal Intervention Telepresence

Key Words: omnidirectional augmented reality, robotic intervention, robotic telepresence

Authors: Zecai Lin, Zheng Xu, Huanghua Liu, Xuyang Wang, Xiaojie Ai, Cheng Zhou, Bidan Huang, Weidong Chen, Guang-Zhong Yang, and Anzhu Gao

Source: Advanced Intelligent Systems, 2024: 2300373

摘要: 机器人远程医疗可以为地理上偏远的危重病人提供及时治疗。 然而,由于缺乏深度信息、仪器遮挡和视角限制,患者对临床医生的视觉反馈通常不直观,这影响了手术安全性。在这里,开发了一种全方位增强现实(AR)辅助的机器人远程手术系统,用于介入医学。 使用单目摄像头作为增强现实设备,并结合操控器,通过多目标手眼校准、迭代最近点和图像叠加算法,在视频图像上叠加虚拟的关键解剖结构和仪器。 摄像头的视角可以通过操控器进行调整,从而可以从不同的方向观察关键解剖结构和仪器。 使用运动结构和多视图立体算法对患者一侧的场景进行重建,为操控器提供虚拟现实(VR)交互界面,以实现安全的远程操作。 进行了两个不同的假体实验来验证所提出方法的有效性。 最后进行了一项离体实验,涉及到猪腔内的介入性灵活机器人,操作者可以观察到该机器人。 所提出的方法将全方位增强现实和虚拟现实与机器人远程手术相结合,可以为临床医生提供直观的视觉反馈。

1. 研究背景

增强现实(AR)为精确的机器人远程手术提供了直观的方法,并且在机器人辅助手术中变得越来越重要。AR通过将计算机生成的虚拟物体叠加在真实场景上来增强用户的感知,这不仅可以增强病变的视觉效果,还可以虚拟可视化仪器。在AR辅助的机器人内腔手术中,医生可以快速识别关键解剖结构,并通过在真实场景上显示的术前规划轨迹来减少不必要的操作。

然而,用于重建表面的RGB-D相机的视角不能轻易改变,并且多视角不包括相机捕捉到的实际场景。此外,该系统不适用于内腔介入中使用的灵活手术机器人。在该团队之前的研究中,开发了一种基于增强现实的机器人远程手术系统,其中光学透视式头戴显示器安装在机械臂的末端,从不同的方向提供视图。 医生可以查看位于患者体内的关键解剖结构和工具。 然而,需要在头戴显示器的镜片后面安装额外的相机来监视其视图,这增加了系统的复杂性。 此外,商用头戴显示器增加了系统的成本,并且集成商用设备会阻碍二次开发。

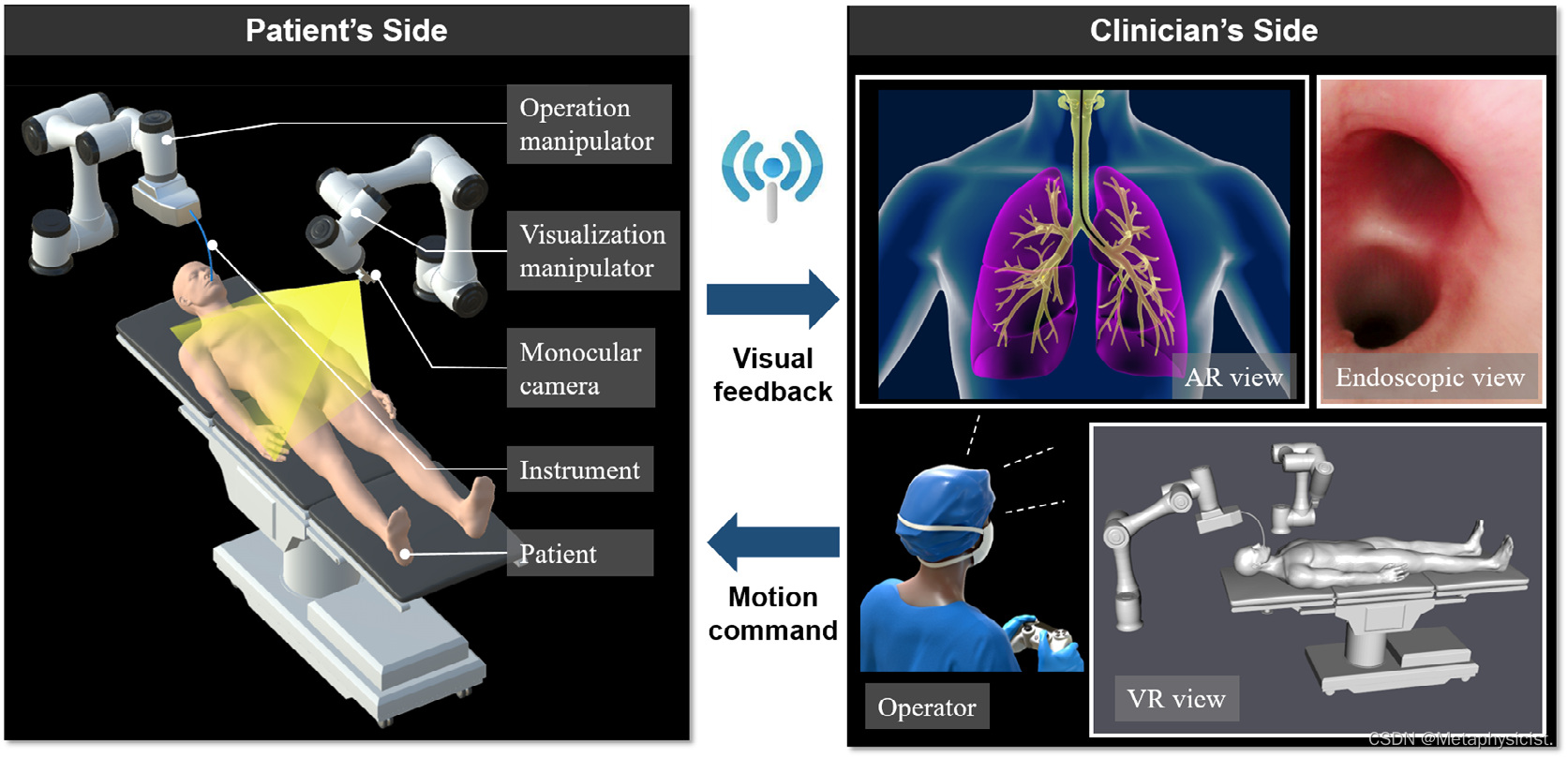

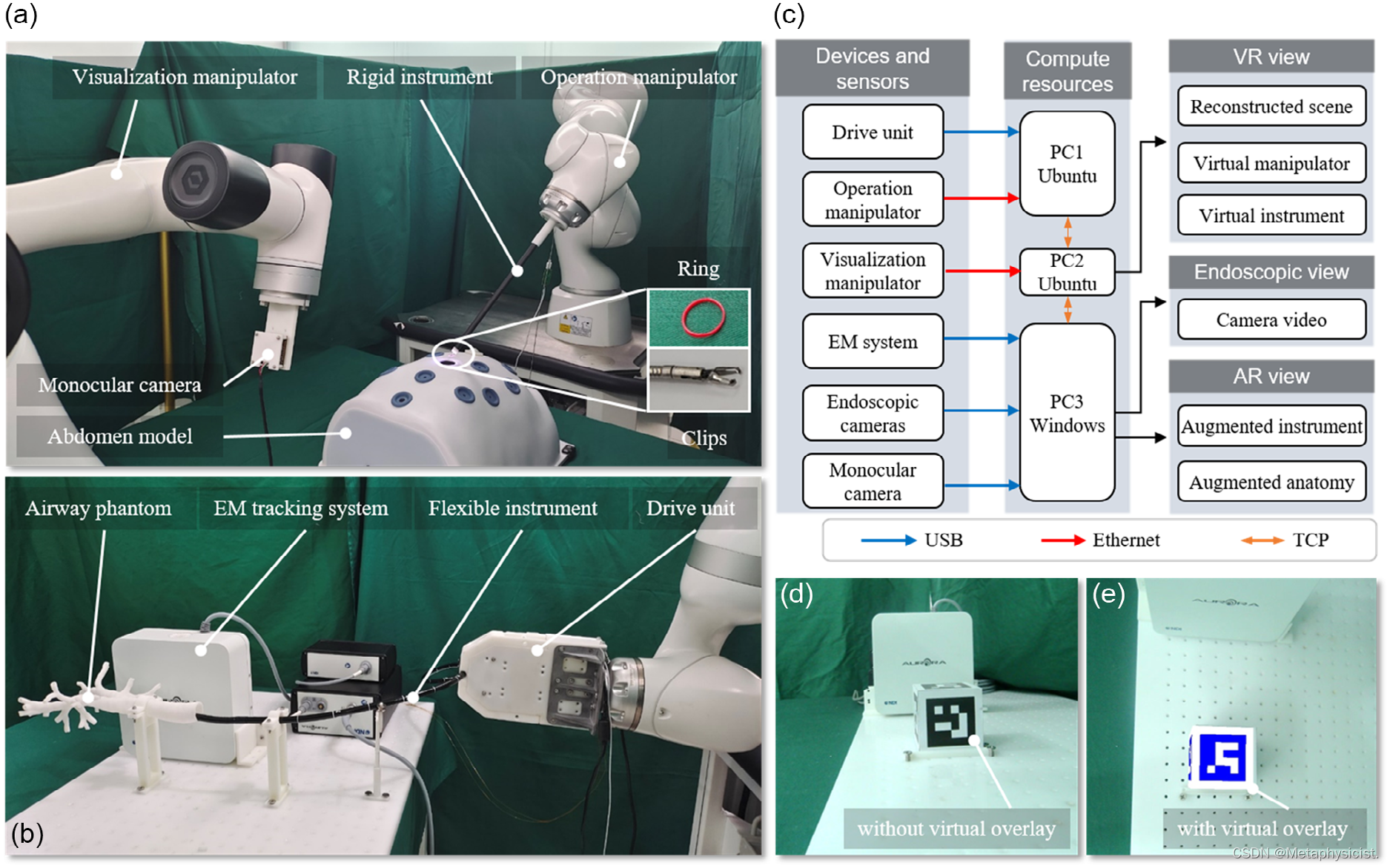

因此,本文开发了一种机器人操控辅助的全方位增强现实(OmniAR)内腔介入医疗系统,如图1所示。 增强现实(AR)、虚拟现实(VR)和内窥镜视图在患者一侧产生,用于远程手术,临床医生一侧的运动指令传输到患者一侧进行机器人操作。 虚拟目标解剖结构和仪器叠加在视频图像上,通过操纵器改变摄像头的视角,实现全方位增强现实显示,使位于患者体内的解剖结构和仪器可以从不同方向进行直观的机器人操作。

图1. 机器人操控辅助的全方位增强现实内腔介入远程手术。 单目摄像头安装在可视化操纵器的远端。 患者向临床医生提供的视觉反馈包括增强现实、虚拟现实和内窥镜视图。 在增强现实视图中,可以查看患者和仪器的关键解剖结构,并且可通过移动可视化操纵器到不同位置以获得不同的视角方向。 通过与显示软件的交互,可以改变虚拟现实视图的方向,以确认操纵器与周围物体的安全距离,从而确保操纵器的安全。 增强现实视图通过渲染单目摄像头的图像生成,内窥镜视图则是固定在仪器尖端的摄像头的图像。 操作操纵器、可视化操纵器和仪器由临床医生一侧的操作员进行远程操作。 此外,可视化操纵器还可以根据术前规划轨迹自动移动。

2. 机器人远程遥操作框架

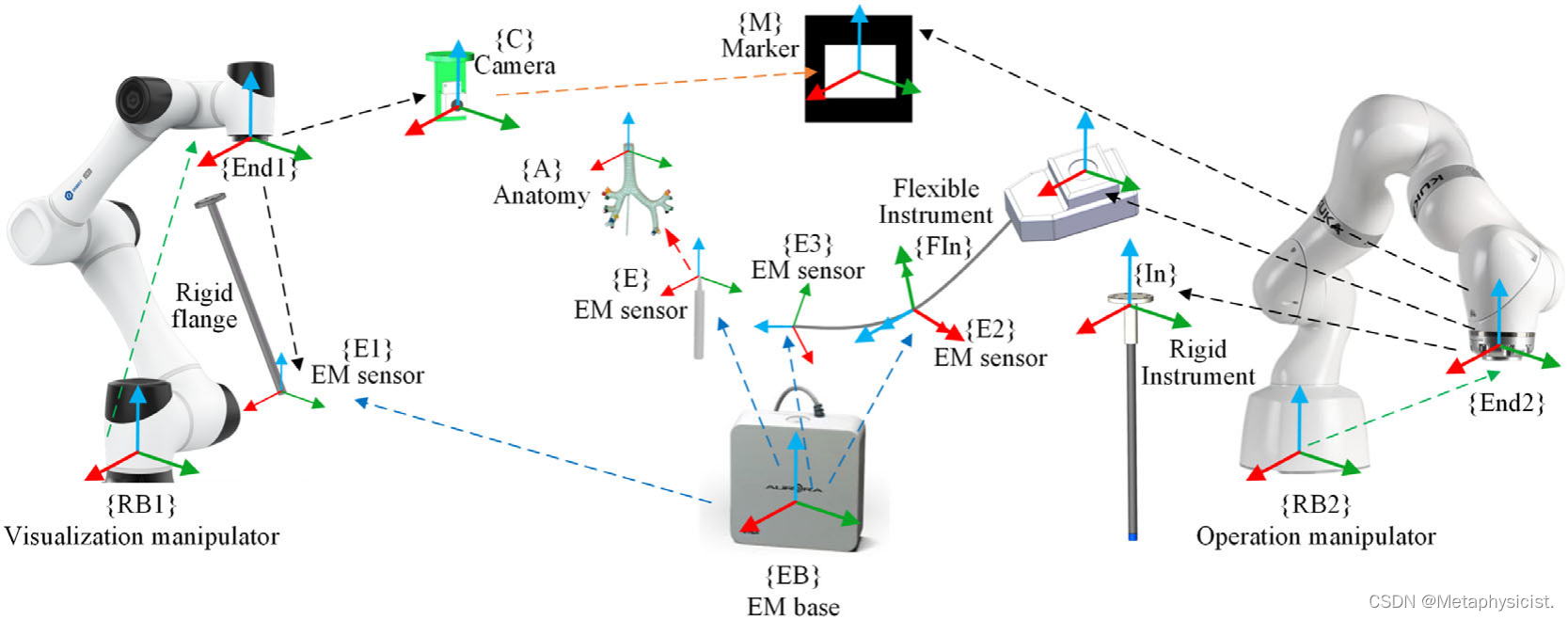

每个组件的参考坐标系必须转换为单目相机坐标系,以便将虚拟模型和仪器叠加到真实世界中。 这主要涉及四个步骤的校准和匹配:可视化操纵器与EM跟踪系统之间的校准,可视化操纵器与刚性仪器之间的校准,手眼校准,以及EM跟踪系统和解剖结构的匹配。 所有的校准方法都基于AX=XB,配准方法基于ICP算法。图2显示了机器人远程操作框架的组件及其相对变换。 所有的校准和匹配都在术前执行,形状重建则实时进行。

图2. 提出的机器人远程操作系统的组件及其相对变换。 彩色箭头表示通过物理关系(黑色)、运动学(绿色)、姿态估计(蓝色)、ICP(红色)和PnP(橙色)获得的相应变换。 在可视化操纵器和EM跟踪系统之间的校准过程中,E1被固定在可视化操纵器的末端,并带有一个刚性夹具。 完成此校准后,移除E1,并将摄像头固定在可视化操纵器的末端。 类似地,在两个操纵器的校准过程中,标记被固定在操作操纵器的末端,然后将刚性或柔性工具固定在操作操纵器上。 所有的校准和配准都在术前执行,并且形状重建是实时运行的。

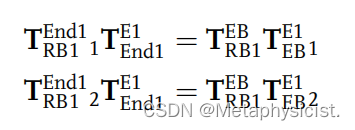

A.操控器和EM跟踪系统之间的校准

可视化操控器和EM跟踪系统之间的校准被转化为手眼校准问题,主要解决AX = XB的问题。 首先,将一个六自由度(DOF)的EM传感器(E1)安装在可视化操控器末端的一个固定法兰上。 随后,通过可视化操控器的远程操作,将E1在EM跟踪系统的磁场中移动,并记录操控器和E1的姿态。 最后,利

用这些姿态构建方程求解。

B.操控器和刚性仪器之间的校准

从操作操控器的运动学计算得到{In}和{RB2}之间的转换矩阵。 因此,可视化操控器和刚性仪器之间的校准等同于校准这两个操控器。 这个校准也可以转化为手眼校准问题。 首先,在可视化和操作操控器的末端分别固定一个单目摄像头(C)和标记物(M)。 随后,通过两个操控器的远程操作将摄像头和标记物移动到不同的位置,且标记物始终在摄像头的视野中。 摄像头使用透视-点(PnP)算法估计标记物的姿态。最后,可以利用两个操控器和标记物的姿态构建方程求解。

C. EM跟踪系统和解剖的匹配

将EM跟踪系统和解剖进行匹配,以获取解剖相对于{C}的3D姿态。

详细的匹配过程如下:

1)对解剖进行CT扫描;

2)使用多个CT切片重建解剖的3D虚拟模型,并将模型用作目标点云P;

3)使用EM传感器收集解剖的点云作为源点云G;

4)使用ICP算法匹配点云P和G,获取EM跟踪系统和解剖之间的变换TAE,即EM跟踪系统和解剖之间的变换。

D. 柔性仪器的形状估计

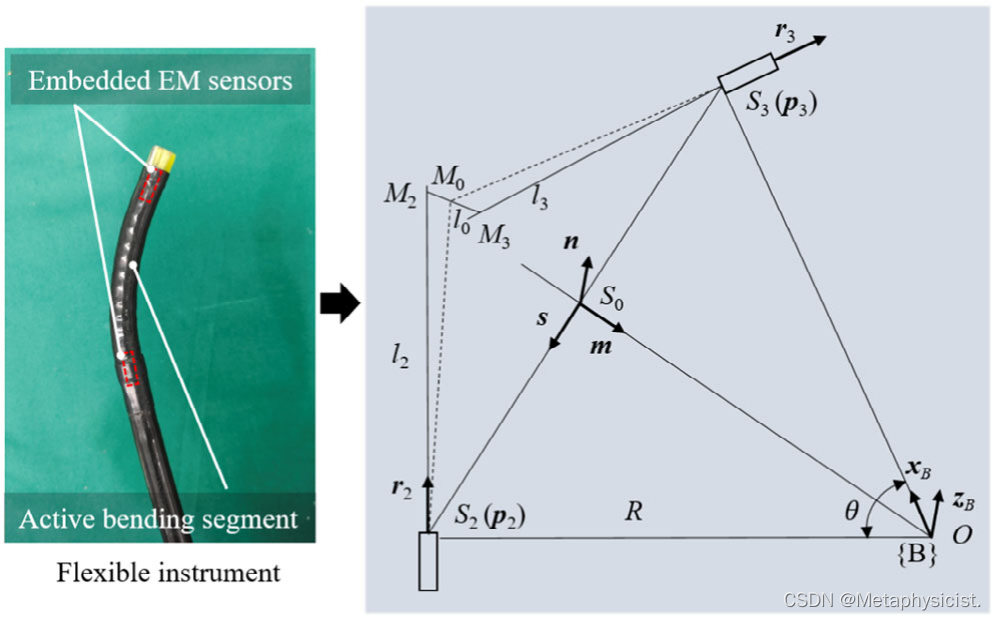

重建活动弯曲段的形状,以供增强现实视图使用。 两个六自由度电磁传感器,E2和E3,分别组装在活动弯曲段的基座和尖端,如图3所示。根据几何关系(如图3)与插值算法,可以实现对柔性仪器的形状估计。

图3. 活动弯曲段与两个6自由度电磁传感器集成的几何形状。

E. 实际场景的三维重建

为了直观地远程操作机械臂并确定其是否与周围物体发生碰撞,在术前对患者一侧进行实际场景的重建,并在临床医生一侧为操作者提供虚拟现实视图。 在虚拟现实视图中,显示了重建的场景、机械臂和刚性仪器,并实时更新机械臂和仪器的姿态。 操作者可以与虚拟现实显示界面进行交互,改变视角,从而提高深度感知并避免视野遮挡,以安全地远程操作机械臂。

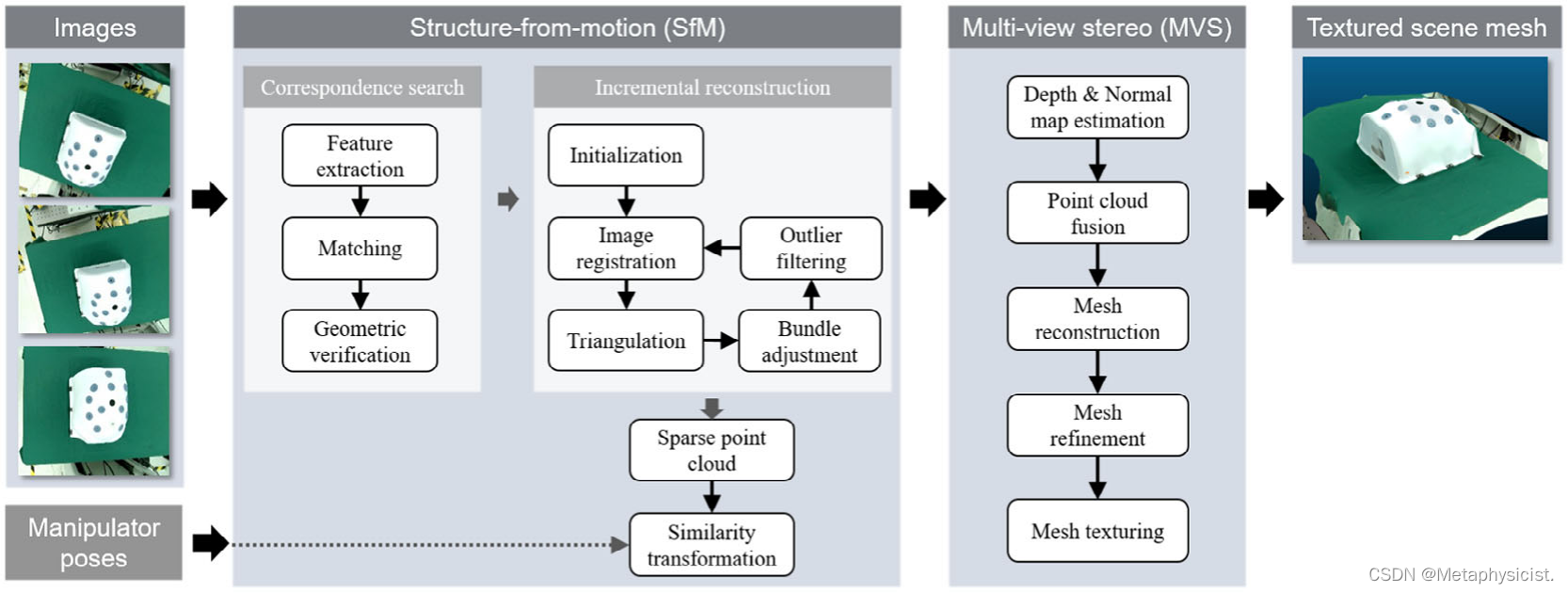

三维重建包括两个步骤:稀疏重建和密集重建。 使用增量式SfM算法进行稀疏重建,使用MVS算法进行密集重建,基于开源库COLMAP。另外,使用OpenMVS库通过网格重建、细化和纹理恢复来获取重建场景的完整表面。 实际场景的构建过程如图4所示。

图4. 场景重建过程。输入为几张单眼摄像机图像,输出为三维重建场景。场景重建包括稀疏重建和密集重建,SfM和MVS分别用于稀疏重建和密集重建。对于稀疏重建,SfM包括对应搜索和增量重建,利用机械手的姿态,通过相似度变换恢复相机姿态的真实尺度信息。

3. 全方位增强现实和叠加精度估计

要实现全方位增强现实,必须将摄像机移动到不同的方向观察物体。 由于可视化操纵器具有较高的定位精度,它可以有效地补偿摄像机的运动。

A. 解剖学增强显示

将虚拟解剖学叠加到真实世界的过程包括以下四个步骤:1)使用开源库Visualization ToolKit (VTK)创建包含虚拟相机和三维解剖模型的虚拟三维空间;2)将虚拟相机的内部参数设置为与实际单眼相机相同,并且虚拟相机的参考坐标系与虚拟空间相同;3)使用TAC更新虚拟空间中三维解剖模型的姿态,并实时使用虚拟相机捕获虚拟空间的场景;4)将虚拟相机和真实单眼相机捕获的图像融合,用于解剖学增强显示。

B. 仪器增强显示

本研究使用两种不同的设置进行机器人辅助内腔介入,分别使用柔性仪器和刚性仪器。分别使用了{C} 到{In}的变换矩阵,实现了仪器的形状估计和状态实时更新。

如果虚拟解剖和虚拟仪器在同一虚拟空间中,在使用虚拟摄像头捕捉图像时可能会相互遮挡。 因此,也为仪器创建另一个了虚拟3D空间,实现了仪器增强显示。

图5. 介入实验平台。 a) 腹腔镜介入实验平台。单目摄像头连接到Windows电脑上的USB接口,两个操纵器连接到Ubuntu电脑上的以太网接口。b) 内腔介入实验平台。EM跟踪系统、内窥镜摄像头和驱动单元连接到Windows电脑上的USB接口。c) 机器人远程操作的数据流。d) 一个80毫米的立方体没有虚拟叠加。e) OmniAR叠加精度估计。一个带有标记的虚拟立方体叠加在真实世界上。

C. 叠加精度估计方法

叠加误差的来源主要包括校准、匹配和图像融合。 由于虚拟和真实显示在2D图像中的叠加结果,估计3D空间中的叠加精度是困难的。 因此,开发了一种基于虚拟标记的方法来计算叠加误差。一个由每个面都包含一个标记的立方体被用作实际对象,一个由每个面都包含一个标记图像的虚拟立方体模型被用作虚拟对象。 实际立方体和EM跟踪系统的匹配过程与前述的过程相同。随后,使用方程将立方体的姿态从{EB}转换为{C},得到TAC。 最后,立方体增强显示与之前相同。

当相机移动到不同位置时,在虚拟立方体覆盖真实世界之前和之后捕获图片。 因为虚拟和实际立方体的每个表面都有标记,所以通过使用PnP算法进行姿态估计来计算虚拟和实际立方体的3D姿态。 随后,使用估计的姿态计算虚拟和实际立方体的每个角点的位置。

4. 实验和结果

A.基于人体运动模仿的远程操作

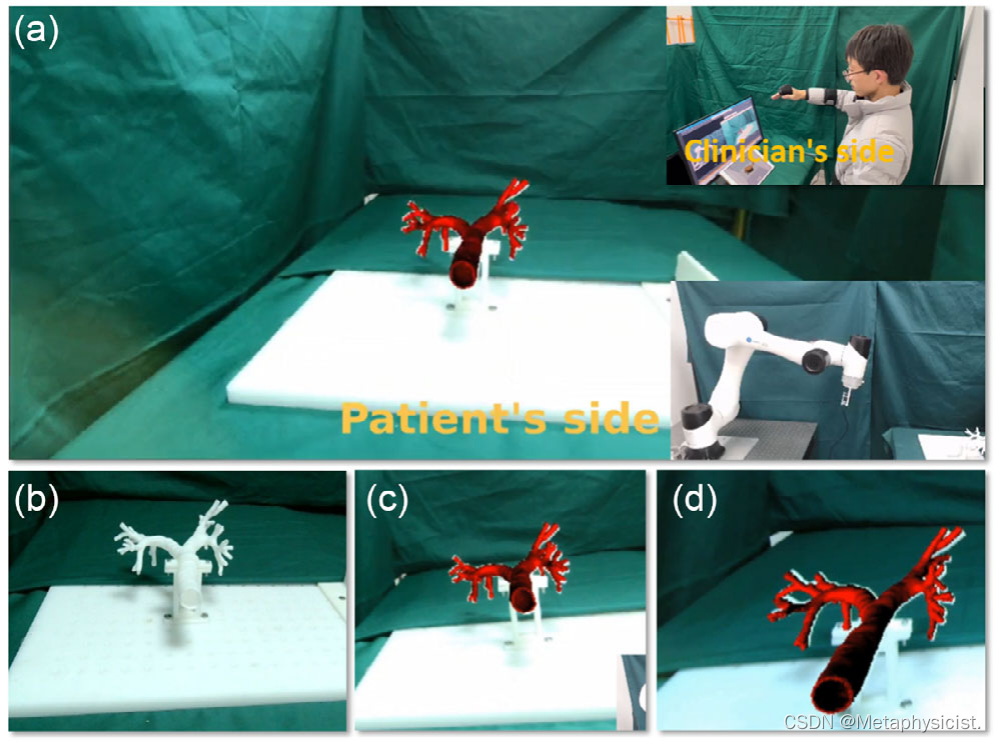

进行了一项远程操作实验,验证了OmniAR显示的有效性,如图6a所示。本研究中使用的机械手是6自由度的,只需要在人体手臂的末端和机械手之间进行映射。在患者一侧,使用气道模型作为解剖结构,并将虚拟气道模型叠加在单目摄像头图像上的实际气道上。在临床医生一侧,操作者调整机械臂的姿势以从不同方向观察气道模型。 图6b显示了没有增强现实的气道模型,图6c、d显示了带有增强现实的气道模型的不同观察方向。

图6. 基于人体运动模仿的远程操作的综合显示。a)在病人的一侧,一个虚拟的气道模型被覆盖在真实的世界上。在临床医生的一侧,操作者根据视觉反馈调整手臂姿势,从不同的方向查看模型。没有模型的AR。c,d)从不同的视角下使用AR的气道模型。

B. 机器人辅助腹腔镜介入手术和用户研究

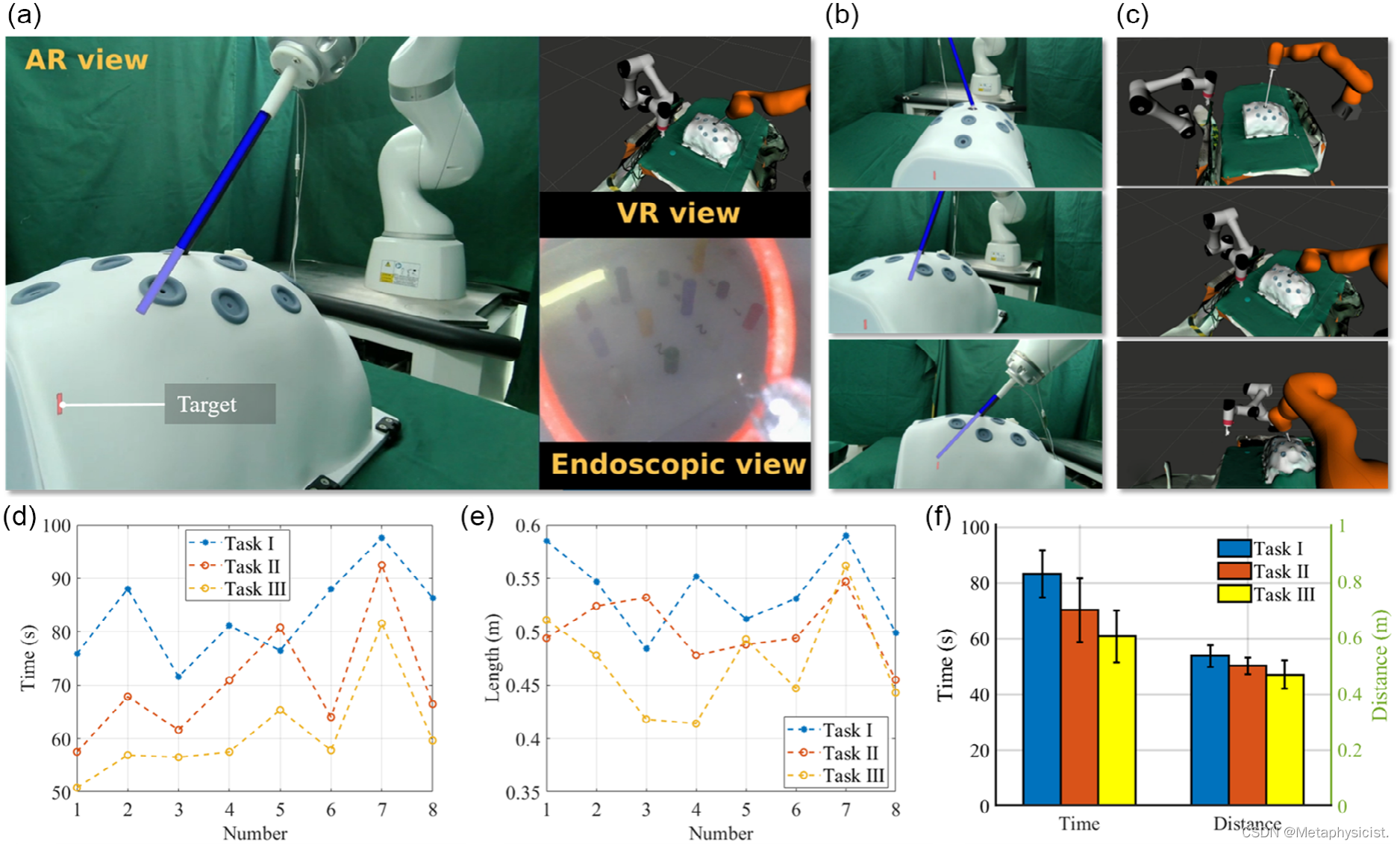

术前使用单目摄像头重建了患者侧的实际场景。 重建的3D模型、两个操纵器和工具被导入到ROS可视化(RViz)环境中进行3D虚拟现实显示。 腹腔镜手术干预设置如图7a所示。两个操纵器和工具的状态在虚拟现实视图中实时更新。 操作者可以与RViz交互,改变显示视图的方向,从而使操作者能够在可视化操纵器和周围物体之间保持安全距离。 腹腔镜手术干预的任务是通过远程操作将工具从插入口移动到目标位置,并根据增强现实、虚拟现实和内窥镜视图将橡胶环滑到指定的圆柱体上。 工具由临床医生一侧的操作者进行远程操作,增强现实和虚拟现实的视角可以根据操作者或助手的要求进行更改。 图7b、c分别显示了增强现实和虚拟现实的不同视角。

图7. 使用OmniAR的腹腔镜介入实验。a)患者对临床医生的视觉反馈。虚拟的刚性仪器和目标被覆盖到现实世界上。b)不同方向的AR视图。c)不同方向的VR视图。d)所有参与者在执行这三个任务时所花费的时间。e)仪器的尖端运动路径的长度。f)三个任务的平均时间和长度。

用户研究的任务是从插入口远程操作仪器到目标位置,并将橡胶环滑到特定的圆柱上。 用户研究涉及五名男性和三名女性参与者(平均年龄:26.3±4.1)。提高操作者的空间意识和手眼协调能力,而不是提供医疗信息。

参与者不需要具备医学背景。 每个参与者被指示完成以下三个任务:

1)任务一:仅使用内窥镜视图远程操作仪器;

2)任务二:使用内窥镜和增强现实视图远程操作仪器,但增强现实视图的方向不能改变;

3)任务三:使用内窥镜、全方位增强现实和虚拟现实视图远程操作仪器。在执行任务之前,参与者被允许熟悉这三个任务。

在用户研究过程中,所有参与者被要求完成整个任务两次,并使用平均时间和路径长度作为客观指标来评估用户表现。 所有参与者的表现结果如图7d-f所示。任务一、任务二和任务三的平均时间分别为83.1秒、70.2秒和60.8秒,平均路径长度分别为0.538米、0.502米和0.471米。

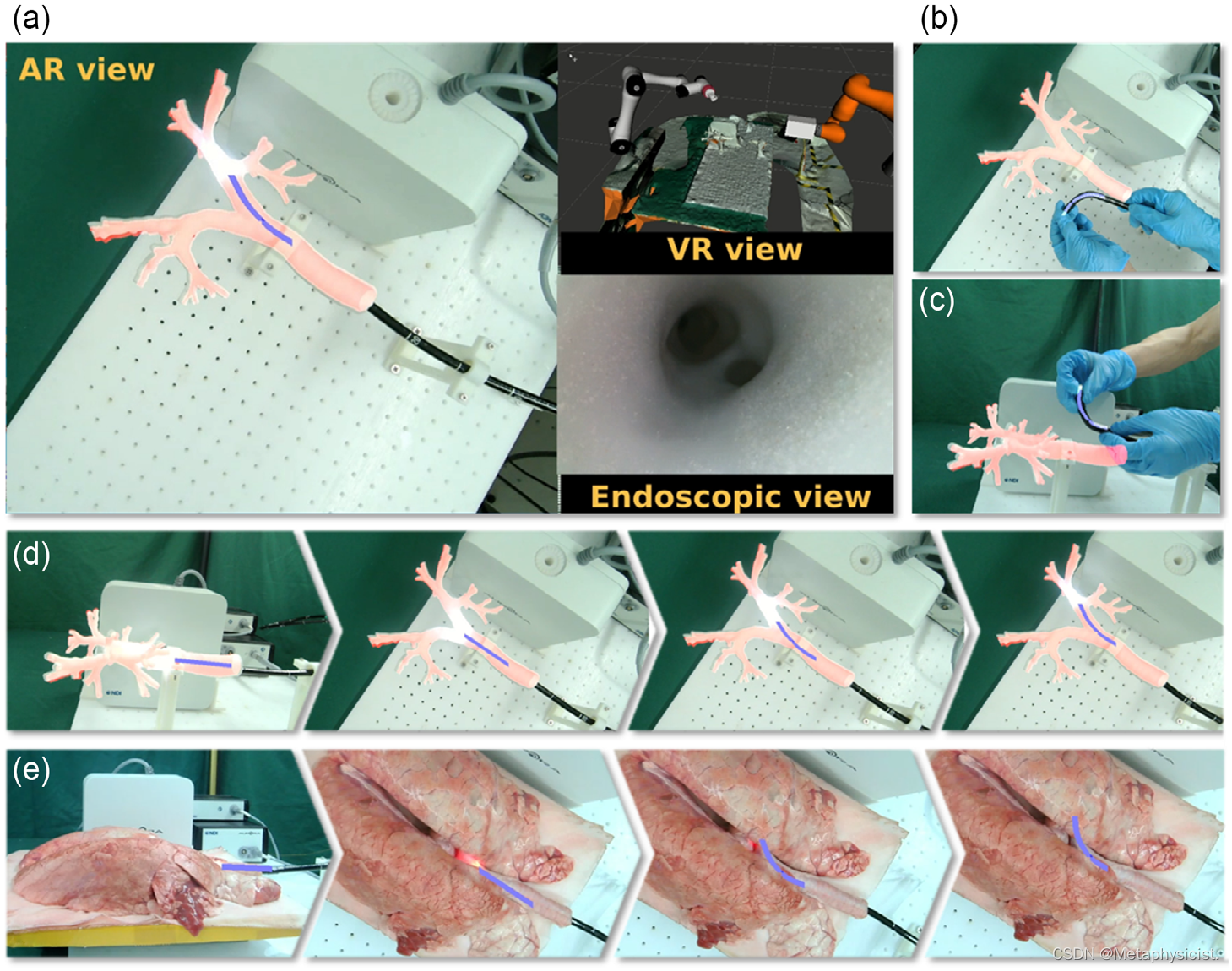

C. 机器人辅助气道内腔介入

驱动单元可以为柔性仪器提供两个自由度的弯曲和一个自由度的平移。驱动单元固定在手术操作器的末端。在术前,手术操作器移动到合适的位置后,术中不再移动。 柔性仪器通过远程操作在人工气道模型内移动。 提供内窥镜、增强现实和虚拟现实视图作为视觉反馈,增强现实和虚拟现实的视角可以根据操作者或助手的要求进行更改。

根据操作者的要求。 使用OmniAR进行气道内腔介入实验的设置如图8a所示。图8b、c显示了使用OmniAR对柔性仪器进行形状监测,图8d演示了介入过程。

为了进一步说明所提出的方法的可行性,进行了一项涉及猪肺的离体实验。由于在这项研究中没有考虑解剖结构的变形,虚拟猪肺模型没有与真实世界叠加,并且肺部的三维表面也没有用于虚拟现实视图的重建。 OmniAR仅适用于灵活的仪器和猪肺介入过程,如图8e所示。

图8. 全腔内介入实验。a)患者对临床医生的视觉反馈。在AR视图中,虚拟的柔性仪器和气道模型被覆盖到现实世界上。b、c)柔性仪器主动弯曲段的形状监测。d)使用气道假体模型的腔内干预过程。e)使用猪肺的腔内介入过程

未来展望

将来可以扩展当前实验以考虑解剖变形的影响,并且可以通过将方法与现有方法相结合来显示介入机器人与组织之间的力触觉性质。

Reference

[1] Lin, Z., Xu, Z., Liu, H., Wang, X., Ai, X., Zhou, C., … & Gao, A. (2024). Robotic Manipulator‐Assisted Omnidirectional Augmented Reality for Endoluminal Intervention Telepresence. Advanced Intelligent Systems, 2300373.

[2] Lin, Z., Zhang, T., Sun, Z., Gao, H., Ai, X., Chen, W., … & Gao, A. (2022). Robotic Telepresence Based on Augmented Reality and Human Motion Mapping for Interventional Medicine. IEEE Transactions on Medical Robotics and Bionics, 4(4), 935-944.