热门标签

热门文章

- 1基于Putty的Linux远程登录教程(Windows系统,虚拟机)_putty远程连接ssh

- 2DataTable转相应的实体对象_datatable转对象

- 3快过年了,整理一波2023年技术文章合集,一键打包

- 4十六进制的转换为十进制两种常见方法_十六进制转十进制方法

- 5【目标检测】45、YOLOv3 | 针对小目标效果提升的 YOLO 网络_yolov3大目标和小目标

- 6交换机vlan什么意思_工业以太网交换机的光口和电口是什么意思?

- 7kubernetes和kubersphere的关系_kubesphere

- 8linux运维进阶-基于RHCS+iSCSI+CLVM实现Web服务的共享存储集群架构

- 9Android中自定义Textview解决文字和数字换行不整齐_textview 换行对齐

- 10Google Play上架总结(三)Google Play 上架流程_谷歌上架分发商品

当前位置: article > 正文

【已解决】RuntimeError: CUDA error: out of memoryCUDA kernel errors | 选择指定服务器跑模型

作者:花生_TL007 | 2024-03-11 21:39:39

赞

踩

【已解决】RuntimeError: CUDA error: out of memoryCUDA kernel errors | 选择指定服务器跑模型

当出现报错

RuntimeError: CUDA error: out of memory

CUDA kernel errors might be asynchronously reported at some other API call,so the stacktrace below might be incorrect.

For debugging consider passing CUDA_LAUNCH_BLOCKING=1.

使用

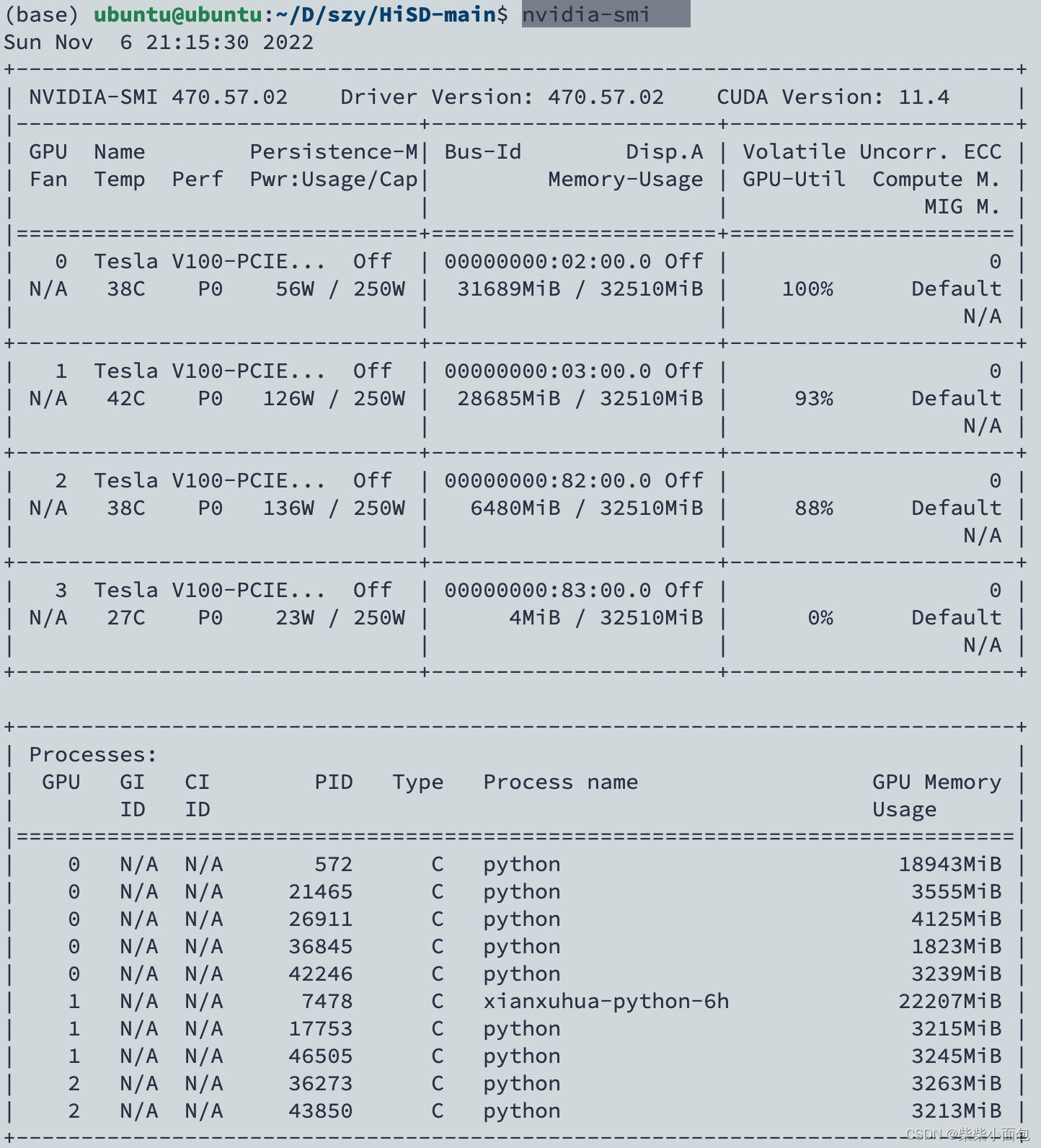

nvidia-smi查看当前服务器占用情况

上图中3号服务器还有剩余位置,因此使用以下方法即可运行

CUDA_VISIBLE_DEVICES=3 nohup python train.py &注意:是 CUDA_VISIBLE_DEVICES=3 + 你的代码

如果遇到第三列都很满的情况,则看第二列

上图中GPU2的占用情况为88%,但是memory-usage是8893/32510,所以可以试试能不能用。一般情况是可以的,但是会比较慢,因为有别人在跑

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/花生_TL007/article/detail/220659

推荐阅读

相关标签