- 1一文教你实战构建消息通知系统Django

- 2Xcode6内置环境变量(Build Setting Macros)_gcc_treat_warnings_as_errors = no

- 3【人工智能技术专题】「入门到精通系列教程」打好AI基础带你进军人工智能领域的全流程技术体系(机器学习知识导论)_构建鲁棒安全人工智能所需的基础理论与技术体系

- 4Swagger的使用详细教程_swagger配置

- 5iOS Debug环境下生成dSYM文件配置_debug information format生成dsym

- 6深度之眼Paper带读笔记NLP.29:深度语境化词表征_深层语境化词表征

- 7使用bert4keras进行关系抽取的代码_bert4keras关系抽取

- 8(没有显卡如何跑Stable Diffusion?)Stable Diffusion使用Google Colab快速部署在云端使用_stable diffusion 无gpu

- 9生成式AI:3D场景创作的新机遇_ai生成三维场景

- 10已解决:org.springframework.amqp.rabbit.support.ListenerExecutionFailedException: Listener method ‘publ

边缘AI行业报告:发展趋势、相关机遇、产业链及相关公司深度梳理_中国边缘ai市场发展因素分析

赞

踩

今天分享的AI系列深度研究报告:《边缘AI行业报告:发展趋势、相关机遇、产业链及相关公司深度梳理》。

(报告出品方:慧 博 智 能 投 研)

报告共计:31页

边缘计算及边缘 AI 概述

1.边缘AI

边缘 AI(本文指 AI on edge是智能化发展的趋势,是边缘计算和人工智能的结合。边缘 AI是指在缘部署 AI模型,可以在没有网络连接的情况下对数据进行处理,具有低延迟、高速处理数据的显著优势,以往很多难以在云端进行数据处理的场景,如工厂机器人、自动驾驶等,都可以通过边缘 AI 迎来新的技术和应用场景突破。以智能工厂为例,边缘 AI 可以对来自监控摄像头和传感器的大量多模态数据进行可视化和评估,可以用它来检测生产线上人类可能忽略的故障数据。AI 浪潮下终端对 AI算力需求大幅提升,边缘 AI叠加边缘计算和 AI 的双重优势,是未来终端真正能够像使用水、电一样使用 AI的重要方式,有望加速万物智能时代的到来。

2.边缘 AI 发展历程

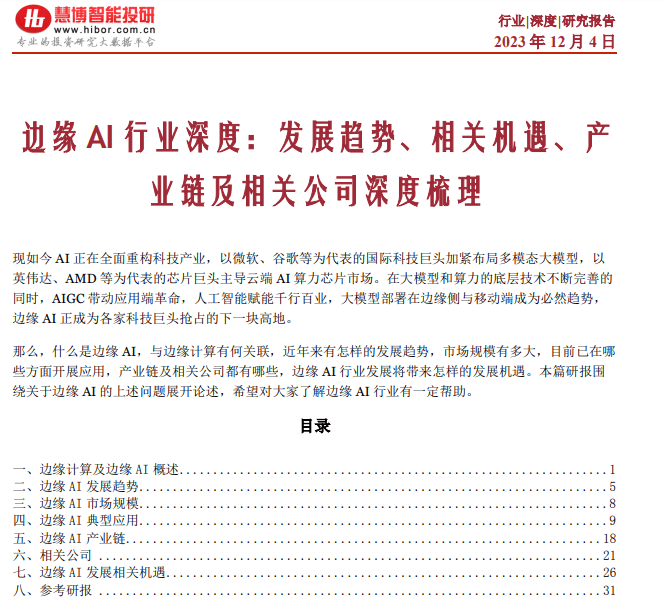

(1) 云计算

云计算 (cloud computing)是分布式计算的一种,指的是通过网络“云”将巨大的数据计算处理程序分解成无数个小程序,然后,通过多部服务器组成的系统进行处理和分析这些小程序得到结果并返回给用户云计算早期,简单地说,就是简单的分布式计算,解决任务分发,并进行计算结果的合并。因而,云计算又称为网格计算。通过这项技术,可以在很短的时间内(几秒钟)完成对数以万计的数据的处理,从而达到强大的网络服务。

2005年云计算的提出和应用改变了人们的生产和生活方式,云计算数据中心具有超强计算能力,能够集中式解决计算和存储问题。

(2) 边缘计算

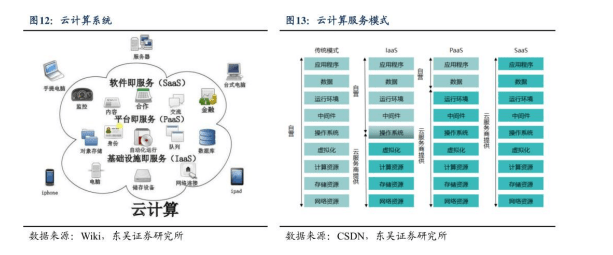

然而随着物联网的快速发展和 4G、5G 无线网络的普及,网络边缘设备数量迅速增加,该类设备所产生的数据已达到泽字节(ZB) 级别,以云计算为核心的集中式数据处理的模式在数据处理能力、网络传输带宽负载量、个人隐私保护等多方面已难以满足边缘产生的庞大数据处理需求。根据 Gartner 的预测,2025 年将有 75%的数据产生在数据中心和云之外的边缘侧。以边缘计算模型为核心的面向网络边缘设备所产生海量数据计算的边缘式大数据处理应运而生。

边缘计算是指在尽可能靠近数据源或终端的地方捕获和处理数据。通过在数据源的物理位置附近放置服务器或其他硬件来处理数据,在本地完成处理而不是在云端或集中式数据中心,它能最大限度地减少延迟和数据传输成本,允许实时反馈和决策。

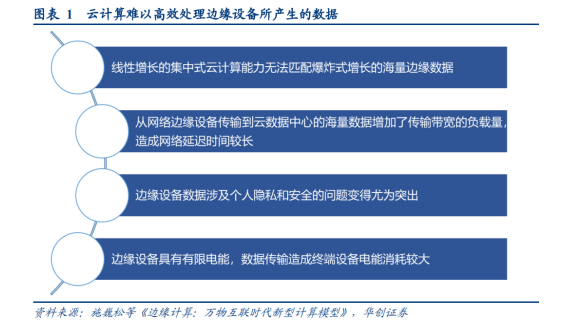

相较于集中式大数据处理的云计算,边缘计算更适应大数据处理时代的数据特征。边缘计算模型将原有云计算中心的部分或全部计算任务迁移到数据源的附近执行,包括数据存储、处理、缓存、设备管理、隐私保护等。

在当下万物互联时代,互联网设备的感知数据迅速增加,数据类型丰富多样,用户对数据处理的实时性要求较高。未来边缘计算将和云计算相互补充、相互连接,将部分原有云中心的计算任务迁移至边缘能够极大提高数据传输性能,保证处理的实时性,降低云计算中心的负载。

云计算和边缘计算的主要区别在于处理所在的位置。边缘计算,处理发生在网络边缘,更靠近数据源,而云计算,处理发生在数据中心。

边缘计算发展历程:边缘计算的历史可以追溯到上世纪 g 年代,当时内容分发网络(CDN)充当分布式数据中心。但 CDN仅限于缓存图像和视频,而不是海量数据工作负载: 2000 年左右,智能设备的爆炸式增长给现有IT 基础设施带来了压力,诸如点对点(P2P)网络的发明减轻了这种压力,在这种网络中,计算机无需通过单独的集中式服务器计算机即可连接并共享资源: 10 年代,大公司开始通过公共云向终端用户出租计算和数据存储资源: 2020 年后,边缘计算融合了 CDN 的低延迟能力、P2P 网络去中心化平台以及云的可扩展性和弹性,共同构建了一个更高效、更有弹性和更可靠的计算框架。

边缘计算特征,边缘计算通常指部署在设备本地的算力或者离用户距离较近的数据中心中的计算算力,拥有可定制化、低成本、低时延、高安全性与隐私性四大特征。

(3) AI 浪潮催生边缘 AI 需求

AI进入iPhone时刻,产品形态和应用边界不断拓宽,市场空间广阔。2023 年初,ChatGPT 因其强大的语言理解和文本生成能力火速出圈,引发市场强烈关注和热议。AI可以赋能革新生产力,实现工作和生产效率的提升,其产品形态和应用边界不断拓宽,即可以对传统行业实现改造颠覆,也可以创造全新商业模式,在各行各业均有广阔的发展前景。随着越来越多的巨头布局 AI,越来越多的 AI 应用落地,AI产业进入“iPhone时刻”。根据艾瑞咨询测算,2022 年我国人工智能产业规模达到 1,958 亿元,预计到 2027 年产业规模将达到 6,122 亿元,2022-2027 年 CAGR为 25.6%。根据华为云 AI领域首席科学家、国际欧亚科学院院士田奇的预计,2026 年人工智能行业渗透率将达到 20%。

二、边缘 AI 发展趋势

1.受益于软硬件技术的不断发展进步,边缘 AI 大规模商业化趋势日渐明

在边缘部署 AI模型受益于三方面技术: 神经网络的成熟、计算基础架构的进步和物联网设备的采用。

(1)神经网络的成熟:神经网络和相关的 AI基础架构已发展到能够实现通用机器学习的程度。企业机构正在学习如何成功训练 AI 模型,并将其部署到边缘的生产中。

(2)计算基础架构的进步: 在边缘运行 AI 需要强大的分布式计算力,当前已经在使用最先进的高度并行 GPU 来运行神经网络。

(3)物联网设备的采用: 物联网的广泛采用推动了大数据的爆炸式增长。企业能够从工业传感器、智能摄像机、机器人等采集各个方面的数据。5G 的发展也能够提供更快、更稳定和更安全的连接进而推动物联网。

在IBM5月份发表的一项研究表明中,94%的受访高管表示,他们的企业机构将在未来五年内部署边缘计算。物流问题、工人短缺、通货膨胀和疫情所造成的不确定性正困扰着企业,而边缘 AI 解决方案可以作为人与机器之间的桥梁,实现预测、工人分配、产品设计和物流的改进。受益于软硬件技术的不断发展进步,边缘 AI大规模商业化趋势日渐明晰。日前,OpenAI 宣布推出官方ioS 应用,高通和微软在Microsoft Buid 开发者大会上达成合作关系,将面向消费级和企业级终端、以及工业设备,规模化扩展AI能力,为用户带来行业领先的 AI 体验。

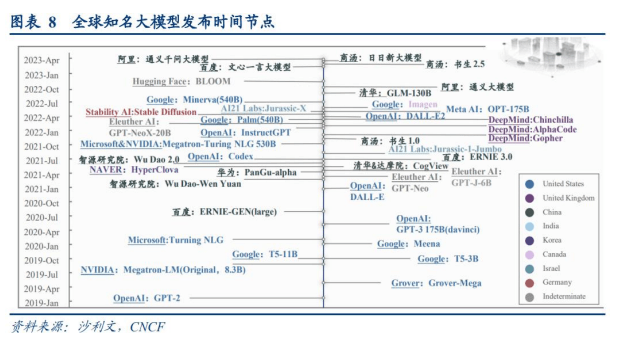

2.AI 大模型加速迭代,平民化趋势有望助力边缘 AI 需求释放

过去几年,国内外的 AI厂商均在大模型领域有所布局并持续迭代。ChatGPT 的发布,掀起了新一轮发展热潮,原有厂商基于自身大模型开始推出一系列生成式AI 应用,并对外提供 API接口。2023 年 6月14 日,OpenAI发布了 ChatGPT 的重大更新,其中不仅包括不断加速迭代的 AI大模型,同时还宣布降低成本。通过不断提高系统效率,OpenAI将原始版本 GPT-3.5-turb 的价格降低 25%。此外,OpenAl的text-embedding-ada-002(文本嵌入模型之一)的定价也有所降低,每 1000 个 tokens 的价格为0.0001美元,比之前的价格降低了 75%。在技术进步的推动下,AI大模型正逐渐平民化,终端逐渐能够以较低的价格获得高品质 AI 服务,助力边缘 AI 市场需求的快速释放。

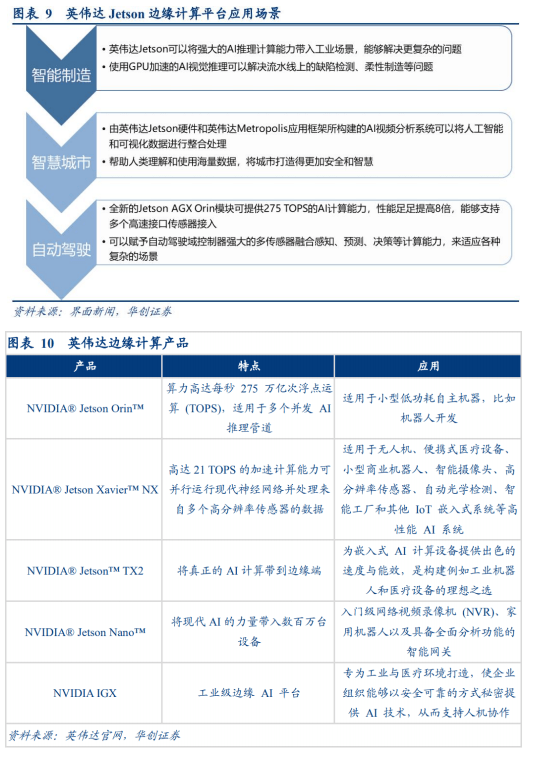

3.在硬件设备方面,英伟达、高通等公司为边缘 AI 的部署的升级提供支持

英伟达宣布将在 2023 年上海国际嵌入式展中,展示适用于自主机器和很多其他嵌入式应用的英伟达Jetson 边缘计算平台,这是基于 Jetson Orin NX/ Orin Nano 开发的无人机机载平台和小型化机器人主控平台,可应用于智能制造、智慧城市、自动驾驶等多个领域。在此之前,英伟达就在边缘计算模组领域布局了多款产品,为边缘 AI未来的部署和升级提供支持。2022 年底,高通正式发布了新的旗舰产品骁龙 8Gen2 处理器,其搭载的全新专用 AI加速计算 Hexagon 处理器的人工智能性能提高了 4.35 倍,可以通过识别图像的哪些部分是脸、头发、衣服、背景等来提高照片质量。2023 年 5月,高通高级副总裁 AlexKatouzian 表示,高通作为全球最大的智能手机处理器制造商,正在从通信公司转型成为一家智能边缘计算”公司,认为人工智能(AI)的未来将需要比云计算本身更强大的计算能力。

三、边缘 AI 市场规模

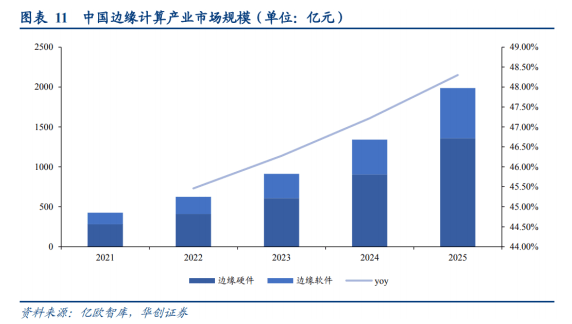

1.边缘计算市场规模仍处快速扩张期

根据 STL Partners 边缘计算关键数据统计,2030 年全球边缘计算潜在市场规模将达到 4450 亿美元,10 年复合增长率为 48%。根据亿欧智库发布的《2022 年中国边缘计算产业研究报告》,2021 年我国边缘计算市场规模已经达到 427.9 亿元,预计 2021-2025 年中国边缘计算产业市场规模年复合增速有望达到 46.81%,2025 年边缘计算市场整体规模达 187.68 亿元。

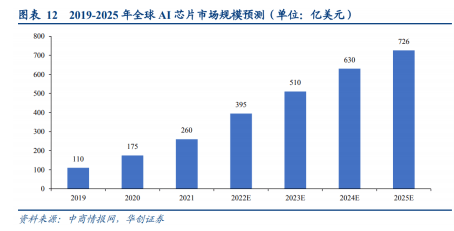

2.边缘 AI 苏片组市场规模有望超越云 AI 片组

将 AI 部署到终端目前仍以芯片的方式为主,据中商情报网,随着人工智能技术日趋成熟,数字化基础设施不断完善,人工智能商业化应用将加落地,推动 AI芯片市场高速增长,预计 2025 年全球人工智能芯片市场规模将达到 726 亿美元。根据全球技术市场咨询公司 ABI Research 的数据显示,预计到 2025年,边缘 AI 芯片组市场的收入将达到 122 亿美元,云 AI芯片组市场的收入将达到 11 亿美元,边缘 AI芯片组市场将超过云 AI 芯片组市场。

四、边缘 AI 典型应用

1.英伟达:以 Omniverse 为核的的具身智能路径

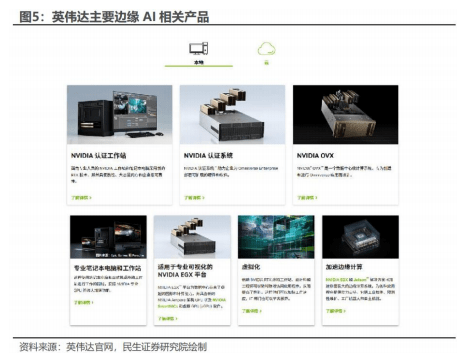

英伟达边缘 AI 自下而上突破的具身智能路径已经打通,结合云计算可以在边缘 AI从开发到部署的各个环节提供丰富技术支持。NVIDIA 选择微软 Azure 作为 Omniverse Cloud 的首家云服务商。微软 Azure将能支持企业在享有 Azure 云服务的规模分析特性与安全性的同时,访问全套 Omniverse 软件应用及NVIDIAOVXT"计算系统,为客户提供了一套可用于设计、开发、部署和管理工业元宇宙应用的全栈式云环境和平台功能,连接并使用 NVIDIA 合作伙伴生态系统的相关产品,如英伟达认证工作站、边缘计算模块等。

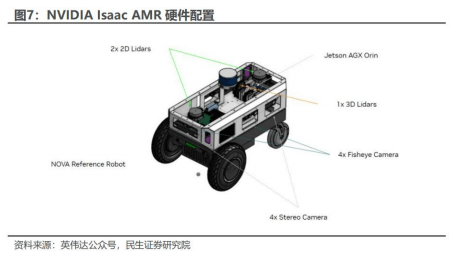

NVIDIA Isaac 是专为机器人开发和 AI打造的加速平台,AMR 移动机器人平台率先落地。英伟达 Isaac平台从预训练模型开始,通过 Isaac Replicator 中生成的合成数据进行增强,并使用 NVIDIATAO 进行训练,从而实现目标性能,用本地和云端提供的 NVIDIAIsaacSim 创建物理精准的逼真环境,以开发和测试与机器人运行相关的各个方面,利用 NovaOri 节省时间,并使用硬件加速 SDK将 AI带入到基于 NVIDIAJetson 的机器人,例如用于基于 ROS 的机器人的 Isaac ROSGEM、用于视频流解析的NVIDIA Deep StreamSDK、用于自然语言处理的 NVIDIARiva: 通过 EGXFleet Command和IsaacforAMR (包括 Metropolis、CuOpt 和 DeepMap)管理机器人编队以优化生产力。IsaacAMR 是用于模拟验证、部署、优化和管理自主移动机器人车队的平台,包含了边缘到云的数字孪生训练、软件服务、计算以及一套参考传感器和机器人硬件,可加快 AMR 的开发和部署速度,减少成本和缩短产品上市时间。

IsaacAMR 建立在 NVIDIA NovaOrin 参考架构的基础。NovaOrin 包括立体相机、鱼眼相机、2D 和 3D 激光雷达在内的多个传感器与系统模块集成在一起,支持先进的 AI 和硬件加速算法,提供 275TOPS 的 实时边缘计算性能。同步和校准的传感器套件为实时三维感知和绘图提供了传感器的多样性和冗余性。 用于记录、上传和重放的云原生工具使调试、地图创建、训练和分析变得容易。

2.高通: 云边一体的混合 AI 路径

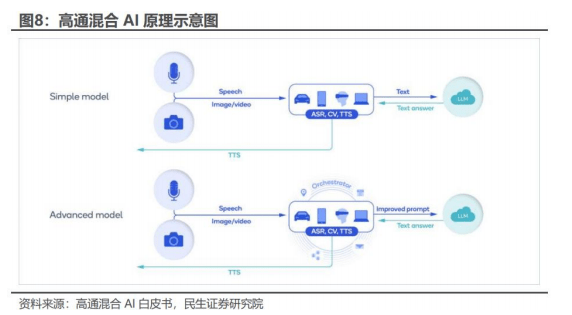

高通提出云边一体的混合 AI 路径,深度开发边缘 AI,云端 AI 选择与微软等公司合作。据高通混合 AI白皮书,在混合 AI 场景中,边缘大模型是云端大模型的感知器官,例如用户对手机说话,自动语音识别(ASR)AI 模型如 Whisper 在设备上转换语音为文本,发送到云端,云端运行大模型,回发文本答案。在进阶版本中,设备 A 更进一步保护隐私,承担更多处理,提供更个性化的提示给云:通过设备学习和个人数据,设备创建用户个人形象,与调度程序协作,基于上下文提供更好的提示;例如,用户要求手机预约和朋友在最爱餐厅吃饭,对简单查询,较小的大模型可在设备上运行无需云交互,如果用户需要复杂信息,则本地将需求转化为提示发给云端大模型并返回详细答案。

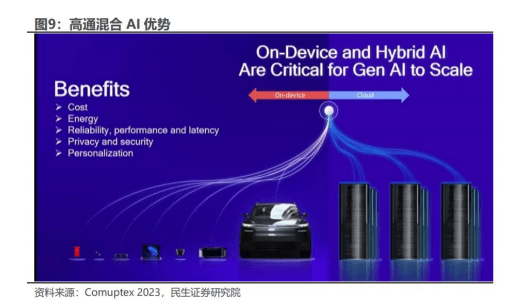

据高通混合 AI 白皮书,混合 AI 主要有以下优点:

1)经济性:降低云端推理成本、高效利用边缘算力、降低 AI 应用开发门;

2)能耗低:边缘设备可以以较低能耗运行大模型,若考虑处理和数据传输等因素,能耗节约更加显著:3) 可靠性: 边缘 AI 不受网络状况影响,运行更加稳定;

4)隐私性:数据完全在本地推理,大幅降低泄密风险;

5)个性化:边缘设备可以搜集用户真实生活中的行为、价值观、痛点、需求、关注问题等信息形成定制化服务。

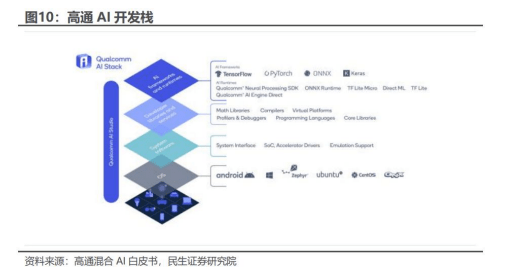

高通 AI 开发栈支持主流 AI 框架,如 TensorFlow、PyTorch、ONNX 和 Keras,以及 TensorFlowLiteTensor Flow LiteMicro、ONXruntime 等运行时。此外,它还包括推理软件开发工具包(SDK),如备受欢迎的 Oualcomm@神经处理 SDK (适用于 Android、Linux 和Windows)。开发人员库和服务支持最新的编程语言、虚拟平台和编译器。在较低的层次上,高通 AI开发栈系统软件包括基本的实时操作系统(RTOS)、系统接口和驱动程序。高通 AI开发栈在不同的产品线上提供丰富多样的操作系统支持,包括Android、Windows、Linux和ONX,以及 Prometheus、Kubermetes 和 Docker 等部署和监控基础设施高通 AI 开发栈还包括 AIStudio,支持从设计到优化、部署和分析的完整大模型工作流,将所有工具整合到一个图形用户界面中,并提供可视化工具,简化开发人员的体验,使他们能够实时查看模型开发情况,包括 AI 模型效率工具包 (AIMET)、AIMET 模型库、模型分析器和神经架构搜索(NAS) 。

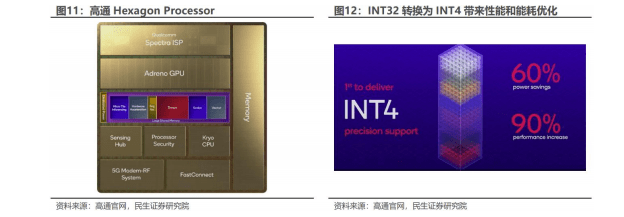

硬件端:高通 Hexagon Processor 核心。高通 Hexagon Processor 采用全新的架构以及专用的供电系统在 AI推理方面增加了特殊的硬件来改善组卷积、激活函数加,并将张量加速器的性能提升一倍,采用独特的方法将复杂的 AI 模型分解为微块 (MicroTile) 以加速推理过程,标量、向量和张量加速器可以同时工作,无需每次都涉及内存,从而节省功耗和时间。此外还通过物理桥梁实现了与 Hexagon 的无缝多IP 通信。这种连接可以驱动高带宽和低延迟的用例,例如认知 ISP 或在游戏场景中提高低分辨率。高通 Hexagon Processor 成功地将多个深度学习模型从 FP32 转换为INT4,最高降低 60%能耗同时增长90%性能。

高通已有 Stablediffusion 模型落地案例,未来大模型 AI边缘部署规划清晰。2023 年 2 月,高通利用高通AI软件栈(Qualcomm AIStack) 执行全栈 AI优化,首次在 Android 智能手机上部署StableDiffusion。2023 年 5月,高通发布混合 AI 白皮书,预计 2023 年边缘 AI 覆盖10 亿参数以下的各类模型。

3.中科创达:大模型+大平台的软硬一体化发展

2023 年5月 18 日,中科创达发布 Rbik 大模型,是国内首个边缘 AI终端统一操作系统的雏形,同时中科创达还与亚马逊云科技共同成立人工智能联合创新实验室,并展示了 Turbox 模组、智能音箱参考设计、Rubik Genius Canvas 等一系列创达魔方产品。据公司 2022 年报,公司自成立以来,一直在端侧、边缘侧、云端技术进行沉淀和积累,目前已成为上述领域全球领先的技术厂商。此外,公司的机器人产品覆盖了当下几乎全部的机器人场景以及全球众多机器人厂商。并且,公司与产业链的技术和产品的头部企业保持深度的合作,构建了生态的卡位优势。公司在边缘 AI 的软件端拥有大模型,硬件端深耕高通、亚马逊等科技巨头的生态,软硬一体化的发展路径极具潜力。

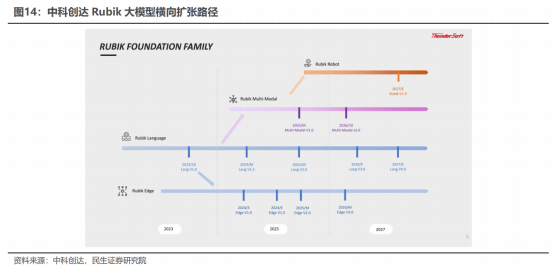

(1)横向看:中科创达 Rubik 围绕现有业务构建 AI 生态

Rubik 大模型系列核心产品为 ubik Language 语言大模型,董事长预计 2024 年时将达到 ChatGPT3.5水平。Rubik Edge、Rubik Multi-Modal 以及预计 2027 年推出的 Rubit Robot 均将服务于智能手机和智能驾驶领域,提升人机交互体验。与此同时,Rubik 系列围绕人机交互和现有业务搭建生态: RubikStudio、Rubik Auto、Rubik Device 和 Rubik Enterprise。在拥有能力强大的大模型同时,也会把大模型变成各种各样的中小模型,以满足各类场景和知识的拆分、提高与客户的适配性。

与谷歌类似,中科创达 Rubik 大模型有望首先落地机器人。在众多智能硬件产品中,中科创达的机器人产品可覆盖各种不同的应用场景,并已助力全球众多机器人厂商实现了产品的量产落地。基于在机器人领域的深厚积累,中科创达将智能音箱与机器人进行融合,并通过 Rubik 大模型的不断训练,已经实现了能够自由对话的智能销售机器人,可以自主回答客户关于企业及产品的各种问题。

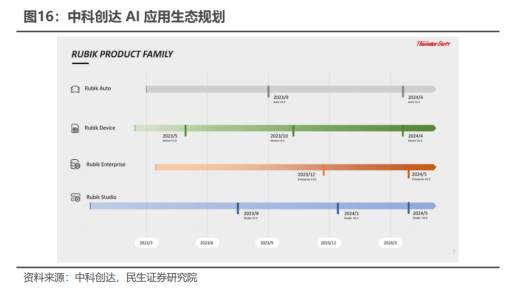

(2)纵向看: 中科创达 AI 应用生态整装持发

中科创达 Smartto lntelligent 战略开启,实现从智能应用为中心到模型驱动的机器与机器、机器与人交瓦的全新智能世界。Rubik 大模型将与公司现有的智能汽车和物联网业务整合,并通过私有化部署和系统调优来满足各行业需求。公司有望通过大模型持续优化,将机器人变为现实,并在未来智能计算行业的 toBtoC 领域中发挥核心竞争优势。

报告共计:31页