- 1c++链接时,无法解析的外部符号 _GdipAlloc等一系列报错_error lnk2019: 无法解析的外部符号 _gdiplusstartup@12,该符号在函数

- 2数据结构之顺序表详解

- 3Java - SpringBoot借助Java Mail Sender(基于javax/jakarta.mail)发邮件_jakarta.mail发送邮件

- 4需要达到什么水平才能找到一份计算机实习?

- 5[SpringMVC]请求与响应③(JSON数据传输参数、日期类型参数传递、内部实现原理)_json可以传日期参数吗

- 6OpenHarmony实战:帆移植案例(中)

- 7gitee-jenkins-测试服务器|部署+跑通入门简单案例,问题发现与处理_怎么在测试服务器搭jenkins

- 8【中间件】RocketMQ与Kafka的异同_rocketmq的offset和kafka的offset的区别

- 9解决GitHub下载速度太慢的问题_雷神加速github

- 10特征选择算法 | Matlab 基于支持向量机递归特征消除特征选择算法(SVM-RFE)的回归数据特征选择_svm-rfe回归

论文阅读笔记(8-2)---A Study on Threshold Selection for Multi-label Classification_a survey of threshold selection for multi-label cl

赞

踩

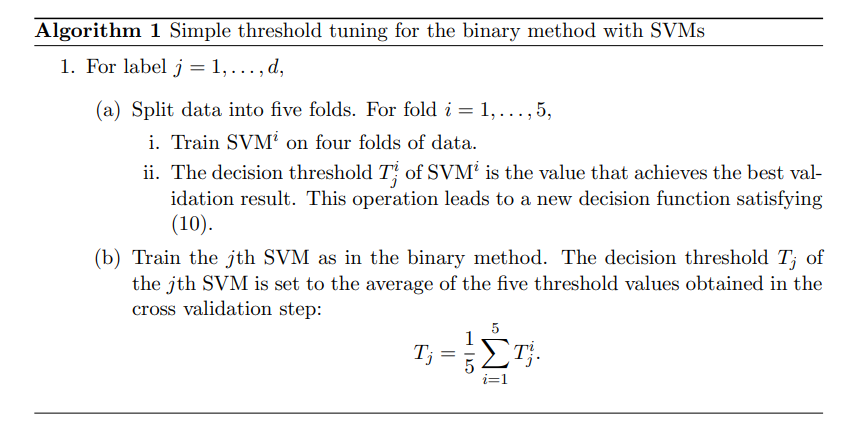

Section3 通过阈值选择的优化策略

对于2.3节的讨论,我们在二进制方法的决策函数中调整了阈值。直接直观的方法是在验证集上实现最佳评估度量的值。Algorithm 1使用五折交叉验证显示细节,使用的评估度量可以是任何标准,例如宏平均F-measure。给定按照决策值排序的

l

^

\hat l

l^验证实例,有

l

^

+

1

\hat l+1

l^+1种可能的预测结果。接着,我们使用两个相邻的判决值作为阈值来检查性能。对于支持向量机预测所有实例为正或负的两种极端情况,我们检查一个比最高(或最低)决策值略高(或略低)的阈值。

为了了解这个算法是如何工作的,我们创建了一个带有

d

=

2

d=2

d=2个标签,和10个验证实例的问题。目标是通过调整两个决策函数

f

1

,

f

2

f_{1},f_{2}

f1,f2的

T

1

,

T

2

T_{1},T_{2}

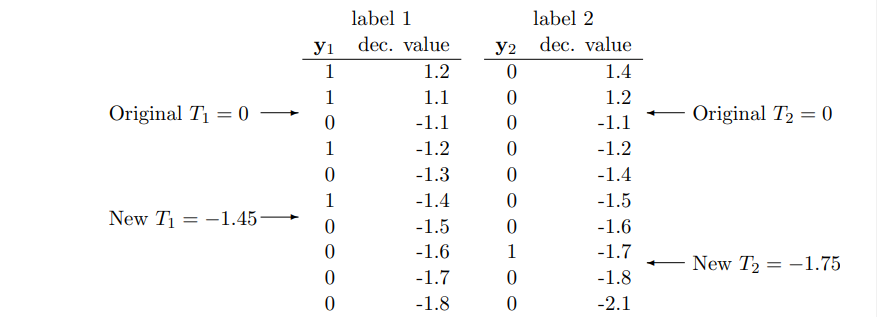

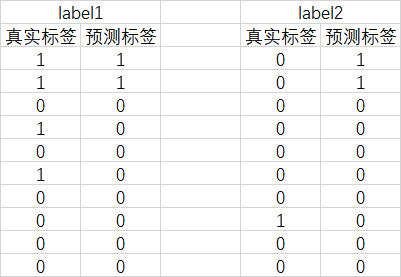

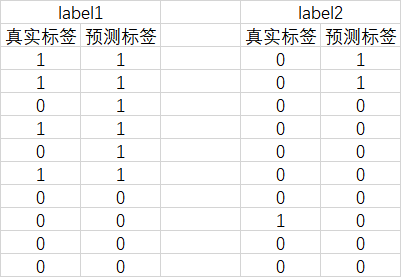

T1,T2来优化宏观平均F-measure。假设利用二进制方法得到如下结果:

我们根据验证实例的决策值对它们进行排序,列

y

1

,

y

2

y_{1},y_{2}

y1,y2表示真正的标签。 在初始阈值

T

1

=

T

2

=

0

T_{1}=T_{2}=0

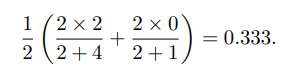

T1=T2=0的情况下,我们预测了两个阳性实例的所有两个标签。宏观平均F-measure为

当阈值

T

1

=

−

1.45

,

T

2

=

−

1

/

75

T_{1}=-1.45,T_{2}=-1/75

T1=−1.45,T2=−1/75时,得到更好的宏观F-measure:

注意到优化宏观平均F-measure有时会导致微观平均F-measure减小。例如,如果我们保证

T

2

=

0

T_{2}=0

T2=0,那么微观平均F-measure为8/13=0.615。

要优于当

T

2

=

−

1.75

T_{2}=-1.75

T2=−1.75时的值:10/19=0.526。然后在algorithm 1种得到平均阈值。如果训练/验证分割的分布差别不大,则这次设置是合理的。

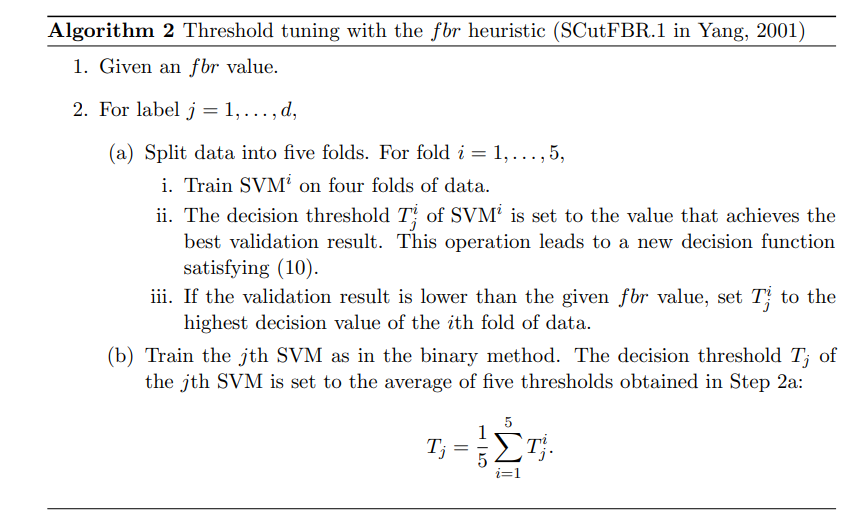

Yang(2001)认为:

- 过高的阈值会降低宏观平均F-measure

- 过低的阈值会降低宏观和微观平均F-measure

Yang(2021)等人接着提出了 f b r fbr fbr启发式方法:当标签的F-measure没有达到 f b r fbr fbr的预定义值时,我们通过以下两种方法设置阈值:

- SCutFBR.0:阈值设为∞, 此设置不会对微观平均值F-measure产生太大影响(因为标签是基本上没有1),但会损害宏观平均值。

- SCut FBR.1:将阈值设置为验证数据的最高决策值。这种方法对宏观平均值的影响较小。

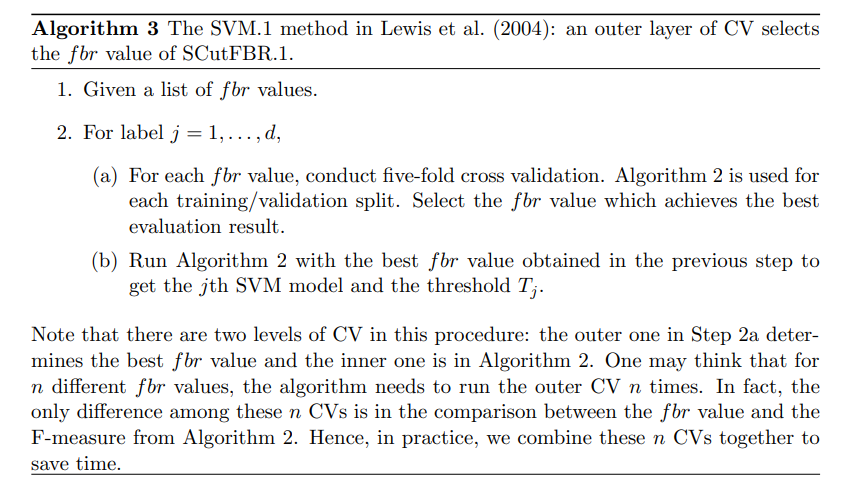

给定一个预先指定的fbr值,algorithm 2给出了使用SCutFBR.1的详细算法,Lewis(2004)等人利用algorithm 2,利用五折交叉验证,得到最佳

f

b

r

fbr

fbr值。SVM.1的算法algorithm 3利用两级的交叉验证进行处理,计算时间更长。

由于SCutFBR.0和SCutFBR.1都将阈值设置为更高的值,因此当得到的F-measure不够好(小于

f

b

r

fbr

fbr)时,我们进行保守预测

避免阈值太低。由于过高的阈值对宏观平均F-measure的伤害更大,因此使用

f

b

r

fbr

fbr时微观平均F-measure更好,但宏观平均可能稍差。

然而,我们的实验给出了完全不同的结果。表2显示了二进制方法和algorithm 1-2之间的比较。我们从OHSUMED数据1中,使用5000个训练点和5000个测试点。我们调整阈值以优化宏观平均F-测度。显然,algorithm 1-2比普通二进制方法要好得多。因此,调整阈值是非常必要的。有趣的是,使用

f

b

r

fbr

fbr的algorithm 2的结果与我们的预期相反:algorithm 2比algorithm 1给出了更好的宏观平均F-measure。我们对许多其他数据集也有类似的观察结果。

因此,Yang(2001)在提出f-br启发式时没有涉及以下问题:

- 这个 f b r fbr fbr启发式是否可能导致阈值过高,从而严重损害宏观平均值?

- 表2显示了更好的宏观平均F-measure。当使用 f b r fbr fbr启发式时,这个结果是如何产生的?

这些将在第五节分析。

Section4 数据和实验设置

真实世界的数据集

#inst 代表数据集的数据量;#feat 代表特征数量;#label代表标签数量;#label size frequency 是数据集中标签size的比率;#label distr ranking是标签类型出现次数的排名。

scene

scene数据集是Boutell等人(2004)提出的一个语义场景分类问题。2407幅图像中的每一幅都与六种不同的语义场景(海滩、日落、秋叶、田野、城市和山脉)中的一些场景相关联。我们在Boutell等人(2004)中使用了相同的设置,其中有1211个训练图像和1196个测试图像。每个实例是从CIE LUV类颜色空间生成的294个特征的图像。我们不缩放此数据集以保留原始颜色信息。

yeast

这是慕尼黑蛋白质序列信息中心(MIPS)的微阵列数据集(Mewes等人,1997)。我们使用与Elisseeff和Weston(2002)相同的数据集进行实验,其中有1500个训练和917个测试实例。数据集中的每个实例代表一个yeast基因,每个基因有103个特征。共有14个基因功能群标签。由于每个酵母基因被分配到一组标签,我们有一个多标签数据集。我们将每个特征线性缩放到范围[−1, +1].

OHSUMED

这个数据集(Hersh等人,1994)是MEDLINE的医学参考文献的集合,MEDLINE是一个医学文献的在线书目数据库。我们的实验基于Cesa Bianchi等人(2005)的特定版本,其中包括94个标签和55503个文档。语料库被随机分成40000个训练文档和15503个测试文档。这个过程重复了五次,所以我们有五对训练和测试实例。

Yahoo! Directories

本系列,用于上田和斋藤(2003年);Kazawa等人(2005年),由雅虎14个顶级分类的网页Yahoo! Directories。我们将属于同一顶级类别的网页视为一个数据集,因此有14个数据集。每个顶级类别都包含几个第二级类别,它们是我们的标签。由于一个页面可能同时属于多个二级类别,因此数据集是多标签的。我们选择了六个数据集:艺术与人文(Ar)、商业与经济(Bu)、计算机与互联网(Co)、教育(Ed)、娱乐(En)和健康(He)。所有实例都用TF-IDF编码并进行余弦归一化。

RCV1-V2

此数据集(Lewis et al.,2004)包含路透社有限公司的新闻报道。Lewis 等人(2004)使用了几种方案来处理文档,包括删除停止词、词干、将文档转换为TF-IDF格式的向量等。每个实例都是余弦标准化的。有三个类别集:主题、行业和地区。在本文中,我们考虑主题范畴集。共有23149个培训和781265个测试实例。对于标签,101出现在训练集中,所有103出现在测试集中。

实验设置

三个文档数据(Yahoo!Directories、OHSUMED和RCV1-V2)很大,因此我们随机选择了几对训练和测试子集。我们使用分层选择,使所有标签出现在训练子集。为了六个Yahoo!设置时,我们选择3000个训练和3000个测试文档,并重复这样的选择5次。

此外,我们还生成了另一对训练测试子集,用于支持向量机的参数整定。对于OHSUMED数据,其原始形式包含五对训练集(40000个实例)和测试集(15503个实例)。我们从训练集中反复选择5000个实例,从测试集中反复选择5000个实例,形成5对。RCV1-V2使用相同的方案生成5个训练/测试pairr,但每个训练(测试)集包含3000个实例。表4总结了我们实验中使用的训练和测试数据的大小。

对于每个问题,我们必须选择一个合适的SVM核。由于yeast和scene的特征数量较少,采用RBF核,将数据向量映射到更高的层次

空间。对于长特征向量的文档,现有的工作表明,它适合留在原始输入空间。因此,我们使用线性核。如果采用RBF核,有两个参数:惩罚参数C和核参数γ。我们通过在参数网格空间上最大化五折交叉精确匹配比来选择它们。当使用线性核时,唯一的参数是C。为了Yahoo!数据,我们使用第六对训练和测试子集从三个值中选择:1、2和4。对于OHSUMED和RCV1-V2,其中每个都有五对训练和测试子集,我们使用第一对选择C。表4列出了最终参数,它们用于所有算法1-3。

算法2中的 f b r fbr fbr值设置为0.1。对于算法3,我们按照Lewis et al.(2004)检查八个 f b r fbr fbr值:0.1到0.8。对于具有多对训练集和测试集的数据集,我们报告平均结果。所有实现都基于LIBSVM(Chang和Lin,2001)MATLAB接口。