- 1python OMP: Error #15: Initializing libiomp5md.dll, but found libiomp5md.dll already initialized

- 2Web3.0介绍与应用_rust web3.0

- 3树莓派系统安装,WIFI、SSH、VNC连接以及WiringPi库安装使用_wiringpi下载

- 4迅速上手:CentOS 系统下 SSH 服务配置指南_centos ssh

- 5DataX-数据迁移Oracle到Mysql-ETL工具_datax实现orcel迁移mysql

- 6LR(Logistic Regression) & XGBOOST 学习笔记_lr、xgboost区别

- 7(二十七)Flask之数据库连接池DBUtils库

- 8机器学习一:Regression回归算法_regression算法

- 9Mac brew安装失败的解决方案 (使用清华大学镜像)_brew 安装失败

- 10【对抗网络】CycleGAN模型讲解和代码实现

gensim 实现 TF-IDF;textRank 关键词提取_gensim获取词频

赞

踩

目录

这里只写了两种简单的提取方法,不需要理解上下文,如果需要基于一些语义提取关键词用 LDA:TF-IDF,textRank,LSI_LDA 关键词提取-CSDN博客

TF-IDF 提取关键词

介绍

TF-IDF(Term Frequency-Inverse Document Frequency)

含义:

-

TF (Term Frequency): 词频,是指一个词语在当前文档中出现的次数。它衡量的是词语在文档内部的重要性,直观上讲,一个词语在文档中出现越频繁,表明它对该文档内容描述的贡献越大。

-

IDF (Inverse Document Frequency): 逆文档频率,是一个词语在整个文档集合中的稀有度度量。IDF值由所有文档的数量除以包含该词语的文档数量,然后取对数得出。一个词语在越多的文档中出现,其IDF值就越小,反之,出现在少数文档中的词语IDF值较大,表示这个词具有更高的鉴别力。

TF-IDF计算公式:

TF-IDF = TF(t, d) * IDF(t)

其中,t是词语,d是文档。

优点:

-

突出重点:通过结合词频和逆文档频率,TF-IDF可以较好地突出文档中重要的、有代表性的词语,抑制常见但不具备独特意义的词语。

-

适应性强:适用于多种应用场景,如信息检索、文本分类、关键词提取等,能够在一定程度上消除文档长度差异对结果的影响。

-

计算简洁:基于简单的数学模型,易于理解和实现。

-

单篇文档也可以用:对于单篇可以吧文档分割为多个段落,以字数,句号等分割,这样就形成了多篇文档,再用就可以了。

缺点:

-

忽视上下文:TF-IDF仅仅考虑了词语在文档内部和文档集合之间的相对重要性,但没有考虑词语间的关联性和语义关系,容易忽略词序和短语结构等信息。

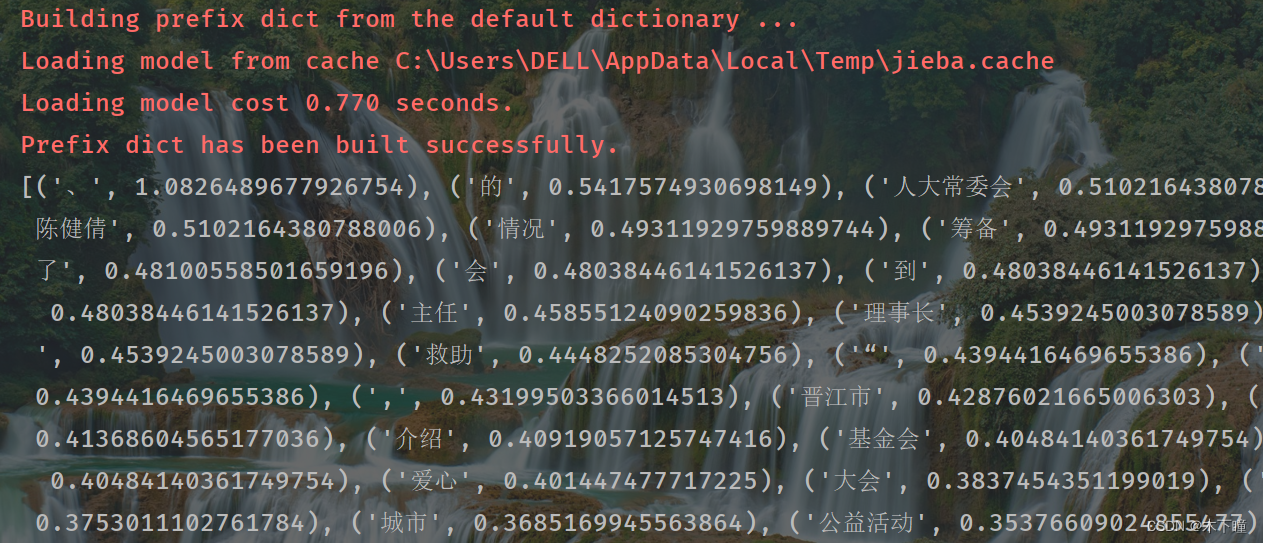

代码

提取一段文本中的关键词,需要先分为对文本分割,一是怕文本太长,而是可能会影响结果;

再对每个句子分词,再开始词袋及下面模型;

这里没有踢掉停用词啥的

- import jieba

- from gensim import corpora, models

-

- # 文本预处理,将文档分为句子

- text = '6月19日,《2012年度“中国爱心城市”公益活动新闻发布会》在京举行。' + \

- '中华社会救助基金会理事长许嘉璐到会讲话。基金会高级顾问朱发忠,全国老龄' + \

- '办副主任朱勇,民政部社会救助司助理巡视员周萍,中华社会救助基金会副理事长耿志远,' + \

- '重庆市民政局巡视员谭明政。晋江市人大常委会主任陈健倩,以及10余个省、市、自治区民政局' + \

- '领导及四十多家媒体参加了发布会。中华社会救助基金会秘书长时正新介绍本年度“中国爱心城' + \

- '市”公益活动将以“爱心城市宣传、孤老关爱救助项目及第二届中国爱心城市大会”为主要内容,重庆市' + \

- '、呼和浩特市、长沙市、太原市、蚌埠市、南昌市、汕头市、沧州市、晋江市及遵化市将会积极参加' + \

- '这一公益活动。中国雅虎副总编张银生和凤凰网城市频道总监赵耀分别以各自媒体优势介绍了活动' + \

- '的宣传方案。会上,中华社会救助基金会与“第二届中国爱心城市大会”承办方晋江市签约,许嘉璐理' + \

- '事长接受晋江市参与“百万孤老关爱行动”向国家重点扶贫地区捐赠的价值400万元的款物。晋江市人大' + \

- '常委会主任陈健倩介绍了大会的筹备情况。'

- sentences = [sentence.strip() for sentence in text.split('。') if sentence.strip()]

-

- # 对每个句子进行分词

- tokenized_sentences = [list(jieba.cut(sentence)) for sentence in sentences]

-

- # 创建词典并转化为词袋表示

- dictionary = corpora.Dictionary(tokenized_sentences)

- corpus = [dictionary.doc2bow(sentence) for sentence in tokenized_sentences]

-

- # 训练TF-IDF模型

- tfidf = models.TfidfModel(corpus)

-

- # 计算TF-IDF值并提取关键词

- keywords_freq = {}

- for bow in tfidf[corpus]:

- for id, freq in bow:

- if dictionary[id] in keywords_freq:

- keywords_freq[dictionary[id]] = keywords_freq[dictionary[id]] + freq

- else:

- keywords_freq[dictionary[id]] = freq

-

- # 结合词典信息,按TF-IDF值排序

- keywords_tfidf = sorted(keywords_freq.items(), key=lambda x: x[1], reverse=True)

-

- # 提取前N个关键词

- N = 10

- print(keywords_tfidf[:N])

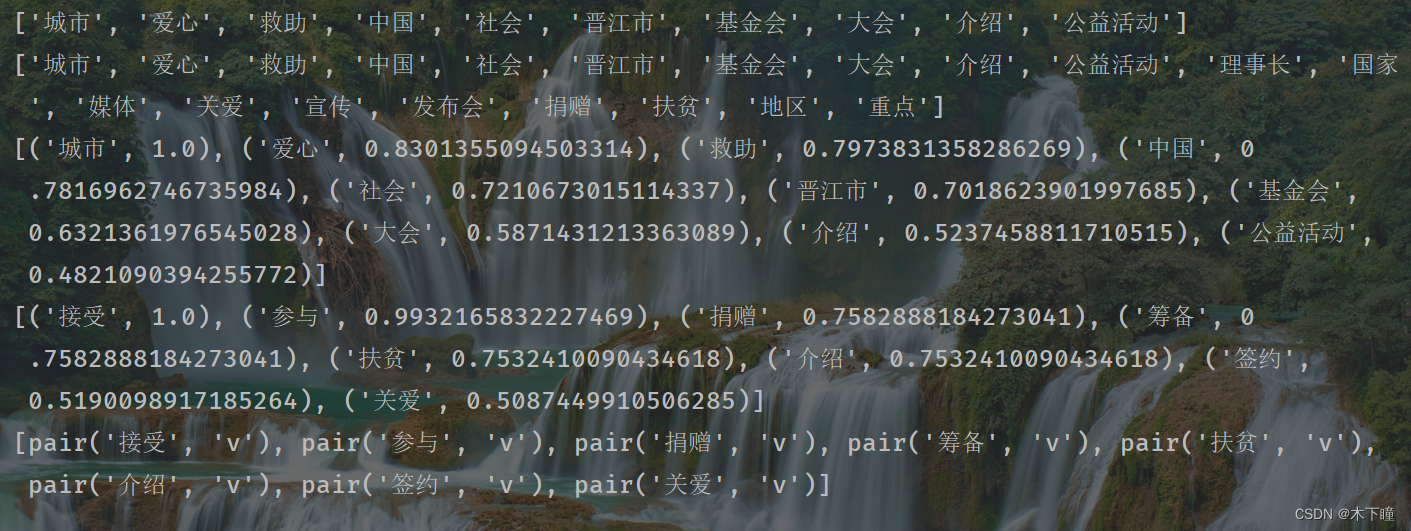

textRAnk 提取关键词

TextRank算法是一种轻量级、易于实现的关键词提取和文本摘要方法,可用与单篇文档关键词提取,主要根据句子间的关联性对词进行分割关键词提取。

jieba 库有实现封装好的,有这么几个参数:

topK=10 选择前几个关键词

withWeight=True 是否显示权重分数

allowPOS=('v') 限制关键词词性,值保留括号中的词性的词,默认为('ns', 'n', 'vn', 'v')

withFlag=True 为 true 那返回格式为 [pair(word1, weirght1),..] 列表

- from jieba import analyse

-

- text = '6月19日,《2012年度“中国爱心城市”公益活动新闻发布会》在京举行。' + \

- '中华社会救助基金会理事长许嘉璐到会讲话。基金会高级顾问朱发忠,全国老龄' + \

- '办副主任朱勇,民政部社会救助司助理巡视员周萍,中华社会救助基金会副理事长耿志远,' + \

- '重庆市民政局巡视员谭明政。晋江市人大常委会主任陈健倩,以及10余个省、市、自治区民政局' + \

- '领导及四十多家媒体参加了发布会。中华社会救助基金会秘书长时正新介绍本年度“中国爱心城' + \

- '市”公益活动将以“爱心城市宣传、孤老关爱救助项目及第二届中国爱心城市大会”为主要内容,重庆市' + \

- '、呼和浩特市、长沙市、太原市、蚌埠市、南昌市、汕头市、沧州市、晋江市及遵化市将会积极参加' + \

- '这一公益活动。中国雅虎副总编张银生和凤凰网城市频道总监赵耀分别以各自媒体优势介绍了活动' + \

- '的宣传方案。会上,中华社会救助基金会与“第二届中国爱心城市大会”承办方晋江市签约,许嘉璐理' + \

- '事长接受晋江市参与“百万孤老关爱行动”向国家重点扶贫地区捐赠的价值400万元的款物。晋江市人大' + \

- '常委会主任陈健倩介绍了大会的筹备情况。'

- textrank = analyse.textrank

- keywords = textrank(text, topK=10)

- # 输出抽取出的关键词

- print(keywords)

-

- textrank = analyse.textrank

- keywords = textrank(text)

- # 输出抽取出的关键词

- print(keywords)

-

- textrank = analyse.textrank

- keywords = textrank(text, topK=10, withWeight=True)

- # 输出抽取出的关键词

- print(keywords)

-

- textrank = analyse.textrank

- keywords = textrank(text, topK=10, withWeight=True, allowPOS=('v'))

- # 输出抽取出的关键词

- print(keywords)

-

- textrank = analyse.textrank

- keywords = textrank(text, topK=10, allowPOS=('v'), withFlag=True)

- # 输出抽取出的关键词

- print(keywords)