- 1为android编译python的图像库pillow_python pil android

- 2逻辑斯蒂回归(Logistic Regression) | 算法实现_logistic regression算法的实现步骤

- 3论文学习——基于改进Bi-LSTM和XGBoost的电力负荷组合预测方法_lstm+xgboos

- 4【正点原子Linux连载】第三十二章 Linux RS232/485驱动实验 摘自【正点原子】ATK-DLRK3568嵌入式Linux驱动开发指南

- 5User class threw exception: org.apache.spark.SparkException: Task not serializable问题解决_diagnostics: user class threw exception: org.apach

- 6【超万字详细Mysql的基本语法之增删查改】_mysql用法

- 7大数据之ZooKeeper介绍_zookeeper集群一般用来实现大数据存储

- 8【蓝牙】BluetoothAdapter详解

- 9国密算法SM2 的JAVA实现(基于BC实现)_java sm2

- 10Vue环境搭建_vue环境安装与配置

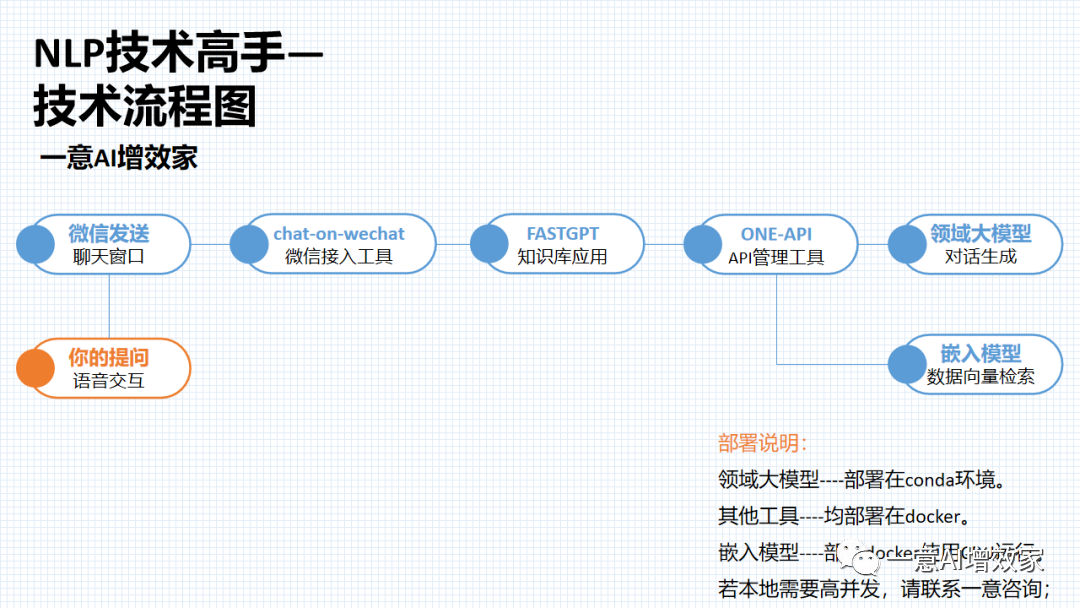

完全体!本地大模型+知识库大功告成!让知识库可以存知识!fastgpt部署m3e嵌入模型!20/45_fastgpt m3e

赞

踩

hi~

上一篇,我们搭建了本地的知识库应用:fastgpt!然后给知识库搭好了桥(one api),并且把本地部署的大模型Qwen-14B/chatglm3-6b接入了知识库!

但是知识库还没有向量的功能,也就是说存不到知识和文档进知识库!

今天跟着雄哥,把嵌入模型m3e,部署到GPU上,打造知识库完全体!

整体项目是这样的!

我们在纯本地的环境搭建,涉及垂类大模型+嵌入模型的部署、docker部署,都搞掂后!

搭建本地私有的知识库!

现在市场上已有大量的知识库/文档对话产品了,学会了这个部署,你基本了解到整个企业知识库部署的过程!内容如下:

day17:动手本地部署ONE-API管理工具,与知识库打通!【已更新】

day18:与知识库对话!部署Qwen-7B/14B,用API接入知识库!【已更新】

dat19:与知识库对话!部署ChatGLM3-6B,用API接入知识库!【已更新】

day20:本地部署M3e嵌入模型!接入知识库,完全体!大功告成!【本篇】

day21:快速上手!3分钟动手搭建私有的知识库!

day22:进阶!三种数据处理办法,提高知识库性能!

day23:进阶!知识库可视化高级编排!

day24:进阶!自定义内容,不该说的一句不说,只聊指定内容!

day25:按部门/学科,建立知识库并分发给对应部门使用

一边做一边看大家反馈,有不清楚的,雄哥再补充!

ok!人的专注力只有10分钟!那,话不多说!

本篇在win11系统完成,需要docker+WSL子系统(非wsl不稳定)!

星球的伙伴学完【7天精通docker】,可以直接上手!

还没来得及学的,可以在星球先学!

点击申请加入知识星球![]() https://t.zsxq.com/15XR5BKhd

https://t.zsxq.com/15XR5BKhd

如果你还没加星球,那你一定要加啦!联系小胖参加 ‘团购’ 活动!

这个过程,任何报错,也可以找他!或者加入交流群!最近我们在跑Agent项目,回复可能有点慢!

整个过程非常的简单!人的专注力只有10分钟!开干!

① GPU部署m3e嵌入模型

② 接入one API中

③ 接入知识库,让它们相认!

④ 塞知识库进去测试!

第一部分:GPU部署m3e嵌入模型

为什么用GPU部署?

快得简直不要不要的!实测跑m3e大概需要1.5G显存,加上GLM3的5G!

8G显存的卡,也能玩得飞起!

现在,跟着雄哥打开命令行!

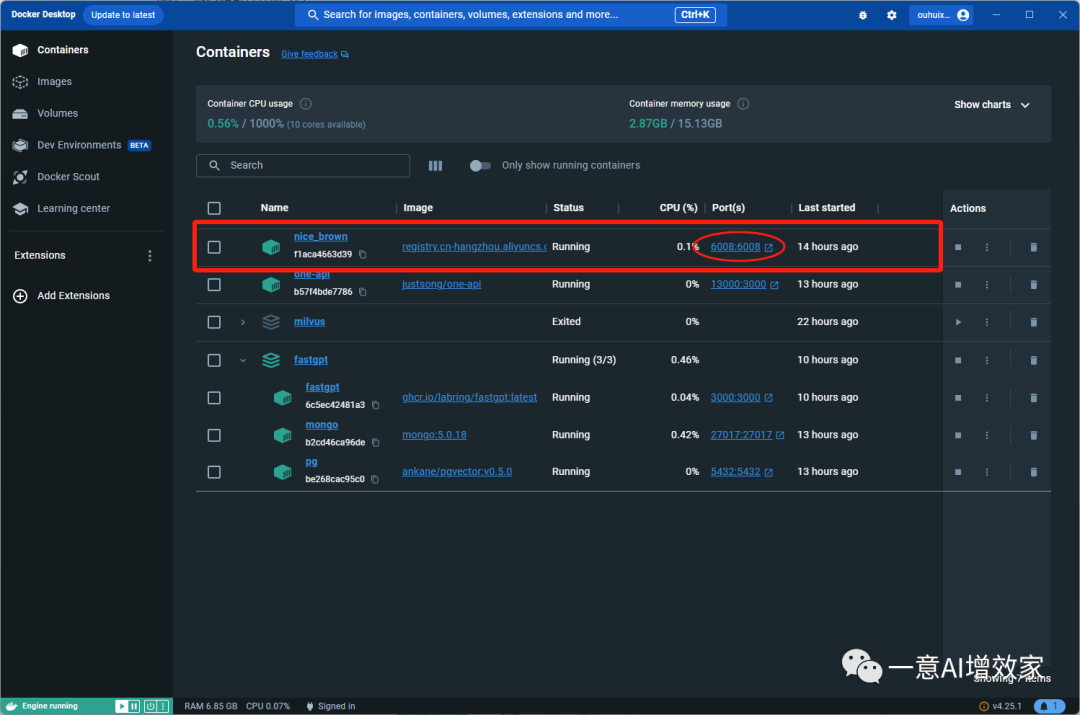

之后他会自动下载镜像,并且在docker上运行!

docker run -d -p 6008:6008 --gpus all registry.cn-hangzhou.aliyuncs.com/fastgpt_docker/m3e-large-api:latest这里解释一下代码!因为使用了GPU部署,所以我们加了一个GPU选项!

否则他默认是CPU启动,这样的话不稳定,而且速度上差很多!

docker run:这是Docker命令,用于启动一个新容器。

-d:这是一个选项,表示以分离模式(detached mode)运行容器。这意味着容器将在后台运行,并且不会阻塞当前终端。

-p 6008:6008:这是一个端口映射选项,表示将容器内的6008端口映射到宿主机的6008端口。这样,我们可以通过访问宿主机的6008端口来访问容器内的服务。

--gpus all:这是一个选项,表示启用所有可用的GPU资源。这样,容器可以将GPU资源全部用于加速计算任务。

registry.cn-hangzhou.aliyuncs.com/fastgpt_docker/m3e-large-api:latest:这是要运行的Docker镜像的名称和版本。在这个例子中,我们运行的是一个名为m3e-large-api的镜像,版本为latest。

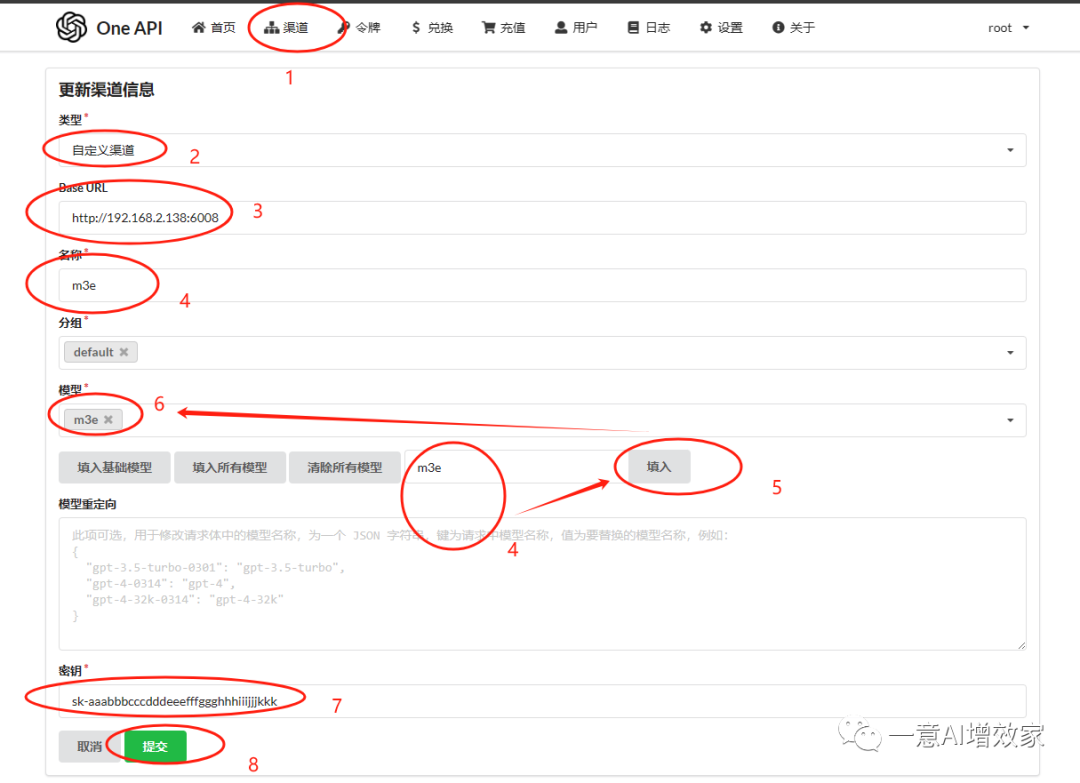

第二部分:接入one API

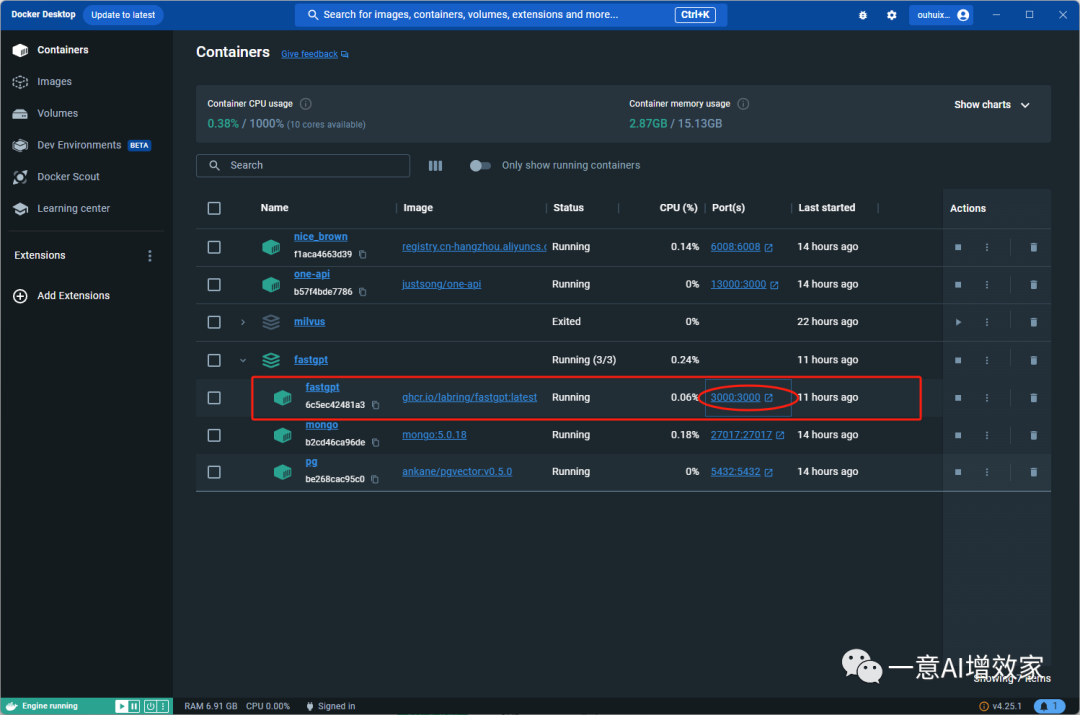

我们看上图,已经成功在6008端口部署成功了!

切记,不要跟现有的端口有冲突,如果有冲突的话,需要改一下!

现在,跟着雄哥把他接入到one api中转站里!

登录打开one api管理界面!按照这个配置填好!提交!

第三部分:接入知识库

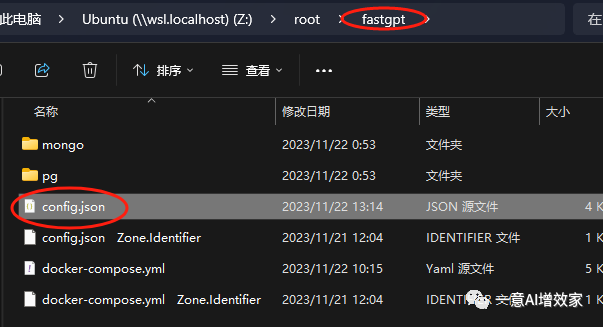

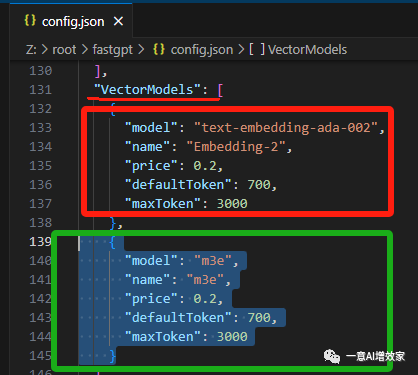

上面我们配置好了!我们要让知识库能顺利调用它!还需要改改文件!

不然,知识库不知道怎么调用这个嵌入模型!

我们打开fastgpt的配置文件!还记得在哪吗?

直接复制原先的,粘贴新建!改为m3e!

注意这个小逗号啊!如果你这个逗号少了,那这个配置文件就失效了!

保存!在docker上重启!

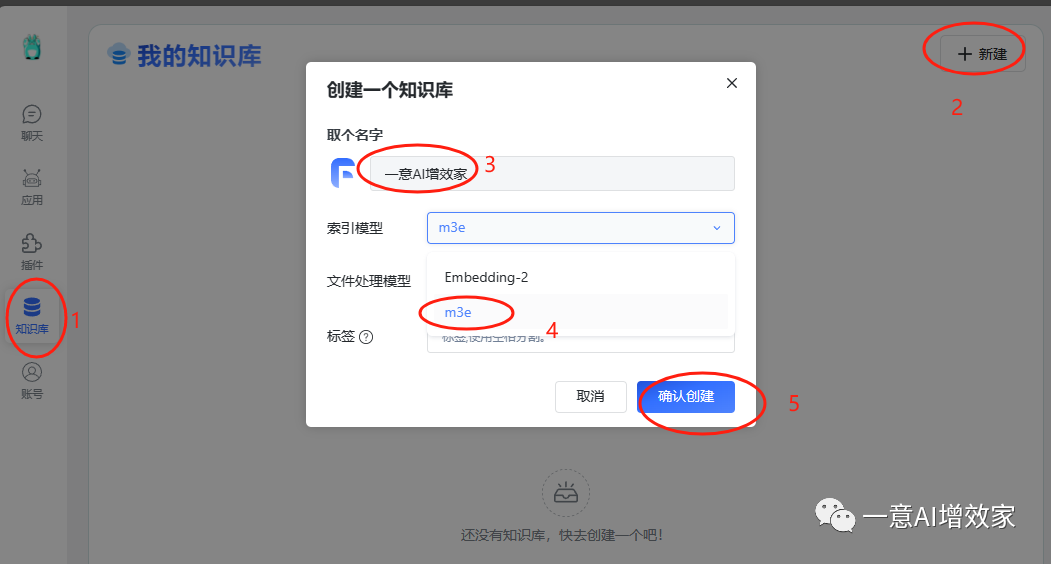

第四部分:塞知识库进去测试!

重启之后,我们打开docker上fastgpt的端口,自动跳转到登录页面!

输入账号密码!登录!

后面雄哥会教大家怎么用的!现在先跟着创建知识库!测试!

如果你在这一步,看不到m3e的选项,那肯定是配置文件写错了!

无法解决的,直接进群反馈或者找小胖!

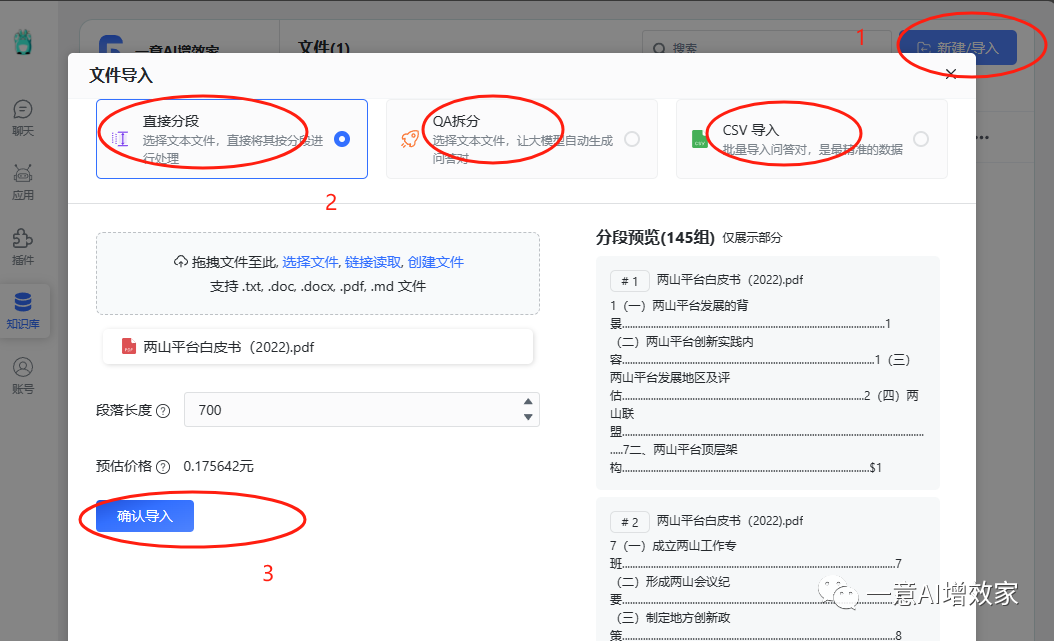

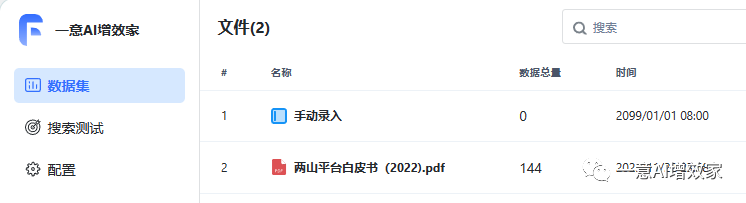

创建成功后,我们就可以上传文件了!

确定导入之后!我们看到这个速度非常快!

都是因为使用了GPU部署,两秒钟搞掂!

现在去测试一下吧!

到这里!

我们的知识库和大模型已经部署完成了!

下一步,我们要开始搭建属于自己的知识库进去!

最后输出到微信/网页上提供服务!

也许你会遇到很多问题!请坚持下去!

雄哥会提供这方面助理!

如果条件运行,加入星球吧,会帮你节省很多时间!

- 相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。