- 1IDEA起步(三) - Maven配置以及在pom文件中快速添加依赖_idea怎么与pom文件关联

- 2[易语言]使用易语言部署yolov5-7.0的图像分类模型_eai 易语言 yolov7

- 3Windows安装PHP及在VScode中配置插件,使用PHP输出HelloWorld

- 4CVHub|AI标注神器 X-AnyLabeling-v2.3.0 发布!支持YOLOv8旋转目标检测、EdgeSAM、RTMO等热门模型!_x-anylabeling 2.3

- 5本地部署github上的stable diffuion,轻松玩转ai绘画(新手小白也能懂)_github ai绘画

- 6VSCode更新之后出现的问题 自动下载.NET Runtime_vscode downloading .net version(s) 7.0.15~x64

- 7【LangChain】Memory_langchain的memory

- 8Keras深度学习实战系列:卷积神经网络详解与实现_卷积神经网络 keras

- 9EasyCVR视频融合平台如何助力执法记录仪高效使用

- 10ICP算法

AI生成漫画或者小说推文——自动根据角色画绘本如何保持角色生成一致性的问题_stable diffusion 绘本 角色

赞

踩

前言

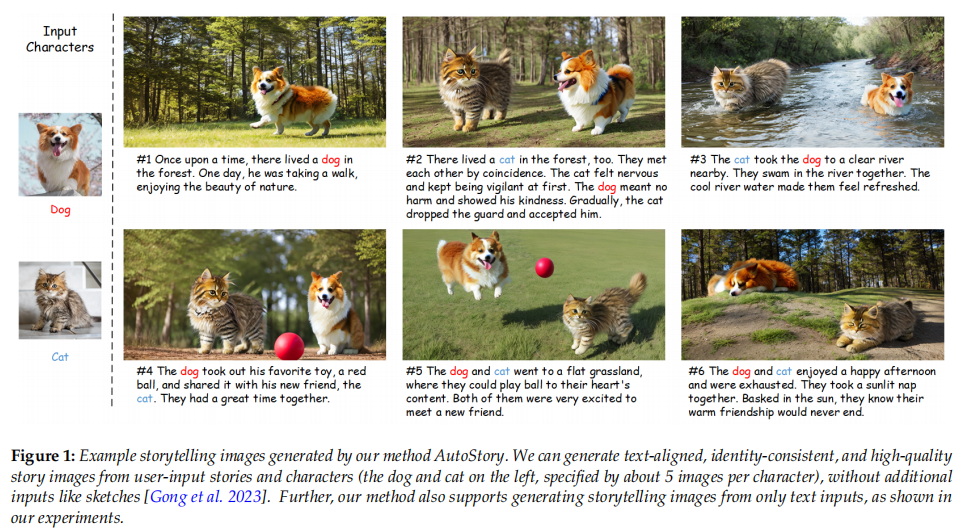

生成与文本描述相匹配的一系列图像是一个复杂的任务,要求生成的图像在质量上要高,与文本描述保持对齐,并且保持角色身份的一致性。例如在使用Stable Diffusion生成人物中要实现不同的动作图像,但要求衣服、发型和相貌保持不变。或者,可以根据一个已有的角色生成各种不同风格的海报图,而无需对模型进行额外的训练。目前的方法通常通过限制考虑特定的少数角色和情境,或者要求用户提供每个图像的详细控制条件(如草图)来大大简化问题。然而,这些简化使得这些方法无法胜任实际应用的需求。

近期由浙大发表的论文AutoStory和谷歌论文The chosen one提到了一些可能的解决方案。

AutoStory

一、简介

本文提出了一种名为AutoStory的全自动、多样化、高质量的故事可视化方法。用户只需输入简单的故事描述,即可生成高质量的故事图像。与此同时,该方法还提供了灵活的用户界面,允许用户通过简单的交互来微调故事可视化的结果。这种方法具有广泛的应用前景,可以为艺术创作、儿童教育和文化传承等领域提供丰富的视觉表达。

本文提出了一种全自动的故事可视化流程,能够在最小的用户输入要求下生成多样化、高质量和一致的故事图像。为了处理故事可视化中的复杂情境,我们采用了稀疏控制信号进行布局生成,并利用密集控制信号进行高质量图像生成。同时,我们引入了一种简单而有效的密集条件生成模块,可以将稀疏控制信号自动转换为草图或关键点控制条件。为了保持身份一致性并消除用户为角色绘制或收集图像数据的需求,我们提出了一种简单的方法,从文本中生成多视角一致的图像。此外,我们利用3D先验来提高生成的角色图像的多样性,同时保持身份一致性。这是第一个能够在多样化的角色、场景和风格中生成高质量故事图像的方法,即使用户只输入文本,也能灵活适应各种用户输入。

二、故事可视化

故事可视化是一项任务,旨在从文本描述中生成一系列视觉一致的图像。现有方法主要基于GAN,但由于模型生成能力的限制,很多方法在特定数据集上简化任务,难以泛化到不同的角色和场景。一些新方法采用了VQ-VAE和基于transformer的语言模型,或者借助预训练的DALL-E进行改进。其中一些方法还提出了新的任务,如故事延续和自回归方法。

大规模预训练的文本到图像生成模型的发展为可推广的故事可视化开辟了新的机会。尽管已有多种尝试生成具有多样化角色的故事图像的方法,但存在一些限制。TaleCraft提出了一种系统化的故事可视化流程,但需要用户提供每个角色的草图。相比之下,我们的方法只需文本描述作为输入即可生成多样化且连贯的故事可视化结果。

三、可控图像生成

大规模预训练的文本到图像模型可以通过交叉注意力层将文本信息传递到图像的潜在表示中,从而生成图像。稳定扩散是一种大规模预训练的文本到图像模型,可以通过文本提示生成图像。

T2I模型在生成多个角色和复杂场景方面表现不佳,因为受到文本编码器语言理解能力的限制和文本到图像内容关联性差的影响。为了解决这个问题,一些方法引入了显式的空间引导,例如ControlNet、T2I-Adapter和GLIGEN。这些方法通过引入可靠的控制和注入指导特征,使得模型能够更好地利用输入信息。

最近的研究使用大型语言模型(LLMs)进行布局生成,其中LayoutGPT和LLM-grounded Diffusion都取得了不错的效果。然而,LLM-grounded Diffusion需要仔细的超参数调整,而且难以控制生成对象的详细结构。相比之下,本文使用直观的草图或关键点来指导最终图像生成,可以实现高质量的故事图像生成,并允许通过调整生成的草图或关键点条件来进行交互式故事可视化。

四、自定义图像生成

现有方法在一次性定制化方面表现不佳,需要多个用户提供的图像。为了解决这个问题,提出了一种无需训练的一致性建模方法,并利用3D感知生成模型中的3D先验知识,获得多视角一致的角色图像,从而消除了依赖人工收集或绘制角色图像的需求。同时介绍了多种不同的定制化方法,包括单个对象的定制化、多个对象的定制化、多个定制化权重的融合等。

本文介绍了一种生成多样化故事图像的方法,结合了LLMs和大规模文本到图像模型的能力。该方法包括条件准备阶段和条件图像生成阶段,通过LLMs将文本描述转换为故事图像的布局,使用简单而有效的方法将稀疏边界框转换为密集控制信号,生成具有合理场景布局的故事图像,并提出一种方法,使用户无需收集每个角色的训练数据即可生成一致的故事图像。该方法只需要在少量图像上微调预训练的文本到图像扩散模型,可以轻松地在任意角色、场景甚至风格上利用现有模型进行故事叙述。

五、 从故事到布局的生成

1. 故事预处理

用户输入的文本可以是一个书面的故事

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。