热门标签

热门文章

- 1自然语言处理选择题_rb.sub(自然语言处理,nlp,text1)表示的含义是

- 2第三次面试总结 - 吉云集团 - 全栈开发

- 3高可用、高性能、高扩展推荐系统的构建过程及架构演进

- 4基于springboot框架的校园食堂外卖点餐系统_餐饮外卖系统国内外研究现状

- 5Kafka入门到起飞系列 - 副本机制,什么是副本因子呢?_kafka 副本因子

- 6AI发电厂——数据标注公司(国内数据标注公司服务调研)_数据标注外包公司

- 7基于Selenium+Python的web自动化测试框架(附框架源码+项目实战)_selenium+python 的 web 自动化测试开源框架下载

- 8Caddy2学习笔记——Caddy2反向代理docker版本的headscale_caddy反向代理

- 9基于vue技术的农产品商城系统(开题报告+源码)_vue农产品介绍前端模板

- 10Android_studio入门之Linearlayout+基本初级语法_androidstudio常用的语句

当前位置: article > 正文

Sigmoid激活函数和ReLU激活函数的区别:_sigmoid和relu区别

作者:菜鸟追梦旅行 | 2024-03-29 04:04:15

赞

踩

sigmoid和relu区别

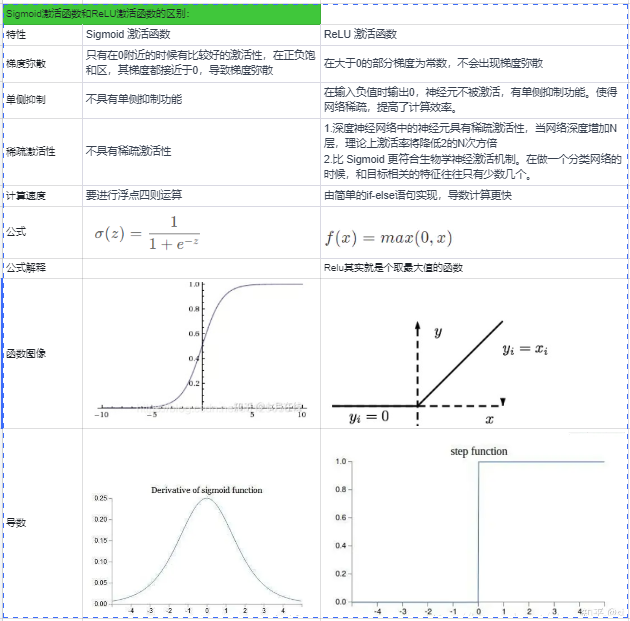

| Sigmoid激活函数和ReLU激活函数的区别: | ||

| 特性 | Sigmoid 激活函数 | ReLU 激活函数 |

| 梯度弥散 | 只有在0附近的时候有比较好的激活性,在正负饱和区,其梯度都接近于0,导致梯度弥散 | 在大于0的部分梯度为常数,不会出现梯度弥散 |

| 单侧抑制 | 不具有单侧抑制功能 | 在输入负值时输出0,神经元不被激活,有单侧抑制功能。使得网络稀疏,提高了计算效率。 |

| 稀疏激活性 | 不具有稀疏激活性 | 1.深度神经网络中的神经元具有稀疏激活性,当网络深度增加N层,理论上激活率将降低2的N次方倍 2.比 Sigmoid 更符合生物学神经激活机制。在做一个分类网络的时候,和目标相关的特征往往只有少数几个。 |

| 计算速度 | 要进行浮点四则运算 | 由简单的if-else语句实现,导数计算更快 |

| 公式 | ||

| 公式解释 | Relu其实就是个取最大值的函数 | |

| 函数图像 | ||

| 导数 | ||

声明:本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:【wpsshop博客】

推荐阅读

相关标签