- 1git常用回滚命令_git rollback命令

- 2工作记录------PostMan自测文件导入、导出功能_postman 导出pdf

- 3Linux 环境配置 VScode copilot_linux copilot

- 4FPGA-图像处理-仿真_vivado图像处理仿真

- 5Windows下常用的DOS命令_windows dos命令

- 6【主色提取】模糊C均值(FCM )聚类算法和彩色图像快速模糊C均值( CIQFCM )聚类算法_什么是fcm聚类

- 7WebUI自动化学习(Selenium+Python+Pytest框架)002_pyhton使用pytest框架写webui自动化

- 8Golang中的字符串迭代与索引_go 字符索引

- 9未来10年云计算发展前景如何?云计算的优势在哪里?_云计算在未来5-10年对商业和社会产生的影响和变化

- 109.4.k8s的控制器资源(job控制器,cronjob控制器)

液冷数据中心如何构建,蓝海大脑液冷技术保驾护航_液冷机柜定制设计及工艺集成方案怎么写

赞

踩

随着云计算、大数据、人工智能等技术的发展和应用,“东数西算”政策的落地以及数据中心规模不断扩大,数据中心总体耗能不断增加。传统的散热方式已不能满足当前高密度数据中心的发展需求。液冷技术的出现,改善了传统的散热形式,并凭借高可靠、低能耗等优势,逐步被应用于数据中心。

1 数据中心的发展阶段

自20世纪60年代以来,数据中心发展分为三个阶段:

一、早期阶段

1996年,美国 Exodus 公司(专门从事机房设施建设和带宽服务)首次提出 “IDC”。

二、第二阶段

随着时间的推移,数据中心托管服务开始精细化,从完全的服务器托管到网站托管,出现虚拟托管服务。

三、云计算阶段

通过虚拟化技术和容器技术,彻底实现数据中心服务器计算能力资源的池化。所有的CPU、内存、硬盘等资源都由更强大的虚拟化软件管理,然后分发给用户。

2 数据中心的组成结构

从硬件类型上来说,数据中心和我们以前看到的内部机房差不多,只是规格、档次、管理水平更高一点。

如今,随着国家政策变化,国产 CPU 崛起占据越来越多的份额。国产 CPU 采用 ARM 架构,性价比更高,成本更低。

总体来说,数据中心的硬件分为两类,即主设备和支撑设备。

一、主设备

数据中心最基本的主要设备是服务器。和台式电脑一样,包含CPU、内存、主板、硬盘、显卡(GPU)、电源等。

蓝海大脑服务器

服务器机架

一个常见标准机架,高度尺寸通常是 42U。1U等于4.445cm,机架宽度有600mm或800mm。机架深度有很多种,如有600mm、800mm、900mm、1000mm、1200mm等。一般来说,IT设备(服务器)机架较深(1100mm或1200mm),通信设备较浅(600mm)。

IT设备和通信设备的机架深度对比

机架中的IT设备除服务器之外,还有磁盘阵列等专业存储设备。随着大数据的发展,人类产生的数据量每年都在快速增加,增加了对存储设备数量和性能的要求。

众所周知,主流的电脑存储硬盘分为HDD和SSD。HDD是传统的机械硬盘,而SSD是逐渐普及的固态硬盘。SSD属于半导体内存,由于存储速度快体积小,所以很受欢迎。但价格较为昂贵。对于数据中心来说,HDD仍是性价比的主流选择。目前SSD主要用于高端客户和高性能业务。

说到交换机,我们不得不提到一个名词 —— 架顶式。TOR 交换机是数据中心领域常用术语。顾名思义,就是机架顶部的交换机。这种交换机是数据中心最底层的网络交换设备,负责连接这个机架中的服务器和上层的交换机。

TOR 交换机的位置

实际上,机架交换机并非一定放在机架顶部。可以位于机架的顶部,也可以位于机架的中部或底部(一般放在最上面,因为有利于内部布线)。

机架再往上是一排机架和 n 排机架。将这些机架与服务器连接起来需要数据中心的网络技术(最流行的数据中心组网架构是叶脊网络(Spine-Leaf))。

如今,为了高带宽传输数据,数据中心广泛使用光纤替代网线。所以光纤、光模块和光通信设备 (OTN等) 成为数据中心的重要组成部分。

现在流行分布式部署,数据中心之间的数据流量很大,对带宽要求很高。

光通信骨干网设备

二、配套设备

底层配套设备设施分为多种类型,主要包括供配电系统和冷却系统,消防系统、监控系统和建筑管理系统。

-

供配电系统

电源是数据中心正常运行的基础。数据中心配电设备的主要功能是电能的开/关、控制和保护。主要配电设备是配电柜。数据中心配电柜分为中压配电柜和低压配电柜。

数据中心供配电示意图

除配电柜,为保证紧急情况下的正常供电,数据中心还会配备大量的UPS(不间断电源)甚至柴油发电机组。数据中心一般会提供 48V 直流电和 220V 交流电(通过 AC-DC 转换和 DC-AC 逆变转换)。直流现在正成为更多数据中心(如Google)的选择,因为直流损耗更小,电能利用率更高,符合高计算能力数据中心高能耗的发展趋势。

-

冷却系统

目前数据中心制冷主要包括两种方式:风冷和液冷。

风冷

风冷一般采用风冷空调系统。和家用空调一样,数据中心风冷空调也分为室内机和室外机。相对来说,技术成熟,结构简单,容易维护。

液冷

液冷,利用液体作为制冷剂降温散热。液体的导热系数是空气的25倍。相同体积下,液体带走的热量是空气的近3000倍。从噪音上来看,在相同的散热水平下,液冷的噪音比风冷低 20-35 分贝。从能耗来看,液冷比风冷省30%-50%。目前液冷技术被业界普遍看好,但仍处于探索阶段。总的来说,液冷的市场前景非常广阔,据统计市场规模超过千亿。

蓝海大脑液冷散热技术

关于制冷散热值得一提的是,机柜池级、排级、机柜级等近端制冷方式正在兴起,成为新建数据中心的主流选择。传统制冷是房间级,整个机房都是空调制冷。这种方式冷却路径太长,效率太低,无法满足大功率设备的散热要求,能耗也很高。机柜池级、排级、机柜级是以一个机柜池、一排柜或单个机柜为中心进行散热设计。

机柜排级散热,以一排机柜为对象进行风道设计。气流路径明显缩短,散热效率高。除配电和散热制冷之外,数据中心还有一些和管理运维有关的设备设施,例如动环监控系统、楼宇自动控制系统、消防系统等。

3 数据中心液冷技术发展分析

数据中心在信息社会和数字经济发展中扮演着重要角色,提供计算、存储、网络能力、支撑社交、视频、网购等应用的正常进行。如图所示,数据中心能耗结构中冷却系统能耗占据高达40%,成为数据中心进行能效优化的重要因素。

随着国家对新基建的重视,数据中心迎来新的发展浪潮,伴随着数字化社会的发展,数据中心也将会承担越来越重要的角色,推动数据处理、存储、传输等相关设备的建设与发展。

在发展方面,液冷技术在航天等领域内具有很长的应用历史,而在数据中心行业中发展较为缓慢。有专家提出液冷结合风冷技术的双通道系统,且测试实验 PUE 结果达1.1 到1.2 之间;基于多个城市的液冷散热样本数据进行分析,构建不同城市数据中心制冷散热系统的能耗计算模型,有效降低数据中心系统的能耗值。结合数据中心节能分析基础上,采用热回收技术,在降低数据中心能耗的同时,提升热回收效益。在国外,也有大量的研究人员对降低数据中心的损耗进行大量的研究,产生了较多的应用案例,如IBM 公司的 SuperMUC 充分应用液冷技术的制冷优势,大幅度降低了数据中心的损耗率。

针对数据中心液冷技术在不同行业的技术应用发展,下面主要从浸没式、冷板式、喷淋式三种液冷技术的发展进行分析,并将三种液冷技术的特点进行系统的对比,总结出液冷技术的不同特点以及适用应用场景类型,为数据中心液冷技术的场景应用及技术发展提供参考。

液冷技术分析

液冷技术是电子设备进行散热的技术,主要区别于目前常用的风冷技术。当前液冷技术包括浸没式、冷板式、喷淋式等类型。

一、浸没式液冷技术

浸没式液冷技术通过浸没发热器件,使得器件与液体直接接触,进而进行热交换。根据介质是否存在相变化分为单相浸没和相变浸没两种类型。

浸没式液冷技术主要由冷却液、腔体结构、换热模块及相关的连接管道等设施构成。其中,冷却液为数据中心的换热介质,具有高绝缘、低黏度以及超强兼容特性,是浸没式液冷技术的主要媒介。主板芯片等发热器件表面散热性能在很大程度上影响介质沸腾的换热强度,若芯片表面光滑,则液体在换热面上传热系数较高,从而提高热量的散发速率。市场上常采用安装散热罩的方式,增大芯片的散热面积,从而提高数据中心的散热性能,降低损耗率。冷却模块是浸没式液冷技术的主要散热模块,包含液气换热器、循环泵等多个配件设施。冷却模块的部署方式可以影响冷却液的冷凝换热效率,改变浸没式系统的冷却极限,从而降低数据中心的散热效率,其模块大多适用于高性能、高热流的计算场景,如中科曙光 E 级超算设备,完全摆脱风冷散热的制约,去除风冷式散热器,配置 512 个计算节点,系统峰值功耗为 249 kW,PUE 达 1.04,有效解决高密度计算产生的制冷散热问题。

二、冷板式液冷分析

冷板式液冷系统主要由换热冷板、热交换单元和循环管路、冷源等部件构成。冷板式液冷将热量传递给循环管道中的冷却液体,通过液体本身的制冷特性将服务器产生的热量带走,提高冷板的冷却效率,大幅度降低数据中心的能耗。

换热冷板通过空气、水或其他冷却介质在通道中的强迫对流,带走服务器中的耗热能量,可有效降低数据中心的 PUE 值。冷板材质一般由高导热系数的材料构成,使得冷板表面接近等温,带走大量的集中热量。并且冷板的应用减少冷却介质对电子元器件的污染,提高数据中心设施的使用寿命。冷量分配单元主要为竖直和水平两种形式,通过竖直和水平分液单元将低温冷却液均匀的分配给每一个分液单元,防止芯片热量无法有效散出,减少因节点温度升高而发生的隐患,提高系统的计算能力。循环管路是连接换热冷板、热交换单元以及其他相关器件的重要部件,一般分为直连式和环路式两种类型,大多根据数据中心建设的不同需求,选择合适的管路进行连接。冷源作为带走数据中心产生热量的最终出口,是冷却系统的主要组成部分。大多采用室外冷却设备提供的低温冷却水在热交换单元中充当冷源。冷源与升温后的冷却液进行间接接触,通过带走冷却液的热量进行降温,使冷却液以低温状态进入芯片模块,进而进入散热循环。因此,冷源的选择合理与否,将会直接影响整个系统的使用效率及运行的经济性问题,如阿里巴巴千岛湖数据中心利用周边环境的自然资源,采用湖水自然冷却系统等技术,使PUE 达1.28,有效节省数据中心的建设成本。

三、喷淋式液冷分析

喷淋式液冷一般不需要对数据中心的基础设施进行大幅度地改动,只需在喷淋模块调整喷淋头,实现喷淋设备与服务器的精准对应。与传统风冷服务器相比,其可以有效降低器件所产生的热量,从而控制数据中心运行的温度。喷淋式液冷服务器是整个喷淋系统的主要内部器件,凭借其高性能、低能耗、高可靠运行的特点,可以有效降低数据中心能耗。当前,先进的喷淋式液冷服务器大多采用芯片级喷淋液冷技术,通过冷却液带走部件产生的热量,冷却液的温度提升后,随即进入冷却系统的换热装置进行换热。

四、液冷技术对比

对冷板式、浸没式、喷淋式液冷技术进行比对,具体情况如表所示。由表可以看出,冷板式液冷技术在可维护性、空间利用率、兼容性方面具有较强的应用优势;但在成本方面,由于其单独定制冷板装置的原因,导致技术应用的成本相对较高。而喷淋式液冷技术则通过改造旧式的服务器和机柜的形式,大幅度减少了数据中心基础设施的建设成本。浸没式技术与其他两种技术相比,虽然器件的可维护性和兼容性较差,但空间利用率与可循环方面具有较好的表现,降低数据中心的能耗。

液冷产业发展分析

一、行业应用问题分析

液冷技术在数据中心行业的散热方面具有显著的优势,但在数据中心行业大规模应用,仍需提高技术的创新性和适用性,需要解决以下行业发展问题。

1、液冷适用性

每一种新兴技术的应用,都需要厂商进行长期的实验,才能保证技术稳定性。并且在大批量应用之前需进行小规模的定点实验,提高液冷的实用性。当前,液冷技术应当进一步加强小规模的定点实验,并努力批量应用于数据中心行业中。

2、液冷架构重构性

液冷方式的部署环境与传统的机房有较大的差异,而且部署架构也需要重新构建。因此,采用液冷技术不但面临高额的部署费用,而且也增加运维人员的时间成本,大幅度升高了数据中心的运维成本,因此,需要进一步在架构、运维等方面进行优化。

3、液冷设计规范性

液冷在数据中心的建设和测试过程中缺乏成熟的行业规范,大部分企业均根据自身的需求特点进行研发,未达成业界的统一标准。若未进行标准化统一管理,会导致液冷技术不规范发展,一旦产生破坏性故障,会彻底打击液冷技术的发展。同时,非标产品也不利于成本和应用,因此必须加快标准化进程。

二、行业发展建议

液冷技术在数据中心行业的应用中,需要逐步成熟的发展过程,必须依托厂商、用户及行业组织的推进,才能在未来的发展中获得大幅度提升,具体建议如下。

1、完善液冷技术材料的通用性,降低建设成本。

如冷板式液冷技术中,冷板的要求规格较多,导致冷板式技术的成本较高。若对液冷应用的原材料和配件进行深入研究,降低制造液冷原材料和配件的成本,将会大幅度提升液冷数据中心的发展速度。

2、提高液冷技术的运维效率。

液冷技术的运维与传统风冷技术的运维方式相差较大,从而加剧运维人员的工作成本。因此,需要生产配件的各个厂商及设备商提供安装、调试和运维的规范说明。通过标准化的流程,不但保障其应用的稳定性,而且大幅度提升运维人员的工作效率。

3、加强液冷技术验证力度,确保技术可靠运行。

液冷技术的可靠性实施,需要依托于设备商、服务商、用户等企业。从节能性、可靠性和适用性等方面,推进液冷技术示范试点的运行,并在加强验证的基础上,在数据中心行业进行大批量的推广。

4 蓝海大脑液冷解决方案

蓝海大脑液冷技术通过液体作为热量传输媒介,达到降低设备温度的目的。液体直接导向热源带走热量,不需要像风冷一样间接通过空气制冷。对于密度高、规模大、散热需求高的数据中心优势明显。

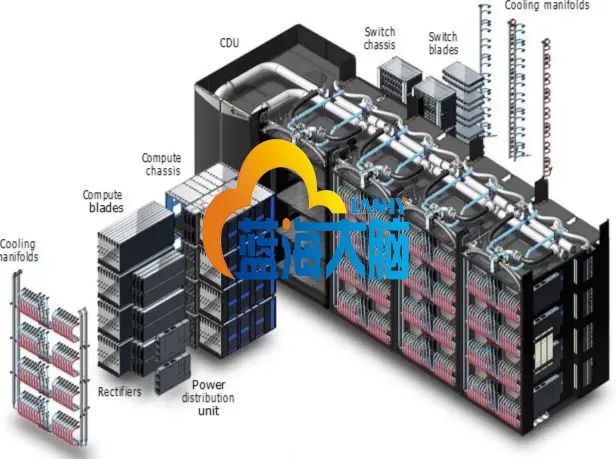

液冷数据中心解决方案

对于需要最大性能、密度和效率的大型系统的客户,超级计算机提供液冷机柜,支持紧凑刀片配置中所有组件的直接液冷。

架构包含许多支持高瓦数 CPU 和 GPU(超过500W)的创新功能,极大地减少互连布线需求,降低操作成本。液冷式基础设施还带来更紧凑的系统结构,减少使用昂贵的光互连电缆。

此外,其基础设施经过精心设计,支持多处理器体系结构和加速器选项,至少在未来十年内与下一代CPU、GPU和互连技术保持向前兼容。

机柜架构

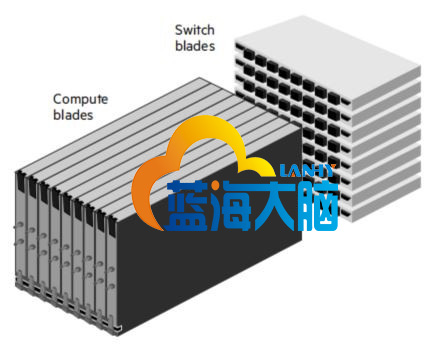

液冷机柜的计算和交换机基本构件包括:

-

服务器机柜:一台机柜可容纳8台机箱,最多支持64个计算刀片和512个处理器。

-

计算刀片:刀片是机箱中的模块,包括CPU、结构连接、印刷电路板,以及冷却和电源组件。预装四个双插座节点。从机柜前部插入机箱。

-

交换机机箱:可容纳8台交换机箱,最多支持64个交换机。从机柜后部插入机箱。

-

交换机刀片:包含光纤交换机,电路板,用于连接计算刀片和冷却所需的所有组件和电源。

每个机柜包含8个服务器机箱和8个交换机机箱,直接从交换机连到刀片上,无需布线。交换机和交换机端口都是直接液冷冷却。刀片垂直放置,交换机水平放置,交换机可以直接与刀片相连接。

预装的液冷计算刀片配备四台双处理器服务器。所有组件均采用直接液体冷却方式。机柜未配置风扇。

网路

-

64 口交换机,提供 12.8 Tb/s 带宽

-

每个交换机机箱最多支持8个交换机刀片,每个计算刀片最多支持8个光纤连接

-

每个机箱2个交换机,用于向32个计算节点(8个计算刀片)单点连接 (每个节点一个网络连接)

-

每个机柜有16个交换机,用于向256个计算节点(64个计算刀片)单点连接 (每个节点一个网络连接)

-

任何端点间,最多3次连接

电源

液冷机柜可支持高达300千瓦的功率。

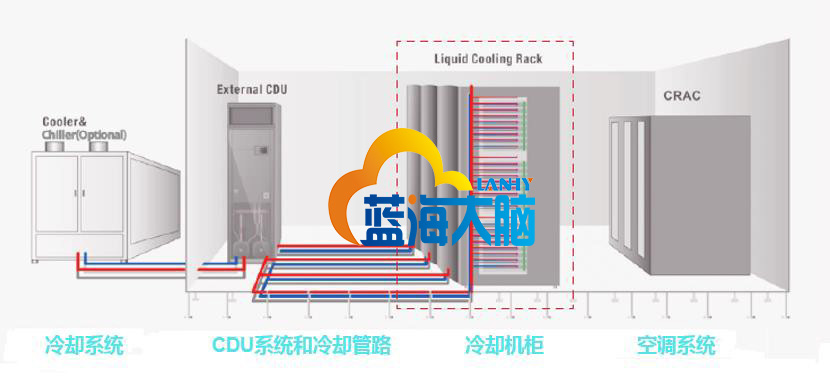

冷却

机柜和所有组件冷却由贯穿整个计算设施的循环液体完成。冷却分配单元(CDU)通过数据中心的热交换器冷却液体将热水排出。

整个冷却回路是一个源自CDU的闭环。一个CDU最多可以支持四个液冷机柜。CDU将冷却液保持在一定温度,并通过热传递机制将热量转移到数据中心的水里。

液体冷却通过一系列流管到达液冷柜中的各个刀片和部件,这些流管将冷却液从主管道分配到各个刀片和交换机,然后将热的液体回流管道。机柜前面配备计算刀片的冷却管,后面配备交换机的冷却管。计算刀片和交换机刀片之间的连接快速且无滴漏,可在不关闭整个系统的情况下卸下刀片服务器进行维护。冷板直接去除CPU中的热量。当NIC夹层卡位于CPU上方时,由CPU冷板冷却。液冷超级计算机的功率和冷却预算大大小于风冷装置。

5 如何构建数据中心?

在介绍建设过程之前,我们先了解一下数据中心的服务提供商。

数据中心服务提供商

虽说数据中心是基础设施,但不是完全属于国有。也可以是民营,由私企建设和运营。但根据国家法律法规,必须持有互联网数据中心经营许可证,才能提供数据中心服务。一般来说,数据中心服务商分为三类公司。

一、电信运营商,如中国移动、中国电信、中国联通。

大型国企,资金雄厚,人才雄厚,资源丰富,基建经验丰富,是国内数据中心市场的主导力量。以中国电信为例,作为国内最大的IDC服务商,他们拥有794个数据中心,50多万个机架,数量最多,分布最广。

二、云计算服务商,如阿里、腾讯、华为等。

提供商本身就开展云计算业务,所以自建或合建大量的数据中心。在数据中心的建设和运营方面非常专业,技术实力较强。以阿里为例,在全球25个地区部署上百个云数据中心,在张北、河源、南通、乌兰察布、杭州等地拥有多个超级数据中心,投资数千亿。

三、专业从事数据中心的第三方服务商,如万国数据、世纪互联、光环新网、宝信软件、中金数据、奥飞数据、数据港等。

通过建设数据中心或者租用运营商的数据中心,为客户提供服务,不受单一电信运营商的网络和地域限制,可以提供相对均衡的网络出口。同时,服务更加灵活,善于根据客户的需求提供定制服务。

根据销售方式不同,第三方数据中心又分为零售型数据中心和批发型数据中心。零售型数据中心面向中小型互联网公司、一般企业等客户,提供相对标准化的服务器托管服务和网络带宽服务。批发数据中心,面向大型互联网公司、云计算厂商或电信运营商,提供定制服务,一般以模块为最小出租单位。

数据中心的建设

数据中心的建设是一个专业性较强的项目,需要较强的资源整合能力。按照时间顺序,数据中心建设不可避免地包括以下一系列专业项目:

-

选址

-

土地、电力、水、能源评估、环境评估等

-

可行性研究

-

项目立项

-

方案设计和施工图设计

-

工程施工总包招标采购、以及监理招标采购

-

专业分包的包界划分、工程分包商采购、主要设备采购

-

土建

-

机电安装

-

设备调试

-

验收交付

在数据中心选址阶段,每个数据中心服务商都会根据自身需求和外部条件 (温度、地质、自然灾害、电力资源、能耗指标) 对数据中心选址进行规划。

数据中心的设计非常复杂,需要考虑的因素很多,也会使用到大量的专业设计工具。

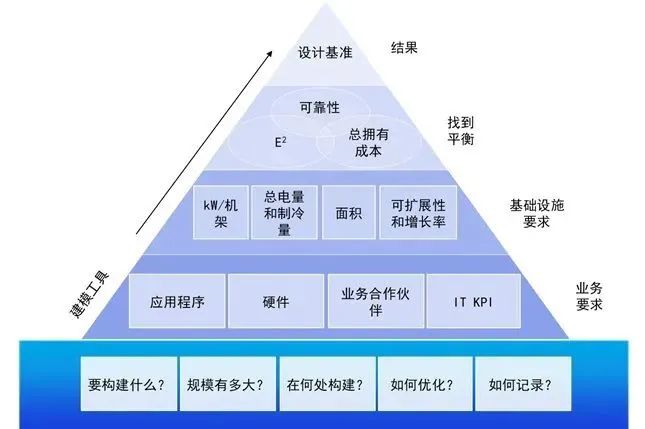

数据中心的规划思路

该设计不仅包括楼宇和园区的总体概念设计,还包括数据中心各子系统的详细设计。需要输出每个细节的设计方案和施工图,方便后续施工。设计完成后,进入真正的施工阶段。施工流程就不一一介绍了。无非是土建施工、配套设备设施安装、主体设备设施安装调试等。

建设过程中的每一个细节,国家都有相应的标准来规范和约束。正规施工单位基本都能满足要求。

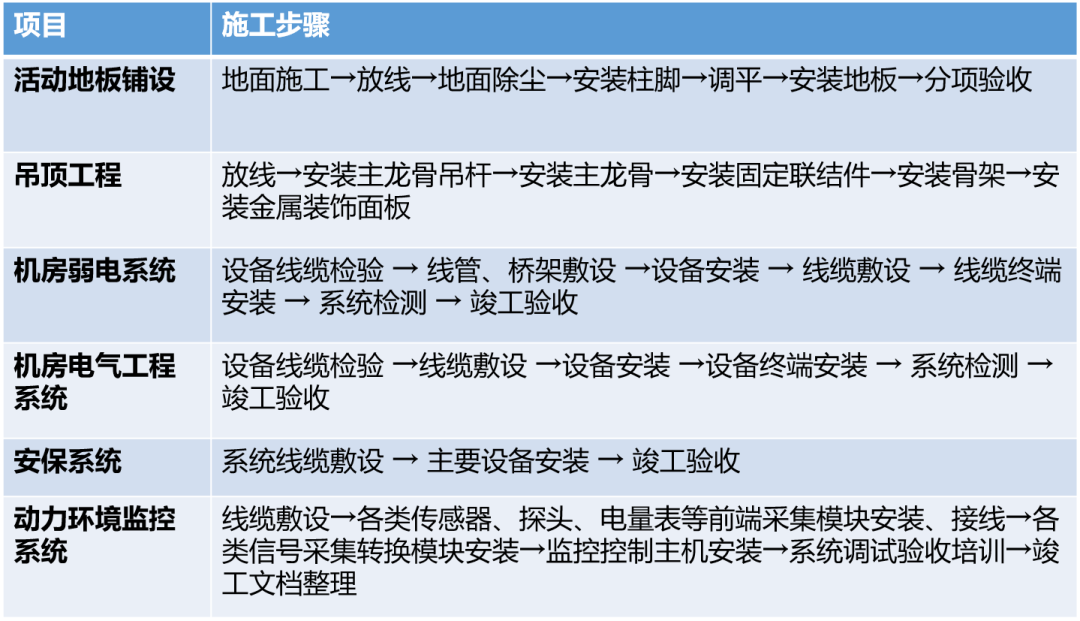

几项常见施工的步骤

6 总结

数据中心是数字时代重要的信息化实施是算力重要载体,直接决定国家的数字竞争力。在“东数西算”战略的推动下,国内数据中心将迎来又一波发展热潮。据统计,2022年中国数据中心业务市场规模将达到3200.5亿元,年复合增长率为27.0%。2025年,国内数据中心IT投资规模预计将达到7070.9亿元。除了数量的快速增加,数据中心正在向绿色和智能方向发展,积极引入AI人工智能,提高能效,降低运营复杂度。未来数据中心是否会有新的形态变化,我们拭目以待。

蓝海大脑液冷服务器是面向数字中心建设的一站式服务器,具有超强算力密度、高能效比、高网络带宽、易扩展、易管理等优点,满足企业机房部署、大规模数据中心集群部署和人工智能计算集群部署。