- 1HikariCP 源码分析之 leakDetectionThreshold 及实战解决 Spark/Scala 连接池泄漏

- 2PHP连接mysql服务器(mysqli方法)及sql语句创建数据库并插入数据_php数据库的连接带插入sql

- 3顺利上岸字节电商后端,但也真的很不顺利

- 405 输入一个地址的访问过程_一个地址的访问流程

- 5技术分享 | 在 IDE 插件开发中接入 JCEF 框架_使用 jcef 开发 idea插件

- 6一站式AI技术宝库:推荐全能型人工智能网站(收藏,一应俱全_人工智能技术学习的网站

- 7Golang实现根据文件后缀删除文件和递归删除文件

- 8windows版kafka异常java.nio.file.FileSystemException另一个程序正在使用此文件,进程无法访问_error while deleting segnebts for kafka

- 9私有git服务多用户管理及权限控制_git用户管理

- 10Magma中ECC的点乘实例

Spark下载与入门_spark download

赞

踩

1 下载Spark

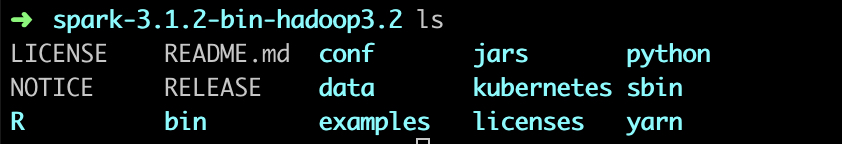

下载和解压缩,首选下载预编译版本的Spark,访问:Spark download,选择包类型为:“Pre-built for Apache Hadoop 3.2 and later",然后直接下载Spark包:spark-3.1.2-bin-hadoop3.2.tgz。下载好后,对包进行解压缩,并且进入到spark目录中:

cd ~

tar -xf spark-3.1.2-bin-hadoop3.2.tgz

cd spark-3.1.2-bin-hadoop3.2

ls

- 1

- 2

- 3

- 4

从中我们可以看到基本文件目录如下:

- README.md : 包含用来入门Spark的简单的使用说明

- bin : 包含可以用来和Spark进行各种方式的交互的一系列可执行文件

- python, R : 不同语言的包程序

- examples: 包含一些可以查看和运行的Spark程序,对学习Spark的API有帮助

- …

2 Spark中的Python shell

Spark带有交互式的shell,可以作即时数据分析。若打开Python版本的Spark shell,也就是PySpark Shell, 进入Spark目录然后输入:

bin/pyspark

- 1

若打开Scala版本的shell,输入:

bin/spark-shell

- 1

稍等片刻,就可以进行交互式的编程了。在Spark中,我们通过对分布式数据集的操作来表达我们的计算意图,这些计算会自动地在集群上并行进行。这样的数据集被称为弹性分布式数据集 (resilient distributed dataset) 简称RDD。RDD是spark对分布式数据和计算的基本抽象。我们先来使用shell从本地文本文件创建一个RDD来作一些简单的即时统计。

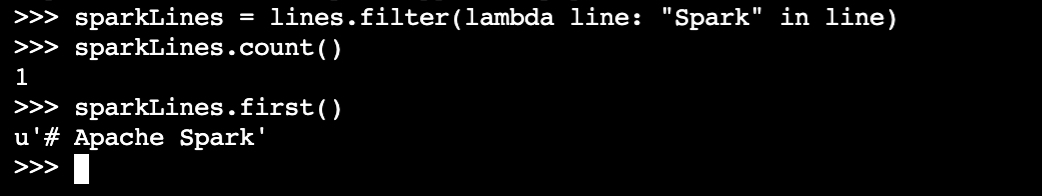

创建一个名为lines的RDD,统计RDD中元素个数(行数),输出RDD中的第一个元素(第一行)。

3 Spark核心概念

每个spark应用都由一个驱动器程序来发起集群上的各种并行操作。而在上面的例子里,实际的驱动器程序就是Spark shell本身。驱动器程序通过一个SparkContext对象来访问Spark。这个对象代表对计算集群的一个连接。shell启动时已经自动创建了一个SparkContext对象,是一个叫做sc的变量。一旦有了SparkContext,就可以用它创建RDD。上面我们调用了sc.textFile()来创建一个代表文件中各行文本的RDD, 我们可以在这些行上进行各种操作。要执行这些操作,驱动器程序一般要管理多个执行器(executor)节点,若果我们再集群上运行count()操作,那么不同的节点会统计文件的不同部分的行数。如下展示了spark如何在一个集群上运行:

我们有很多用来传递函数的API,可以将对应操作运行在集群上。比如,刷选出文件中包含某个特定单词的行:

Spark API最神奇的地方就在于像filter这样基于函数操作也会在集群上并行执行。

4 独立应用

在Python中,可以把应用写成Python脚本,但是需要使用Spark自带的bin/spark-submit脚本来运行。spark-submit脚本会帮我们引入Python程序的Spark依赖。这个脚本为Spark的PythonAPI配置好了运行环境,只需要如下那样运行脚本即可:

bin/spark-submit my_script.py

- 1

一旦完成了应用与spark的连接,接下来就需要在程序中导入spark包并且创建SparkContext。可以先创建SparkConf对象来配置应用,然后基于这个SparkConf创建一个SparkContext对象。基于python语言的初始化spark如下:

from pyspark import SparkConf, SparkContext

conf = SparkConf().setMaster("local").setAppName("My App")

sc = SparkContext(conf=conf)

- 1

- 2

- 3

创建SparkContext的最基本方法,只需传递两个参数:集群URL,告诉Spark如何连接到集群上。在这个例子上,我们使用的是local,让spark运行在单机单线程上而无需连接到集群。应用名:当连接到一个集群时,这个值可以帮助在集群管理器的用户界面中找到自己的应用。

5 总结

Spark编程的核心概念:通过一个驱动器程序创建一个SparkContext和一系列RDD,然后进行并行操作。