- 1poi实现多个word文档合并,加超简单分页教程_poi合并word

- 2ncnn:提取所有层特征值

- 3git恢复rebase过程中遇到权限问题和丢失的提交_git reflog恢复

- 4区块链部署笔记(Centos7)包含fisco bcos与webase!_centos7 部署fisco bcos

- 5深入理解Python中的JSON模块:基础大总结与实战代码解析

- 6建筑类AIGC图像微调模型(LoRA)训练经验介绍

- 7Android APP自动化工具uiautomator2超详细环境搭建+例子演示_uiautomator2 安装(1)_安装uiautomator2

- 8【Gradle:新一代构建工具】学习笔记 3 Gradle进阶说明 3.30 拓展spring-boot-gradle-plugin插件

- 9moveit是如何控制机械臂运动的_moveit 控机械臂

- 10我用Python爬了4400条淘宝商品数据,竟发现了这些“潜规则”

文献学习-31-内窥镜摄像机运动模仿学习的深度齐次变换预测

赞

踩

Deep Homography Prediction for Endoscopic Camera Motion Imitation Learning

在这项工作中,通过从回顾性腹腔镜手术视频中学习模仿行为,研究腹腔镜摄像机运动的自动化。提出了一种新颖的方法,该方法通过基于仿射变换的图像空间中对象运动不变的图像配准来增强外科医生的行为。与现有方法不同,不做出任何几何假设,也不需要深度信息,这使得该方法能够立即转移到机器人系统。与文献中占主导地位的方法不同,后者通常遵循手术工具,不手工制定目标,也不对手术场景强加任何先验,这使得方法能够发现无偏的策略。在这个新兴的研究领域中,在Cholec80和HeiChole数据集上展示了对两个基线的显著改进,相比摄像机运动延续,改进了47%。此外,该方法还被证明能够正确预测AutoLaparo公共运动分类标签中的摄像机运动。

Background

在机器人辅助微创手术中,自动化可以减少因疲劳、注意力不集中和认知负荷导致的错误,帮助外科医生操作系统,尤其在劳动力减少的老年人口社会中,有利于维持医疗服务的可达性。预计 RMIS 的某些部分最终会实现自动化,其中相机运动自动化可能是最先实现的。

现有的相机运动自动化方法主要是基于规则,如将手术工具保持在视野中心,但这过于简化,因为外科医生可能需要观察周围解剖结构来决定操作。相比之下,数据驱动的方法,如强化学习(RL)和模仿学习(IL),能捕捉更复杂的控制策略。目前,RL 因样本效率低和可能对患者造成伤害,主要限于模拟环境。已有工作试图弥合模拟与现实的差距,但还未实现临床应用。IL 则可以从真实数据中学习,间接解决模拟与真实世界之间的差距,但数据收集可能困难。

最近公开的大量腹腔镜手术视频改变了IL在相机运动自动化中的应用方式。这些数据通常用于辅助任务,如工具和器官分割,手术阶段识别。然而,对于相机运动自动化,没有公开可用的图像与行为配对数据。一些研究继续关注于通过手术工具推断相机运动,或者在提供相机运动信息的机器人系统上进行学习。但有研究发现,腹腔镜手术视频本身就包含了相机运动,可以从视频中的动作中学习,无需机器人,直接从人类操作中学习。

Contribution

这项工作,从公开的腹腔镜手术视频数据集中高效地提取图像与行为配对,数据量是私有数据的20倍以上。与现有技术不同,这项工作的相机运动提取不依赖于手术视频中稀疏的图像特征,能自然地区分相机和物体运动。还提出了新的重要性采样和数据增强步骤,以实现模仿学习下的相机运动自动化。

Methodology

这一部分主要介绍了用于学习相机运动预测的方法,可以分为以下几个部分:

1. 理论背景

- 在移动相机下,平面上的点在图像空间中通过3×3的射影单应矩阵$G$进行变换。

- 预测未来相机运动(到一定尺度)可以等价地视为预测未来的射影单应性。

- 使用四点单应性表示$\Delta uv = \{p_i - p_i' | i \in [0, 4)\} \in \mathbb{R}^{4 \times 2}$比使用3×3矩阵表示更适合深度学习应用。

- 相机运动$C$被视为时间范围$[T_0, T_{N+M})$内的一系列四点单应性序列,其中$N$为回忆视界长度,$M$为预览视界长度。

2. 数据和数据准备

- 使用了三个数据集:两个胆囊切除数据集Cholec80和HeiChole,以及一个子宫切除数据集AutoLaparo。

- 为了去除可能影响相机运动估计的状态指示器覆盖,使用圆形视野的边界圆将视图裁剪为240×320。

- 数据集被划分为训练集、验证集和测试集。由于处理原始数据时的错误,从数据集中排除了一些视频。

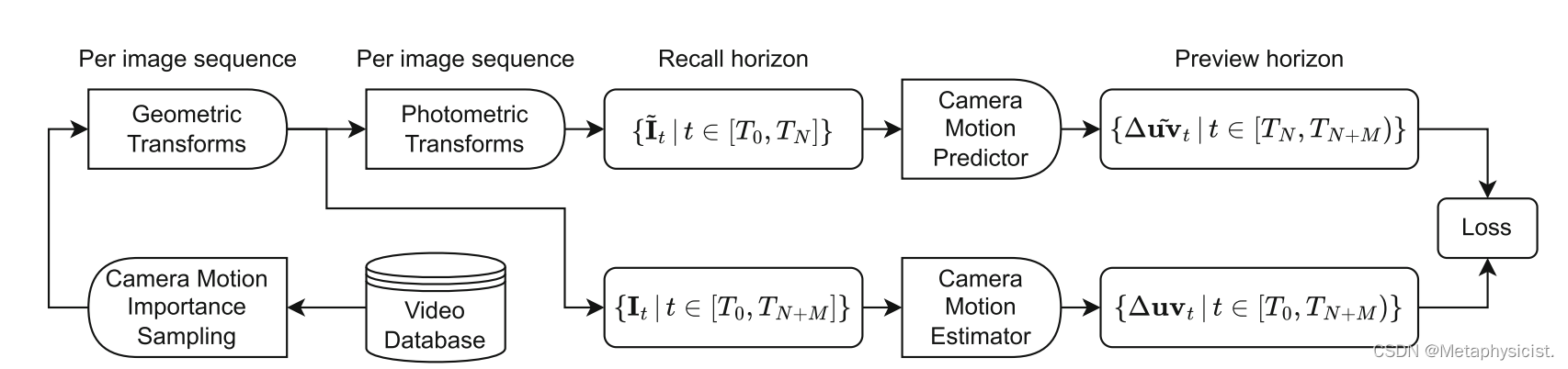

3. 提出的流水线

- 视频数据库和重要性采样:将数据积累到视频数据库中。以帧增量$\Delta n$和序列初始帧间隔$\Delta c$采样长度为$N+M$的图像序列。离线估计帧间相机运动$\Delta uv$,创建图像-运动对应$(I_n, I_{n+\Delta n}, \Delta uv_n)$。对运动幅度大于数据集标准差$\sigma$的对应进行重要性采样。

- 几何和光度变换:对重要性采样的图像序列进行数据增强,包括几何变换(改变方向/上下/左右等)和光度变换(改变亮度/对比度/雾化等)。为确保运动估计性能,光度变换只应用于上支路。

- 相机运动估计器和预测器:预测器以光度和几何变换的回忆视界$\{\tilde{I}_t | t \in [T_0, T_N)\}$为输入,预测预览视界上的相机运动$\tilde{C} = \{\Delta \tilde{uv}_t | t \in [T_N, T_{N+M})\}$。估计器以几何变换的预览视界$\{I_t | t \in [T_M, T_{N+M})\}$为输入,估计相机运动$C$作为预测器的目标。估计器通过几何变换实现在线视角增强。

图1。培训流程. 从左到右:图像序列是从视频数据库中采样的重要性,每个序列在线应用随机增强。下分支估计后续帧之间的摄像机运动,作为上分支的伪GT,它学习预测摄像机在预览视界上的运动。

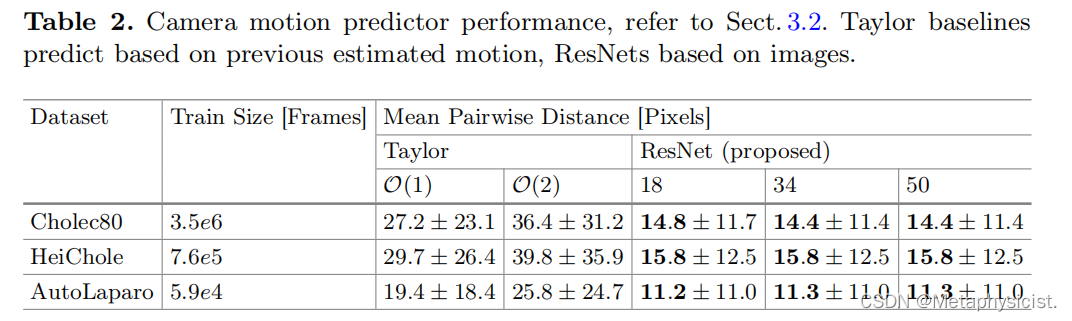

对相机运动估计器和预测器的实验评估的结果如下:

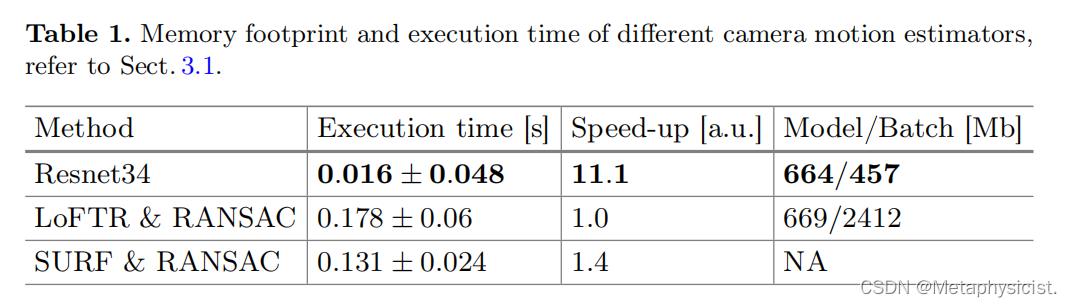

1. 相机运动估计器

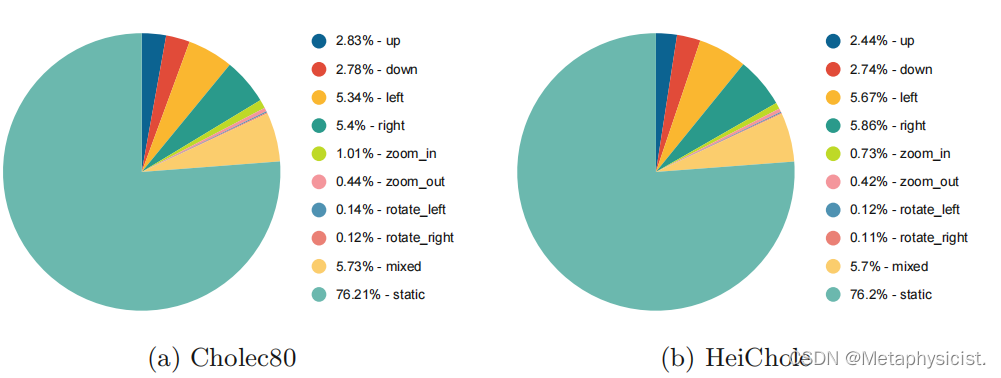

- 相机运动分布:在所有数据集中,大部分序列(71%-76%)没有显著的相机运动,这支持了本文引入的重要性采样。左/右和上/下运动分布均匀。

- 在线相机运动估计:使用ResNet-34主干的深度单应性估计执行速度是GPU加速方法中最快的(是LoFTR & RANSAC的11倍),且GPU内存占用最低。这允许了高效实现在线相机运动估计。

图2。摄像机运动分布,参考本节。3.1.AutoLaparo: 2.81%上,1.88%下,4.48%左,3.38%右,0.45%放大,0.2%缩小,0.3%旋转左0.3%,右旋转14.9%混合,71.29%静态。

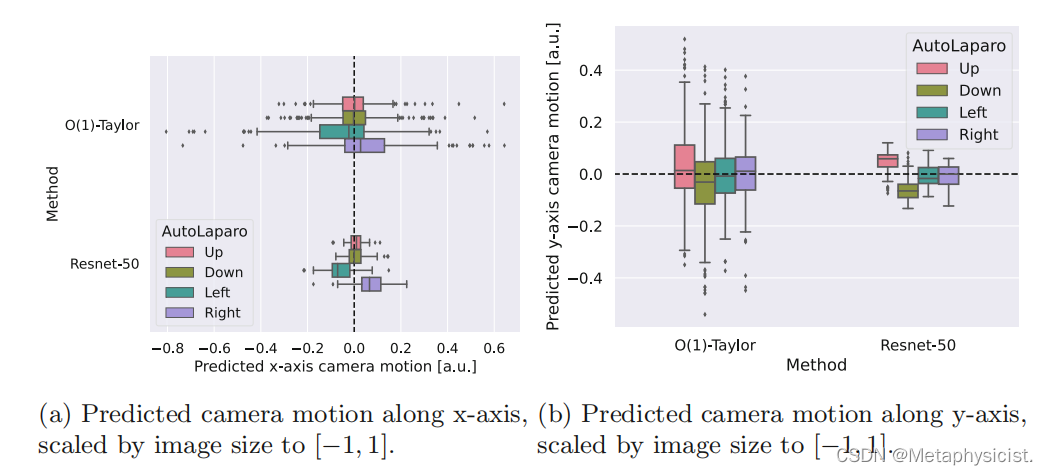

图3。自动预测的摄像机运动,参考节。在使用ResNet-50骨干的Cholec80上训练的摄像机运动预测器,见表2。所示是图像中心在预测的性下的运动。显然,对于标记为左/右的视频,预测中心点将向左/右移动,而对于向上/向下的标签,预测的左/右运动将以零(a).为中心在(b)中观察到上下运动,左右运动为零中心。

图4。典型的摄像机运动预测.在图像序列中,注意力从右向左改变。我们通过预测的同质性来扭曲过去的视图(黄色),并覆盖当前的视图(蓝色)。良好的对齐性对应于良好的摄像机运动预测。与基线相反,所提出的方法能很好地预测运动。数据取自HeiChole测试集,在Cholec80上训练的ResNet-50骨干,见表2。(彩色图形在线版)

2. 相机运动预测器

- 在Cholec80和HeiChole数据集上,学习的预测方法比基线(泰勒展开)取得了显著改进。在AutoLaparo上,学习方法平均优于基线,但改进不显著。

- 在AutoLaparo上,将预测的相机运动下图像中心点的位移与提供的多类运动标注进行对比,发现预测的相机运动与地面真值标签吻合良好。

- 图4展示了一个示例性的相机运动预测结果。在图像序列中,注意力从右侧工具转移到左侧。通过预测的单应性对过去视图(黄色)进行变换并与当前视图(蓝色)叠加,良好的对齐对应良好的相机运动预测。与基线相比,所提出的方法能很好地预测运动。

总的来说,实验结果表明了所提出方法在学习相机运动预测方面的有效性,尤其在Cholec80和HeiChole数据集上取得了显著改进。在线相机运动估计的高效实现为该方法的应用提供了可能。

Source

[1] Huber, M., Ourselin, S., Bergeles, C., & Vercauteren, T. (2023, October). Deep Homography Prediction for Endoscopic Camera Motion Imitation Learning. In International Conference on Medical Image Computing and Computer-Assisted Intervention (pp. 217-226). Cham: Springer Nature Switzerland.