热门标签

热门文章

- 1关于密码加密方式----sha512_sha512hex 不允许有特殊字符吗

- 2清华研究再登Nature!重磅发布世界首个类脑互补视觉芯片_天眸芯片

- 3【Pytorch】VSCode实用技巧 - 默认终端修改为conda activate pytorch_vscod默认conda

- 4计算机键盘盲打方法,电脑键盘盲打练习方法 盲打键盘指法练习技巧

- 5【项目】仿牛客网社区开发 第7章 项目进阶 构建安全高效的企业服务 4 Redis高级数据类型_仿牛客 redis高级数据类型

- 6Element UI中table表格中使用Switch 开关及调接口_elementui el-table列表中加入switch 开关

- 7llama factory 参数体系EvaluationArguments、DataArguments、FinetuningArguments、FreezeArguments、LoraArgument_llamafactory各个参数含义

- 8星光/宝骏/缤果/长安 车机CarPlay盒子权限破解原理普及----小白版本_长安车机 autokit

- 9【河南省科学院、河南大学、郑州航空工业管理学院主办 | EI(核心), Scopus检索】第四届人工智能,大数据与算法国际学术会议 (CAIBDA 2024)_郑州查论文收录

- 10基于FPGA的五子棋(论文+源码)_基于fpga的五子棋游戏论文

当前位置: article > 正文

Windows 搭建自己的大模型-通义千问_windows 部署通义千问

作者:酷酷是懒虫 | 2024-06-19 23:05:34

赞

踩

windows 部署通义千问

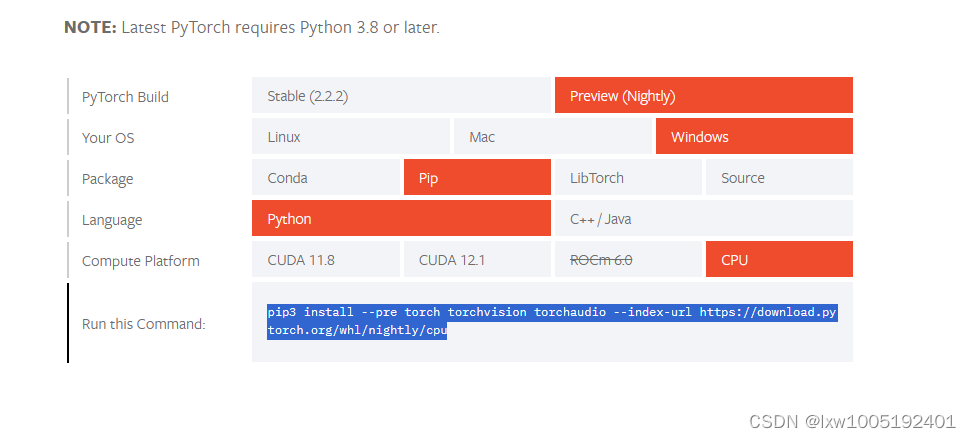

1、安装 pytorch https://pytorch.org/get-started/locally/ 点击进入官网,如图选择自己的环境得到pip安装依赖的命令:

pip3 install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cpu

2、拉取代码并安装依赖

- # 拉取代码

- git clone https://github.com/QwenLM/Qwen-7B.git

- # 进入代码目录

- cd Qwen-7B

- # 安装依赖

- pip install -r requirements.txt

- # 安装 web_demo 依赖

- pip install -r requirements_web_demo.txt

检出的项目为启动项目:Qwen-7B,不包含预训练好的模型文件。

3、启动模型

python web_demo.py --server-port 8087 --server-name "0.0.0.0"

不出意外的话,这里要出现意外了。OSError: We couldn't connect to 'https://huggingface.co' to load this file,大意是不能连接到https://huggingface.co下载模型文件。因为这个地址国内访问不了。只能自己下载模型文件到本地,离线启动。

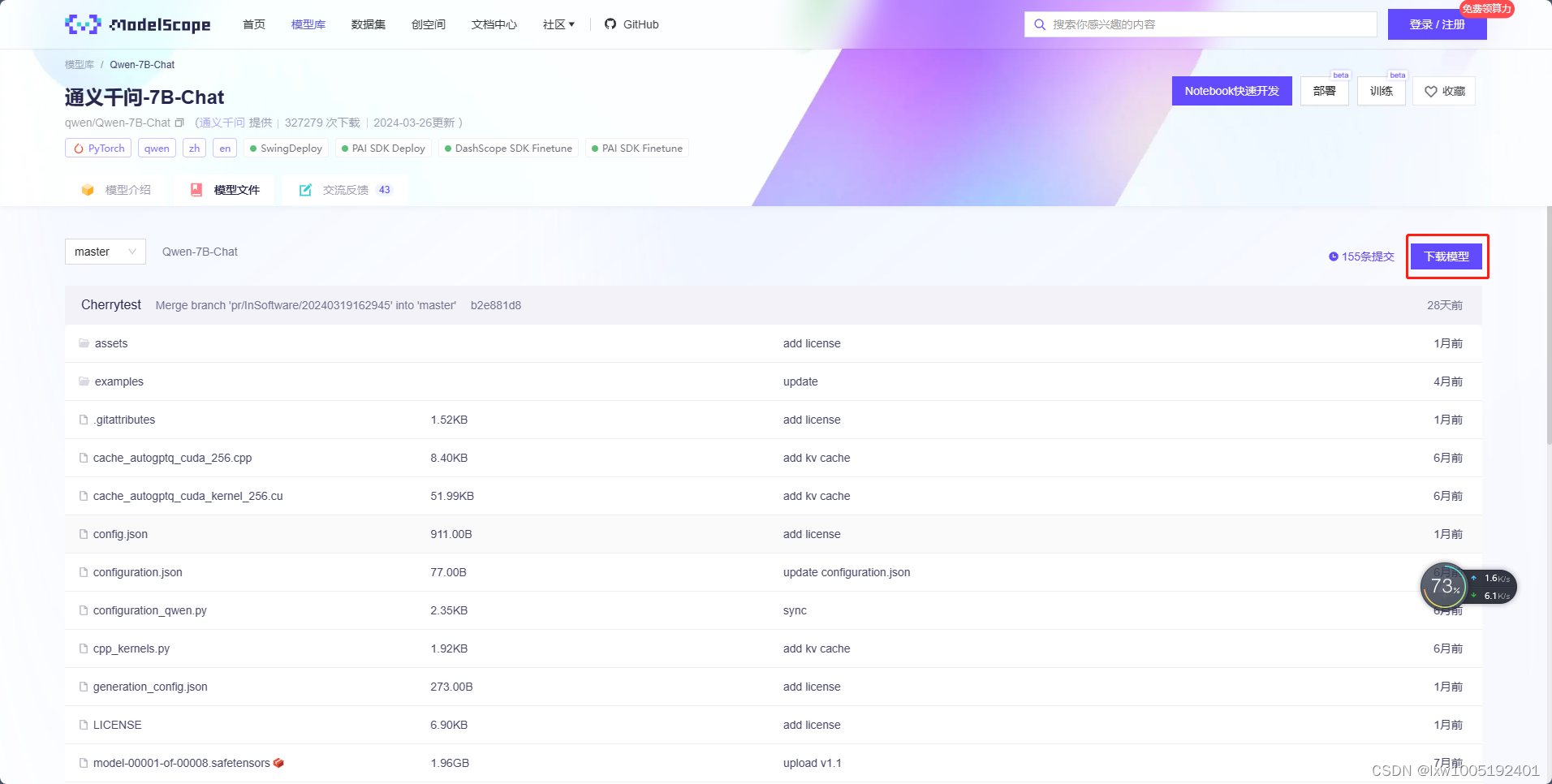

4、模型下载

去魔搭官网下载:https://www.modelscope.cn/models/qwen/Qwen-7B-Chat/files

点击【下载模型】按钮,得到git仓库检出命令:

git clone https://www.modelscope.cn/qwen/Qwen-7B-Chat.git检出模型到本地目录,例如:D:\Qwen\Qwen-7B-Chat

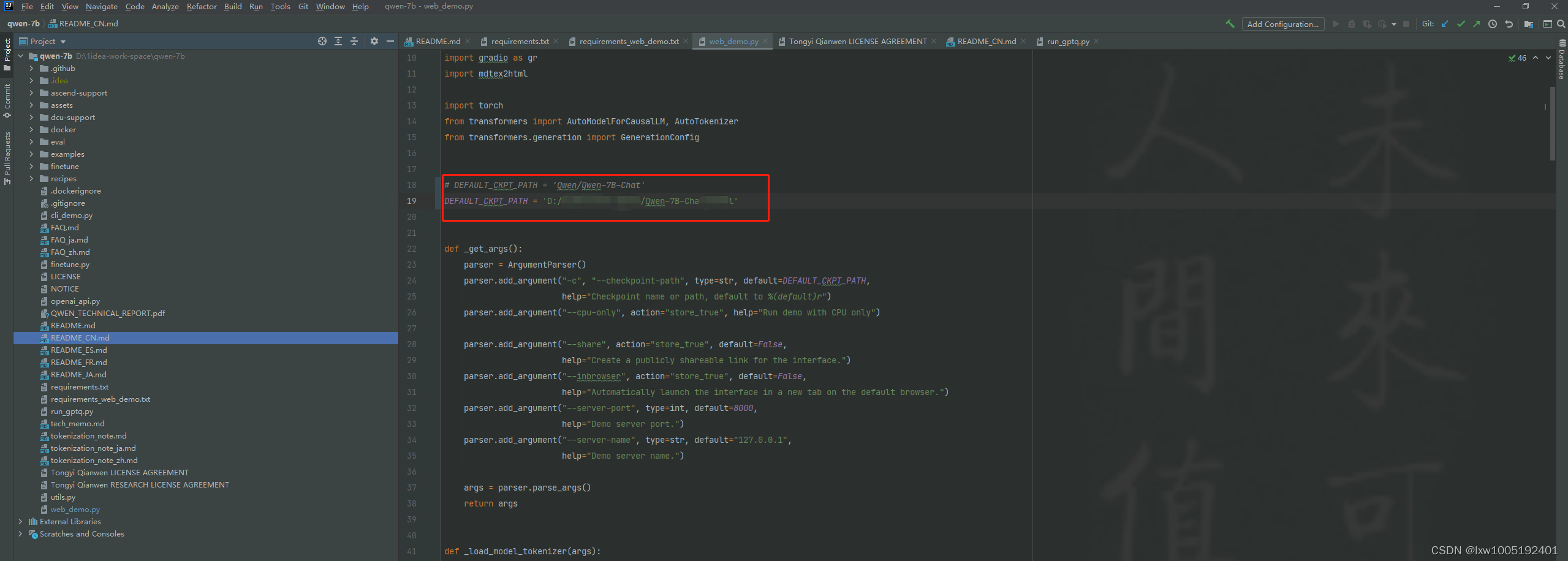

5、修改启动项目:Qwen-7B

找到web_demo.py文件,如图

将DEFAULT_CKPT_PATH参数改为模型下载的路径:D:/Qwen/Qwen-7B-Chat

再次进行步骤3的python文件执行命令。即可启动成功

浏览器访问即可,如图

6、启动 openai api 形式的接口

安装依赖

pip install sse_starlette启动API接口服务

python openai_api.py --server-port 8086 --server-name "0.0.0.0"

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/酷酷是懒虫/article/detail/737850