热门标签

热门文章

- 1Hadoop 教程 - Hadoop YARN应用开发详解

- 22024年【危险化学品生产单位安全生产管理人员】考试题库及危险化学品生产单位安全生产管理人员考试报名

- 3基于matlab实现两条曲线之间的填充阴影区域_matlab加阴影

- 4探索PyTorch-NLP:深度学习在自然语言处理中的高效工具

- 5应用宝shangjia安全评估报告_虎门大桥还安全吗?最新评估报告出来了!

- 6【AIGC调研系列】Gitlab的Duo Chat与其他辅助编程助手相比的优缺点_gitlab duo

- 7阿里菜鸟+腾讯IEG面经(阿里5面,腾讯8面)无限秽土转生_菜鸟网络 二面挂

- 8学籍管理系统mysql实训报告_学生信息系统数据库实验报告.doc

- 9vscode git撤回本地提交commit和 撤销push推送回退旧版本_vscode撤销上次提交

- 10新出炉的热门大厂java开源项目_大厂开源的业务项目java

当前位置: article > 正文

LM Studio本地离线部署大语言模型_使用lm studio运行下载模型

作者:酷酷是懒虫 | 2024-07-02 04:42:27

赞

踩

使用lm studio运行下载模型

LM Studio本地离线部署大语言模型

使用LM Studio快速体验大模型工具,免除Python环境及众多依赖组件的安装。可以切换不同类型的大语言模型,同时支持在windows、linux、mac等PC端部署。

1. 环境配置

本次使用的操作系统及硬件信息如下:

- 操作系统:windows11 23H2

- CPU: intel i7-12700

- MEM: 16GB

- GPU: NVIDIA GeForce GTX 1650

- Disk: 512GB SSD

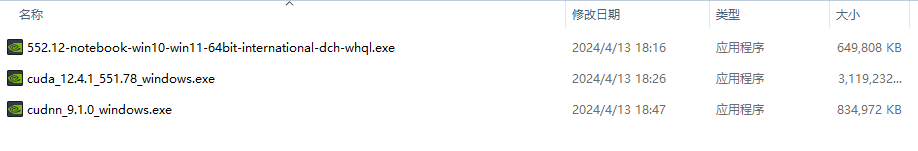

已经安装nvidia显卡驱动+cuda+cudnn,配套如下:

2. 安装LM Studio

访问官网,选择windows版本下载安装。

安装完成打开后的界面如下:

3. 模型配置

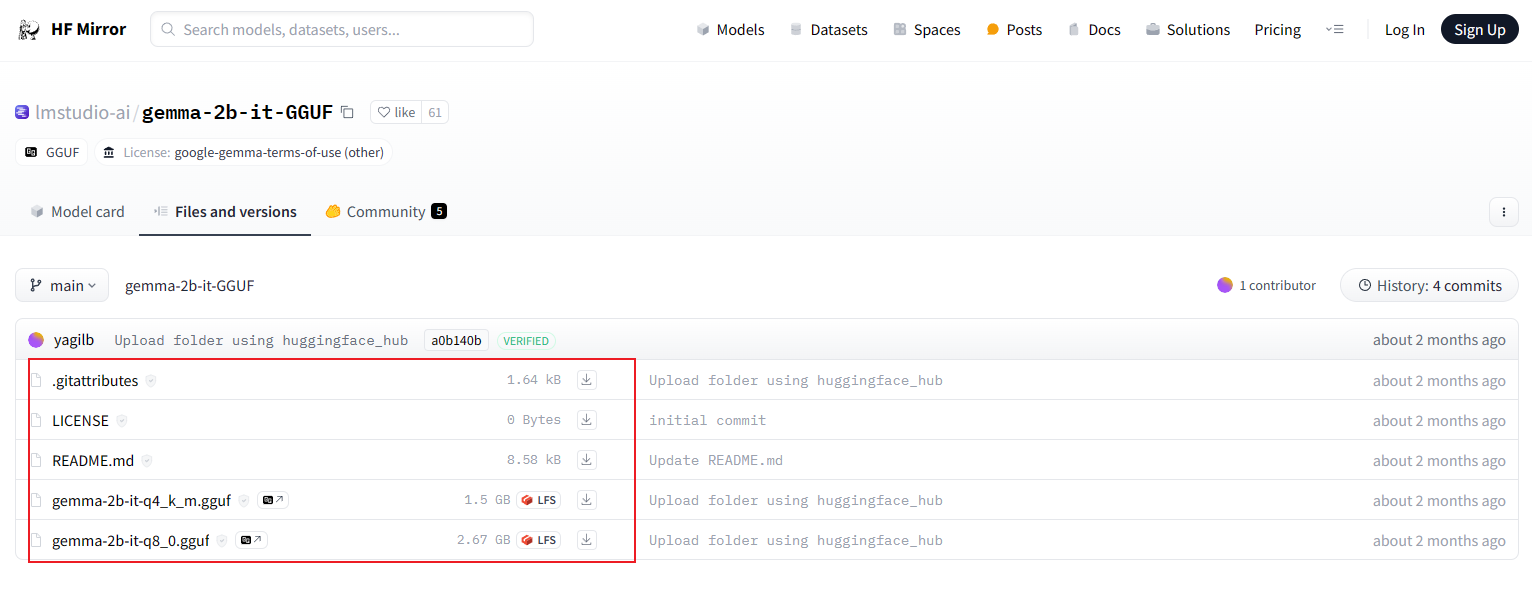

以首页推荐的谷歌deepmind出品的模型Google’s Gemma 2B Instruct为例,点击搜索会跳转到huggingface官网改模型的URL:

https://huggingface.co/lmstudio-ai/gemma-2b-it-GGUF

直接使用lmstudio下载模型会失败,本文采用离线部署模式。

3.1 访问huggingface官网或镜像站点,下载模型文件

huggingface官网:

https://hf-mirror.com/lmstudio-ai/gemma-2b-it-GGUF

镜像站点:

https://hf-mirror.com/lmstudio-ai/gemma-2b-it-GGUF/tree/main

3.2 导入模型文件

下载模型文件后按照如下目录层级放置到本地路径

本地路径查询如下,LM Studio-Mymodel-show in File Explorer

4. 运行模型

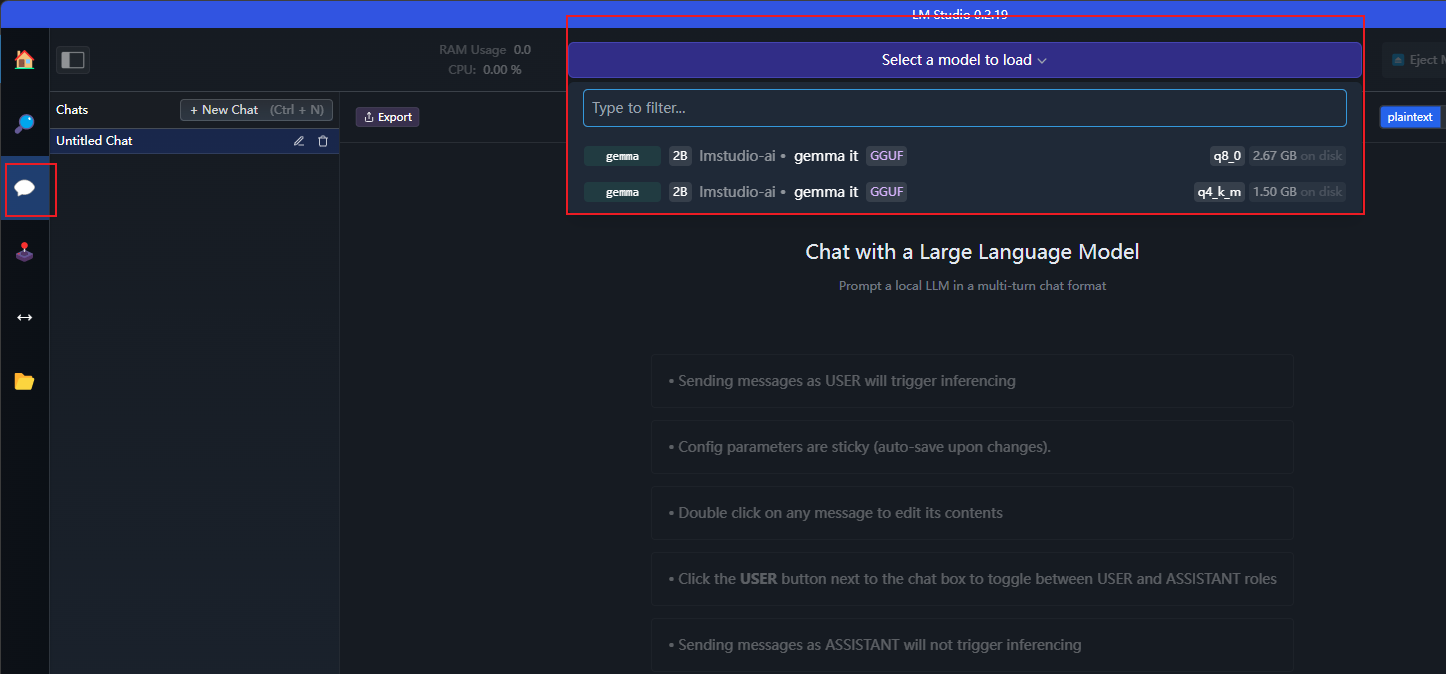

4.1 AIChat-选择模型加载

选择上述导入的模型。

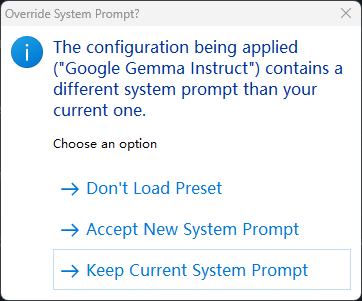

可以设置默认prompt或使用当前系统prompt:

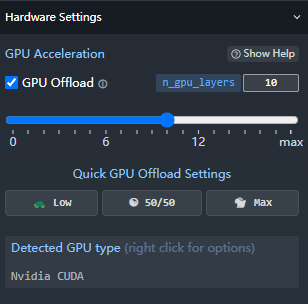

默认启用了GPU:

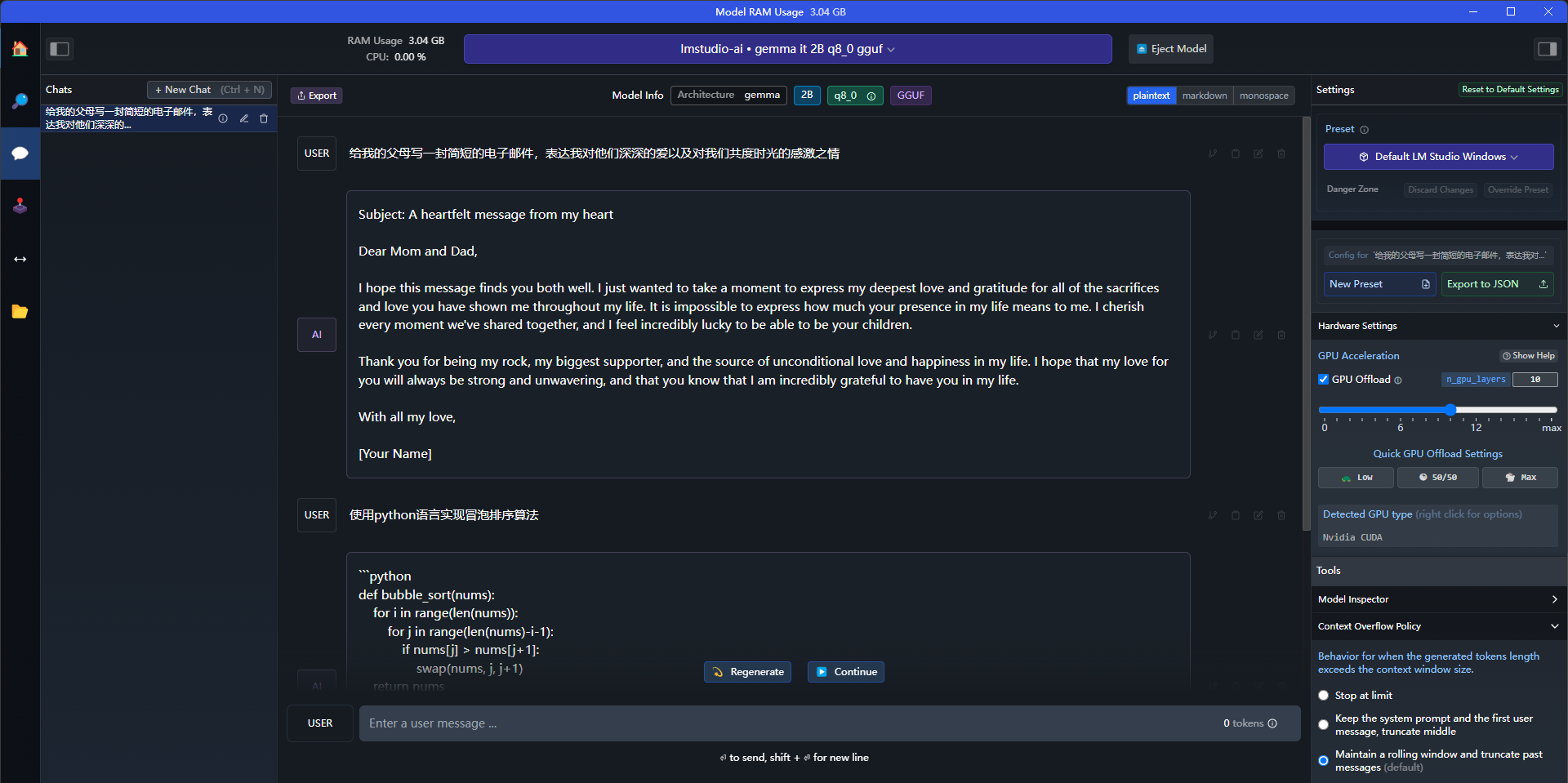

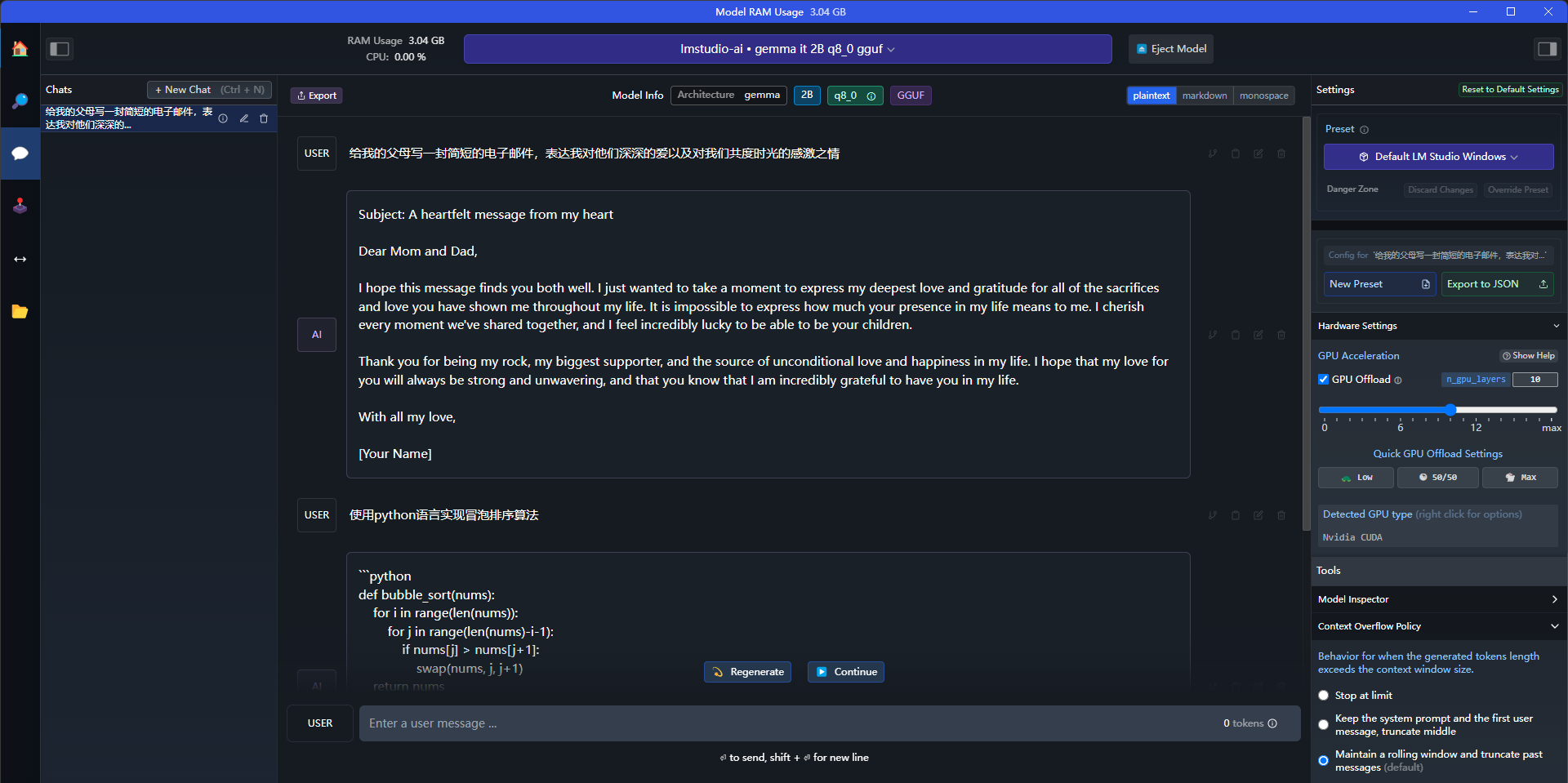

4.2 chat对话测试

模型加载完毕后即可进行对话测试:

4.3 local server

除了UI界面的chat对话使用之外,也可以在本地启动服务器,使用接口进行调试。包括curl、python等方式。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/酷酷是懒虫/article/detail/778627

推荐阅读

相关标签