- 1UI自动化测试、接口测试等自动化测试策略

- 2布隆过滤器(BloomFilter)的原理及应用_布隆过滤器原理 应用

- 3人脸识别长篇研究_大数据 查找相似长相的人

- 4Hive Container 内存溢出问题解决_set hive.tez.container.size

- 5ubuntu 22.04 编译 ORBSLAM3_ubuntu 22 编译 orb slam3

- 6在CSDN创作了一年,我收获了什么?_我在csdn这一年

- 7利用Elasticsearch提升Java应用的搜索能力_java elasticsearch suggest智能辅助

- 8macOS Monterey 系统关闭SIP详细教程,超级简单!_macsip怎么关闭

- 9分布式架构下基于Redisson实现Redis分布式锁_redisson实现分布式锁

- 10(转)深度学习:感受野、卷积,反池化,反卷积,卷积可解释性,CAM ,G_CAM,为什么使用CNN替代RNN?_反卷积 可解释性

近期语音大模型论文总结_wavllm

赞

踩

WavLLM: Towards Robust and Adaptive Speech Large Language Model

大语言模型 (LLM) 的最新进展彻底改变了自然语言处理领域,逐渐将其范围扩大到多模态感知和生成。然而,将听力能力有效地整合到法学硕士中提出了重大挑战,特别是在跨不同背景进行概括和执行复杂的听觉任务方面。

在这项工作中,我们介绍了 WavLLM,一种具有双编码器的鲁棒自适应语音大语言模型,以及通过两阶段课程学习方法优化的提示感知 LoRA 权重适配器。利用双编码器,我们解耦不同类型的语音信息,利用 Whisper 编码器处理语音的语义内容,并利用 WavLM 编码器捕获说话者身份的独特特征。在课程学习框架内,WavLLM 首先通过优化混合基本单一任务来构建其基础能力,然后针对更复杂的任务(例如基本任务的组合)进行高级多任务训练。为了增强对不同任务和指令的灵活性和依从性,在第二个高级多任务训练阶段引入了提示感知 LoRA 重量适配器。

我们在通用语音基准(包括 ASR、ST、SV、ER 等任务)上验证了所提出的模型,并将其应用于专门的数据集,例如用于 SQA 的高考英语听力理解集和语音思想链(CoT)评估集。实验表明,所提出的模型在相同模型大小的一系列语音任务中实现了最先进的性能,在使用 CoT 方法执行复杂任务时表现出强大的泛化能力。此外,我们的模型无需专门训练即可成功完成高考任务。代码、模型、音频和高考评估集可以通过\url{此http URL }访问。

Large Language Models are Efficient Learners of Noise-Robust Speech Recognition

大语言模型(LLM)的最新进展促进了自动语音识别(ASR)的生成纠错(GER),它利用LLM丰富的语言知识和强大的推理能力来提高识别结果。最新工作提出了一个具有“HyPoradise”数据集的GER基准,以通过有效的LLM微调来学习从ASR N最佳假设到基本事实转录的映射,该方法显示出很大的有效性,但缺乏对噪声鲁棒ASR的特异性。在这项工作中,我们将基准扩展到噪声条件,并研究我们是否可以教LLM像鲁棒ASR那样对GER执行去噪,其中一种解决方案是将噪声信息作为调节器引入LLM。然而,由于跨模态间隙,直接结合来自音频编码器的噪声嵌入可能会损害LLM调谐。

为此,我们提出从N最佳列表中提取一个语言空间噪声嵌入来表示源语音的噪声条件,这可以促进GER中的去噪过程。此外,为了增强其对音频噪声的表示能力,我们设计了一种通过互信息估计的知识提取(KD)方法,将音频嵌入中的真实噪声信息提取到我们的语言嵌入中。在各种最新LLM上的实验表明,在有限的训练数据下,我们的方法实现了新的突破,在单词错误率方面提高了53.9%的校正率。分析表明,我们的语言空间噪声嵌入能够很好地表示源语音的噪声条件,在这种噪声条件下,现成的LLM表现出很强的语言空间去噪能力

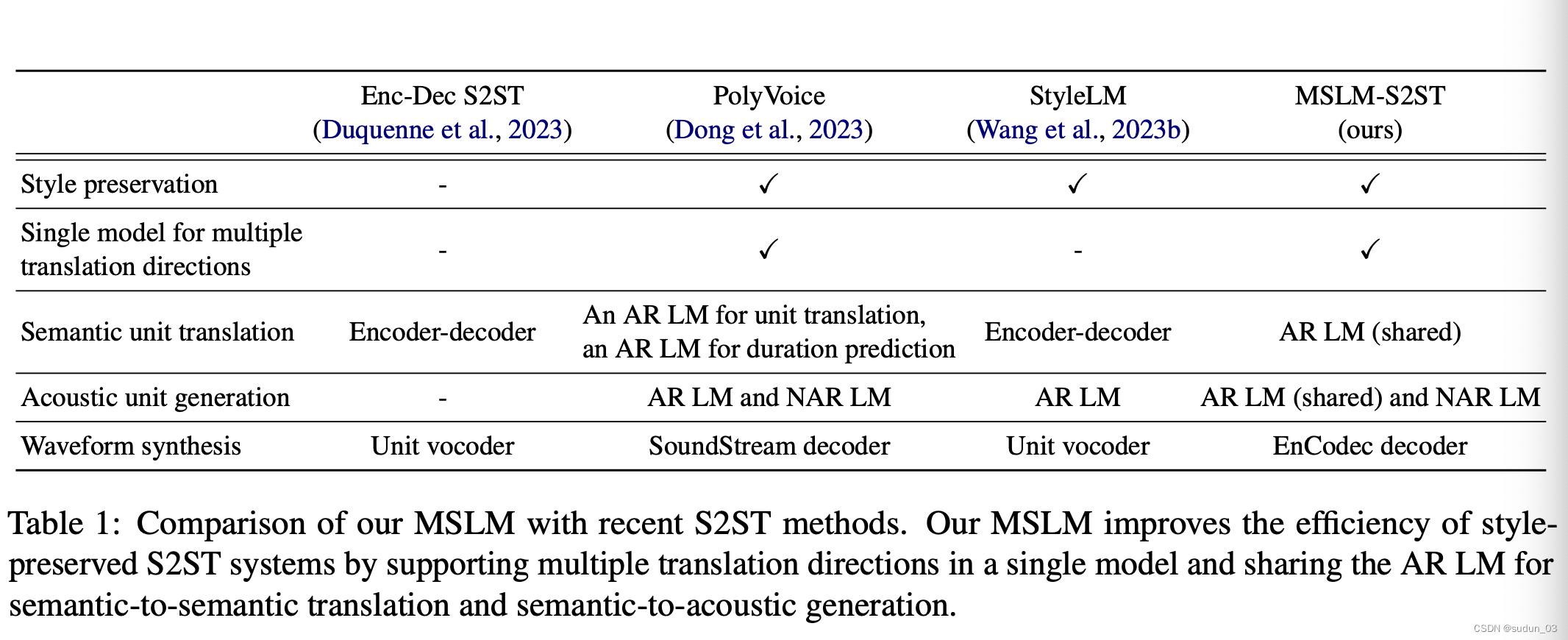

MSLM-S2ST: A Multitask Speech Language Model for Textless Speech-to-Speech Translation with Speaker Style Preservation

在将话语从一种语言翻译到另一种语言的语言翻译方面,语言到语音翻译(S2ST)方面,出现了新的研究兴趣和进步。这项工作提出了多任务语音语言模型(MSLM),这是一个在多任务环境中训练的仅解码器语音语言模型。在不依赖文本训练数据的情况下,我们的模型能够支持保留扬声器风格的多语言S2ST。

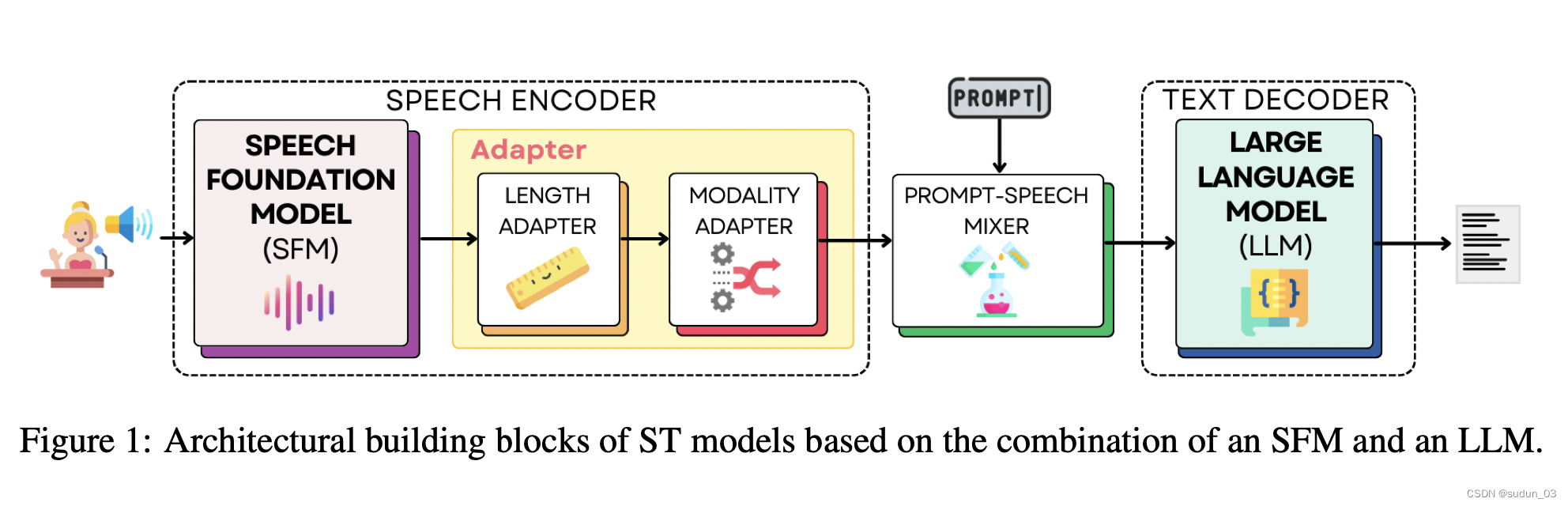

Speech Translation with Speech Foundation Models and Large Language Models: What is There and What is Missing?

随着基础模型的出现,自然语言处理(NLP)领域最近发生了变革性转变,特别是大型语言模型(LLM),这些模型彻底改变了基于文本的NLP。这种范式已经扩展到其他模式,包括语音,研究人员正在积极探索将语音基础模型(SFM)和LLM组合成能够解决多模态任务的单一、统一的模型。在这些任务中,本文侧重于语音到文本翻译(ST)。通过审查已发表的关于该主题的论文,我们提出了迄今为止提出的建筑解决方案和培训策略的统一观点,强调了它们之间的相似性和差异性。基于这次检查,我们不仅组织了经验教训,还展示了多样化的设置和评估方法如何阻碍了为每个建筑构建模块和培训选择确定性能最佳的解决方案。最后,我们概述了未来关于该主题的工作的建议,旨在更好地了解ST的SFM+LLM解决方案的优势和劣势。

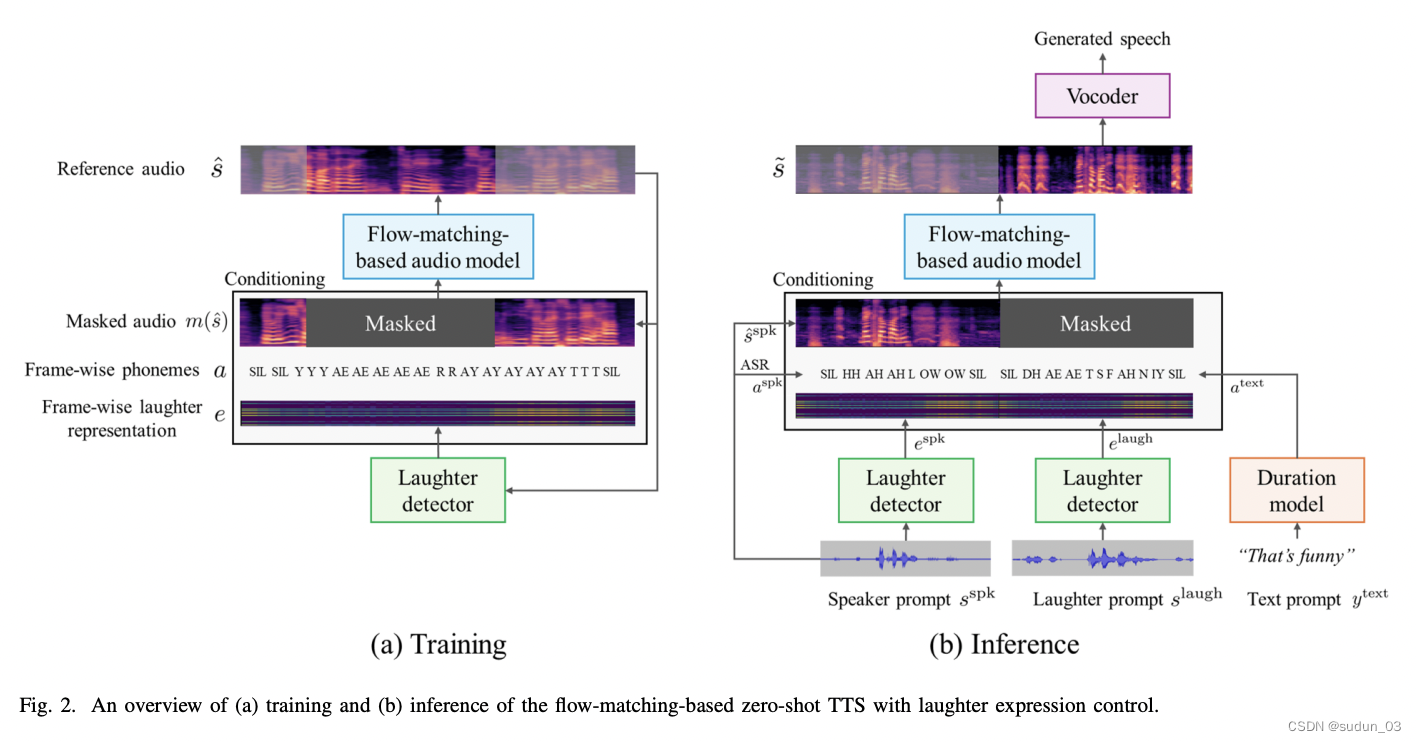

Making Flow-Matching-Based Zero-Shot Text-to-Speech Laugh as You Like

笑是人类言语中最具表现力和最自然的方面之一,可以传达情感、社交线索和幽默。然而,大多数文本转语音(TTS)系统缺乏产生真实且适当的笑声的能力,限制了它们的应用和用户体验。虽然之前已经有一些产生自然笑声的作品,但它们在控制笑声产生 的时间和种类方面存在不足。

在这项工作中,我们提出了 ELaTE,一种零样本 TTS,可以根据短音频提示生成任何说话者的自然笑声,并精确控制笑声时间和表情。具体来说,ELaTE通过音频提示来模仿语音特征,通过文本提示来指示生成语音的内容,以及控制笑声表情的输入,可以是笑声的开始和结束时间,也可以是附加的笑声表情。包含要模仿的笑声的音频提示。

我们在基于条件流匹配的零样本 TTS 的基础上开发了我们的模型,并使用来自笑声检测器的帧级表示作为附加条件对其进行微调。通过将小规模笑声调节数据与大规模预训练数据混合的简单方案,我们证明了预训练的零样本 TTS 模型可以轻松地进行微调,以产生具有精确可控性的自然笑声,而不会丢失预训练的零样本 TTS 模型的任何质量。

通过评估,我们表明,与传统模型相比,ELaTE 可以生成笑声,其质量和可控性显着提高。请参阅此 https URL以获取演示示例。

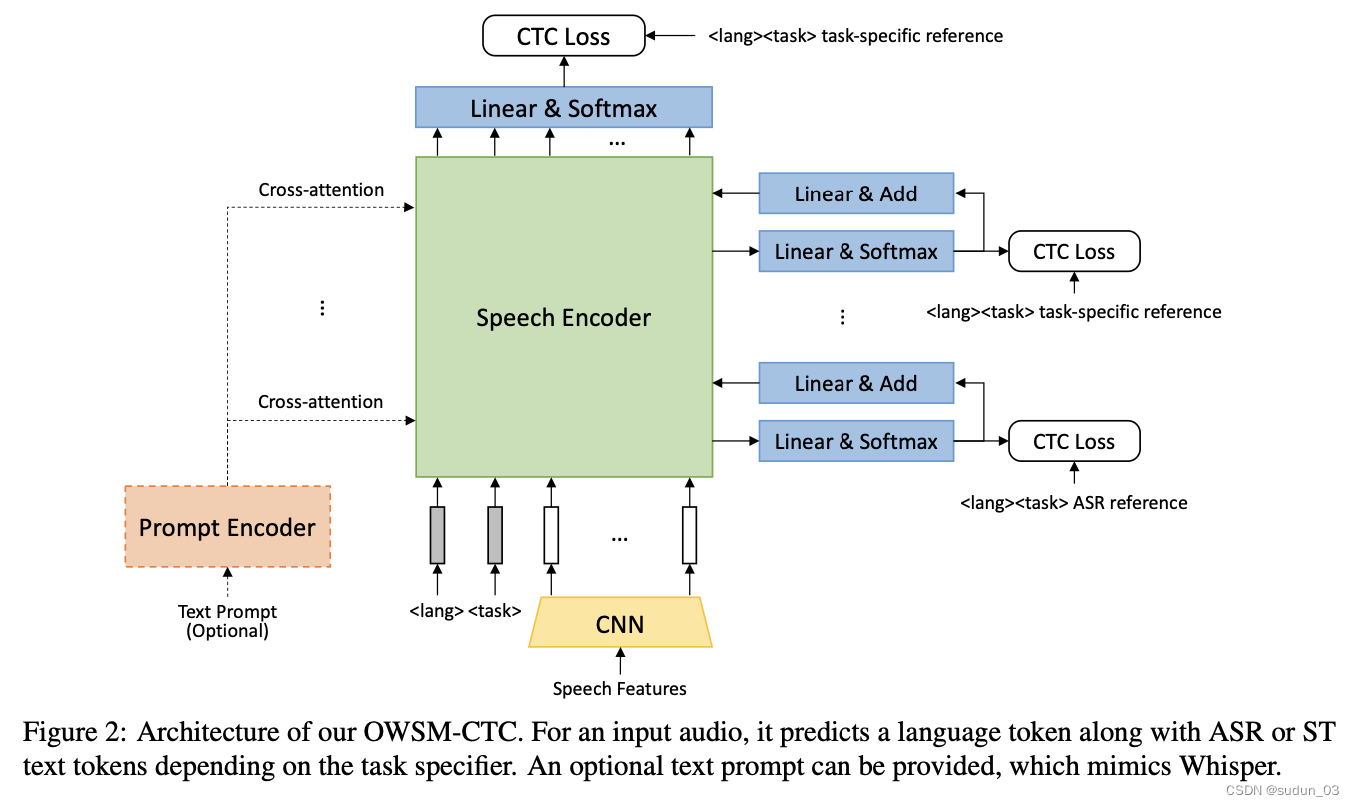

OWSM-CTC: An Open Encoder-Only Speech Foundation Model for Speech Recognition, Translation, and Language Identification

人们越来越关注大型语音模型,这些模型可以在单个模型中执行多个语音处理任务。此类模型通常采用编码器解码器或仅解码器架构,因为它们在许多领域很受欢迎,性能良好。然而,与非自回归模型相比,自回归模型在推理过程中可能较慢,并且也有潜在的幻觉风险。尽管之前的研究观察到小规模某些任务的非自回归模型的有希望的结果,但目前还不清楚它们是否可以扩展到不同语言和任务中的语音到文本生成。受开放耳语式语音模型(OWSM)项目的启发,我们提出了OWSM-CTC,这是一种基于连接主义时间分类(CTC)的新型仅编码器语音基础模型。它接受了18万小时公共音频数据的培训,用于多语言自动语音识别(ASR)、语音翻译(ST)和语言识别(LID)。与编码器-解码器OWSM相比,我们的OWSM-CTC在ASR上取得了竞争性结果,在ST上实现了高达25%的相对改进,同时它更强大,推理速度快3到4倍。OWSM-CTC还以20倍的速度改进了长格式ASR结果。我们将公开发布我们的代码库、预训练模型和培训日志,以促进语音基础模型中的开放科学。

Boosting Large Language Model for Speech Synthesis: An Empirical Study

Large language models (LLMs) have made significant advancements in natural language processing and are concurrently extending the language ability to other modalities, such as speech and vision.

大型语言模型 (LLM) 在自然语言处理方面取得了重大进展,同时将语言能力扩展到其他模式,例如语音和视觉。

Nevertheless, most of the previous work focuses on prompting LLMs with perception abilities like auditory comprehension, and the effective approach for augmenting LLMs with speech synthesis capabilities remains ambiguous.

然而,之前的大部分工作都集中在prompting LLMs的听觉理解等感知能力,而增强法学硕士语音合成能力的有效方法仍然不明确。

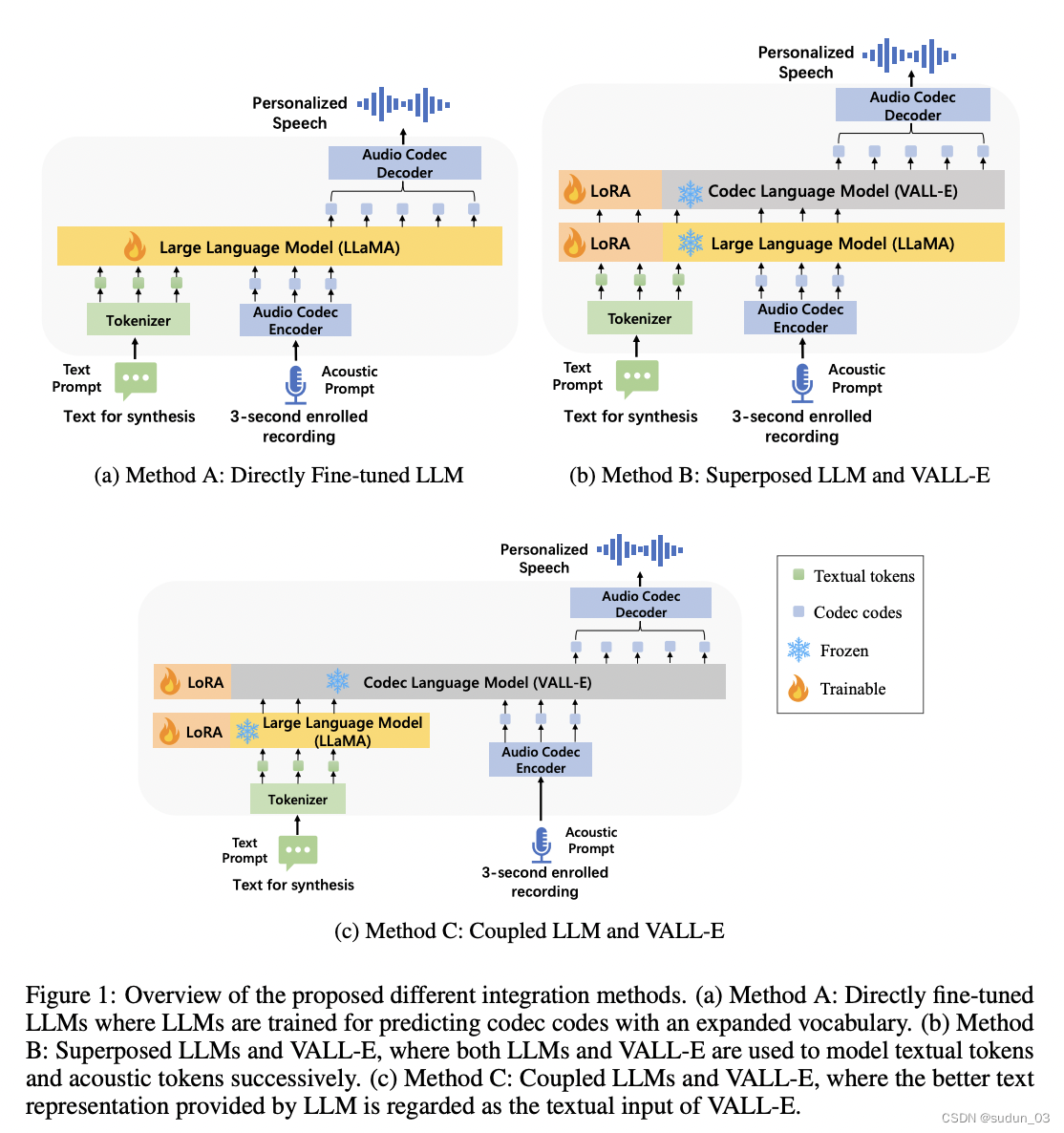

In this paper, we conduct a comprehensive empirical exploration of boosting LLMs with the ability to generate speech, by combining pre-trained LLM LLaMA/OPT and text-to-speech synthesis model VALL-E.

在本文中,我们通过结合预训练的LLM LLaMA/OPT和文本到语音合成模型VALL-E,对增强LLM生成语音的能力进行了全面的实证探索。

We compare three integration methods between LLMs and speech synthesis models, including directly fine-tuned LLMs, superposed layers of LLMs and VALL-E, and coupled LLMs and VALL-E using LLMs as a powerful text encoder.

我们比较了LLM和语音合成模型之间的三种集成方法,包括直接微调LLM、LLM和VALL-E的叠加层,以及使用LLM作为强大的文本编码器耦合LLM和VALL-E。

Experimental results show that, using LoRA method to fine-tune LLMs directly to boost the speech synthesis capability does not work well, and superposed LLMs and VALL-E can improve the quality of generated speech both in speaker similarity and word error rate (WER).

实验结果表明,使用LoRA方法直接微调LLM来提高语音合成能力效果不佳,而叠加LLM和VALL-E可以在说话人相似度和误字率(WER)方面提高生成语音的质量。

Among these three methods, coupled methods leveraging LLMs as the text encoder can achieve the best performance, making it outperform original speech synthesis models with a consistently better speaker similarity and a significant (10.9%) WER reduction.

在这三种方法中,利用 LLM 作为文本编码器的耦合方法可以获得最佳性能,使其优于原始语音合成模型,具有始终如一的更好的说话人相似度和显着 (10.9%) 的 WER 降低。

SpeechGPT-Gen:扩展信息链语音生成

Benefiting from effective speech modeling, current Speech Large Language Models (SLLMs) have demonstrated exceptional capabilities in in-context speech generation and efficient generalization to unseen speakers.

受益于有效的语音建模,当前的语音大语言模型(SLLM)在上下文语音生成和对看不见的说话人进行高效推广方面表现出了卓越的能力。

However, the prevailing information modeling process is encumbered by certain redundancies, leading to inefficiencies in speech generation. We propose Chain-of-Information Generation (CoIG), a method for decoupling semantic and perceptual information in large-scale speech generation.

然而,普遍存在的信息建模过程受到某些冗余的阻碍,导致语音生成效率低下。我们提出了信息链生成(CoIG),这是一种在大规模语音生成中解耦语义和感知信息的方法。

Building on this, we develop SpeechGPT-Gen, an 8-billion-parameter SLLM efficient in semantic and perceptual information modeling. It comprises an autoregressive model based on LLM for semantic information modeling and a non-autoregressive model employing flow matching for perceptual information modeling.

在此基础上,我们开发了SpeechGPT-Gen,这是一个在语义和感知信息建模方面高效的80亿参数SLLM。它包括一个基于LLM的自回归模型,用于语义信息建模,以及一个非自回归模型,该模型采用flow matching进行感知信息建模。

Additionally, we introduce the novel approach of infusing semantic information into the prior distribution to enhance the efficiency of flow matching. Extensive experimental results demonstrate that SpeechGPT-Gen markedly excels in zero-shot text-to-speech, zero-shot voice conversion, and speech-to-speech dialogue, underscoring CoIG's remarkable proficiency in capturing and modeling speech's semantic and perceptual dimensions. Code and models are available at https://github.com/0nutation/SpeechGPT.

此外,我们引入了将语义信息注入先验分布的新方法,以提高flow matching的效率。广泛的实验结果表明,SpeechGPT-Gen在零镜头文本到语音、零镜头语音转换和语音到语音对话方面表现出色,

这突出了CoIG在捕获和建模语音的语义和感知维度方面的非凡熟练程度。代码和模型可在https://github.com/0nutation/SpeechGPT上找到。

3. SpeechGPT-Gen

Building upon the Chain-of-Information Generation method, SpeechGPT-Gen conducts semantic modeling and percep- tual modeling sequentially.

SpeechTokenizer (Zhang et al., 2023b) is utilized to extract semantic representations and perceptual representations.

SpeechGPT-Gen consists of a LLM-based autoregressive model for semantic modeling and a flow matching-based non-autoregressive model for perceptual modeling.

SpeechGPT-Gen基于信息链生成方法,依次进行语义建模和感知建模。

SpeechTokenizer(Zhang et al.,2023b)用于提取语义表示和感知表示。SpeechGPT-Gen由用于语义建模的基于LLM的自回归模型和用于感知建模的基于流匹配的非自回归模型组成。

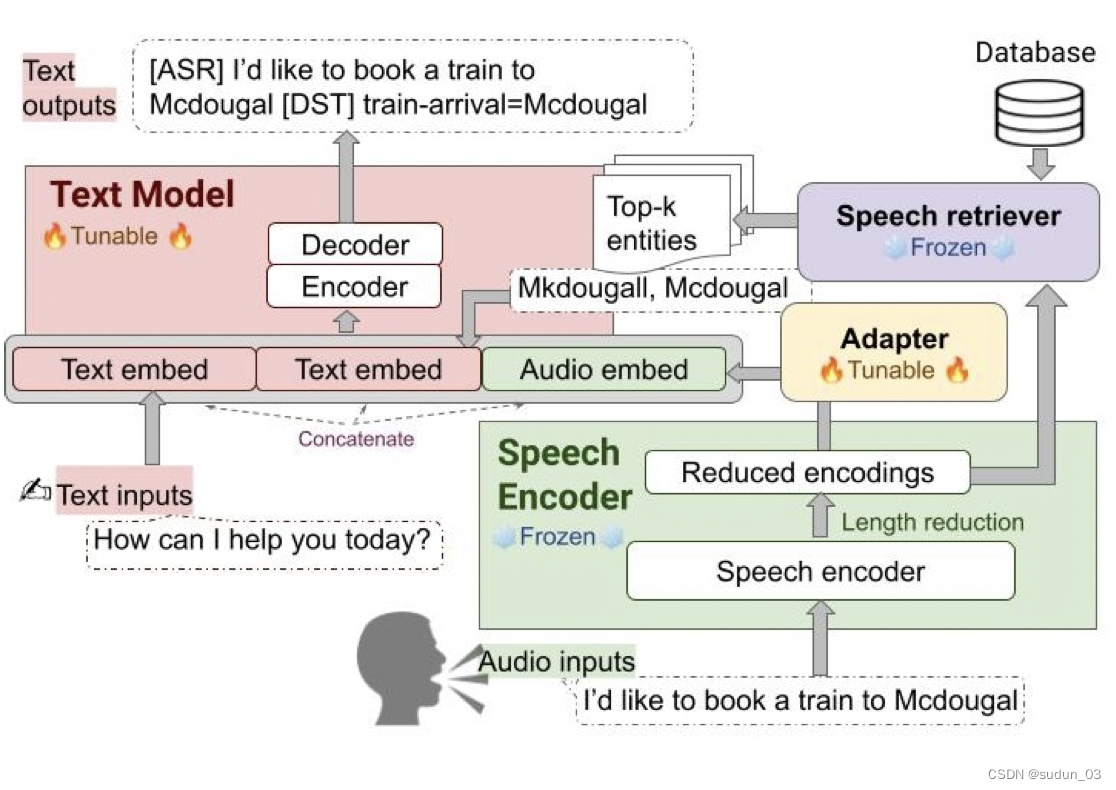

Retrieval Augmented End-to-End Spoken Dialog Models

我们最近开发了SLM,这是一种语音和语言联合模型,它融合了预训练的基础语音模型和大型语言模型(LLM),同时保留了预训练LLM固有的上下文学习能力。

在本文中,我们将SLM应用于直接从音频信号推断对话状态的语音对话应用。面向任务的对话框通常包含特定领域的实体,即餐厅、酒店、火车站和城市名称,这些实体很难识别,但对下游应用程序至关重要。受RAG(检索增强生成)范式的启发,我们提出了一种克服这一弱点的检索增强SLM(ReSLM)。我们首先训练语音检索器来检索音频中提到的文本实体。

然后将检索到的实体作为文本输入添加到底层SLM中,以对模型预测产生偏差。

我们在语音MultiWoz任务(DSTC-11挑战)上评估了ReSLM,发现这种检索增强提高了模型性能,实现了联合目标准确率(38.6%对32.7%)、时隙错误率(20.6%对24.8%)和ASR字错误率(5.5%对6.7%)。

虽然在对话状态跟踪上进行了演示,但我们的方法广泛适用于其他需要上下文信息或领域特定实体的语音任务,例如具有偏置能力的上下文ASR。

Unified Speech-Text Pretraining for Spoken Dialog Modeling

虽然最近的工作显示,在扩大大型语言模型(LLM)直接理解和合成语音的能力方面取得了有希望的结果,但基于LLM的口语对话建模策略仍然难以捉摸,需要进一步调查。这项工作提出了一个广泛的语音文本LLM框架,名为统一语音对话模型(USDM),以生成与给定输入语音相关的有机原声道功能的连贯语音响应,而无需依赖自动语音识别(ASR)或文本到语音(TTS)解决方案。我们的方法采用多步语音文本推理方案,利用底层LLM展示的推理链能力。我们还提出了一个广义的语音文本预训练方案,有助于捕获跨模态语义。自动和人工评估表明,拟议的方法在产生听起来自然的语音响应方面是有效的,表现优于先前和级联基线。详细的比较研究表明,尽管级联方法在单个组件中更强大,但联合语音文本建模提高了对识别错误和语音质量的鲁棒性。

在这项工作中,我们提出了USDM,这是一个综合了富有自然韵律的口语对话反应的模型。我们可以通过学习全面的语音-文本关系的统一预训练方案,更有效地对下游口语对话进行建模。

我们的方法通过利用声学单元标记化方案来补充,该方案保留了韵律信息,并采用了编码器和解码器的支持对。我们发现,在DailyTalk中,USDM在内容、韵律和自然度方面优于基线。

我们还表明,我们的预训练方案在教授各种语音-文本关系方面是有效的,这对口语对话建模至关重要,甚至可能用于一般的语音-文本任务。此外,我们为将我们的方法推广到多转弯场景提供了有力的证据。

我们认为,USDM已经为将LLM的会话能力扩展到语音领域奠定了基础,我们希望探索统一语音文本预训练的好处,以及将现有的基于文本的指令数据集纳入大型语音文本模型的方法。

尽管我们提出的预训练方案和USDM具有优势,但我们的模型有几个局限性和需要改进的地方。首先,探索用于预训练的数据集和模型是有限的。

需要进一步的调查来确定哪些数据对我们的预训练方案更重要,并探索我们的预培训方案是否对Mistral-7B以外的其他LLM有效。

此外,建立一个高质量的口语对话模型,能够直接从输入的口语对话中生成口语响应,而不需要跨模态链接,这可能是一个很有前途的方向。

Advancing Large Language Models to Capture Varied Speaking Styles and Respond Properly in Spoken Conversations

在口语对话中,即使两个当前的转折点是同一个句子,当他们以不同的风格说话时,他们的反应可能仍然不同。口语风格包含副语言学和韵律信息,标志着语篇和语音模态之间最显著的差异。

当使用纯文本LLM来模拟口语对话时,纯文本LLMs不能根据当前回合的说话风格给出不同的回答。在本文中,我们的重点是使LLM能够倾听说话风格并做出正确的回应。

我们的目标是教LLM “即使句子相同,如果用不同的风格说话,他们相应的反应也可能不同”。

由于没有合适的数据集来实现这一目标,我们收集了一个语音对语音数据集StyleTalk,该数据集具有以下所需特征:当两个当前语音具有相同的内容但以不同的风格说话时,它们的反应会不同。

为了教会LLM正确理解和应对说话风格,我们提出了口语LLM框架,该框架可以对语言内容和说话风格进行建模。我们使用StyleTalk数据集训练口语LLM,并设计了一个两阶段的训练管道,以帮助口语LLM更好地学习口语风格。

基于大量的实验,我们证明了口语LLM优于纯文本基线和先验语音LLM方法。

Limitation

数据规模:当前的StyleTalk训练集仅包含约2K个样本,这可能导致训练不稳定和过拟合。利用更大规模的数据集可以缓解这些问题,并消除对未经过滤的LLM生成数据的预训练阶段的需要。

风格多样且混合的真实语音:StyleTalk中的语音数据是从带有风格控制的Azure TTS系统中合成的。然而,将自发的演讲与更多样的风格相结合是更可取的。此外,目前的一种热点情绪简化了问题,因为言语情绪可以通过表达多标签来表达。

直接语音到语音建模:口语LLM生成预定义的风格属性,用于输入到富有表现力的TTS系统中。未来直接建模回应语音的工作有可能消除对明确风格标签的需求。

走向类人口语对话:现实世界中的人类交流包括(backchannel, laughter, and turn-taking )反向通道、笑声和转向行为,这超出了基于转向的口语对话系统(Nguyen et al.,2023;Mitsui et al.,2021)。通过这些行为来探索口语风格,可以使口语对话模式更接近人类对话。

Spokenwoz: A large-scale speech-text benchmark for spoken task-oriented dialogue agents

近年来,以任务为导向的对话(TOD)模式取得了重大进展。然而,之前的研究主要侧重于标注人员编写的数据集,这导致了学术研究和现实世界口语会话场景之间的差距。

虽然也有几个小规模的口语TOD数据集来解决ASR错误等稳健性问题,但它们忽略了口语对话中的独特挑战。

为了解决这些局限性,我们引入了SpokenWOZ,这是一个用于口语TOD的大规模语音文本数据集,包含8个域、203K 多轮、5.7K对话和249小时的人与人口语对话的音频。

SpokenWOZ进一步结合了常见的口语特征,如逐字处理和口语推理。基于这些特点,我们将交叉多轮语义槽和推理语义槽检测作为新的挑战。

我们对各种基线进行了实验,包括文本模态模型、新提出的双模态模型和LLM,例如ChatGPT。结果显示,目前的模型在口语对话方面仍有很大的改进空间,其中最先进的对话状态跟踪器仅在联合目标准确率上达到25.65%,SOTA端到端模型仅在52.1%的对话中正确完成用户请求。我们的数据集、代码和排行榜可在https://spokenwoz.github.io/SpokenWOZ-github.io/上找到。

Turn-taking and backchannel prediction with acoustic and large language model fusion

我们提出了一种通过将神经声学模型与大型语言模型(LLM)相融合来连续预测口语对话中的转向和反向通道位置的方法。

在Switchboard人机对话数据集上的实验表明,我们的方法始终优于单一模态的基线模型。

我们还开发了一种新颖的多任务教学微调策略,以进一步受益于LLM编码的知识来理解任务和会话上下文,从而带来额外的改进。

我们的方法展示了LLM和声学模型相结合的潜力,在人类和语音人工智能代理之间实现更自然、更对话的互动。