- 1linux 修改22默认端口和扩展其他端口_22端口和其他端口

- 2git@gitee.com: Permission denied (publickey)_git上传了公钥还是permission denied (publickey).

- 3CorelDRAW Graphics Suite2024简体中文版本发布更新介绍_coreldraw 2024 25.1.1.328

- 4【MySQL 基础知识】

- 5如何在 PyTorch 上进行性能分析_vtune和torch profiler

- 6区块链开发者观点:来自 Carbon 的 Nick Pai_hedera postgresql

- 7crt批量增加session模板与脚本_crt.session

- 8解决因jbd2导致mysql性能过低问题

- 9XML的三大解析方式解析_解析xml文件的三种方式

- 10什么是提示词注入攻击?大语言模型为Web安全带来的新风险!

使用Ollama搭建一个免费的聊天机器人_ollama 还需要注册嘛

赞

踩

0 概述

Ollama是一个能在本机运行大语言模型的软件,它提供命令行和API的交互方式,对于需要考虑数据隐私的情景,可以方便的使用Ollama部署大语言模型,并在此基础上开发RAG等应用,而无需调用OpenAI等开放API。Ollama基本上已经建立了比较完善的生态,除了在系统中使用命令行、API等方式交互,Langchain、Dify等开发框架也都支持Ollama,另外,也有非常多GUI客户端可以使用,像在iPhone、iPad等移动端设备上,也可以通过仅仅修改一个地址就能拥有属于自己的“ChatGPT”。

1 入门

1.1 下载安装

从官方网站https://ollama.com/直接下载安装即可

1.2 常用环境变量

1.2.1 OLLAMA_MODELS

模型下载目录

macOS下指定此目录,此目录中会下载文件,但在~/.ollama/models下也会下载文件

1.2.2 OLLAMA_HOST

Ollama监听网络地址,默认监听回环地址

export OLLAMA_HOST=0.0.0.0# or指定监听端口export OLLAMA_HOST=0.0.0.0:8080

- 1

1.3 模型库

从官方网站可以查找支持的模型https://ollama.com/library

1.4 其他可用模型

ollama run roger/minicpm

- 1

2 基本使用

2.1 下载模型

可以设置环境变量OLLAMA_MODELS来指定模型下载位置,此步非必须,因为大语言模型一般都比较大,如果需要指定下载路径,可以设置环境变量

注意修改下方的地址为自己电脑中的地址

export OLLAMA_MODELS=/Volumes/SHAERGE/Appdata/Ollama

- 1

下载模型

ollama pull gemma:2b

- 1

查看模型信息

ollama show --modelfile gemma:2b

- 1

# Modelfile generated by "ollama show"

# To build a new Modelfile based on this one, replace the FROM line with:

# FROM gemma:2b

FROM /Users/luogang/.ollama/models/blobs/sha256-c1864a5eb19305c40519da12cc543519e48a0697ecd30e15d5ac228644957d12

TEMPLATE """<start_of_turn>user

{{ if .System }} <end_of_turn>

<start_of_turn>model

<end_of_turn>

"""

PARAMETER repeat_penalty 1

PARAMETER stop "<start_of_turn>"

PARAMETER stop "<end_of_turn>"

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

2.2 导出模型

记住上面的模型路径,拷贝到一个新的文件,模型格式为gguf,例如:

注意修改下方的地址为自己电脑中的地址

cp /Users/luogang/.ollama/models/blobs/sha256-c1864a5eb19305c40519da12cc543519e48a0697ecd30e15d5ac228644957d12 /Users/luogang/Downloads/gemma/gemma_2b.gguf

- 1

2.3 创建模型

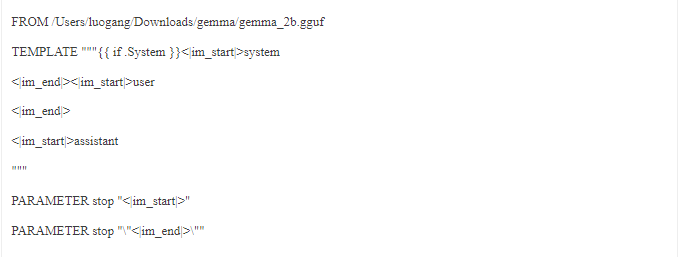

创建一个Modelfile文件,最简形式如下:

From /Users/luogang/Downloads/gemma/gemma_2b.gguf

- 1

完整形式如下:

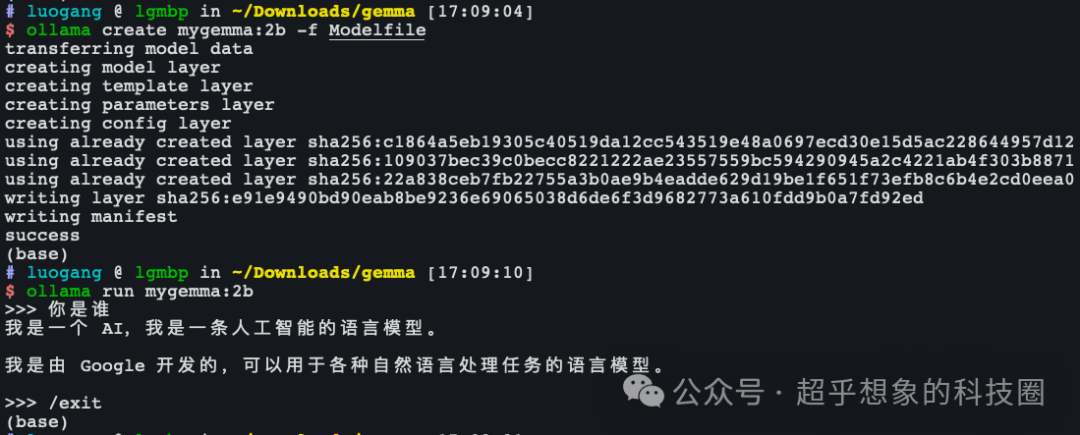

使用如下命令创建Ollama模型

可以设置环境变量OLLAMA_MODELS来指定模型下载位置

注意修改上面的地址为自己电脑中的地址

ollama create mygemma:2b -f Modelfile

- 1

然后使用

ollama run mygemma:2b

- 1

可以正常使用

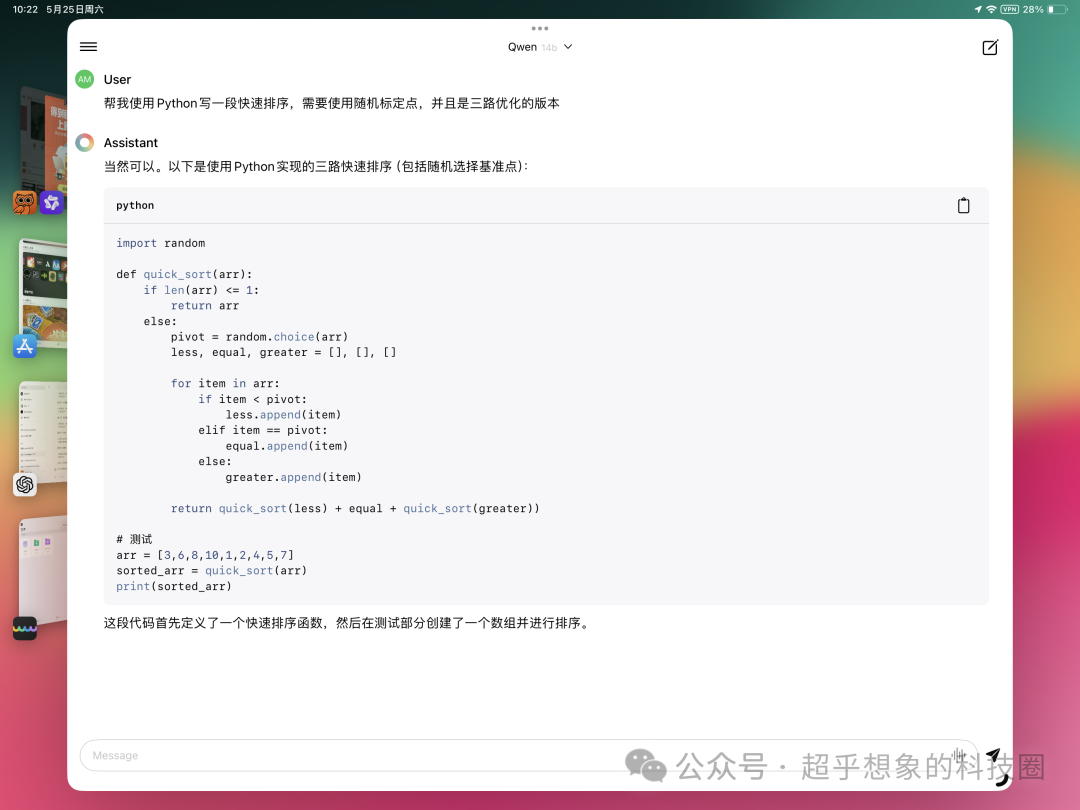

2.4 运行

如果指定的模型没有下载,运行时会先下载

ollama run qwen:1.8b

- 1

使用效果如下,实际生成token的速度非常快

2.5 列出已下载模型

ollama list

- 1

2.6 启动服务

macOS下

在macOS上,点击Ollama图标运行程序后,就已经启动服务了,默认监听在11434端口

不过要注意,从点击Ollama图标的方式运行的方式,没有办法设置环境变量,虽然在https://github.com/ollama/ollama/issues/703此处有人给出了解决方案 launchctl setenv OLLAMA_HOST 0.0.0.0:8080,但经过尝试并不生效

Linux下

ollama serve

- 1

在Linux下安装成功后,会默认安装为一个服务,系统启动后相当于自动执行了ollama serve,此时可以修改systemd启动单元/etc/systemd/system/ollama.service

注意将下方Environment中的相关路径,替换为自己的路径

[Unit]

Description=Ollama ServiceA

fter=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/home/luogang/.autojump/bin:/opt/anaconda3/bin:/opt/anaconda3/condabin:/home/luogang/.autojump/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin:/usr/local/cuda-11.8/bin:/usr/local/cuda-11.8/bin"

Environment="OLLAMA_HOST=0.0.0.0"

[Install]

WantedBy=default.target

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

Environment="OLLAMA_HOST=0.0.0.0"这一行是新增的,编辑完成保存后,执行如下命令

如果启动状态检查没有报错,说明启动成功,再次使用如下命令检查环境变量是否生效

netstat -an | grep 11434

- 1

2.7 REST API

更多API可以参考此处:https://www.postman.com/postman-student-programs/workspace/ollama-api/collection/21521806-f48dc31a-a9f1-4dad-9082-fd07f5cd2fda

2.7.1 列出模型

curl http://localhost:11434/api/tags

- 1

2.7.2 查看模型信息

2.7.3 生成

stream参数非必填,默认为true,下同

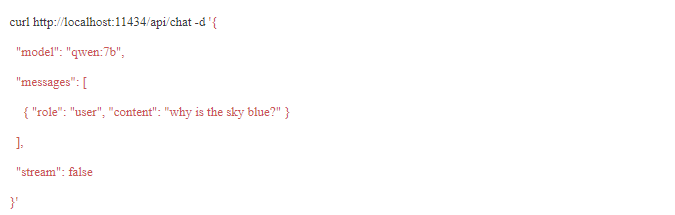

2.7.4 对话

2.7.5 Embedding

3 以服务的方式关联前端GUI使用

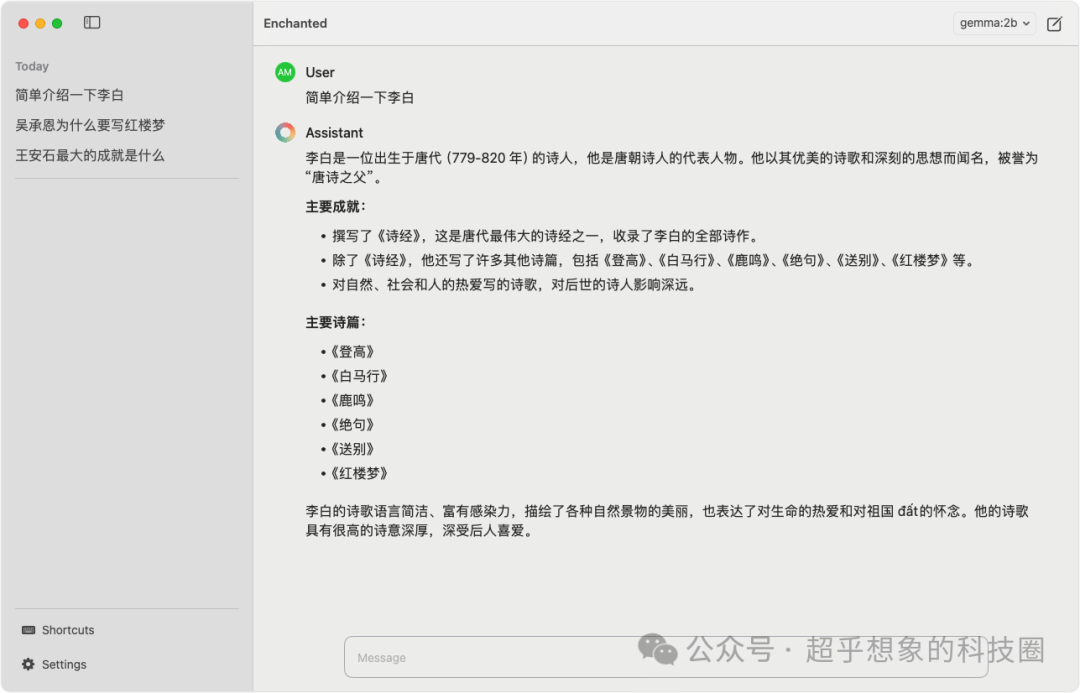

3.1 Echanted

在Ollama启动后(双击运行或者ollama serve方式),启动Echanted不需要做任何修改,直接可以运行

3.1.1 macOS

3.1.2 iPadOS

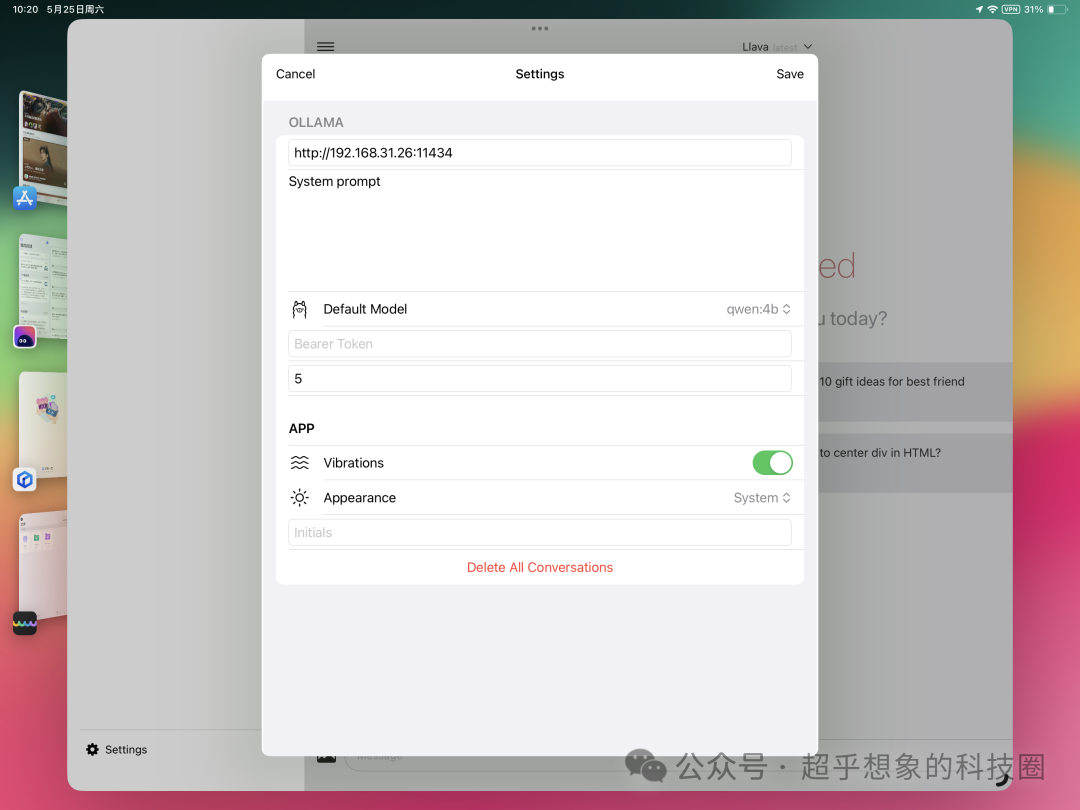

iPadOS下支持Ollama的软件比较多,比如Enchanted、OpenCat等,Enchanted完全免费,下面以此为例。

点击左上角的按钮展开侧边栏,然后在最底下的Settings,需要在设置中的OLLAMA下输入Ollama服务地址,比如http://192.168.31.26:11434

要注意,这个地址需要iPad能够访问到,也就意味着Ollama服务启动时需要监听0.0.0.0

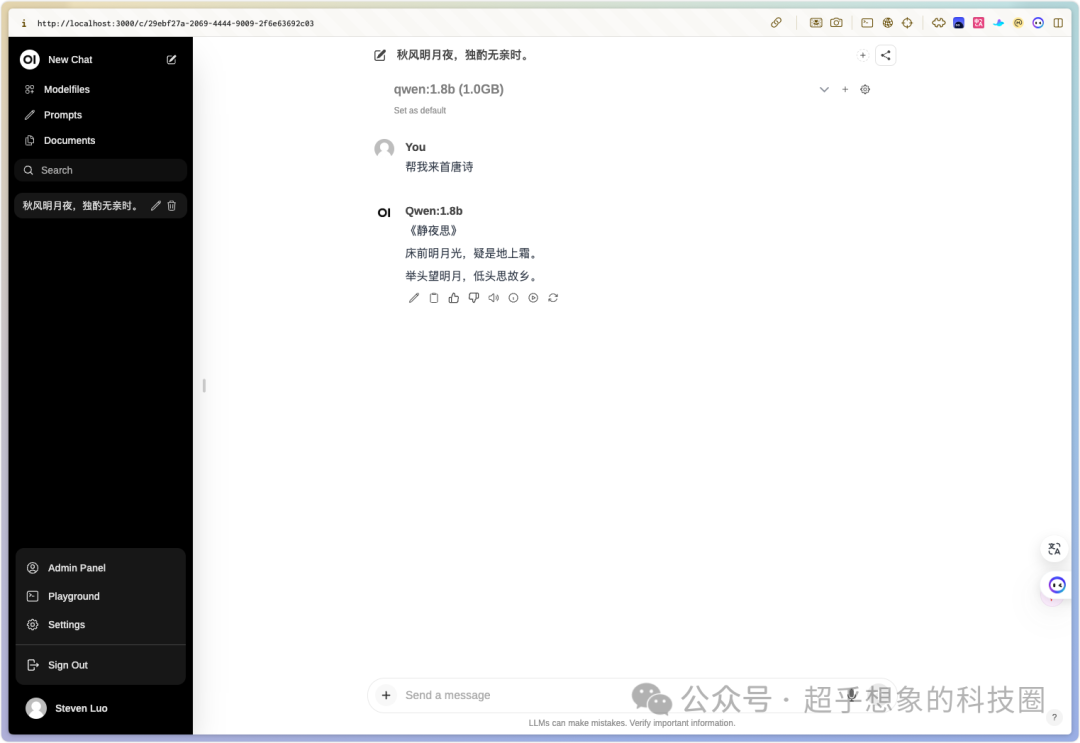

3.2 Open WebUI

直接使用Docker启动

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 1

登录后,需要注册,填写个人信息进行注册即可

进入界面后,在界面顶端可以直接选择已经下载的模型

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。